所有文章

<blockquote><p>在当今的数字化时代,智能客服系统已成为企业服务的重要组成部分。然而,许多人认为智能客服能否解决问题,实际上与智能客服本身无关,而是取决于背后的运营策略与服务流程。本文将深入探讨智能客服在实际应用中的优势与局限,并提供优化方案,帮助企业提升客服体验,真正解决用户问题。</p> </blockquote>  ## 不产生利润的售后,凭什么要求真正解决问题 以互联网的周期来看,智能客服也算是比较古老的产品了。这玩意儿在底层逻辑上是服务于企业降本增效的目标,而不是用户体验。 只是现在有大模型之后,体验问题有了被改善的机会。 智能客服转人工,无非两类原因 1、 意图理解不行,有方案根本匹配不到 2、提供的解决方案根本不能解决问题(提供话术,糊弄人,假解决方案) 当然,还有一些交互之类的原因,但不是核心问题也不展开讲。 大家对智能客服的期待,很简单,就是解决问题。 **抛开识别准确率的原因**,不能解决问题的根因,还是企业服务成本的考量。 电子产品过保一天,出问题了,能不能按照保内售后? 服务没预算,只能踢皮球了,但是锅给智能客服背了。 换个说法,能挣钱,有利润的售后服务,巴不得不用智能客服,全转人工。 ## 服务部门,是成本还是利润中心,和服务本身没关系 售后服务是成本还是利润中心,取决于公司卖的是什么产品。 ### 哪些行业的服务是盈利的,哪些是纯成本 赚钱的售后,比较典型的有汽车,工业设备和医疗设备,还有一些高价值的有延续性的金融保险服务,但其实已经超出了售后服务的范畴了。 **高利润售后** - 汽车。 毛利可能高于40%了,因为原厂配件的垄断,高频刚需(保养)等原因 - 工业设备。之前我做工业智能化的时候,接触过一台韩国的demura的设备,技术人员都是从韩国飞过来的。 工业设备停机成本太高,找原厂售后是权衡利弊的结果。 没有业内数据,但是我猜测,工业设备本身可能不怎么赚钱,就是靠长达十年的售后周期产生利润。 - 医疗设备。 耗材、强制年检等,高频刚需。 赚钱的理由千篇一律,亏钱的理由五花八门,但是也离不开,产品本身太便宜了这个大背景。 **亏损型售后** - 消费电子。 大家反馈最多的场景。以手机举例子,原因无非是,产品价值太低了,备件价格透明,维修人力成本高昂。 当然还有产品本身迭代周期也快,备件预测也是麻烦事。 官方售后根本打不过华强北,无论是维修价格还是时效。官方比较好的就是安全可靠。 但是,2000块钱的手机用了一年,维修主板1000,你还会修吗? - 家用电器。 国家有强制三包,并且家电相比消费电子更加依赖渠道,渠道的成本,都是服务成本。 动不动五年十年的质保, 可是一台空调才多少钱啊。 - 快消品。 快消品更典型,单价更低,一退货,利润就不在了。 客单价低到难以分摊服务成本,非技术性服务也缺少溢价空间。 **亏损型售后,必然会提供很多话术类的,无效的解决方案来糊弄用户**。 这是商业规律 ### 亏损型售后智能客服怎么做?悲观的是,除了糊弄,好像做不了什么 公司CEO要满意度还不给服务预算,消费者希望能给他的手机免费维修,不然就12315投诉你。咋整? 怎么破局?智能客服又能做什么? 中医说,治未病,售后的未病是什么? - 产品本身设计有问题–IPD在产品立项阶段就要评估可服务性,如果产品本身设计有问题,可服务性还通过了,那这就是服务自作自受~活该挨骂 - 产品批次故障率高 - 服务政策本身不合理、不清晰,存在认知灰度的空间;服务政策前期宣传含糊不清,避重就轻;判报标准不透明(懂的都懂) 这些都做好了,然后呢,用户还是要找客服,还是要先用智能客服过滤。 不能解决的问题,还是不能解决。 智能客服能做什么? - 尽可能的提供好的交互和情绪价值(之前都是人工客服提供的,大模型的出现让智能客服提供情绪价值有了可能性) - 小额灰度(之前也是人工客服提供的,要给智能客服授权) - 升级入口 除此之外,好像还是没有什么解题的思路。 ## 回归问题本质,做高端产品,可能才是服务变好的唯一方法 有句老话叫:穷生奸计,富长良心。 还有一句老话叫:杀头的买卖有人干,亏本的买卖没人干。 在商言商,没有利润,服务不真正解决,一点毛病没有。 公司利润率和利润都非常高的前提下,拿几个点出来给服务,提升服务体验,才是唯一的解决方法。 **服务好了,销售又会更好,飞轮转起来,才能基业长青。** 整个文章似乎有一点怨气,确实也是。 消费者骂服务,但是根子不在服务。 希望CEO们好好把IPD践行好,多挣点钱,多给服务点钱,满意度不就自然上来了吗 本文由 @福田贝叶斯 原创发布于人人都是产品经理。未经作者许可,禁止转载 题图来自Unsplash,基于CC0协议 该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务

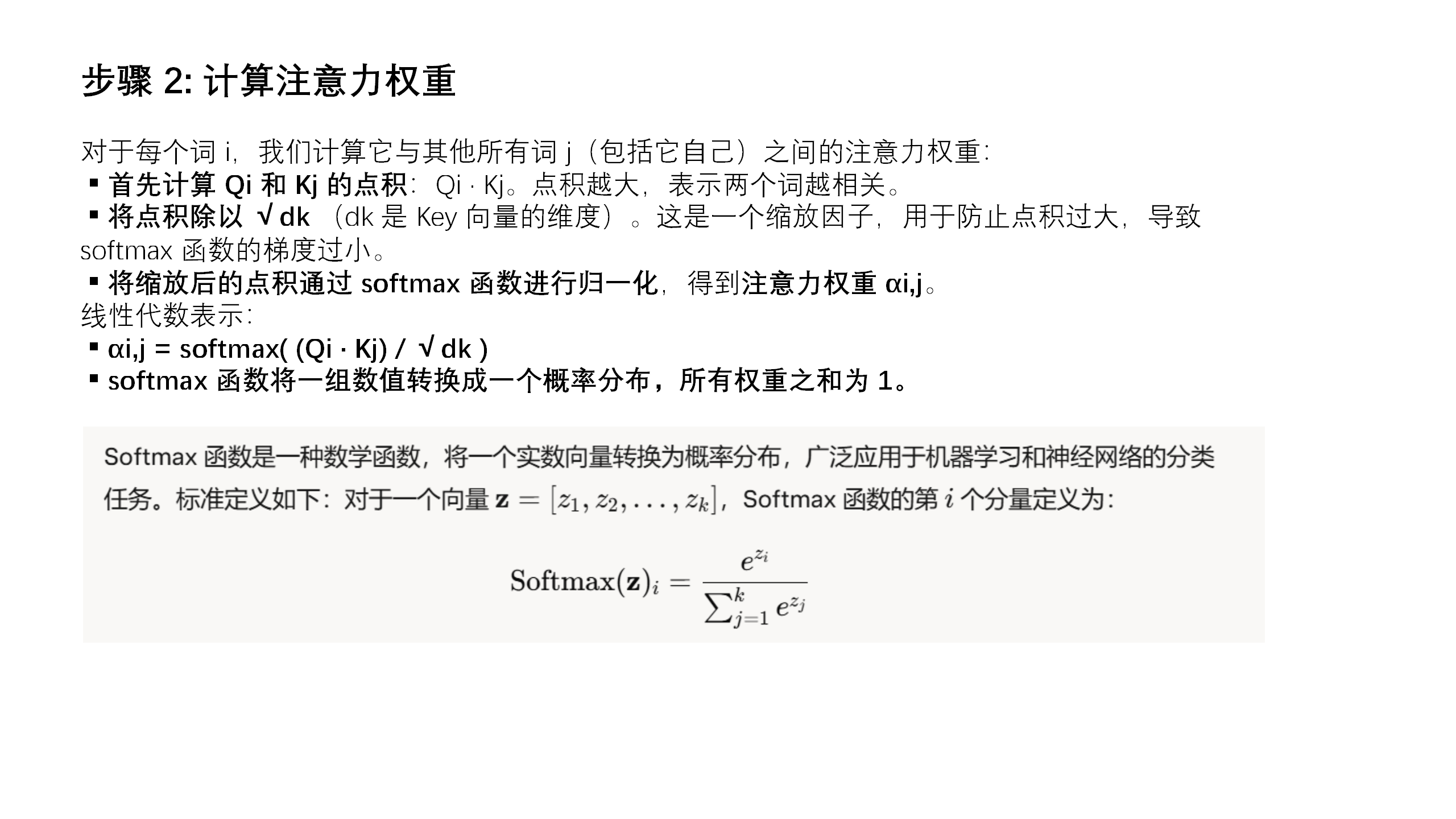

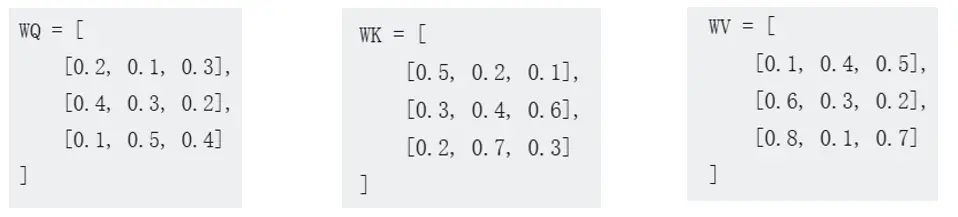

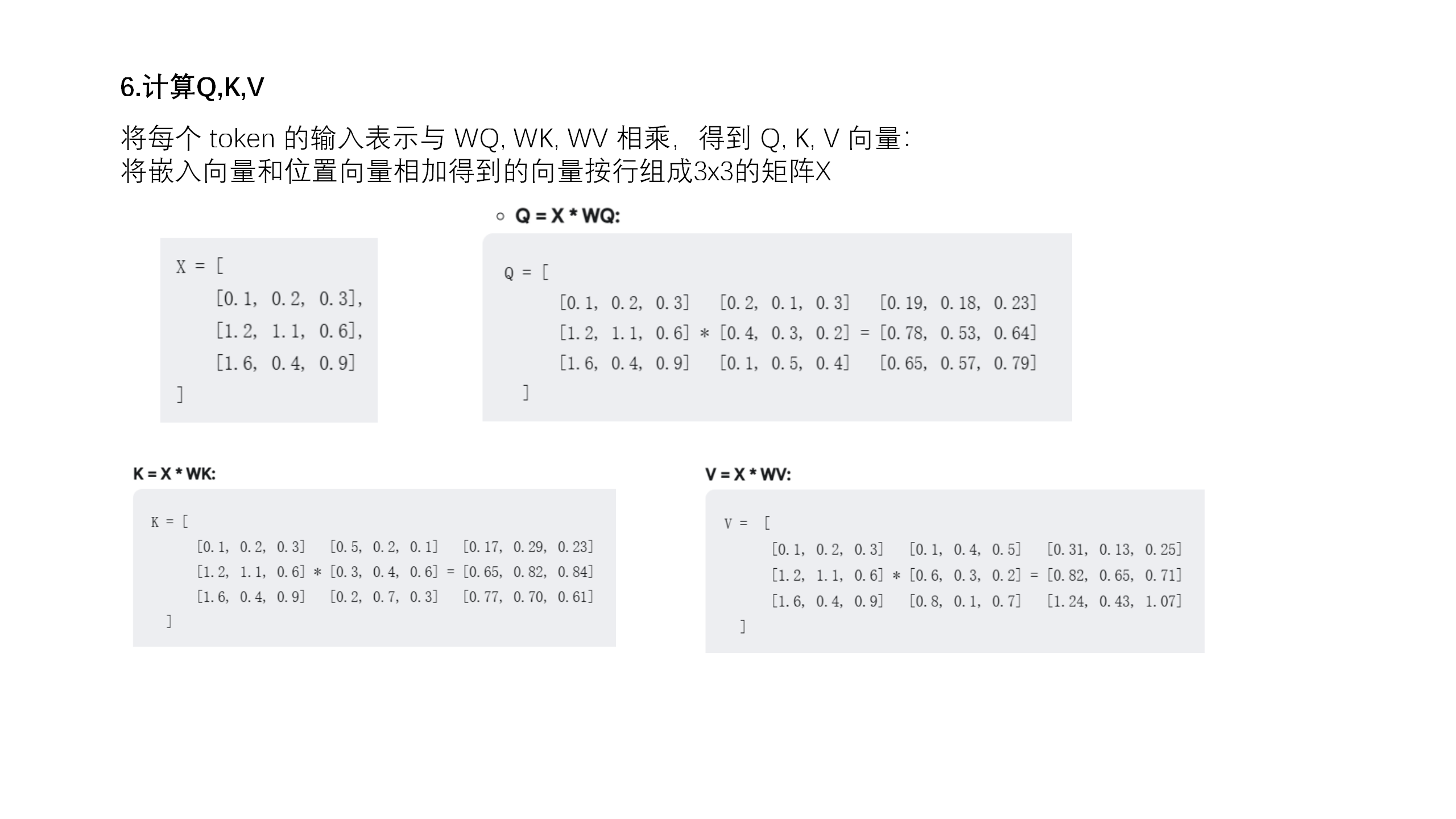

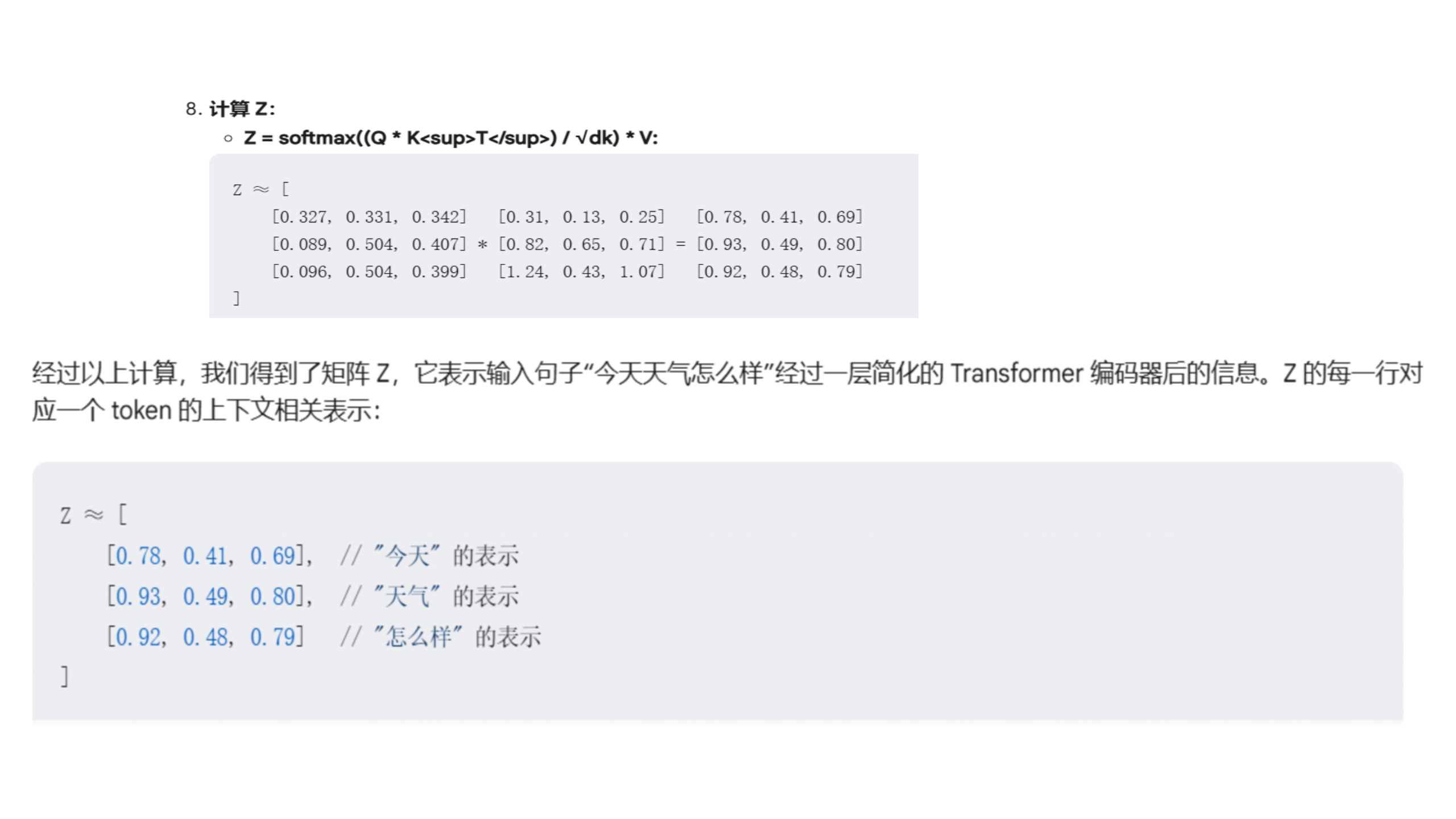

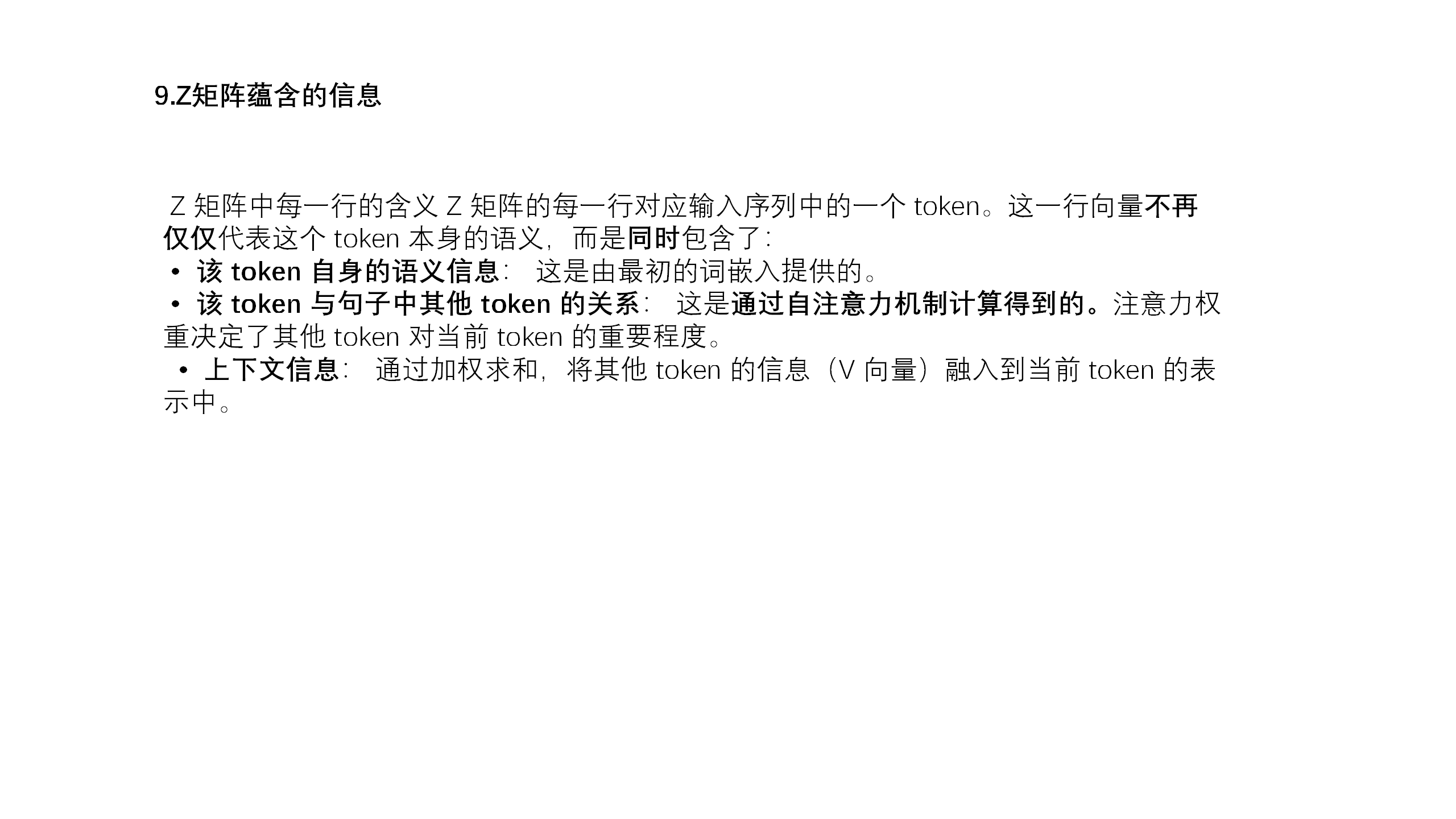

<blockquote><p>人工智能的快速发展已经彻底改变了我们的生活方式,但许多人对其背后的工作原理仍充满疑问。特别是,AI是如何理解和处理语言的?这篇文章将带你深入探索AI大语言模型的核心构成,从词嵌入到自注意力机制,揭示AI如何通过复杂的数学和算法,实现对人类语言的理解与生成。</p> </blockquote>  ## AI大语言模型 (Artificial Intelligence Large Language Model) • AI (Artificial Intelligence): 人工智能。这部分表明了AI的本质——不是一个真实的人类,而是通过计算机程序和算法构建出来的智能体。能够执行通常需要人类智能才能完成的任务,比如学习、推理、解决问题、理解语言等等。 • 大 (Large): 大型。这个词描述了模型的规模。AI通过学习海量的文本数据(例如书籍、文章、网站内容等)来获得知识和能力。 “大型”意味着模型拥有庞大的参数数量(可以理解为神经元之间的连接),这使得AI模型能够处理和生成复杂的语言模式。 • 语言 (Language): 语言。这表明了我的主要功能和应用领域。我专注于理解和生成人类语言。我可以阅读、写作、翻译、总结文本,并与人类进行对话。 • **模型 (Model): 模型**。这个词指的是我的构建方式。我是一个基于数学和统计学的模型。更具体地说,我通常是基于一种叫做“Transformer”的深度学习架构。这个模型通过分析大量文本数据中的统计规律,来学习词语之间的关系、句子的结构以及语言的整体模式。 所以“AI大语言模型”可以看成 是一种基于数学和算法构建的、用于执行特定人工智能任务的结构。它本质上是由大量的参数、算法和数据组成的复杂系统。 **整体架构:Transformer** 目前主流的大语言模型大多基于Transformer架构。Transformer的核心思想是“自注意力机制”(Self-Attention Mechanism),这使得模型能够捕捉文本序列中不同词语之间的关系,无论这些词语在句子中的距离有多远。 **核心组件:层(Layers)** Transformer模型是由多个相同的“层”(Layer)堆叠而成的。每个层都包含以下几个关键子组件: **自注意力层(Self-Attention Layer):** 这是Transformer的核心。它允许模型关注输入序列中不同位置的信息,并计算它们之间的关系。 从线性代数的角度来看,自注意力机制可以看作是对输入序列进行一系列线性变换(矩阵乘法),然后通过Softmax函数进行归一化,得到注意力权重。这些权重表示不同位置之间的相关性。 **前馈神经网络层(Feed-Forward Neural Network Layer):** 在自注意力层之后,每个位置的表示都会通过一个前馈神经网络进行处理。 这个前馈网络通常包含两个线性变换(矩阵乘法)和一个激活函数(如ReLU)。 **残差连接(Residual Connections):** 在每个子层(自注意力层和前馈网络层)周围都有一个残差连接。 这意味着子层的输入会直接加到子层的输出上。这有助于缓解深度神经网络中的梯度消失问题,使得模型更容易训练。 **层归一化(Layer Normalization):** 在每个子层之后,都会应用层归一化。 层归一化有助于稳定训练过程,并提高模型的性能。它会对每个样本在层的维度上进行归一化。 **基本组成单元:神经元(Neurons)** 无论是自注意力层还是前馈神经网络层,它们都是由大量的“神经元”组成的。每个神经元可以看作是一个简单的计算单元。 **总结一下:** 从最底层到最高层,模型的构成可以这样理解: **神经元:** 执行基本计算单元(加权求和、激活函数)。 **层:** 由多个神经元组成,包括自注意力层和前馈神经网络层,以及残差连接和层归一化。 **Transformer架构:** 由多个层堆叠而成,利用自注意力机制捕捉文本序列中的长距离依赖关系。 **参数:** 模型的权重和偏置,通过学习数据来调整。比如deepseek参数最大的是671B. ## 层的概念 ### 什么是“层”? 你可以把“层”想象成一个信息处理的“工序”或者“步骤”。每一层都接收一些输入信息,然后对这些信息进行特定的处理和转换,最后输出处理后的信息给下一层。 就像工厂里的流水线一样: **原材料:** 最初的输入文本(比如一个句子)。 **第一道工序(第一层):** 比如,把每个单词转换成一个数字表示(词嵌入)。 **第二道工序(第二层):** 比如,分析每个单词和句子中其他单词的关系(自注意力机制)。 **第三道工序(第三层):** 比如,根据单词之间的关系,进一步理解整个句子的含义。 **… 更多工序(更多层):** 每一层都在前一层的基础上进行更深层次的处理。 **最终产品:** 模型对输入文本的最终理解(比如,判断这句话的情感是积极还是消极)。 ### 为什么需要“多层”? 为什么要这么多层,而不是一层搞定呢? **逐步抽象:** 每一层都在前一层的基础上进行更抽象的表示。 第一层可能关注的是单词的含义。 第二层可能关注的是词组的含义。 第三层可能关注的是句子的含义。 … 更深层可能关注的是段落、篇章的含义。 **举个例子:图像识别** 虽然我们主要讨论的是语言模型,但“层”的概念在图像识别中也非常常见,而且更容易可视化理解。 想象一下,一个用于识别猫的图像的神经网络: **输入:** 一张猫的图片(可以看作是一个像素矩阵)。 **第一层:** 可能检测图像中的简单边缘和纹理。 **第二层:** 可能将边缘和纹理组合成更复杂的形状,比如猫的耳朵、眼睛的轮廓。 **第三层:** 可能将这些形状组合成猫的脸部特征。 **第四层:** 可能根据脸部特征识别出这是一只猫。 每一层都在前一层的基础上提取更高级别的特征。 ### 回到语言模型 在语言模型中,层的工作方式类似,但处理的是文本而不是图像: **输入:** “The cat sat on the mat.” **第一层(词嵌入层):** “The” -> [0.1, 0.2, 0.3] “cat” -> [0.4, 0.5, 0.6] “sat” -> [0.7, 0.8, 0.9] … (每个单词被转换成一个向量) **第二层(自注意力层):** 计算每个单词与其他单词之间的关系。 比如,”sat” 这个词可能与 “cat” 和 “mat” 有更强的关系。 **第三层(前馈网络层):** 对每个单词的表示进行进一步处理。 **… 更多层:** 每一层都在前一层的基础上进行更深层次的理解。 **最后一层:** 可能输出模型对整个句子的理解,或者预测下一个单词(比如 “.”), 或者进行情感分类等任务。  好,现在有了这些基础知识,我们正式进入主题,AI大模型是怎么理解一句话的? 在回答这个问题之前,我们先来想一个问题,AI能从字面意义上理解人类的话吗?它真的知道苹果是什么东西吗?这个我想很多人都会回答不能。答案也确实是不能,很明显,目前的AI的发展还处于初级阶段,能力还没有达到这种地步。 不信的可以那下面一段对话也考一考AI <blockquote><p>A:先生,你要几等座?</p> <p>B:你们一共有几等座?</p> <p>A:特等,一等、二等,二等还要再等等。</p> <p>B:我看一下,请等一等。</p> <p>A:别等,再等一等也没有了。</p> <p>请问:这位先生最终购买了几等座呢?</p></blockquote> 笔者拿了市面上比较知名的10款AI,其中还包括deepseekR1,Claude等知名大模型。结果是没有一个模型能够判断”再等一等也没有了“这句话断句方式是这样的:再等/一等/也没有了。所有的模型都是这样断句的,再/等一等/也没有了。可以说是全军覆没。 因此现阶段AI尚且不能从字母意义上理解,那它们是怎么理解的呢?这还的从AI大模型的本质上来说。开头我们就介绍了,模型本质是数学和算法的结合体。它实际上就算数学的应用,所以它只能从数学的角度理解一句话。这就是词嵌入——语言的数字化。 当我们在模型中输入一句话时,比如”The cat sat on the mat.” 首先这句话会被分割成一个一个token,每个token,都对应着一个向量。 – 第一层(词嵌入层): – “The” -> [0.1, 0.2, 0.3] – “cat” -> [0.4, 0.5, 0.6] – “sat” -> [0.7, 0.8, 0.9] – … – (每个单词被转换成一个向量) 所以输入的一句话会被转化成矩阵,即**语言的数字化** 上述过程称为**词嵌入**,对应的向量称为**词嵌入向量**。所有嵌入向量组成的矩阵称为词嵌入矩阵。 词嵌入(Word Embedding)中的向量数值不是随意指定的,而是通过学习得到的。详细解释一下: 词嵌入的目标是:将词汇表中的每个词(token)映射到一个固定维度的向量空间中, 使得: •语义相似的词,对应的向量在空间中距离较近。 例如,“king” 和 “queen” 的向量应该比较接近。 •语义相关的词,向量之间存在一定的关系。 例如,“king” – “man” + “woman” 的结果向量应该与 “queen” 的向量比较接近(经典的“国王-男人+女人=女王”的例子)。 词嵌入矩阵不具备唯一性 在初始词嵌入时,同一句话里的相同的字对应的词嵌入向量不一定相同 词嵌入(Word Embedding)中的向量数值确实不是随意指定的,而是通过学习得到的。详细解释一下: 目标: 词嵌入的目标是:将词汇表中的每个词(token)映射到一个固定维度的向量空间中, 使得: •**语义相似的词**,对应的向量在空间中距离较近。 例如,“king” 和 “queen” 的向量应该比较接近。 •**语义相关的词**,向量之间存在一定的关系。 例如,“king” – “man” + “woman” 的结果向量应该与 “queen” 的向量比较接近(经典的“国王-男人+女人=女王”的例子)。 词嵌入矩阵不具备唯一性 在初始词嵌入时,同一句话里的相同的字对应的词嵌入向量不一定相同 ## 自注意力机制的计算步骤 假设我们的输入序列是:”The cat sat on the mat.” 并且每个词已经通过词嵌入层转换成了向量。 转换成嵌入向量后,模型会创建一个位置编码向量。这个**位置编码** (Positional Encoding) 的核心目的是向 Transformer 模型提供输入序列中单词的位置信息,它蕴含了token之间的位置关系。 **步骤 1: 计算 Query, Key, Value。** 对于输入序列中的每个词,我们都计算三个向量: **Query (Q): 查询向量**。可以理解为“我需要关注什么?” **Key (K): 键向量**。可以理解为“我有什么信息可以提供?” **Value (V): 值向量**。可以理解为“我提供的具体信息是什么?”◦ 这三个向量是通过将每个词的词嵌入向量与三个不同的**权重矩阵(WQ, WK, WV)**相乘得到的。这些权重矩阵是模型需要学习的参数。 **线性代数表示:** 假设词嵌入向量的维度是 m。 WQ, WK, WV 的维度都是 m × m。(实际上,为了提高效率,通常会使用多头注意力机制,将 dmodel 分成多个头,每个头的维度是 dk = dmodel / h,其中 h 是头的数量。这里为了简化,我们先不考虑多头注意力。) 对于每个词 i: Qi = Wi * WQ Ki = Wi * WK Vi = Wi * WV (其中 Wi 是词 i 的词嵌入向量)  **接下来我将用Gemini2.0模拟AI将这句话数据化的过程** 注意: 为了便于演示和计算, 我会进行以下简化: • 嵌入向量维度 (dmodel): 3 维 • 头的数量 (h): 1 (我们只考虑单头注意力) • Q, K, V 维度 (dk): 3 维 (因为 h=1, 所以 dk = dmodel) • 不包含: ◦ 多头注意力机制 (只使用一个头) ◦ 前馈神经网络 ◦ 层归一化 ◦ 残差连接 ◦ 多层堆叠 (只计算一层) **步骤一:** **1. 分词**: 将句子“今天天气怎么样”分词为: [“今天”, “天气”, “怎么样”] **2. 嵌入向量** (假设): “今天”: [0.1, 0.2, 0.3] “天气”: [0.4, 0.5, 0.6] “怎么样”: [0.7, 0.8, 0.9] **3.我们假设位置编码如下(3 维)**: 位置 0: [0.0, 0.0, 0.0] 位置 1: [0.8, 0.6, 0.0] 位置 2: [0.9, -0.4, 0.0] **4.输入表示**: 将嵌入向量和位置编码相加,得到每个 token 的输入表示: “今天”: [0.1, 0.2, 0.3] + [0.0, 0.0, 0.0] = [0.1, 0.2, 0.3] “天气”: [0.4, 0.5, 0.6] + [0.8, 0.6, 0.0] = [1.2, 1.1, 0.6] “怎么样”: [0.7, 0.8, 0.9] + [0.9, -0.4, 0.0] = [1.6, 0.4, 0.9] **5.权重矩阵 (假设)**:      本文由 @yan 原创发布于人人都是产品经理。未经作者许可,禁止转载 题图来自Unsplash,基于CC0协议 该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务

**自NVIDIA RTX 50系列显卡发布以来,消费者一直面临着一卡难求和高溢价的局面。**无论是高端的RTX 5080、RTX 5090,还是中端的RTX 5070 Ti和RTX 5070,实际售价普遍比官方建议零售价(MSRP)高出30%到40%。  在最近的一次媒体沟通会上,NVIDIA的Justin Walker在接受采访时表示,**公司正在与显卡制造商(AIB合作伙伴)和零售商密切合作,以确保显卡能够以官方建议零售价出售。** 他指出:“增加供应是解决问题的关键。一旦供应赶上需求,我们预计价格将趋于稳定。” 他还提到,RTX 50系列显卡的出货量已经增加,并且公司正在加班加点以确保供应能够满足市场需求。 此外NVIDIA还声称,其RTX 50系列显卡在发布后的前五周内,出货量达到了RTX 40系列的两倍。 [查看评论](https://m.cnbeta.com.tw/comment/1485374.htm)

3月14日消息,据媒体报道,2月24日凌晨,两男子在海底捞上海外滩店包间用餐后对着火锅锅底小便。3月12日,海底捞就相关事件道歉,并称针对2月24日00:00至3月8日24:00期间在海底捞上海外滩店堂食消费的4109单顾客,将全额退还当日餐费,并额外提供订单付款10倍金额的现金补偿。另外,海底捞提到,若顾客希望通过法律途径维护权益,其将全力配合。 值得注意的是,这起事件也被黄牛盯上,有消费者向媒体表示,**他在海底捞外滩店消费900多元,通过黄牛8.7折代订。因此,黄牛要抽20%的补偿,并且已经向海底捞方面提交了银行卡信息,等待补偿中。** 该消费者对此表示不能接受,实际消费的是他不是黄牛,他这单消费能获得1万元的补偿款,黄牛要抽走2000元。**最后这名消费者前往海底捞外滩门店,成功拦截了相关补偿,并提交了自己的银行卡信息。** 回顾这起事件,律师认为,此事的传播速度远超海底捞预期,明显是舆论压力导致海底捞方面态度转变,只能通过起诉手段挽回消费者信任,此次事件对其品牌声誉造成严重负面影响,涉事男子可能面临海底捞索赔的民事责任,包括但不限于名誉受损赔偿、锅具赔偿等。  [查看评论](https://m.cnbeta.com.tw/comment/1485372.htm)

近日,一上海女子在家中给自己的**iPhone14充电**时,经历了惊心动魄的一幕。事发时,她的iPhone 14突然发出**“噼啪”声响**,**充电接口处竟直接炸了**!该女子描述,当时她同往常一样将手机放在置物架上充电。 不料**约10分钟**后,充电接口突然迸出**小火星,伴随着黑烟,手机瞬间黑屏**,家里随之跳闸停电。 从其提供的照片中,可清楚地看到,**iPhone14手机充电接口处乌黑,外部有十分明显的烧焦痕迹。**  该女子还特别说明,这部手机是**2023年**在**官方正规渠道购买**的,至今使用的**仍是原装电池**,并且从未进行过拆机维修。 事发当日,该女子第一时间联系苹果客服,并上传手机烧毁部位照片。 起初苹果客服承诺下午会给出反馈,但随后承诺落空,后连续两次以**“还在排查”理由**更改了约定日期。 最终,在该女子的强烈要求下,客服答复称:**手机必须寄回返厂检测,检测周期大概在2周至2个月。** 在女子追问下,**客服承认此前也发生过类似案例,检测时长有可能超过2个月。** 对此,有媒体向苹果媒体联络邮箱发去采访邮件,希望核实相关情况,但在截稿前,并未收到苹果方面的任何反馈。  [查看评论](https://m.cnbeta.com.tw/comment/1485364.htm)

在NVIDIA RTX 50系列显卡发布之后,有关其库存奇缺的消息就层出不穷,**不过NVIDIA最新声称其RTX 50系列显卡在发布后的前五周内,出货量达到了RTX 40系列的两倍。**虽然没有提供确切数字,但这一数据看着还是挺多的,不过需要注意的是,这背后却隐藏着一些值得深挖的细节。 [](//img1.mydrivers.com/img/20250314/5becc099-d406-44a4-af7f-07fcc6d35051.png) 根据NVIDIA的说法,RTX 50系列显卡在发布初期的表现远超上一代RTX 40系列,但其实这种对比可能并不完全公平。 RTX 50系列在短短五周内推出了四款显卡,包括RTX 5090、RTX 5080、RTX 5070 Ti和RTX 5070,大部分都是开售即缺货。 **而RTX 40系列在同期仅推出了RTX 4090一款显卡,RTX 4080则是在五周后才发布,这意味着,RTX 50系列在数量上本身就占据了优势。** 而且RTX 4090本身就是旗舰卡,高昂的价格使得大部分普通用户都不会选择购买。 所以NVIDIA这句话应该是“在前五周,RTX 50系列的销量是RTX 4090的两倍”,这样看起来是不是就没那么多了。 [查看评论](https://m.cnbeta.com.tw/comment/1485362.htm)

今年以来,美国接二连三出现飞机事故。据媒体报道,当地时间3月13日下午,**美国航空公司一架波音737-800型客机在科罗拉多州丹佛国际机场起火,现场浓烟滚滚。**报道称,机上172名乘客和6名机组人员目前已被紧急疏散,暂无人员伤亡报告。 据了解,该客机在飞行途中,**机组人员报告发动机发生振动,在大约4900米的高度中止爬升。**  在空中飞行21分钟后,飞机折返并改道飞往丹佛国际机场并安全降落,但在着陆滑行到登机口时,飞机右侧发动机起火。   另外,**当地时间3月13日早,美国一架塞斯纳“奖状”公务机起飞后不久便坠入机场附近树林中,事发时机上只有飞行员一人,已当场死亡。** 事故未造成地面人员伤亡或建筑受损,目前坠机原因尚在调查中。 据悉,在今年美国发生的多起飞机事故中,最严重的一起事故造成67人遇难。 当地时间1月29日晚,首都华盛顿的里根国家机场附近一架客机与一架军用直升机相撞,飞机爆炸后坠河,机上67人无人生还。 [查看评论](https://m.cnbeta.com.tw/comment/1485360.htm)

早在 2024 年年初微软就在测试 Microsoft Edge for Android 的扩展程序支持,在早期测试阶段用户需要手动启用安卓扩展实验性选项后才能访问扩展程序页面。经过 1 年多的测试后现在适用于安卓版的扩展程序功能已经正式推出,现在 Microsoft Edge 稳定版也可以安装扩展程序,首批支持的包括暴力猴等多个比较知名的扩展程序。  需要提醒的是尽管目前稳定版的 Microsoft Edge 已经支持安装扩展程序,但扩展程序商店页面仍然被标记为 Beta 版,也就是微软可能还需要更多时间进行完善。 当然这种情况也不让人意外,大多数扩展程序都是为桌面平台开发的因此在移动设备上存在显示问题,而微软支持的这些扩展程序通常都已经针对移动设备进行优化以方便用户正常使用。 所以在实际使用中用户仍然可能会碰到潜在的问题,这些也属于正常情况,如果碰到问题也可以积极联系扩展程序开发者或微软提交反馈信息。  **下面是在 Microsoft Edge for Android 安装扩展程序步骤:** 1. 将 Microsoft Edge 升级到 v134.0.3124.57 及后续版本 2. 启动 Microsoft Edge 浏览器并点击右下角菜单按钮、点击扩展程序 3. 此时将会启动扩展程序页面,在这里你可以安装你想要的扩展程序 4. 如果需要禁用扩展程序请转到右下角菜单按钮、扩展程序、管理扩展程序、菜单、取消勾选启用按钮 目前已经支持的热门扩展程序包括 Tampermonkey、Dark Reader、Bitwarden 密码管理器、Immerive Translate、Cookie-Editor、User-Agent Switcher 等。 [查看评论](https://m.cnbeta.com.tw/comment/1485358.htm)

近日,NAND闪存全面涨价的趋势开始显现,首先是闪迪宣布将从4月1日起涨价,幅度超过10%,所有渠道和消费类产品都不例外。随后,美光透露将上调渠道经销商拿货价格,三星电子、SK海力士也很可能会在4月份紧随其后。 来自渠道的最新消息称,**在国外闪存原厂全面涨价的形势下,长江存储旗下零售品牌致态,也将从4月起上调渠道提货价格,具体幅度不详,但有可能超过10%。** 根据CFM闪存市场的报价,从2月份开始,部分渠道SSD、小容量eMMC的价格已经开始上涨。  对于这一波闪存涨价潮,CFM闪存市场分析认为,**随着各个领域的存储需求的高扬,存储市场保持合理稳定的价格是极为重要的,这有助于推动客户向大容量升级,进而推动存储行业的持续发展。** 同时,**三星、SK海力士等都在今年初采取了减产措施**,预计全年产量会减少超过10%,对全球整个闪存市场都带来了重大影响,闪存供应开始趋紧,价格上涨不可避免。  而就在近日举办的CFM|MemoryS 2025闪存市场峰会上,大容量存储成为行业趋势之一,尤其是**企业级应用中,32TB SSD已经大规模量产并铺开,64TB、128TB的需求也在快速增加,PCIe 5.0 SSD同样会加速普及,预计今年占比可达30%左右,明年增至50%左右。** 同时在AI PC、AI手机领域,终端设备对存储容量的需求也即将显著增加,需求非常旺盛,尤其是A**I手机的占比将从2024年的10%左右,迅速增长至2025年的30%左右、2026年的50%左右。** 值得一提的是,DeepSeek的出现,大大降低了对GPU算力的需求,有利于推动AI的普惠化,让更多的用户有机会在云端和本地部署、体验AI大模型,这也大大推动了对存储的进一步需求。  峰会期间,长江存储也宣布了下一代企业级SSD PE511,**首次支持PCIe 5.0,首次增加16TB、32TB容量,首次增加E3.S接口形态,整体性能提升100%**,符合行业趋势发展。 [查看评论](https://m.cnbeta.com.tw/comment/1485356.htm)

3月14日,彭博社报道,Shein执行董事长Donald Tang表示,**尽管面临特朗普重振全球贸易平衡运动的冲击,公司仍致力于首次公开募股(IPO)。**Donald Tang表示,上市将有助于赢得公众信任并提高Shein的透明度。  Shein 几周前有投资者表示,**Shein应将其估值下调逾三分之二至约300亿美元。**Donald Tang拒绝对Shein的估值置评。 在寻求说服投资者支持其IPO之际,**Shein正面临特朗普政府拟取消中国小商品免税进口政策的挑战。**长期以来,价值低于800美元的包裹一直免于关税。如果取消最低限度豁免导致Shein提价,习惯了购买8美元T恤和12美元连衣裙的美国消费者可能会望而却步。 Donald Tang表示:“**我们希望确保无论面临何种风暴,消费者都不会受到影响。**”他补充说,公司尚未看到美国市场出现任何放缓迹象。他表示,**Shein将尝试通过集中打包更多产品和减少浪费来降低成本。**Donald Tang还表示,在美国囤积商品可能会适得其反,导致公司积压滞销库存。 他表示:“这会成为负担,因为你必须仓储、融资,还要想办法处理这些商品。如果最后不得不将其填埋,对地球也没有好处。” **Donald Tang称Shein将遵守新规,并“找到办法”保护消费者。**他表示:“我们相信这对我们来说不是问题。” Shein在2023年一轮融资中的估值为660亿美元,2022年估值一度高达1000亿美元。**今年6月,该公司向伦敦证交所提交了上市保密文件。** Donald Tang在采访中表示:“通过上市,我们可以更有效地赢得最大程度的公众信任,**这对公司发展至关重要。**” [查看评论](https://m.cnbeta.com.tw/comment/1485354.htm)

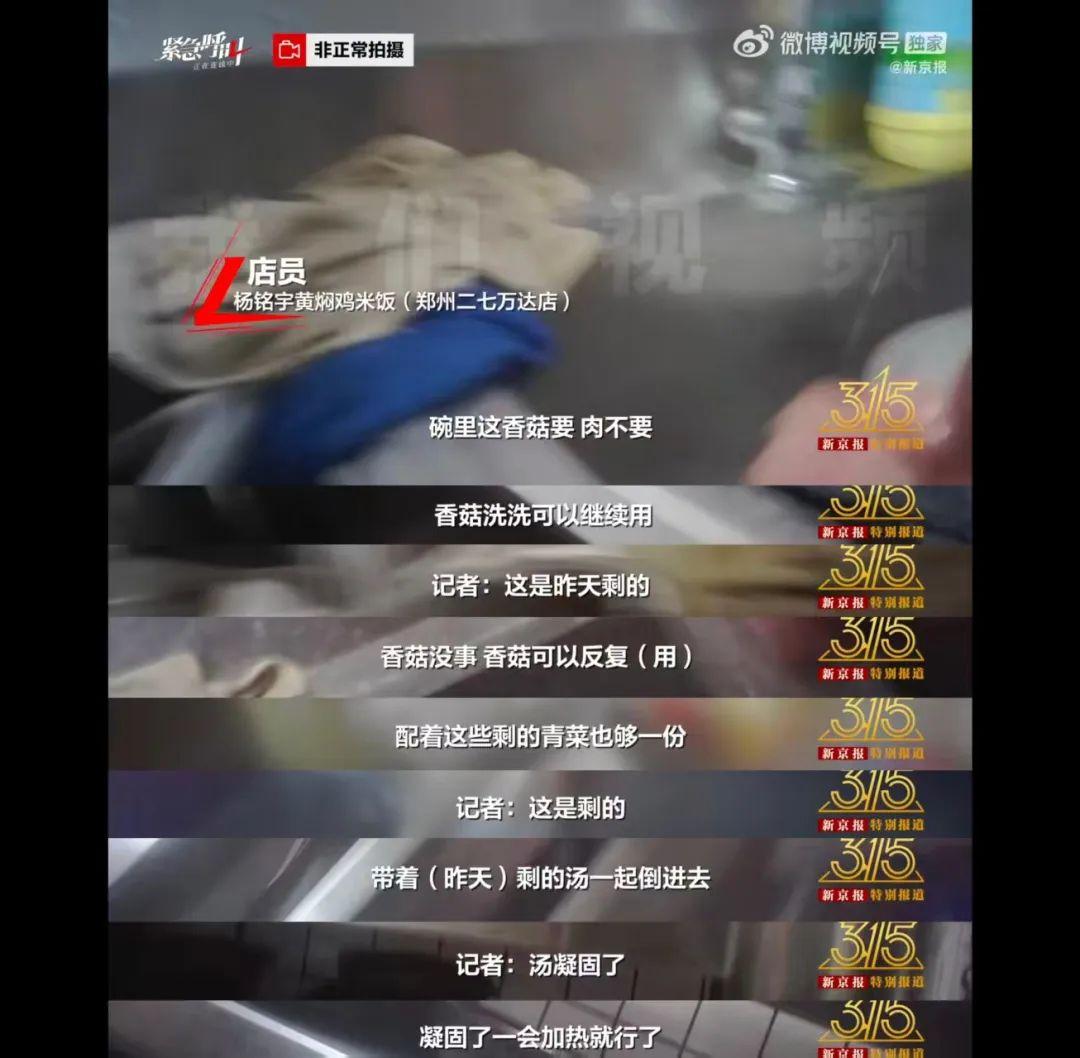

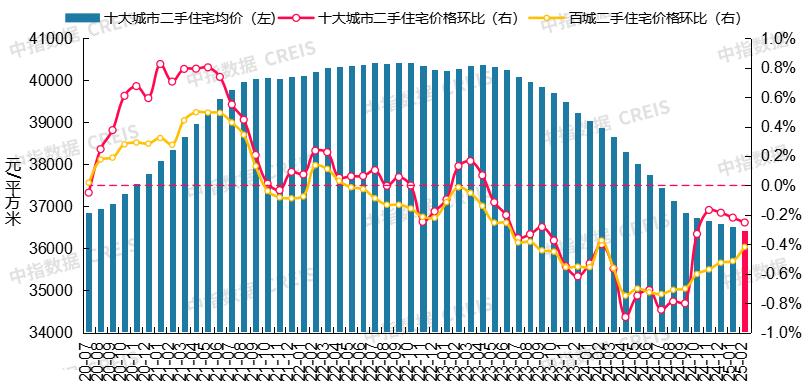

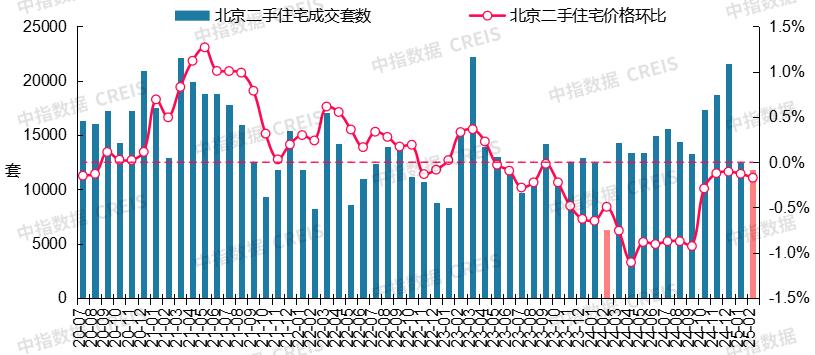

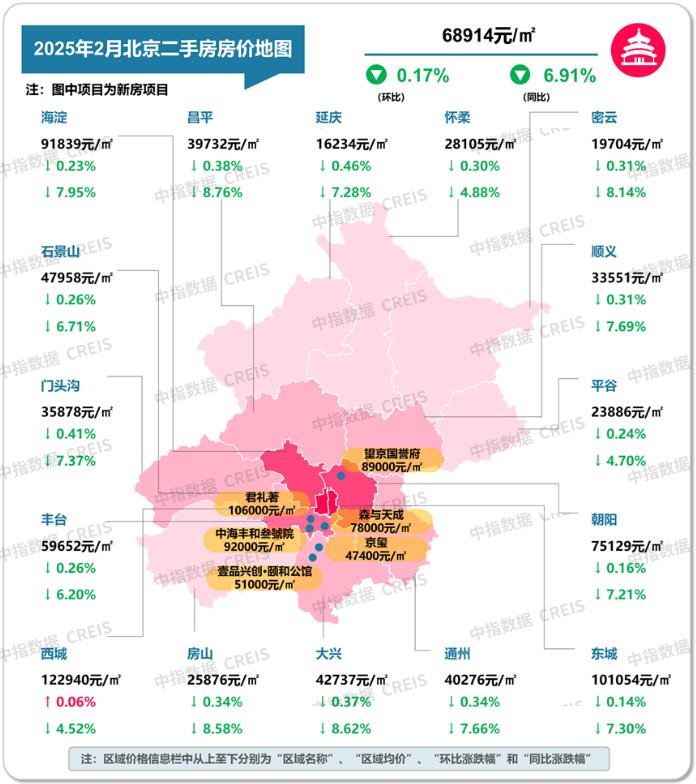

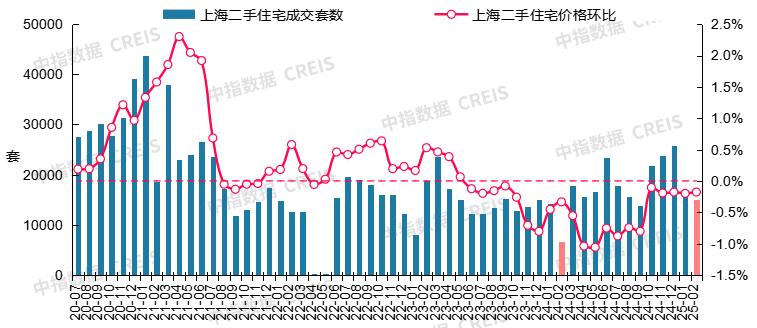

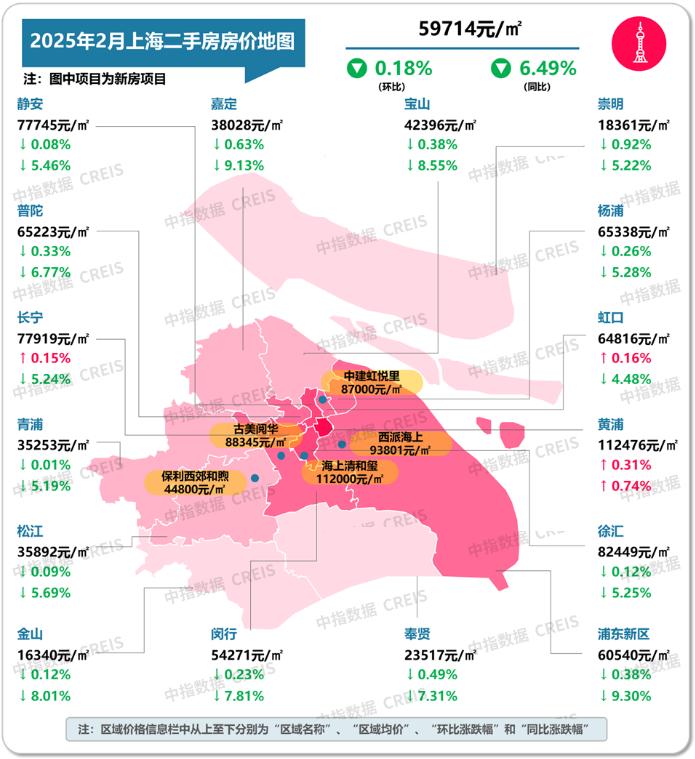

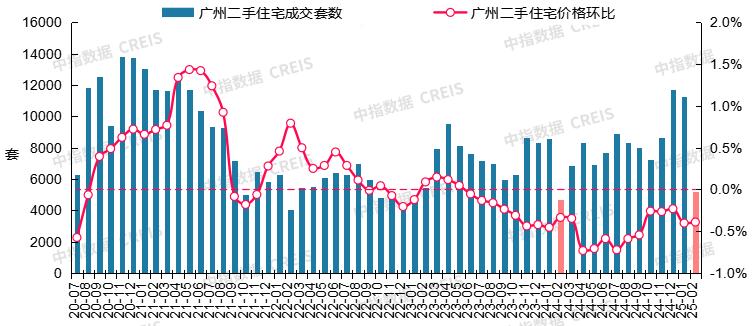

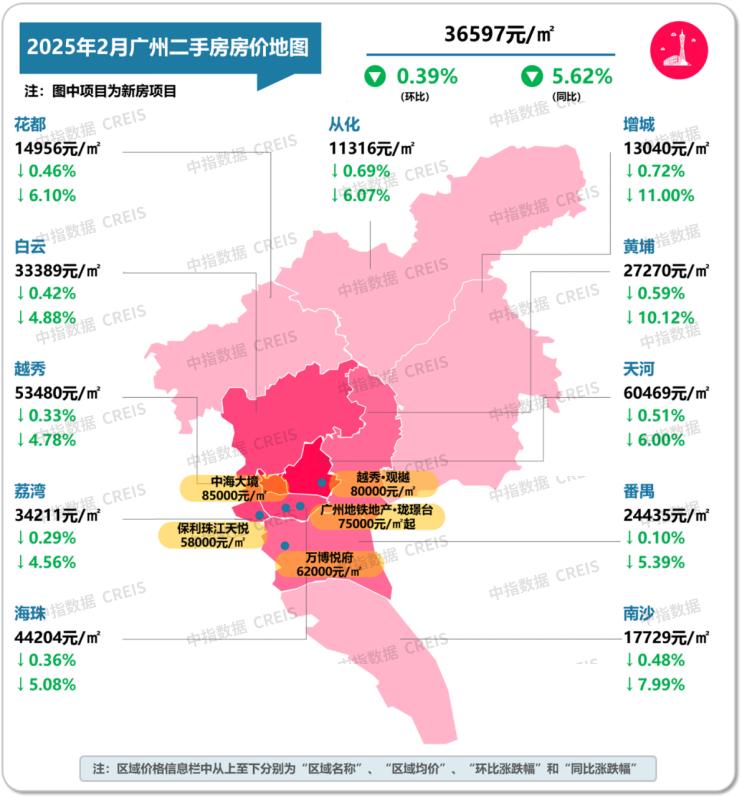

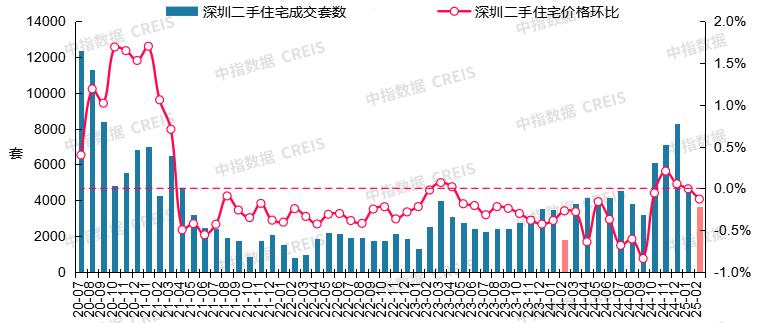

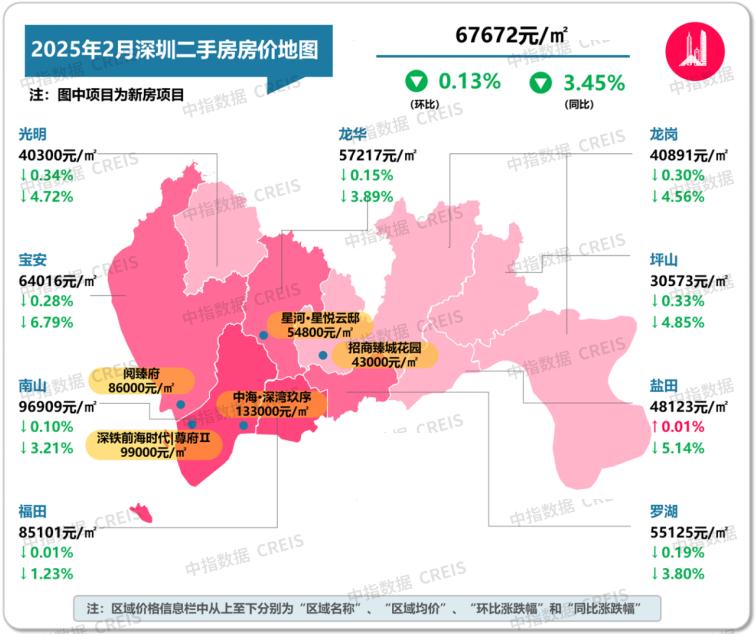

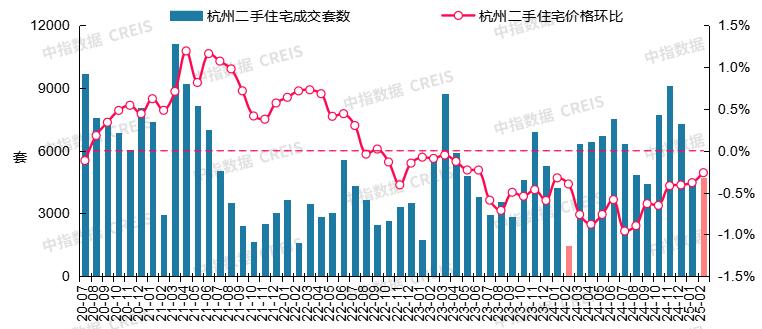

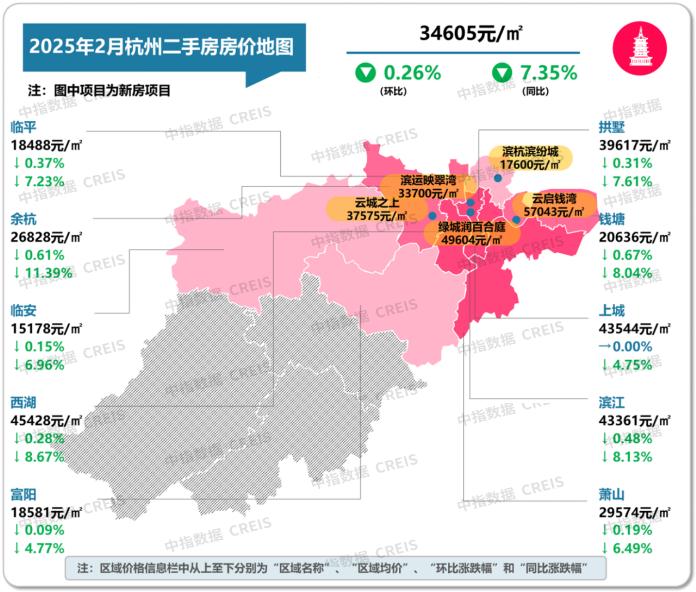

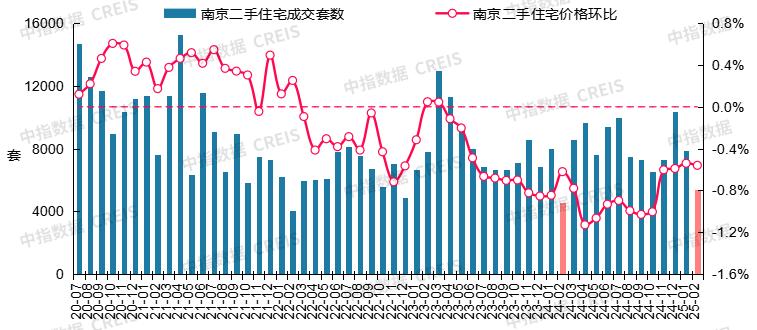

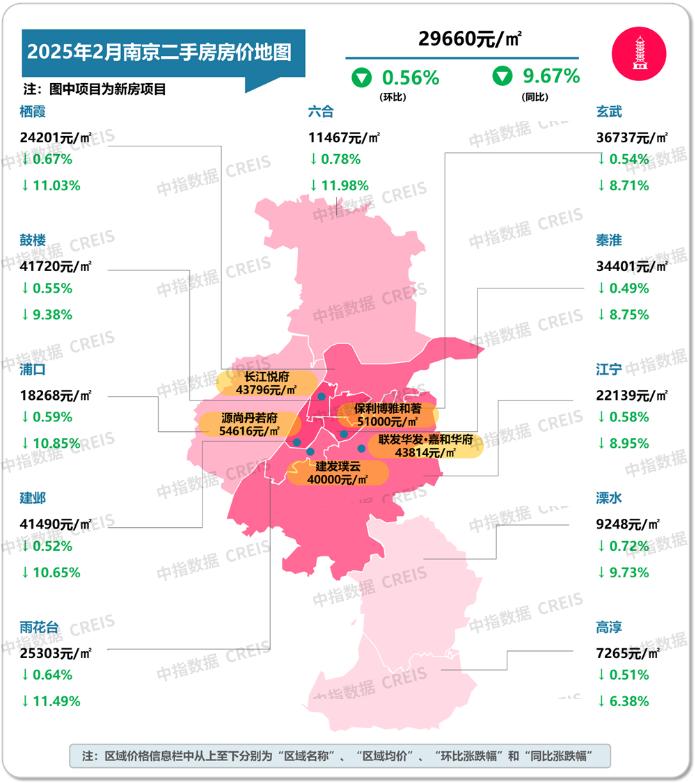

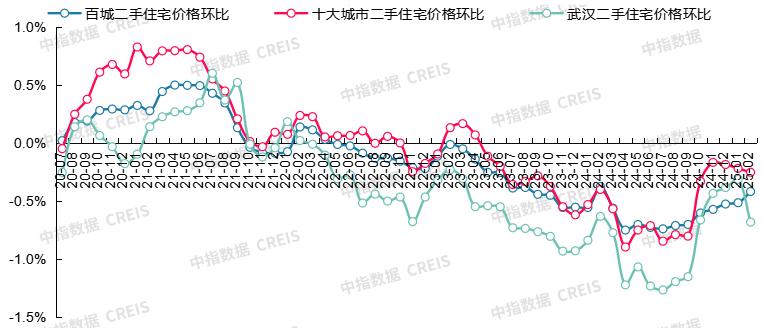

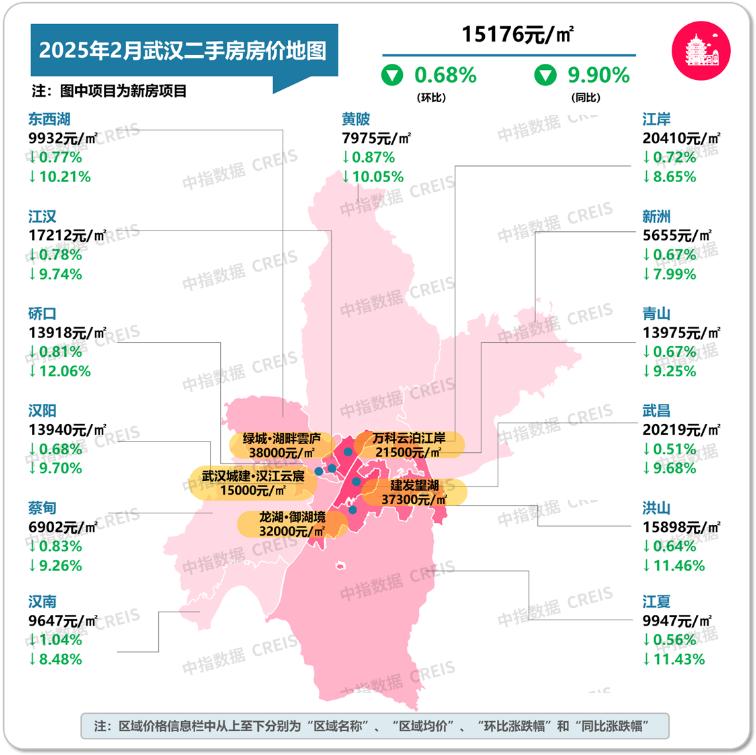

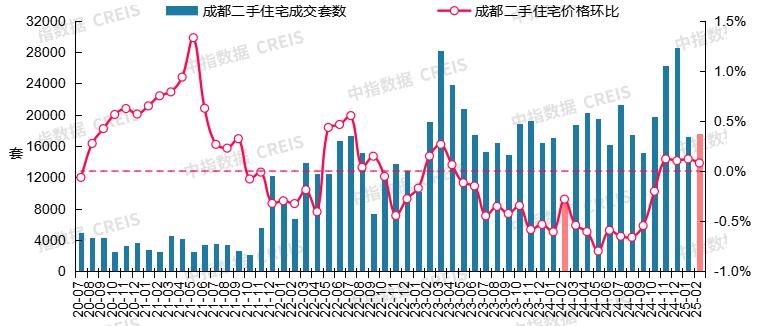

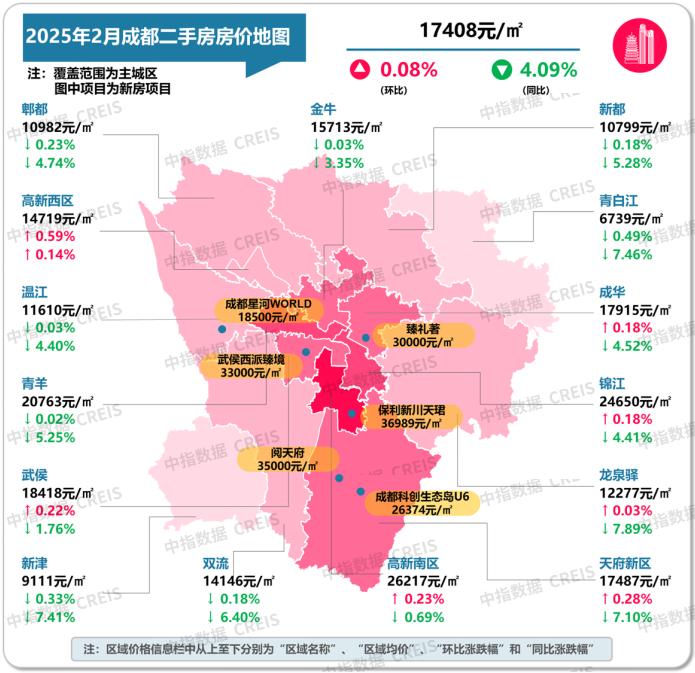

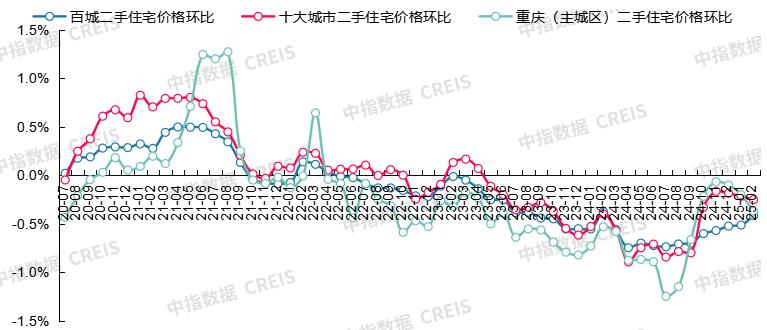

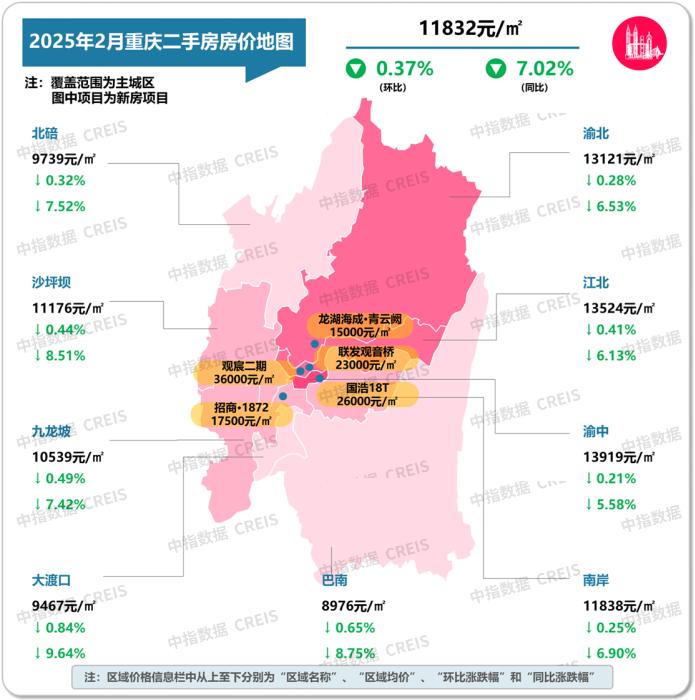

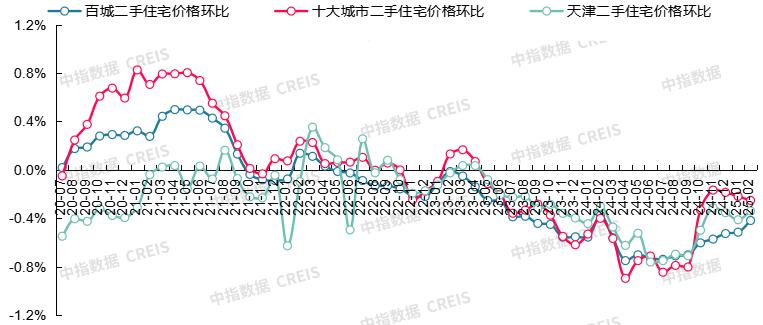

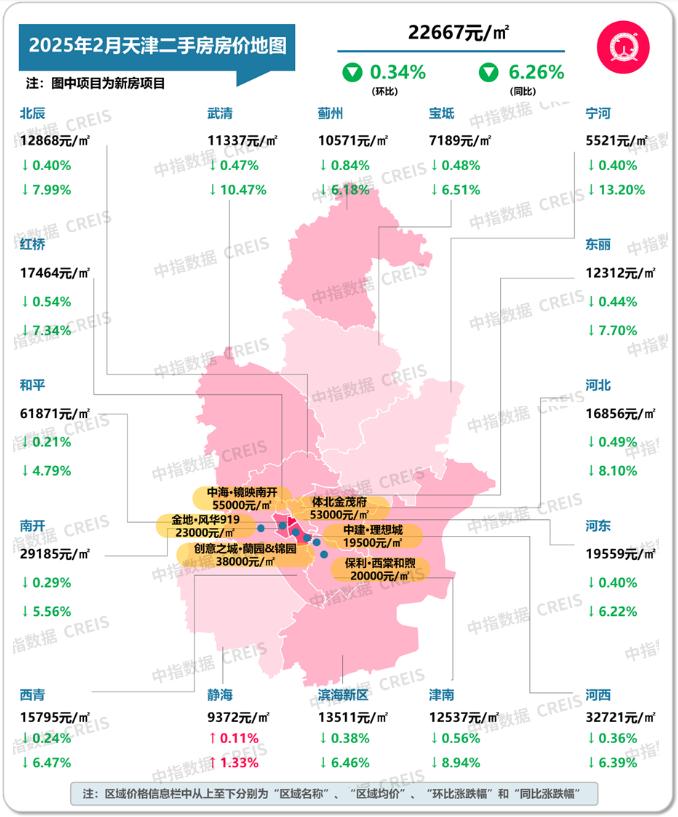

根据中国房地产指数系统百城价格指数,2025年2月,**百城**二手住宅均价环比下跌0.42%,跌幅收窄0.1个百分点,同比下跌7.26%;**十大城市**二手住宅均价环比下跌0.25%,同比下跌6.32%。 图:2025年2月十大城市二手住宅挂牌均价及环同比  数据来源:中指数据CREIS 图:2020年7月至2025年2月十大城市二手住宅均价及环比变化  数据来源:中指数据CREIS 各城市来看,**环比方面,**2月**成都**二手住宅价格上涨0.08%,**已连续4个月保持上涨。** 武汉和南京环比跌幅较大,分别为0.68%、0.56%;广州、重庆(主城区)、天津和杭州环比跌幅均在0.2%-0.4%之间;上海、北京和深圳环比跌幅均在0.1%-0.2%之间。 **同比方面,**2月武汉和南京同比跌幅分别为9.90%、9.67%;杭州、重庆(主城区)同比分别下跌7.35%和7.02%;北京、上海、天津和广州同比跌幅均在5%-7%之间;成都和深圳同比跌幅则均在5%以内,其中深圳跌幅最小,为3.45%。 ### **北京:春节后二手房市场热度逐渐恢复,成交量同比连续5个月保持增长** **成交方面,**春节结束后,北京二手房市场热度有所回升,购房者看房节奏较节前明显加快,周度成交量逐步走高。2月,北京二手住宅成交11876套,同比增长87.6%,同比已连续5个月保持增长,1-2月累计同比增长29.7%。 图:2020年7月至2025年2月北京二手住宅成交套数及二手住宅价格环比走势  数据来源:中指数据CREIS **价格方面,**2月,北京二手住宅价格环比下跌0.17%,同比下跌6.91%,同比跌幅连续4个月收窄。不同辖区来看,西城、东城、朝阳等区域价格保持相对稳定,远郊区域仍通过“特价房源”等方式加速去化。 图:2025年2月北京各市辖区二手住宅挂牌均价及环同比  数据来源:中指数据CREIS ### **上海:2月二手房价格同环比跌幅均收窄,低基数下成交量同比大幅增长** **成交方面,**节后上海中心城区地铁房、学区房市场热度较快恢复,2月,二手住宅成交14982套,同比增长127.1%,1-2月累计同比增长47.2%。 图:2020年7月至2025年2月上海二手住宅成交套数及二手住宅价格环比走势  数据来源:中指数据CREIS **价格方面,**2月,上海二手住宅价格环比下跌0.18%,跌幅较上月收窄0.02个百分点,同比下跌6.49%,同比跌幅连续5个月收窄。 图:2025年2月上海各市辖区二手住宅挂牌均价及环同比  数据来源:中指数据CREIS ### **广州:二手房市场以价换量现象延续,价格环比跌幅收窄** **成交方面,**春节节后二手房市场热度快速恢复,买家入市积极性提高,其中南沙、荔湾、黄埔等拥有优质教育资源的房源表现突出,但由于当前广州二手房挂牌量仍处高位,市场成交仍以降价幅度较大的房源为主。2月,广州二手住宅成交5184套,同比增长10.5%,1-2月累计同比增长23.7%。 图:2020年7月至2025年2月广州二手住宅成交套数及二手住宅价格环比走势  数据来源:中指数据CREIS **价格方面,**2月,广州二手住宅价格环比下跌0.39%,跌幅较上月小幅收窄,同比下跌5.62%。 图:2025年2月广州各市辖区二手住宅挂牌均价及环同比  数据来源:中指数据CREIS ### **深圳:节后二手房成交持续恢复,价格同比跌幅连续5个月收窄** **成交方面,**春节后二手房市场快速恢复,成交套数连续3周呈现环比增长态势,2月深圳二手住宅成交套数3677套,叠加低基数下影响,同比增长106.0%,1-2月累计同比增长56.8%。 图:2020年7月至2025年2月深圳二手住宅成交套数及二手住宅价格环比走势  数据来源:中指数据CREIS **价格方面,**2月,深圳二手住宅价格环比下跌0.13,同比下跌3.45%,同比跌幅连续5个月收窄。 图:2025年2月深圳各市辖区二手住宅挂牌均价及环同比  数据来源:中指数据CREIS ### **杭州:二手房成交同环比均增长,价格环比跌幅连续4个月收窄** **成交方面,**节后市场逐渐回温,尤其是下半月二手房带看量提升明显,2月,杭州二手住宅成交4714套,环比增长3.7%,同比增长220.9%,1-2月累计同比增长62.7%。 图:2020年7月至2025年2月杭州二手住宅成交套数及二手住宅价格环比走势  数据来源:中指数据CREIS **价格方面,**2月,杭州二手住宅价格环比下跌0.26%,跌幅较上月收窄0.12个百分点,环比跌幅已连续4个月收窄。不同区域来看,核心区域优质的次新房价格较稳,远郊刚需盘如临平东湖板块部分房源挂牌价下调明显。 图:2025年2月杭州各市辖区二手住宅挂牌均价及环同比  数据来源:中指数据CREIS ### **南京:高挂牌量下,短期二手房市场继续承压** **成交方面,**春节节后,购房者看房积极性和置业意愿有所提升,市场信心有所修复。但由于南京二手房挂牌量处于高位,议价空间较大,买方市场特征仍明显。2月,南京二手住宅成交7847套,低基数下同比增长17.7%,1-2月累计同比增长5.2%。 图:2020年7月至2025年2月南京二手住宅成交套数及二手住宅价格环比走势  数据来源:中指数据CREIS **价格方面,**2月,南京二手住宅价格环比下跌0.56%,跌幅较上月基本持平。 图:2025年2月南京各市辖区二手住宅挂牌均价及环同比  数据来源:中指数据CREIS ### **武汉:短期二手房价格仍有下行预期** **二手房市场购房者预期偏弱,价格短期仍承压。**2月,武汉二手住宅价格环比下跌0.68%,同比下跌9.90%。 图:2020年7月至2025年2月百城、十大城市及武汉二手住宅价格环比走势对比  数据来源:中指数据CREIS 分区域来看,各市辖区二手住宅价格环比均继续下跌,多数区域跌幅较上月扩大。3月伴随“小阳春”传统旺季到来,市场活跃度或小幅回升,但价格企稳尚需时间。 图:2025年2月武汉各市辖区二手住宅挂牌均价及环同比  数据来源:中指数据CREIS ### **成都:二手房市场维持一定活跃度,价格环比连续4个月上涨** **成交方面,**随着节后返城复工,成都二手房市场交易热度逐步上升,但市场分化仍为显著,“5+2”区域整体表现较好,市场议价空间有所收窄,二圈层如青白江、新都等区域去化压力仍较大,仍依赖低价策略。 2月,成都二手住宅成交17546套,环比增长2.1%,同比增长88.8%,1-2月累计同比增长31.5%。 图:2020年7月至2025年2月成都二手住宅成交套数及二手住宅价格环比走势  数据来源:中指数据CREIS **价格方面,**2月,成都二手住宅价格环比上涨0.08%,连续4个月环比上涨。3月传统旺季叠加政策效应,预计核心区二手房市场或将持续活跃。 图:2025年2月成都各市辖区二手住宅挂牌均价及环同比  数据来源:中指数据CREIS ### **重庆(主城区):2月二手房价格延续下行态势,核心区房源价格相对平稳** **价格方面,**2月初,重庆全面取消限售政策,一些地段不佳、配套不完善住房或者老旧房源,因竞争加剧出现价格下行压力,而核心区优质房源及学区房表现相对较好。 图:2020年7月至2025年2月百城、十大城市及重庆二手住宅价格环比走势对比  数据来源:中指数据CREIS 2月,重庆二手住宅整体环比下跌0.37%,同比下跌7.02%。3月,在楼市传统“小阳春”行情及教育需求释放的推动下,重庆二手房市场调整压力或有所缓解。 图:2025年2月重庆(主城区)各市辖区二手住宅挂牌均价及环同比  数据来源:中指数据CREIS ### **天津:前期学区政策驱动下,2月部分核心区市场表现活跃,但价格下跌态势未改** 2月春节假期结束后,天津二手住宅市场持续回暖,其中河西、南开、河东等具备学区属性的区域表现活跃。 图:2020年7月至2025年2月百城、十大城市及天津二手住宅价格环比走势对比  数据来源:中指数据CREIS **价格方面,**2月,天津二手住宅价格环比下跌0.34%,同比下跌6.26%。3月,在两会政策利好及市场情绪驱动下,潜在购房需求有望继续释放,或带动天津二手房市场进一步修复。 图:2025年2月天津各市辖区二手住宅挂牌均价及环同比  数据来源:中指数据CREIS ### **结语** 整体来看,春节假期结束后,重点城市二手房市场活跃度逐渐恢复,市场交易回归常态。同时二手房价格表现相对平稳,其中成都价格环比已连续4个月上涨,多数城市环比跌幅收窄。3月,在“金三银四”传统旺季、教育需求入场及政策利好带动下,居民置业情绪有望得到修复,二手房成交量继续恢复。 “止跌回稳”仍是今年房地产政策核心目标,今年两会政府工作报告把“稳住楼市股市”写进总体要求,并再次强调要“持续用力推动房地产市场止跌回稳”,为市场传递信心;同时也提到“因城施策调减限制性措施…充分释放刚性和改善性住房需求潜力”。若北上深等核心城市加快优化限购限贷政策,将有助于加快市场企稳。 另外,当前部分城市二手房价格已几乎调整至合理水平,随着教育需求释放,短期核心城市二手房市场热度有望持续。

<blockquote><p>在合同管理系统领域,竞争日趋激烈,如何在全生命周期管理赛道中脱颖而出,成为企业关注的焦点。这篇报告将深入分析各大合同管理系统的核心功能与优势,揭示其在市场中的生存逻辑,并探讨突破现状的有效策略,助力企业找到适合自己的最佳解决方案。</p> </blockquote>  ## 一、市场全景:谁是我们的敌人,谁是朋友? 当前合同管理系统(CLM)市场呈现“功能趋同,策略分化”的格局,可拆解为五大阵营: - 电子签章派:法大大、契约锁等,以电子签章为入口,逐步延伸至合同管理全流程,但核心收入仍依赖签署量抽成; - 法律科技派:幂律智的MeFlow等,专注AI合同审查,构建垂直行业合规壁垒; - 生态寄生派:钉钉智能合同等,依托协同场景嵌入轻量审批功能,主打中小客户; - 全生命周期管理派:蓝凌、泛微、肇新合同等,宣称覆盖合同起草到履约全流程,但内部策略分化严重。 **关键结论**:根据我公司软件的内容,前四类厂商并非直接对手,因为他们针对的场景和所拥有的壁垒不是我们可比拟和超越的。真正的威胁来自我们公司产品的同行-全生命周期管理赛道的同类玩家(蓝凌、泛微、肇新合同)。而且三者拥有相似的功能,实则生存逻辑迥异。 ## 二、深度对决:高端定制VS源码交付的生死局 ### 2.1 产品定位与客群真相 **蓝凌**:国企与大型集团公司的“数字化包工头”。 典型场景:某央企要求合同审批流程适配其18个部门、37类分支条件,蓝凌投入20人团队耗时8个月完成定制; 商业模式:项目制收费(100万起步),赚的是“复杂流程落地”的手工钱。 **泛微**:民营企业OA协同场景的“深度绑定者”。 典型场景:某连锁酒店集团将合同审批与门店预算、店长绩效挂钩,泛微通过OA数据联动实现自动管控; 商业模式:年费制(50万+)叠加模块定制费,本质是“系统集成服务费”。 **肇新合同**:中小企业的“源码贩子”,集成商的“技术苦力”。 典型场景:某区域IT服务商采购肇新源码,二次开发后以“自研产品”名义卖给当地中小企业; 商业模式:源码授权(5万20万),靠走量分摊研发成本,利润依赖生态分润。 ### 2.2 功能对比:全流程的虚实 **合同起草:** 蓝凌/泛微:提供人工维护的模板库,AI仅用于基础条款推荐; 肇新:支持AI生成草稿,但需人工校准,实际节省时间不超过30%。 **履约监控:** 蓝凌:人工设置关键节点(如付款日),到期前邮件提醒; 肇新:宣称AI自动监控,实则依赖人工录入履约条款(如“验收后7日内付款”)。 残酷真相:当前没有厂商能真正实现“全流程自动化”,所谓AI能力多为营销话术。 ### 2.3 商业模式的本质冲突 **蓝凌/泛微的困境:** 优势:高客单价(100万+)、客户粘性强; 死穴:人力成本占比超60%,10人团队一年只能接4、5个项目,规模化无解。 **肇新合同的隐患:** 优势:边际成本低,源码可无限复制; 死穴:渠道失控(集成商拿源码后自立品牌)、功能同质化(中小企业只关心价格)。 ## 三、破局建议:打不过就重新定义规则 ### 3.1 功能分层:切割战场 **基础层:** 提供开源版核心功能(如合同起草、审批),对标肇新争夺中小客户; 盈利点:开放API接口收费(如与电子签厂商数据打通)。 **增值层:** 开发AI合规审查模块(采购MeFlow算法授权),主攻金融、医疗客户; 盈利点:按审查次数抽成(如0.5元/次)。 ### 3.2 生态合谋:与敌人交朋友 与蓝凌/泛微合作: 为其定制项目提供AI模块(如履约监控),抽成15%-20%; 本质:成为巨头的“技术外包商”。 ### 3.3 与钉钉共生 在钉钉应用市场发布极速版,功能限定为“审批+签署”,免费换流量; 转化策略:引导至付费版(如AI合规审查试用)。 ## 四、行动清单:活下去比理想更重要 ### 4.1 客户验证 走访3家蓝凌KA客户,测试其AI模块付费意愿; 接触5家肇新集成商,评估渠道合作可能性。 ### 4.2 成本测算 开源版研发投入(6个月,150万) vs 预期收益(年授权费300万); AI模块外采成本(MeFlow接口费50万/年) vs 抽成收益。 ### 4.3 风险备案 若巨头(如钉钉)封杀,保留私有化部署能力; 若政策收紧(如AI合规审查资质),转向人工审核辅助工具。 ## 写在最后 写完这篇文章,我摸了摸所剩无几的头发,突然意识到:在ToB市场,所谓“技术领先”往往敌不过“成本控制”与“渠道霸权”。或许我们应该少谈点理想,多研究怎么让客户心甘情愿掏钱——哪怕只是为了一丁点效率提升。后续我会继续把我的感想写进来的,要是老板允许的话,把我的竞品报告也发进来。兄弟们有想要的加我,我可以先给你们发零散资料。PS:编辑大大,为啥不让我插图片啊,一插图片就显示网络错误。 本文由 @合同管理吴彦祖 原创发布于人人都是产品经理。未经作者许可,禁止转载 题图来自Unsplash,基于CC0协议 该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务

Epic 宣布与高通合作,为EOS反作弊服务(又称“轻松反作弊”服务)添加对 Windows on Snapdragon 的支持,并将在今年晚些时候在 Windows on Snapdragon 设备上推出《堡垒之夜》。这将帮助开发者将更多游戏带到更多设备上。  在过去的一年中,基于Windows 11 Arm的笔记本电脑的出现改变了PC产业的格局,高通的 Snapdragon X 系列处理器代表了PC游戏市场中一个快速增长的领域。然而,当今大多数PC游戏都是针对x64编译的,这并不能直接转换为 Windows on Snapdragon 架构。由于反作弊软件与x64功能的协同方式,需要额外的工具才能与这些设备兼容。 当今的数百款多人游戏(包括《堡垒之夜》)都依赖轻松反作弊服务来对抗多人电脑游戏中的黑客攻击和作弊行为。除了为《堡垒之夜》发布对 Windows on Snapdragon 的反作弊支持之外,官方还将通过特制的Epic在线服务SDK版本为开发人员提供此支持。这样,使用轻松反作弊服务(EAC)的开发者就能够将此项兼容性引入到他们自己的游戏中。  对《堡垒之夜》进行 Windows on Snapdragon 反作弊支持的实战测试将有助于确保在其他游戏中的顺利实施。Epic期待让玩家能够在由 Snapdragon X 系列驱动的最新 Windows 设备上享受他们最喜欢的、支持Epic在线服务反作弊功能的游戏。 全球各地的游戏开发者均可免费使用Epic 在线服务,无论他们的游戏采用何种引擎开发,以及将会登陆哪个PC商城进行销售。

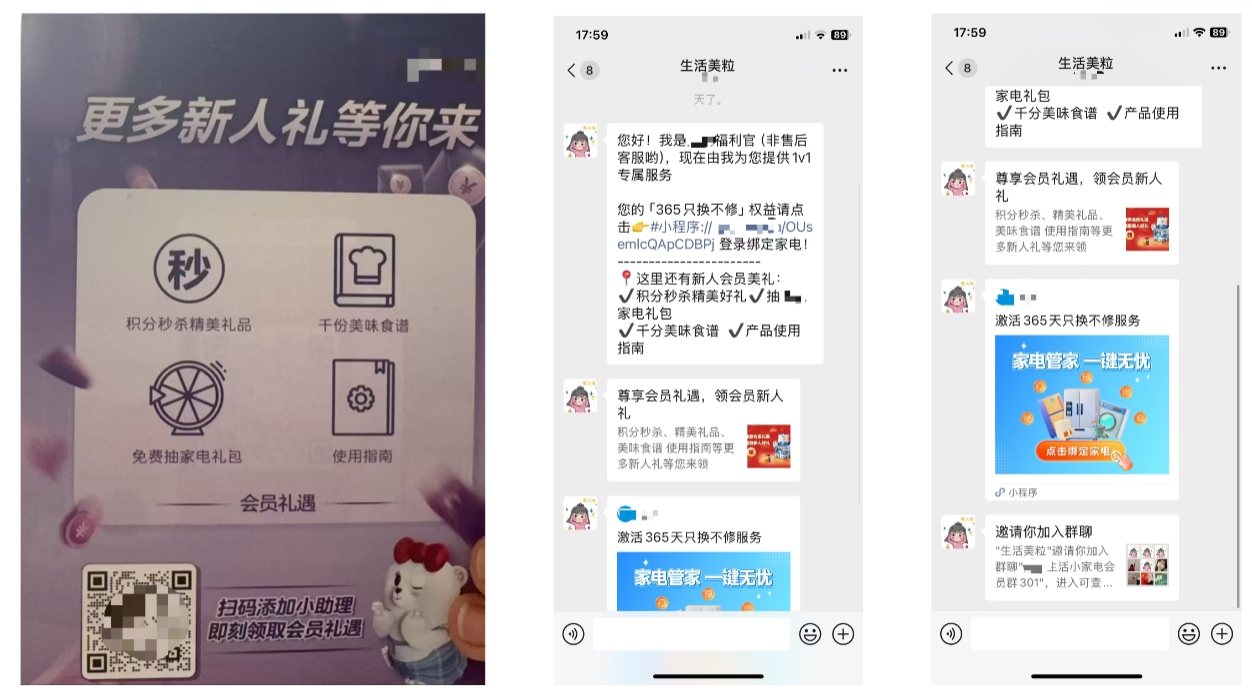

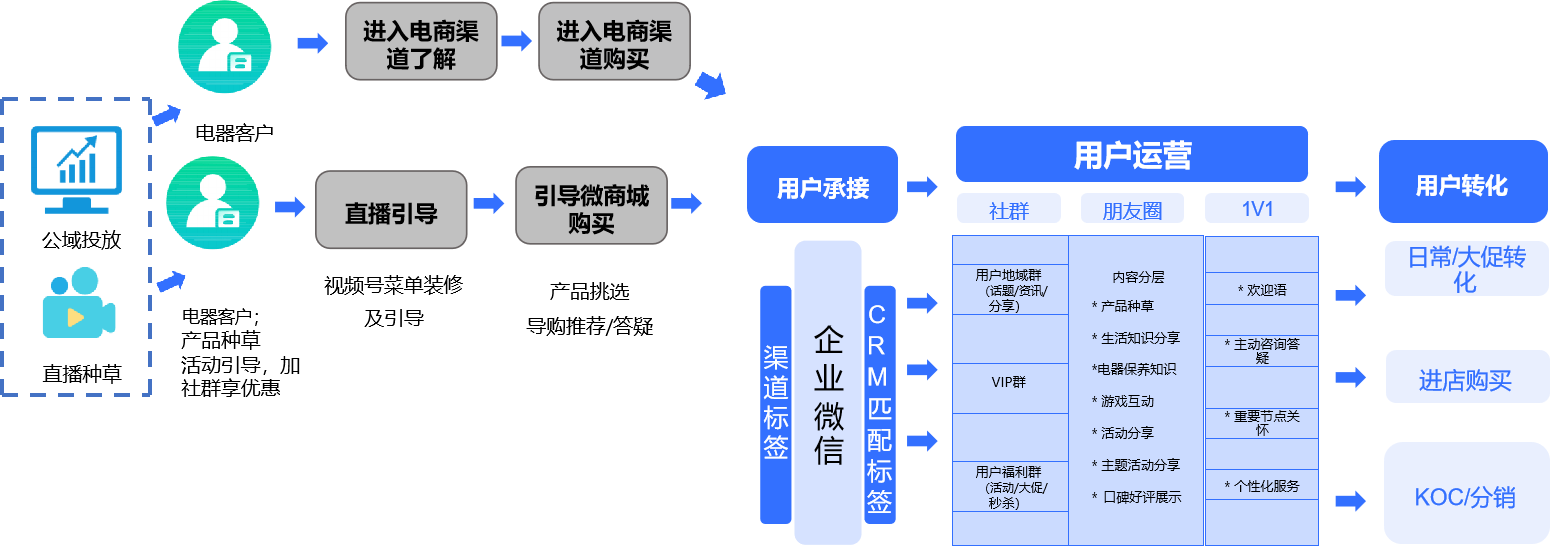

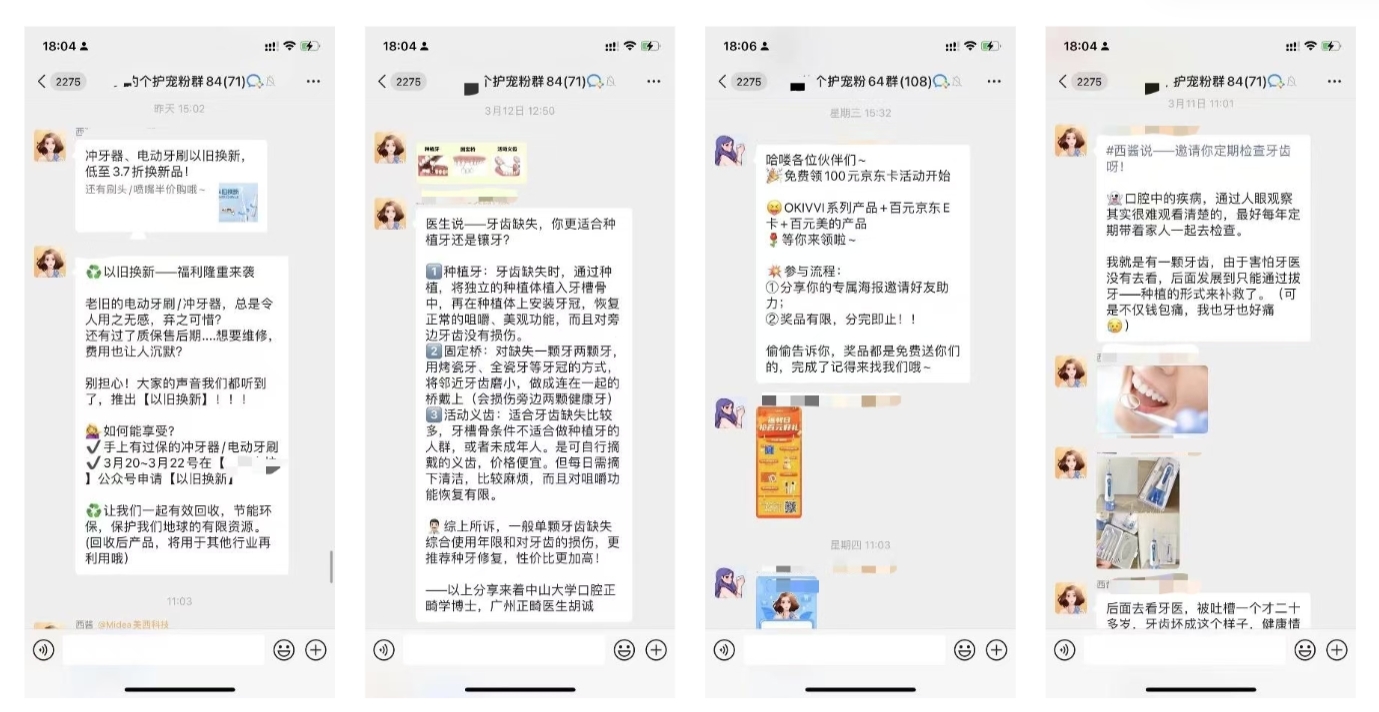

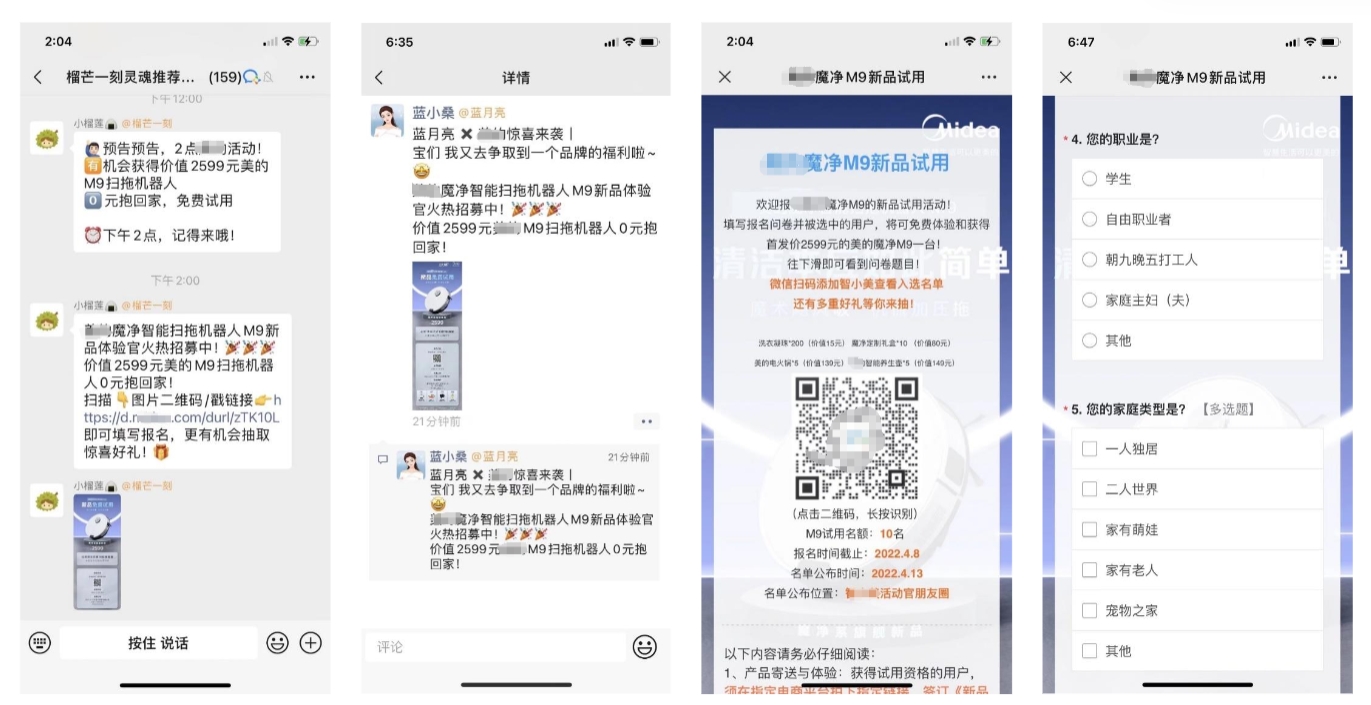

<blockquote><p>传统电商平台和线下渠道的流量成本不断攀升,用户粘性和复购率却难以提升。面对这些挑战,私域运营成为品牌突破困境的关键路径。本文将分享一家国内头部家电品牌如何通过构建私域流量池,实现用户精细化运营,最终将复购率提升40%以上的成功经验。</p> </blockquote>  ## 一、品牌背景 ### 基础信息 所属行业:家电行业 该品牌是国内一家家电类头部品牌,主营产品有空调、冰箱、洗衣机、厨房家电、生活家电、热水净水等等,主要面向C端用户智能化场景搭建。这种类型业务属于典型的,高客单,低复购,交叉销售机会大,售后服务属性强,非常适合做私域。 ### 业务痛点 作为一家头部的家电品牌,其实他们在京东、淘宝等传统电商,以及线下门店,经销商等传统渠道,已经取得了很好的成绩。但是随着竞争越来越激烈,他们业务也存在以下痛点: - **全域数据割裂**:公私域数据未打通,难以对用户做洞察,找到业务增长点。 - **公域依赖严重**:天猫、京东等平台流量成本上涨30%,用户复购依赖促销活动; - **用户粘性不足**:缺乏持续触达渠道,触达效率低,新品推广依赖广告投放; - **服务效率低下**:数据未打通,加上售前售后问题重人工响应,没有工具,咨询响应慢。 ### 私域目的 - 搭建全域用户池,实现线上线下流量互通; - 通过精细化运营提升用户LTV,复购率目标提升40%+; - 建立”专业顾问+即时服务”私域体系,降低人工成本30%。 ## 二、私域人设  ## 三、私域引流 **功能使用:渠道活码、企微标签、好友欢迎语、新好友运营、好友裂变** ### 包裹卡引流  首先,是电商场景最常见的包裹卡引流,引流的利益点包括积分秒杀、免费抽家电礼包,以及因为是高客单的耐用品,所以还有一些客户比较关心的,食谱、使用指南等。基本都是围绕客户画像和客户需求设计的利益点,可以做到加粉率20%以上。 ### AI智能加粉  其次,品牌自有CRM其实也积累了很多历史线索,只有电话号码的情况下,触达渠道也是非常有限的,所以他们也将这些历史线索做了分层,然后通过AI外呼配合主加+短信的方式,将这些线索筛选、激活,尽最大可能沉淀到企业微信私域。全链路借助工具实现了自动化,人工只需要前期配置就好,通过这种方式,极大提升效率和通过率,实现私域好友快速沉淀。 ### 公众号/视频号/小程序引流  公众号/视频号/小程序也多触点布局了引流,尽量将私域内其他应用的流量,也加到可以多次触达的企业微信。比方在公众号的欢迎语、公众号菜单栏、公众号的文章内,都设有引流触点。利益点包括0元试用、限时秒杀、限时特惠、隐藏福利、代金券等。 ## 四、私域运营  ### 数据打通 **功能使用:全渠道订单数据打通、渠道自动打标签、消费标签、企微标签** 首先是全域数据打通,因为转化率的提升,其实非常依赖于客户洞察,给合适的客户针对性推送不同的内容。但是以往客户做私域,由于没有打通客户的消费数据,所以营销信息只能是盲发,盲推,导致私域业绩一直上不去,客户流失也比较严重,每群发一次,就流失一批客户。 所以专门针对这个痛点,通过全渠道订单绑定的形式,打通客户的公私域消费数据,自动计算并打上对应的消费标签,丰富标签体系,这样就可以针对客户的消费偏好精准推送,大幅提升转化率,降低流失率。 不得不说,精细化运营的基础,就是数据打通以及标签体系的建立,他们的标签体系大致分为以下几个维度: ### 1v1运营 **功能使用:客服工作台、素材库、新好友运营、指定好友SOP、高级群发、复购提醒** 1)新好友自动接待 新好友刚添加的节点是极其重要的节点,因为这个时候客户是有兴趣的,是否能在这2分钟留住客户,决定了后续的转化。  所以他们在一开始就使用新好友SOP功能,尽可能的让新加进来的用户,做更多的动作:领取售后权益、积分抽奖、食谱、产品使用指南,以及收集客户生日,在生日的时候赠送优惠券,促进节日转化。此外,在欢迎语的环节,用的新好友运营功能,设置了入群邀请链接,最大化提升入群率。 2)SOP自动培育 为了最大化提升转化率,他们还针对不同的人群,不同的阶段,设置了自动化智能触达的策略,例如: - **高净值用户**:针对消费金额、频次高的高净值用户,每月推送新品优先体验邀请; - **价格敏感用户**:针对主要是关注促销、领券的用户,推送优惠券、满减券等活动促转化; - **沉默用户**:对于一直无回应的沉默用户,定期推送种草类文案,激发需求; - **复购提醒**:对于一些明显有消耗属性的电器品类,例如电动牙刷需要定期更换刷头、净水器需要更换滤芯等,可以自动识别客户的复购周期,自动化精准推送复购提醒。 3)客服接待 对于他们这种服务和知识属性比较重的产品来讲,每天售前售后问题都会相对比较多。现在的用户都没什么耐心,客服需要秒回才能给到客户一个相对还不错的体验,否则几分钟不回可能都会被拉黑或者投诉。所以企微客服接待如何尽最大可能提效,也是一个很关键的问题。 为了用最少的人力,最高效的回复客户的咨询,他们使用了工作台来进行接待,同时配合自动回复,大幅度提效,提升客户体验。 ### 社群运营 **功能使用:客服工作台、群聊群发、群防骚扰、群关键词回复、群欢迎语、社群分析** 1)社群种草  在社群内的基本上已经是购买过产品的客户,为了提升留存活跃和复购,会针对这类客户的潜在痛点和需求点,发送不同的营销内容。例如以旧换新、老带新活动、知识科普、健康科普等。 2)新品试用  在新品上新的时候,会联合不同的品牌,在社群内进行宣传推广,收集新品反馈建议。 3)社群答疑 对于社群中的售后问题,常见问题使用关键词回复,而个性化的问题,使用客服工作台筛选消息进行人工回复,高效率统一解答,大幅度提升客户满意度。 ### 朋友圈运营 **功能使用:朋友圈定向群发、朋友圈自动评论、自动打标签**  朋友圈也是私域运营中一个非常重要的触达渠道,用户每天在刷朋友圈的过程中强化对品牌的认知,简直就是免费的广告。朋友圈发送的内容主要分为以下几类: - **活动推广**:例如会员日、品牌日的活动推广,通过特定节日优惠引导转化; - **新品宣发**:产品上新需要市场推广,通过新品试用+问卷获取市场反馈,优化产品和营销; - **生活分享**:为了打造私域人设,在节假日或者日常,也会发送一些生活感悟类朋友圈; - **产品种草**:结合特定场景痛点,输出解决方案并植入产品广告,例如菜谱和美食制作方法。 总之,自从使用智能化全域运营以来,他们有效解决了人效低的问题,通过SOP自动化,帮助企业大幅提升了触达&服务效率,促进了用户的转化复购。 一些链路,需要相关的SCRM功能做配合才能实现,也不是所有的SCRM都可以实现。 **专栏作家** 猫雯私域研究社,微信公众号:猫雯私域研究社,人人都是产品经理专栏作家。专注于客户关系管理研究,包括私域流量运营、社群运营、用户运营等细分方向。 本文原创发布于人人都是产品经理,未经作者许可,禁止转载 题图来自 unsplash,基于 CC0 协议 该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

由 Cygames 制作的二次元卡牌游戏新作《影之诗:超凡世界》将于6月17日推出。游戏新增“超进化”和“乐园功能”等新元素和新内容, 这将成为一款迈进新次元的电子卡牌游戏。 无论是《影之诗》的老玩家,还是新玩家, 都可以在进化后的影之诗中获得全新体验。 <内嵌内容,请前往机核查看> 值得一提的是,团队宣布“世界”中的非卡牌对战游戏要素,如钓鱼、麻将、RPG等,经过重新评估后决定暂停开发,专注于打造增加卡牌对战趣味的虚拟空间“影之诗乐园”。在“影之诗乐园”中,主战者们依然可以进行与大厅中的其他玩家对战、与公会的朋友们聚会等等活动。未来也将在“乐园“内举办线上比赛,以及可以让所有影之诗玩家参加的大型活动。         超进化需要使用与普通进化不同的“超进化点”,先后手各有2点“超进化点”。所有随从都可以进行超进化。超进化后的随从不仅攻击力和生命值各增加3点,还会获得【突进】能力,并在该回合结束前所受到的伤害将为0,且不会被任何能力破坏。如果超进化后的随从击倒了对方的随从,会将对方的随从击飞并撞向对方主战者,对主战者造成1点伤害。超进化的加入会让卡牌对战更具策略性和爽快感。另外,超进化时会发动随从的“进化时能力”和“超进化时能力”。

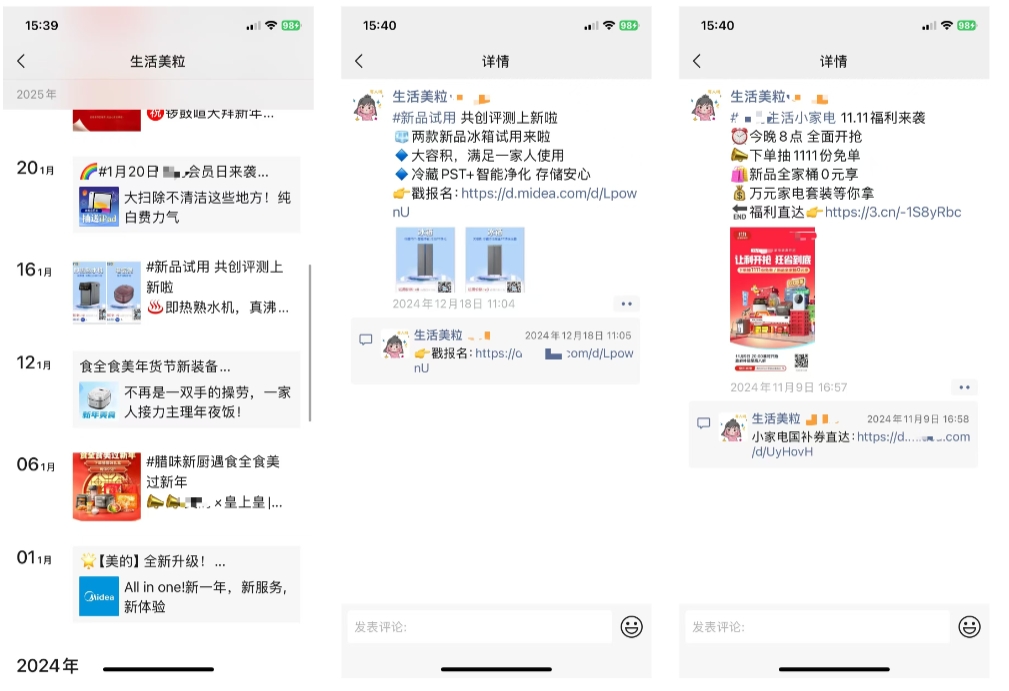

Akira 勒索软件团伙被发现利用不安全的网络摄像头,对受害者网络发起加密攻击,且成功绕过了用于阻止 Windows 中加密器的端点检测和响应(EDR)系统。这一不寻常的攻击方式,是网络安全公司 S-RM 团队在近期对一位客户的事件响应过程中发现的。 值得关注的是,Akira 勒索软件团伙最初尝试在 Windows 系统上部署加密器,不过被受害者的 EDR 解决方案阻止。在此之后,他们才转而利用网络摄像头实施攻击。 **Akira 的非常规攻击链** Akira 的攻击链条十分复杂。威胁行为者起初通过目标公司暴露的远程访问解决方案,可能是利用被盗凭证或者暴力破解密码,得以访问公司网络。获取访问权限后,他们部署了合法的远程访问工具 AnyDesk,并窃取公司数据,为后续的双重勒索攻击做准备。接着,Akira 利用远程桌面协议(RDP)进行横向移动,将自身影响范围扩展到尽可能多的系统,随后尝试部署勒索软件负载。最终,威胁行为者投放了一个受密码保护的 ZIP 文件(win.zip),里面包含勒索软件负载(win.exe),但受害者的 EDR 工具检测到并隔离了该文件,使得这次攻击暂时受阻。 在这次失败后,Akira 开始探索其他攻击途径。他们扫描网络,寻找可用于加密文件的其他设备,发现了网络摄像头和指纹扫描仪。S-RM 解释称,攻击者选择网络摄像头,是因为其容易受到远程 shell 访问,且可被未经授权地观看视频。此外,网络摄像头运行的是与 Akira 的 Linux 加密器兼容的 Linux 操作系统,并且没有安装 EDR 代理,因此成为远程加密网络共享文件的理想设备。  Akira 攻击步骤概览( 来源:S-RM) S-RM 向 BleepingComputer 证实,威胁者利用网络摄像头的 Linux 操作系统,挂载了公司其他设备的 Windows SMB 网络共享。随后,他们在网络摄像头上启动 Linux 加密器,以此加密 SMB 上的网络共享,成功绕过了网络上的 EDR 软件。S-RM 指出:“由于该设备未被监控,受害组织的安全团队并未察觉到从网络摄像头到受影响服务器的恶意服务器消息块(SMB)流量增加,否则他们可能会收到警报。” 就这样,Akira 得以成功加密受害者网络上的文件。 S-RM 告知 BleepingComputer,针对网络摄像头漏洞已有相应补丁,这意味着此次攻击,至少是这种攻击方式,本可以避免。这一案例表明,EDR 保护并非全面的安全解决方案,组织不能仅依赖它来防御攻击。此外,物联网设备不像计算机那样受到密切监控和维护,却存在重大风险。所以,这类设备应与生产服务器和工作站等更敏感的网络隔离。同样重要的是,所有设备,包括物联网设备,都应定期更新固件,修补可能被攻击的已知漏洞。 此外,物联网设备不像计算机那样受到密切的监控和维护,但仍然存在重大风险。 因此,这些类型的设备应该与更敏感的网络(如生产服务器和工作站)隔离。 同样重要的是,所有设备,甚至是物联网设备,都应该定期更新其固件,以修补可能被攻击的已知漏洞。

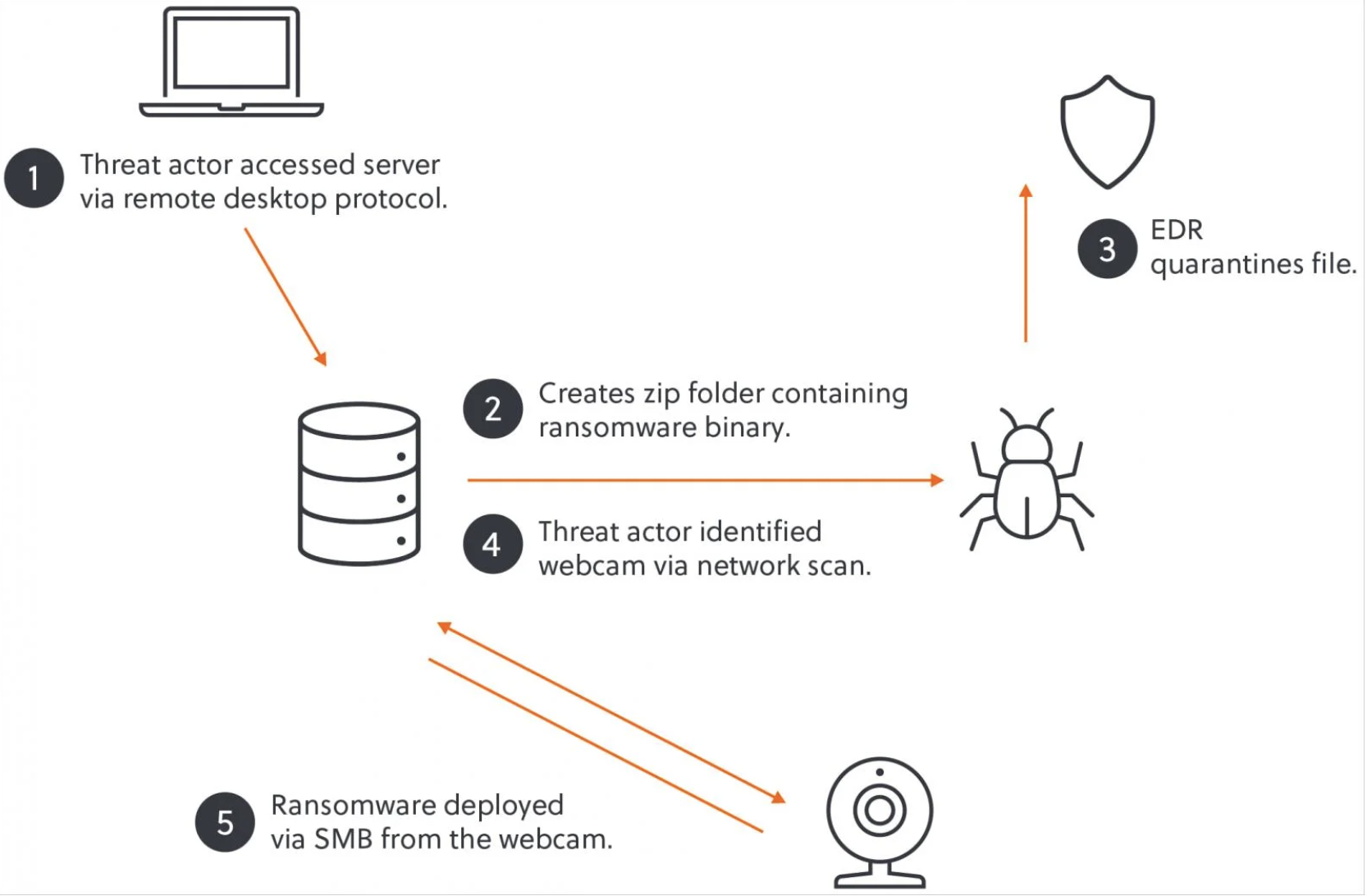

新发现的剪贴板劫持操作 “MassJacker”,利用至少 778,531 个加密货币钱包地址,从受感染计算机中窃取数字资产。 据发现 MassJacker 活动的 CyberArk 称,在分析时,与该行动相关的大约 423 个钱包内共有 95,300 美元。不过,历史数据显示,其涉及的交易金额曾更大。此外,威胁行为者似乎将一个 Solana 钱包作为中央收款中心,截至目前,该钱包已累计完成超过 30 万美元的交易。 CyberArk 怀疑整个 MassJacker 行动与特定威胁组织有关联。因为在整个活动过程中,从命令和控制服务器下载的文件名,以及用于解密文件的加密密钥始终保持一致。然而,该操作也有可能遵循恶意软件即服务模式,由中央管理员向各类网络犯罪分子出售访问权限。  CyberArk 将 MassJacker 称为加密劫持操作,虽然 “加密劫持” 这一术语通常更多用于描述利用受害者的处理 / 硬件资源进行未经授权的加密货币挖掘行为。实际上,MassJacker 依赖于剪贴板劫持恶意软件(clippers)。这种恶意软件会监视 Windows 剪贴板中复制的加密货币钱包地址,并将其替换为攻击者控制下的地址。如此一来,受害者在不知情的情况下,就会把原本要汇给他人的钱,错汇给攻击者。剪辑器这种工具虽简单,却极为有效。由于其功能和操作范围有限,特别难以被察觉。 **技术细节** MassJacker 通过 pesktop [.] com 进行分发,该网站既托管盗版软件,也存在恶意软件。从该站点下载的软件安装程序会执行一个 cmd 脚本,该脚本进而触发一个 PowerShell 脚本,PowerShell 脚本会获取一个 Amadey 机器人以及两个加载器文件(PackerE 和 PackerD1)。Amadey 启动 PackerE,随后 PackerE 解密并将 PackerD1 加载到内存中。 PackerD1 具备五种嵌入式资源,用以增强其逃避检测和反分析的性能。这些资源包括即时(JIT)挂钩、用于混淆函数调用的元数据令牌映射,以及用于命令解释的自定义虚拟机(并非运行常规的.NET 代码)。PackerD1 解密并注入 PackerD2,最终解压缩并提取出最终有效负载 MassJacker,并将其注入合法的 Windows 进程 “InstalUtil.exe” 中。  MassJacker 利用正则表达式模式,对剪贴板中的加密货币钱包地址进行监视。一旦发现匹配的地址,就会将其替换为加密列表中攻击者控制的钱包地址。 CyberArk 呼吁网络安全研究界密切关注 MassJacker 这类大型加密劫持行动。尽管此类行动造成的经济损失可能相对较低,但却能够泄露许多威胁行为者的宝贵身份信息。

<blockquote><p>通过深入解析用户需求与行为,产品团队能够更精准地规划和优化产品路线图。在这篇文章中,我们将全面解读用户故事地图的核心概念、操作流程以及如何在实践中进行高效优化,为你的产品开发提供强有力的支持。</p> </blockquote>  ## 一、用户故事地图到底是个啥? 想象一下,你是个导演,用户是主角,产品就是这部电影。用户故事地图就是你给这部电影画的“分镜头脚本”——把用户从打开产品到完成任务的所有动作、痛点、爽点,像拼图一样摊在桌面上,让团队一眼看明白用户到底在经历什么。 举个接地气的例子: 你团队要做个买菜App,大家七嘴八舌说功能:“得有个智能推荐!”“加个直播卖菜吧!”。这时候如果用用户故事地图,你们会先冷静下来,把用户买菜的真实流程还原出来: **“出门前打开App→比价选菜→凑满减→纠结怎么配送→付款后担心菜品质量→收到货检查→不爽了给差评”** 这时候突然发现:哎?用户最头疼的其实是**“凑满减浪费时间”**,而不是你们以为的“直播功能”。这时候,团队立马知道该优先做“智能凑单”功能,而不是跟风搞直播。这就是用户故事地图的魔力——**让所有人回到用户真实场景,而不是自嗨式开发**。  ## 二、手把手教你画地图:别搞复杂,记住这4步就行 ### 第1步:准备阶段——先搞清楚“为谁做”和“为啥做” **别急着画图!先拉齐认知**: 找张白板(或者打开在线协作工具),先和团队吵清楚: **用户到底是谁**?宝妈?上班族?退休大爷?(比如宝妈最关心配送时间准不准,上班族可能想要“30秒极速下单”) **产品核心要解决什么**?是帮用户省时间?省钱?还是减少决策焦虑? (曾经有个团队做健身App,以为用户想要酷炫课程,结果用户调研发现大家最需要的是“防摸鱼监督功能”…) **工具越简单越好**: 别被工具绑架!便利贴+白板就够用,颜色区分动作(黄色)、任务(蓝色)、痛点(红色)。实在要线上协作,推荐用**boardmix**(模板多)或**Miro**(协作方便),但记住:**工具只是辅助,脑子才是关键**。 ### 第2步:集体脑暴——把用户旅程“撕碎了再拼起来” **先让所有人闭麦写便签**: 每人独立写用户动作,比如“搜索商品”、“看差评”、“和客服撕逼”,写够20张再停。这招专治“老板说啥就是啥”的团队马屁精,避免漏掉真实场景。 **贴便签也有玄机**: **横向按时间排**:左边是用户第一步(比如“打开App”),右边是最后一步(比如“晒单评价”)。 **纵向按重要性分**:上层是必须有的功能(比如“加入购物车”),下层是锦上添花(比如“智能推荐相似商品”)。 (重点来了!一定要边贴边问:“用户这时候在想啥?生气还是开心?”比如付款环节突然弹广告,用户可能直接卸载!) ### 第3步:砍需求比做需求更重要 **第一版只做“活下去”的功能**: 拿把尺子横向一划,只保留用户**不完成就活不下去**的主干流程。比如外卖App的第一版,只要有“选餐馆→点菜→付款→查看配送”就够了,什么会员积分、小游戏统统砍掉! **学会用“KANO模型”怼人**: 当有人非要加个“AR试穿”这种炫技功能时,直接甩出三类需求: - **基本需求**(没有就死):比如商品详情页 - **期望需求**(有了更好):比如价格对比 - **兴奋需求**(没有也行):比如虚拟试妆 (曾经有个团队在医疗App里加“AI算命测健康”,结果用户吐槽:“连预约挂号都卡,算个毛线!”) ### 第4步:边做边改——地图不是用来裱墙的! **每周拿用户反馈打脸**: 做完第一个版本,别自嗨!赶紧找真实用户来用,然后把他们的吐槽直接贴到地图对应位置。比如用户说“搜索太难用”,你就找到地图里的“搜索商品”环节,贴上:“用户实际输入3次才找到想要的口红色号”。 **版本规划像下棋**: 把地图纵向切成几个版本,比如: - **V1.0**:能跑通核心流程(让用户活着) - **V2.0**:优化体验痛点(让用户爽) - **V3.0**:加差异化功能(让用户尖叫) (比如某读书App,V1只做“扫码查书价”,V2加“比价提醒”,V3才做“书友社交”,避免一开始铺太开) ## 三、血泪教训:新手最容易踩的3个坑 **把用户当傻子,以为自己最懂** **反面教材**:某团队给老年人做App,把字体调成炫彩渐变,结果用户根本看不清。 **救命招**:直接拉用户参与画地图!哪怕请个外卖小哥来办公室,让他边吐槽边贴便签,比你们猜100遍都有用。 **沉迷细节,忘了主线** **反面教材**:讨论“健身课程页面”时,纠结按钮圆角用2px还是3px,结果忘了课程加载慢才是痛点。 **救命招**:给每个环节设个“3分钟闹钟”,时间一到必须推进,细节留到开发阶段再抠。 **把地图当一次性作业** **反面教材**:地图画完拍个照,从此再没更新过,结果需求越加越乱。 **救命招**:把它当成“产品族谱”,每次迭代前全员对着地图开10分钟站会,用马克笔直接修改,保持动态更新。 ## 四、说人话的终极心法 用户故事地图不是什么高端黑科技,它本质上是一种**“强迫团队走出办公室”**的工具。记住三个关键词: **真实**:用户怎么做,你就怎么画,别自己加戏 **聚焦**:80%的精力死磕20%的核心流程 **灵活**:边做边改不丢人,一条路走到黑才要命 本文由 @佳简几何 原创发布于人人都是产品经理,未经许可,禁止转载 题图来自 Unsplash,基于 CC0 协议 该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

Steam 春季特卖火热进行中,活动将持续至 3 月 20 日!与精彩的主题特卖不同,季节性特卖的“主题”就是——任何种类的游戏都可能享受折扣!本周不妨花点时间,浏览一下最爱的游戏类型和类别。以下是值得注意的好价: <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看> <内嵌内容,请前往机核查看>

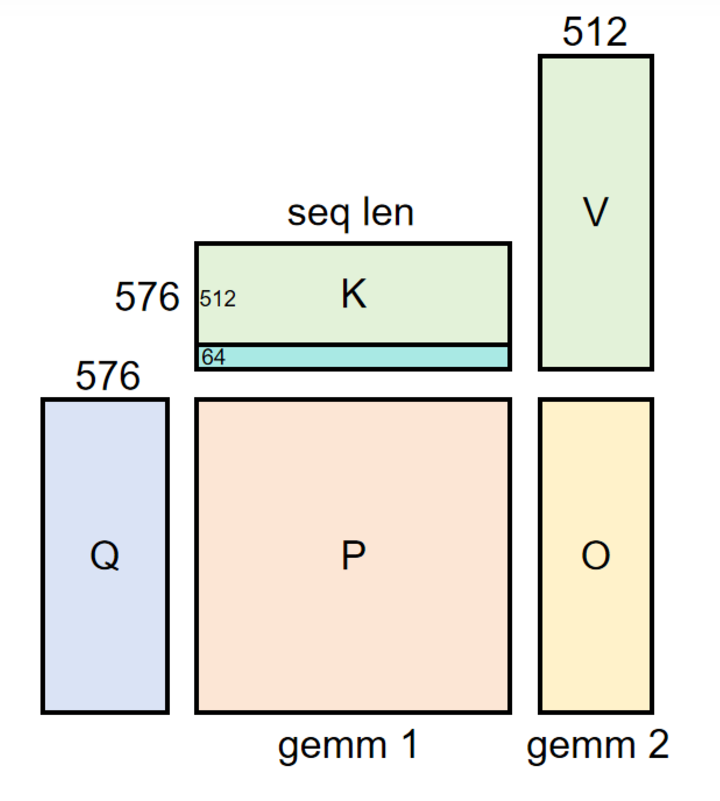

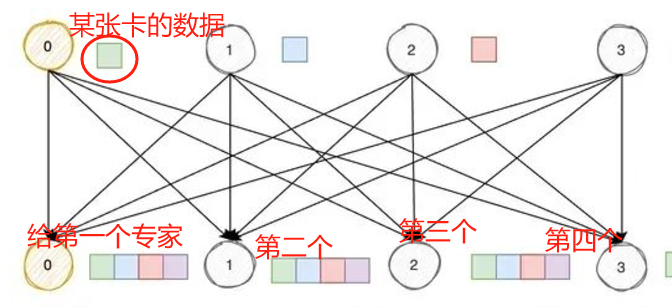

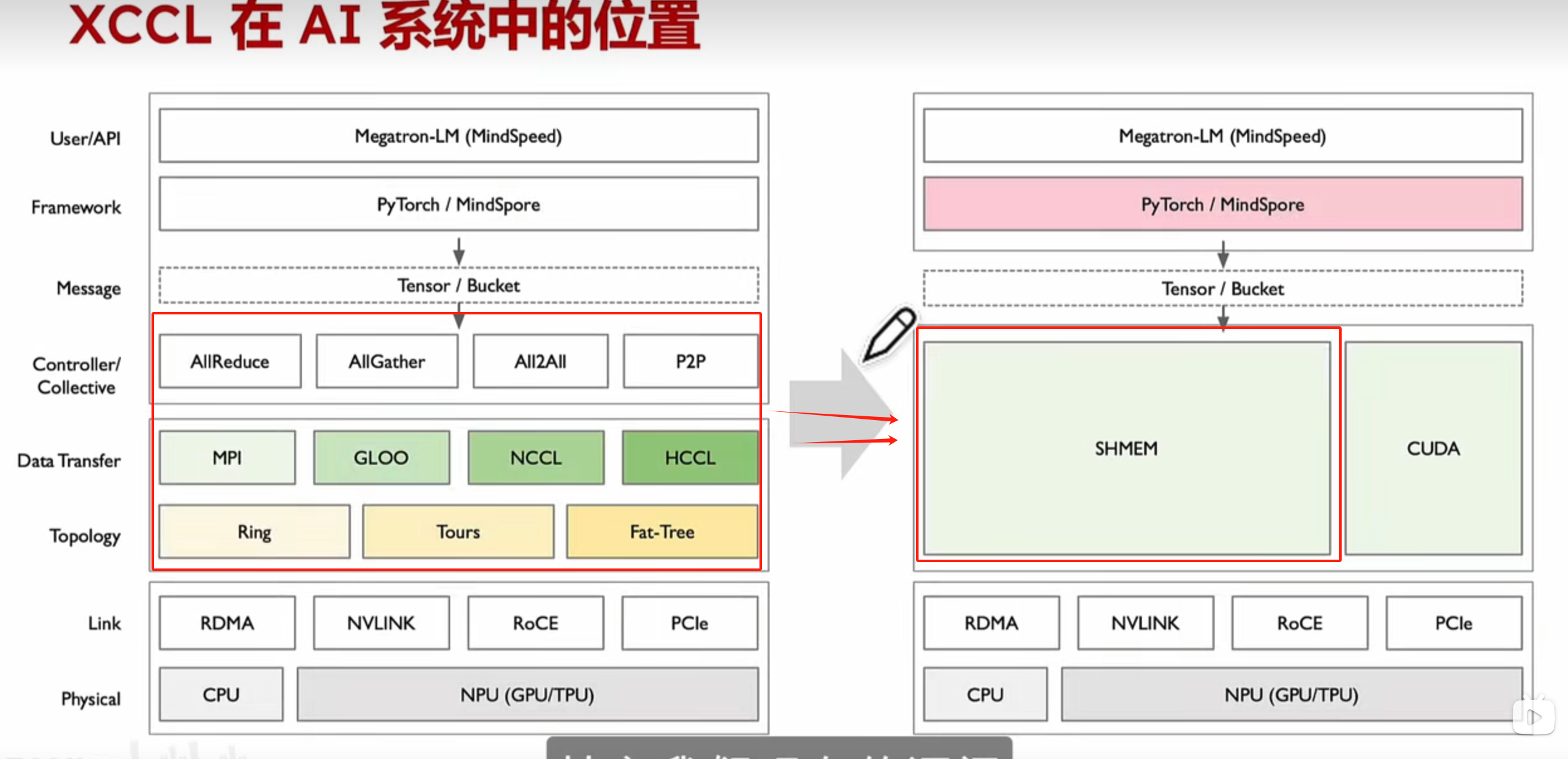

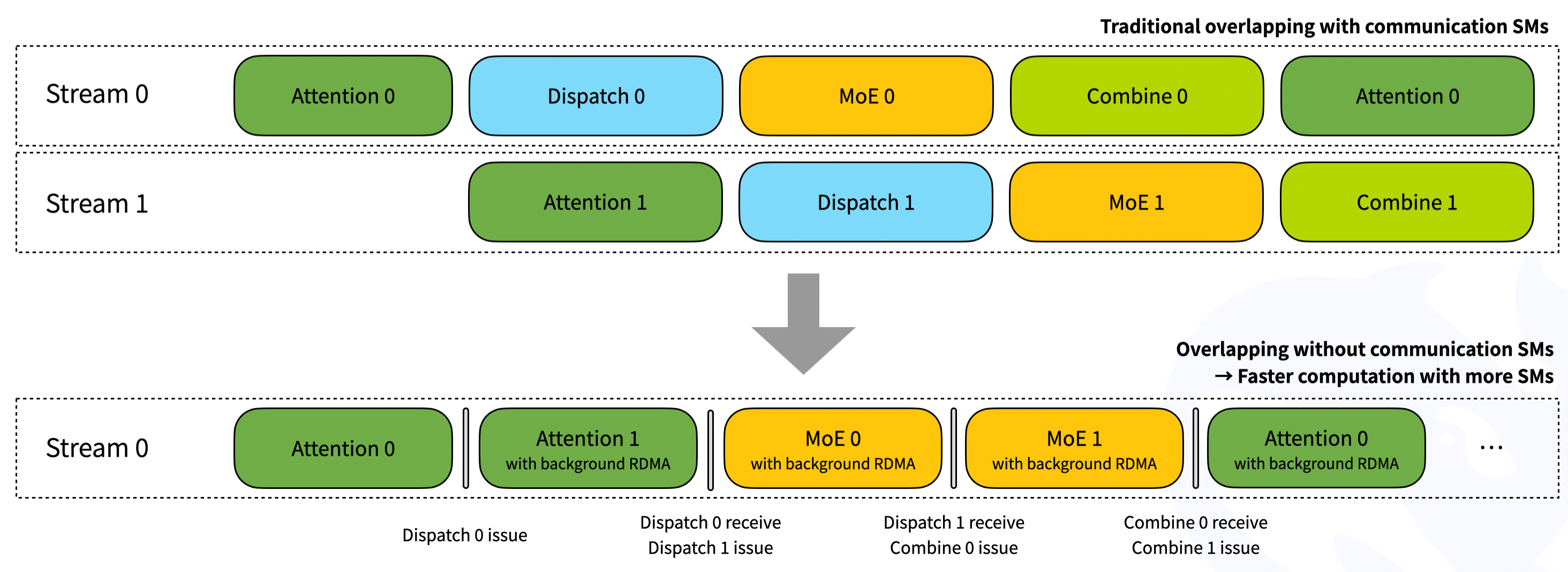

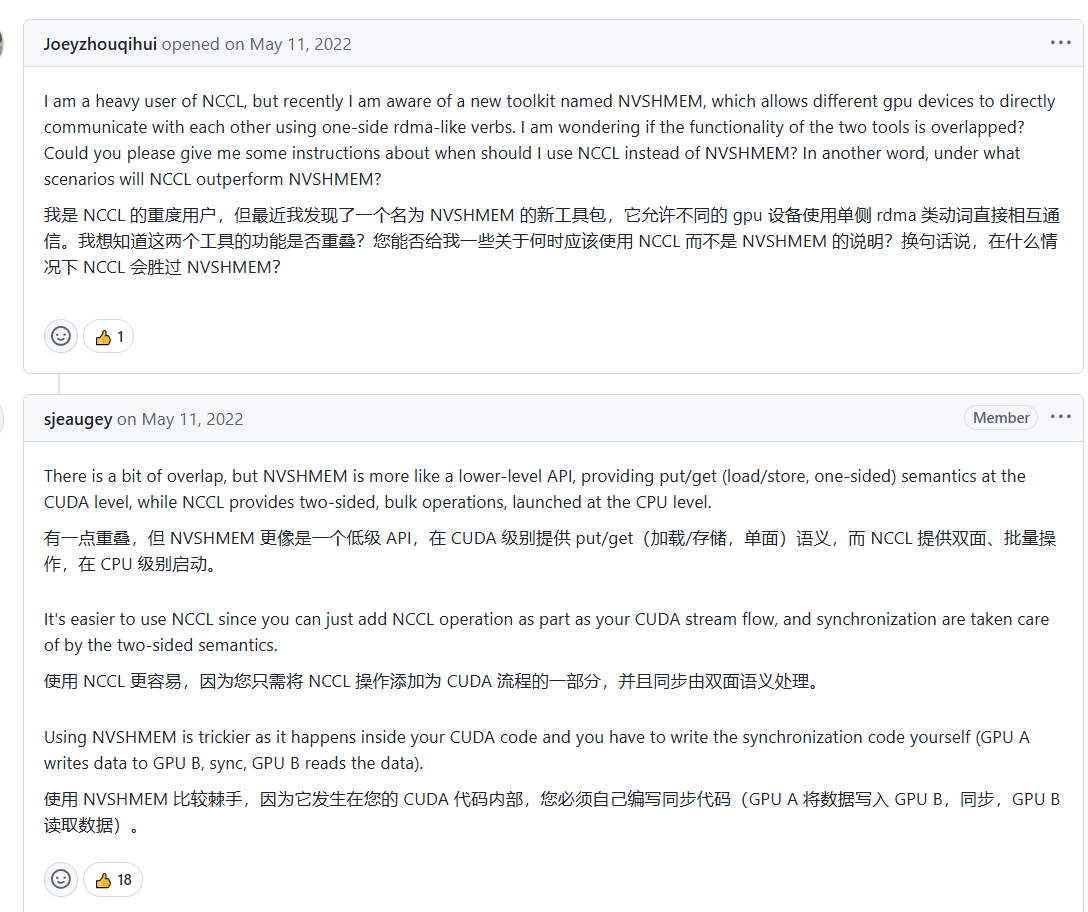

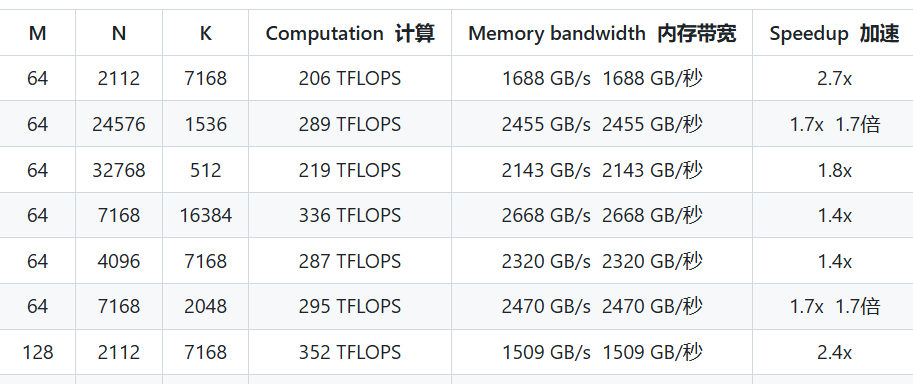

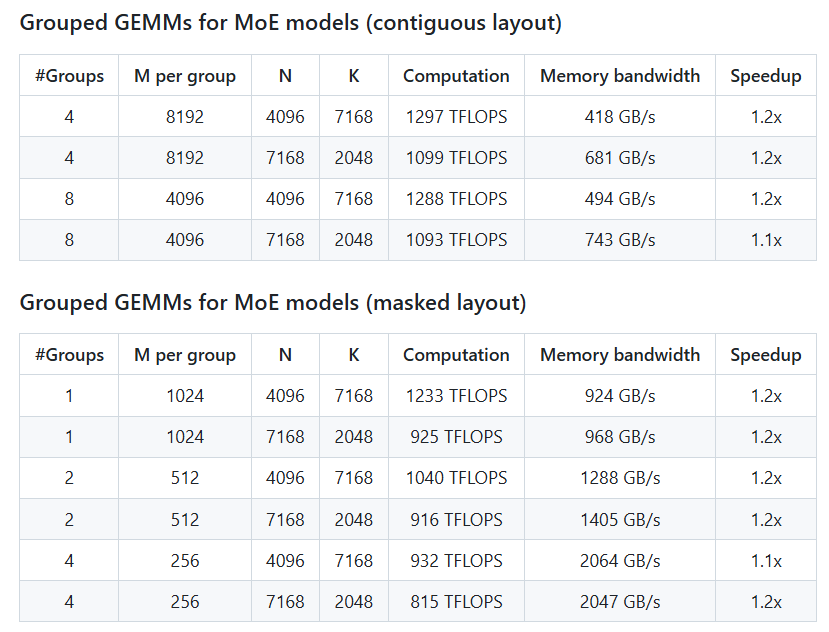

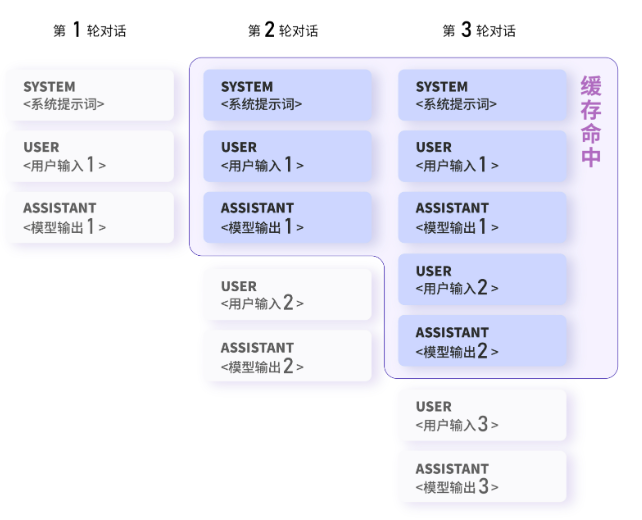

<blockquote><p>随着人工智能技术的飞速发展,大语言模型及相关应用正成为推动科技变革的核心力量。然而,背后支撑这些模型高效运行的基础设施(Infra)却鲜为人知。本文将深度解读DeepSeek开源周的内容,通过通俗易懂的语言,剖析DeepSeek在模型训练、推理优化以及基础设施建设方面的创新成果。</p> </blockquote>  本篇内容是对DeepSeek Infra开源周内容的一次费曼学习结果 阅读前最好能看过前置内容[《万字长文:DeepSeek 647天铸就的登神长阶》](https://whjlnspmd6.feishu.cn/wiki/Xo5WwnpmoiL6k2kD69wcz0b3nvd)。否则虽然也能看懂,但会无法建立全局视野,摄入的知识产生折扣。 阅读的时候可以先跳过每个章节的“术语说明”,看不懂了,再回去翻术语说明。不然没有上下文硬啃术语是挺难受的。 ## DAY1 FlashMLA 地址:https://github.com/deepseek-ai/FlashMLA,11.2K stars ### 术语说明 - MLA(Multi-Head Latent Attention),DeepSeek-V2中首次提出,用以取代他们在DeepSeek-67B中使用的GQA。是一种成本低,效果好的注意力算法。 - Flash,来自FlashAttention这个项目,Flash是闪光、快速,Attention是注意力。这是一个老牌的,专门优化注意力计算/内存效率的项目。 - FlashMLA,所以FlashMLA,就是DeepSeek开源的,借鉴了FlashAttention项目中的一些理念,然后专门针对他们自研MLA进行优化的CUDA内核。 - 所以,通俗来讲,MLA是MLA,FlashMLA是“如何更好在机器上跑MLA”的优化方法。 - SM(Streaming Multiprocessor,流式多处理器),这是GPU上的计算单元,H800上有132个SM。 - Wrap,是SM上线程调度的基本单位,你可以想象为流水线。所以GPU→SM→Wrap,DeepSeek很多精细化的工作是在Wrap层级上进行的。 ### 项目特点 **① Hopper专用** Hopper是英伟达的显卡系列名称,换成耳熟能详的就是H800、H100。 也就是说这个项目如果在其他卡上直接运行,例如华为昇腾、英伟达的A100,都是行不通的。至于为什么,下面会说。 **② 对KV缓存进行分块** 每块大小64。分块后,整个计算和内存的效率会得到相当大的提升。 这就像以前以订单为单位去做仓库管理,有的订单10000个货品,有的订单100个货品,这时候可能出现某个卡车1订单装不下或者1订单装不满的情况,利用率很低。 这个时候平台推动了改革,不再以订单为单位做管理,而是跟踪到每个SKU。那么这个时候你的管理颗粒度上升,虽然会带来更多管理成本,但整体的物流仓管效率也会因为细粒度而得到巨额提升。 不过这个不是DeepSeek的独特发明,而是来自FlashAttention的理念。 **③ 极致利用共享内存** 共享内存(Shared Memory)的访问速度很快,但容量很小,英伟达的Hopper系列,每个SM(GPU计算单元)上最大的共享内存为228K([数据来源英伟达官网](https://developer.nvidia.com/zh-cn/blog/nvidia-hopper-architecture-in-depth/))。 而DeepSeek在项目中将KV计算的中间结果都放在共享内存上了,每个SM单元下利用其中的224K([此数据来源知乎ling ye](https://zhuanlan.zhihu.com/p/26080342823)),从而实现了224/228=98.2%的利用率。 一方面,这极大利用了共享内存的高速特性,但也将这个项目牢牢限定在Hopper系列上,因为别的系列很难支持228K/SM的共享内存(例如A100仅有164KB)。 **④ Wrap级别的精雕细琢** 前面讲到DeepSeek将每个SM的共享内存利用得淋漓尽致,那么这里讲的就是他对每个SM计算、内存通信上的性能压榨。 DeepSeek将整个KV的计算分为两个Wrap Group,其中一个主要负责计算,一个主要负责加载内存,在64分块大小下,刚好每次完成一个分块的计算。 如下图所示,warp0负责Gemm1 这个矩阵的计算+Gemm2一半的计算。Wrap1则负责整个计算过程Q、K、V的内存加载搬运+Gemm2另一半的计算。 p.s,请记住Gemm这个概念,在两天后的第三个项目就会提到他。  **⑤ 动态输入序列的适配** 在实际的场景中,输入的序列是长度不一的,特别是R1类推理模型或阅读理解类任务,输入序列会很长。 在这个项目里DS采用了双线程缓冲的模式,会进行一个动态负载进行计算。如果短序列就采用计算优先模式,长序列就采用内存优先模式。([此部分细节需要要看代码,我的参考来自ZOMI酱的解说](https://www.bilibili.com/video/BV1P9PeezEkx/?vd_source=3cc2d19451098ce946dc21b953c43f51)) ### 总结 最终,在H800 SXM5这个卡上,FlashMLA实现了内存带宽3000GB/S(上限是3.2TB,利用率已经接近90%了),计算浮点数580 TFLOPS的表现 DeepSeek利用了KV分块+共享内容利用+精细化的Wrap设计把H800的性能压榨得一干二净。 ### 有趣的点 我翻了一下issue和fork,已经有人复现了基于A100的 FlashMLA出来了,我相信基于升腾、H20、V100等其他卡的应该也在路上。 项目最末有一堆社区支持,我看了一下,国内芯片很多都在,唯一一个海外的芯片厂商就是AMD了。 另外知名推理框架vLLM也已经完成对FlashMLA的集成支持。 这也是开源的优势所在,MLA一下子从DeepSeek独家的一个注意力机制,变为热门方案,社区涌现出的许多创意方案又能再次反哺到DeepSeek的研发推进当中。 ## DAY2 DeepEP 地址:https://github.com/deepseek-ai/DeepEP?tab=readme-ov-file,7.1Kstars ### 术语说明 EP(expert parallelism),专家并行性。大参数的Moe模型必须部署在多机多卡上。而训练或推理的时候,要把输入的Token分发给各个专家处理,处理完后要重新合并。可是分发和合并的专家们却分布在多个GPU上,这就是专家并行性。 全对全通信(ALL to ALL),全对全通信和点对点通信(P2P)是计算机通信里的两种概念。 如下图,某张卡的数据要发给4个专家处理,这4个专家又在四张卡上,这就需要黄色的这个“0卡”,与4张卡进行4次通讯。以此类推,1、2、3卡也要做这样的事情,这就产生了4X4=16次通讯。 点对点就简单了,0卡把数据发给1卡,结束。所以全对全通信的通信压力是非常大的。  但偏偏,全对全通信在大参数的Moe架构必定会发生,这是因为两点:① Moe架构的输入需要分发给多个专家处理,然后再从多个专家中回收结果合并输出;② 而大参数的Moe模型,必定需要部署在多机多卡上,所以专家们是分布在多个GPU上的,这就导致整个分发和合并的过程必定要跨GPU进行。 Dispatch&combine(分发和整合)。在DeepSeek V2中提到一个门控路由,可以对输入的序列进行处理,然后只分发给TOP-N个专家进行处理(在V3中是TOP-8),这个分发就是Dispatch。当专家们处理完后,再对结果进行回收,统一输出结果,这个整合过程就是combine。 NCCL(NVIDIA Collective Communications Library)& NVSHMEM。NCCL是英伟达开发的集合通信库,专门用于多节点和多GPU的通信。而NVschmen则把多节点的内存地址做了统一,可以将多个节点上的GPU内存视为一个虚拟的超大GPU,从而直接对多个不同节点的内存进行操作。这一段应该比较晦涩,可以放到后面的项目亮点中一起理解。[参考内容:英伟达NVschmen技术文档](https://developer.nvidia.com/nvshmem) NVlink&RDMA。NVlink是一台服务器内多个GPU的通信方式,H800的带宽名义双向400GB/s,DeepSeek实测单向160GB/s,其延迟是纳米级别的。而RDMA则是多个服务器之间的通信方式,带宽50GB/s,延迟为微米级别。 ### 项目特点 **① 放弃中台,完全贴合业务定制** 我们能够看得出来,这个项目是为了解决Moe模型在训练、推理过程中的全对全通信问题。而这个问题过去是通过NCCL或其他类似通信库来解决的。为什么DeepSeek非要自己用NVSHMEM自己手写呢? 如果我们将计算机通信比作物流(同样是搬运,区别只是搬运数据/商品),NCCL就像是淘宝、京东搭建的通用物流平台,已经能够便捷地帮你发货了。可是你现在创业了,做了一个去中心的跳蚤平台,每个人即是卖家,也是卖家,NCCL中的很多设计和封装对你来说都是冗余的。 偏偏你非常在乎这个通信效率,想压榨出最极致的性能。所以你选择NVshcmen,把每个用户的地址都统一映射为一个巨大无比的虚拟地址簿,然后在这个基础上进行完全贴合你业务的改写。 再用一个互联网中比较常见的概念——中台之殇。中台的原意是抽象通用业务,加快新业务的建立。但中台越维护,就越不好用,越发在业务竞争中陷入技术劣势。尤其在LLM这种耗资巨大的明星项目中,更是无法忍受一丝一毫的效益浪费。 更直观的概念可以看下面这张图(左边变成右边),整个系统中过去常用、完善的通信库,被DeepSeek用NVSHMEM直接重写,改成了完全适配自己Moe模型的通信(物流)方法了。  **② 训练&推理全兼容** 在训练中,输入序列通常固定且长,例如4096Token。在推理的预填充阶段,会一次性对所有输入Token进行并行计算(例如一次性把“你好,请帮我解释一下xxx”这几个字并行计算)。这两个场景中都会要求极大的吞吐量。 而在推理的解码阶段(即一字一字往外输出),则要求低延迟性,以保证用户体验。 为此这个项目中DeepSeek准备了两种CUDA内核方案。 第一种,通过NVlink(160GB/s)+RDMA网卡(50GB/s)结合进行,适配训练+推理预填充阶段的需求 第二种,则是纯粹RDMA网卡进行,适应推理解码阶段的低延迟需求(因为减少了NVlink到RDMA的转发)。 **③ 原生支持FP8数据分发** 随着DeepSeek的开源(包括论文和Github项目),FP8训练越来越成为业内的共识。 但这可能也是DeepSeek选择 NVSHMEM手搓通信的一个原因,因为NCCL 对FP8精度的支持不是那么 p.s 这条不保真,原文来自英伟达24年4月的一条技术博客——[“NVIDIA NCCL 仅支持高精度规约操作 (reduction),所以现在仍然需采用 FP16 进行 reduction,完成后再转化为 FP8。”](https://developer.nvidia.com/zh-cn/blog/nvidia-gpu-fp8-training-inference/) **④ 计算与通信重叠** 在旧的方案里,我们正常的顺序是: 获取注意力结果→分发给不同专家(通信)→专家们计算→将专家们结果合并(通信)→decode解码。 其中通信部分可以理解为数据传输,数据没到,流水线就得等,不能计算——流水线就跑不满,效率下降。 而在新的方案里,DeepSeek将同时计算两个批次的结果。所有通信的行为,都发生在计算中,从而消除流水线气泡。 如果用通俗例子说,可以用在厨房做两道菜来举例: 第一种是,我在厨房里进行备菜+炒菜,要完成番茄炒蛋+宫保鸡丁。我先完成番茄炒蛋的备菜,然后炒熟它,再进行宫保鸡丁的备菜,再炒熟它。 资本家看不下去了,于是提出第二种方案。我先做番茄炒蛋的备菜,然后炒它,在等它熟的时候,我就去做宫保鸡丁的备菜。等宫保鸡丁备菜好了,番茄炒蛋也熟了,就紧跟着把宫保鸡丁炒了。 当然Deepseek会更邪恶,他会把备菜(通信)和炒菜(计算)的时间对得刚刚好,让我一个时间单位就做完两道菜。 如下图所示,原本dispatch(分发)和combine(整合)都是通信,是要浪费整个流水线上用于计算的时间的,现在转换后,都隐藏到计算的背后去了。  ### 总结 DeepEP,说白了就是DeepSeek抛弃了传统的NCCL通信库,自己用更底层的NVSHMEM自己手搓了一套通信方法。 这套方法可能不如NCCL那么全面,但在独特的Moe大模型场景下,却是绝对效率最好的。 本章节参考文档: [英伟达NVschmen技术文档](https://developer.nvidia.com/nvshmem) [B站Zomi的解读,再次推荐这个博主](https://www.bilibili.com/video/BV1bN9PYeEak?vd_source=3cc2d19451098ce946dc21b953c43f51&spm_id_from=333.788.videopod.sections) ### 有趣的点 我在找NVSHMEN资料的时候,不小心看到下面这张图,来自2022年5月。两位GIT佬在交流NCCL和MVSHMEM的看法。这个对话或许有助于你理解两者的区别。截图来源:https://github.com/NVIDIA/nccl/issues/679  DeepSeek在项目中声明了一个“未定义的PTX用法”。PTX可以理解为CUDA再往下的一层语言,通常是CUDA/C++→PTX→SASS(机器码)。 所谓未定义即,英伟达官方文档中没有说可以这样用,但结果发现可以用,性能还提升了。 这下真的诠释了什么叫“你只是个做显卡的,你懂什么芯片”。 最后,这个DeepEP在DeepSeek-v3论文中提及过,原文是:“In order to ensure sufficient computational performance for DualPipe, we customize efficient cross-node all-to-all communication kernels (including dispatching and combining) to conserve the number of SMs dedicated to communication” ## DAY3 DeepGEMM 地址:https://github.com/deepseek-ai/DeepGEMM,4.9Kstars ### 术语说明 GEMM(General Matrix Multiplication,通用矩阵乘法)。是大模型训练推理中经常用到的一种计算方式,在门控路由(推荐TOP-N专家),注意力分数的计算,专家前馈网络,训练梯度的反向更新等等都会用到。 GEMM操作几乎占大模型推理计算量的70%以上。所以只要优化GEMM,就能将计算效率推高一截。 ### 项目特点 **① 削履适足** 事实上GEMM在过去有一个经典的库,即英伟达的[CUTLASS](https://github.com/nvidia/cutlass)。但和上个项目DeepEP一样,CUTLASS太过经典通用,在极致的业务适配上并没有达到极限。 在项目的说明中,他提及了大量相对于CUTLASS项目的改进,我们在下面展开。事实上DeepGEMM相对CUTLASS的性能改进,正是这些细细碎碎的改进叠加起来的。 **② JIT设计** 传统的编译方式,最终执行的代码是固定的。而JIT则是边运作边生成代码。 在这个生成过程中,他可以根据情况选择更好的内存分配、减少条件判断等等,他的代码性能会比传统方式更好。 **③ 支持非2次方的块** SM通常只支持2的幂次方块大小,例如256,128等。但这回答导致工作效率拉不满(经典的DeepSeek资本家邪恶风格)。 DeepGEMM通过支持非2幂次的块大小来优化特定形状的效率。 例如传统128分块,在M=256,N=7168(M可以近似理解为输入序列长度,N是FNN的维度)时,(256 / 128) * (7168 / 128) = 112个块。但H800中有132个SM(计算单元),只分到112个块,利用率就太小了(112/132=84%)。 而如果采用112分块,同样情况下,则(256 / 128) * (7168 / 112) = 128个分块结果,利用率为128/132=96%。 **④ 针对最底层的SASS机器码动刀** 还记得我们前面说到的,CUDA/C++>PTX>SASS(机器码)吗? 在V3/R1论文中,DeepSeek动了PTX,就被人惊呼绕过了CUDA,英伟达已死(全是bullshit言论)。而在这里他们干脆对最底层的SASS二进制编码动刀了。 他们的发现过程很有意思,先是注意到NVCC 在12.2和12.3之间,传统GEMM项目 CUTLASS FP8的内核提升了。 啊?这是为什么呢?他们进一步比对了最底层的SASS二级制编码,发现FADD这个指令中会发生周期性交错反转。进一步调研后,怀疑这个指令通过控制warp线程的释放提高了效率。 于是他们借鉴这个思路,干脆开发了一个二进制的脚本来控制另一个指令FFMA,让他也能实现类似的效果。最后发现某些情况能够提升10%以上的性能! 说实在的,这段话,我只能理解一个大概。但是什么FADD、FFMA指令,什么yield位,reuse位是真的不懂,我打算学习Infra,但真没想过我要学到二进制机器码这个地步。 但透过这个记录,我好像看到一个得意的研究员,美滋滋地敲下这段GITHUB说明。 这个世界真正的光芒,总是闪耀在细微之地啊,干杯! ### 总结 针对大模型训练推理中占据计算资源最多的GEMM操作,DeepSeek仍然自己做了更底层(甚至到机器码)的实现以追逐最极致的性能 他们在不同尺寸的矩阵中做了测试,这也是网上很多媒体所说“2.7倍提升”的由来。 但实际上,在Dense(稠密)模型上是1.0倍~2.7倍,其中2.7倍只是极特别的一个场景。 看这个M,N,K的数据,大概是一个低输入长度,低参数的模型。例如向deepseek-7B提问:”你好呀”。(此条举例可能有错,欢迎指出)  事实上我更关心他在Moe结构上的效果 结合下图来看,在连续布局(预填充)和掩码布局下基本上都有1.1X的提升,这已经非常了不起了! 这就类似突然有人和你说全中国的电力成本,能再下降10个百分点…那我马上把全屋空调开起来!(广东开始进入夏天了T T)  ### 有趣的点 这个GEMM库虽然了不起,但需要特别注意的是:他并不支持训练环节,因为训练环节不仅需要GEMM,还需要其他的融合内核,而他们希望这个库干净整洁,所以仅仅发布了面向推理的GEMM内核。 但——DeepSeek内 部正在讨论是否发布可用于预训练的相关内核。([相关信源](https://github.com/deepseek-ai/DeepGEMM/issues/10)) ## DAY4 DualPipe&EPLB https://github.com/deepseek-ai/DualPipe , 2.6K stars https://github.com/deepseek-ai/eplb 1.1Kstars ### DualPipe DualPipe,双向流水线。区别于单线流水线。在DeepSeek-V3中有一个专门的篇幅提及这个方法。 事实上Dualpipe并非DeepSeek首创,根据知乎[Fazzie](https://www.zhihu.com/people/fazzie)在文章中的说法,其最早可以追溯到 21年[SC奇美拉](https://zhida.zhihu.com/search?content_id=252530476&content_type=Article&match_order=1&q=SC%E5%A5%87%E7%BE%8E%E6%8B%89&zhida_source=entity) [Chimera: Efficiently Training Large-Scale Neural Networks with Bidirectional Pipelines](https://link.zhihu.com/?target=https%3A//arxiv.org/abs/2107.06925) 这篇文章。 但为什么直到今天才由DeepSeek重新提出并发扬光大呢? ① 在过去,双向流水线,意味着显存要加载双份模型的参数,这个成本太高了,显存X2。 ② 但是现如今大参数的MOE模型,其模型专家是稀疏的,并且可以通过加大专家并行规模来进一步缓解显存消耗(即每个GPU放更少专家,增加集群的规模)。这就导致在今天特别针对大参数量的MOE模型时,其显存成本并非2倍,而只是1倍多 具体数据我没找到,DeepSeek-V3论文中的原文是:”尽管DualPipe要求保留模型参数的两个副本,但由于我们在训练期间使用了较大的EP大小,因此这并没有显著增加内存消耗” ③ 如果仅仅是显存开支不大,也不是决定性因素。更重要的是Moe架构需要进行的全对全通信(前面DeepEP项目中提到)。这个全对全通信恰好可以让模型训练在进行后向传播(更新权重)时,把另一个Moe的全对全通信(Dispatch或者combine)给做了,从而实现近乎1:1的计算-通信全覆盖。  [本部分参考内容来自知乎Fazzie](https://zhuanlan.zhihu.com/p/17542710424) 但是Dualpipe注定只能成为大玩家的工具。 ① 只有在训练期间,才需要做backward(后向传播),才能有空余精力去做全对全通信,从而实现计算-通信全覆盖。 ② 只有大参数、MOE架构的模型,才配得上用这个方法,所有单机/少量卡能训的模型,非MOE架构的模型,都不适用。 所以这个项目的issue只有可怜的三个,实在是受众太少了。 ### EPLB EPLB(Expert Parallelism Load Balancer),专家并行负载均衡器。这个内容也在V3论文中有提及。 大概原理是:在多级多卡条件下,每个GPU会托管不同的MOE专家,但可能有一些专家总是被访问(例如deepseek Moe方案中独特的共享专家)。 于是Deepseek就给这些劳累的专家做一下克隆,准备多一个备份放到同个机器上备用,称之为冗余专家。 在预填充阶段,他们会将专家平均分配到每个机器上(一个服务器8张GPU)。然后将复制的冗余专家平均分配给每个GPU。以V3为例,最后每个GPU托管8个专家+1个冗余专家。 在解码阶段,由于内存的高要求,部署的最小单元从32个GPU,变为320个GPU,从而每个GPU只托管一个专家,其中64个GPU托管冗余专家和共享专家。 其实这个项目我不是很感兴趣,有点乏味了。唯一有趣的点在于,在V3论文中,他们提及正在尝试动态冗余专家方案,例如每个GPU托管16个专家,但只激活9个。 如果这个尝试能够成功,成本应该会进一步下降。 ### 总结 专用于大参数、Moe架构的训练流水线设计,能够显著减少大型玩家的训练成本,但对于小玩家训练成本或推理成本而言没有帮助。 ## DAY5 3FS文件系统 地址:https://github.com/deepseek-ai/3FS,7.8Kstars ### 术语 Fire-Flyer File System (3FS) 这是一个专用于大模型场景的分布式文件系统,我们先拿U盘举例子,搞明白文件系统是什么。 我之前买过一个1T的固态硬盘,结果发现插到MAC上识别不了。百度一下才发现原来U盘用的是Windows特有的NTFS格式,而MAC只支持FAT32等,就是不支持NTFS。这里的NTFS,FAT32就是文件系统对应的文件格式。 每个文件系统都有自己进行读、写操作的方法,不同的平台也会有不同的文件系统。 而比起我们日常用电脑的场景,现代大数据会有进一步的奇葩的要求:要求极大吞吐,例如PB级别的内容,要求高频操作,例如1S内读写10000次。所以就产生了如HDFS, Lustre这种针对分布式场景的文件系统。 而DeepSeek的3FS,是对如HDFS这类分布式文件系统的再升级,专门定制以用于大模型训练推理。 DRAM、VRAM、SSD DRAM就是CPU的内存,VRAM是显卡的内存,SSD可以理解为硬盘 这三者的价格,我给一个不精准的数字: ① VRAM: 4090显卡 24G 18000元,H100显卡 80G 25万元; ② DRAM: 32G DRAM,320元 ③ SSD: 1T 300元 很显然,显存最贵,内存其次,SSD(硬盘)便宜如土。 ### 项目特点 **① 有助于预训练的一些改进** DeepSeek实测在180节点集群中吞吐6.6TiB/s,25节点集群中吞吐3.66TiB/min。我不了解传统分布式文件系统如HDFS在同等规模节点的性能表现如何(因为DeepSeek没做对比,我也找不到资料)。 但从社区的反馈来看,这个结果非常棒,甚至认为建立了大模型训练文件系统的新标准。 **② 我更感兴趣的是推理成本的改进!** 我们先了解一个概念叫KVCache。例如你进行了一个20轮的上下文对话,或者有很多人预置了Prompt模板 那么这部分输入是可以重复利用的,只需要把他先存起来,就可以节约每次重复计算的成本。大概的示例可以看下面这张图  在过去,这部分KV缓存一般会放在内存或显存中,而DeepSeek通过几个方法的结合将他放到了SSD。 Deepseek依靠的方法: ① 基于MLA注意力机制,可以将KV缓存压缩为低秩数据,从而降低93.3%的内存占用(来自DeepSeek-V2论文数据) ② 而收益于MLA带来的内存空间减少,使得KV缓存可以利用本项目的3FS实现在SSD上的高速读取,吞吐速度为50GB/s 在3月1日DeepSeek公布的推理成本说明中,实际上服务部署运行中KV缓存的命中率为56.3%。也就是有将近一半的KV缓存成本,可以实现90%+的降本。 ### 总结 3FS是一个专门针对大语言模型模型训练&推理所开发的文件系统。其性能提升有助于训练提速 但基于3FS+KVCache所带来的推理成本降低对我来说更有趣。 ### 有趣的点 网友查看开源的3FS文件,发现他最早的开发时间是2014年5月。  但是…2014年幻方还没成立呢。 按照网上检索的信息,2008年到2014年间,梁文锋通过自己的量化算法,实现亿万身家。2015年幻方才成立,2016年幻方才上线第一个完全基于深度学习的量化模型。2019年幻方的深度学习平台萤火一号才上线。 所以,这行14年的代码不会是梁文锋亲自写的吧? 我又找出来一篇我漏掉的DeepSeek论文,关于3FS的,论文标题为:[Fire-Flyer AI-HPC: A Cost-Effective Software-Hardware Co-Design for Deep Learning](https://arxiv.org/abs/2408.14158),其中梁文锋真的在作者清单里。  2014年5月,我的朋友们,你们在做什么呢? 我当时应该在大学宿舍里打英雄联盟。 这个事情的玄幻程度就像1644年崇祯上吊,而同时期英国爆发了资产阶级革命(摊手.jpg)。 ## 3月1日 Deep推理成本公布 地址:https://zhuanlan.zhihu.com/p/27181462601(官方中文版!五星好评) 这篇内容我就不解读了,是前述多个项目的整合说明版本,对大模型推理成本感兴趣的可以自己去看一下。 重点说说很多媒体无脑转发的成本收益率545%,其实是存在一些偏差的(DeepSeek自己也有说明): ① 整个计算混合了V3和R1两个模型,而V3价格比R1价格要低,但最终按R1计算收入,所以偏高。 ② 把免费服务和降价的夜间服务都按满额费用计算了,所以也偏高了。 作者:马丁的面包屑 公众号:马丁的面包屑 本文由@马丁的面包屑 原创发布于人人都是产品经理,未经许可,禁止转载。 题图来自 Unsplash,基于 CC0 协议 该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

US Commerce Secretary Howard Lutnick said Trump was "totally annoyed" by the EU's retaliatory actions announced Wednesday, leading to the latest threat,

昆尼皮亚克大学的一项新民意调查发现,超过一半的美国选民认为埃隆·马斯克和他的政府效率部(DOGE)正在伤害这个国家。调查显示,54%的人认为,马斯克和DOGE的工作正在对美国造成损害。相比之下,40%的人认为马斯克和他团队的工作有助于美国的利益。60%的选民不赞成马斯克和DOGE处理联邦员工的方式,36%的选民赞成。  周四公布的这项民意调查显示,美国人对DOGE主导的联邦机构改革感到不安,选民们正在努力应对现实世界的后果,包括数十万联邦雇员可能面临裁员,国家公园的公共服务减少或关闭。 调查发现,选民的观点在很大程度上因党派分歧而分裂。82%的共和党人认为马斯克和DOGE正在改善这个国家的状况,而94%的民主党人认为他们让这个国家变得更糟。共和党人在马斯克和DOGE对联邦劳动力的处理上存在轻微分歧;77%的人赞成,16%的人反对。在民主党人中,96%的人批评该部门的工作是在掏空劳动力,只有2%的人表示赞同。 昆尼皮亚克大学的民调发现,选民们也在表达对特朗普的不满。大约55%的选民不赞成特朗普对联邦劳动力的处理方式,而40%的选民赞成。这些发现也存在党派分歧;82%的共和党人赞成特朗普对待联邦劳动力的方式,13%的人不赞成,94%的民主党人不赞成,2%的人赞成。 该调查于3月6日至3月10日进行,现场采访人员通过固定电话和手机对全美1198名自认为登记的选民进行了随机抽样调查,误差幅度为正负2.8个百分点。 [查看评论](https://m.cnbeta.com.tw/comment/1485342.htm)

据汽车新闻网站Electrek报道,特斯拉交付专员称,Cybertruck的交付已经暂停。由于许多车主报告称Cybertruck存在装饰件脱落问题,该车目前处于暂停交付状态。目前,许多特斯拉Cybertruck买家在论坛和社交媒体上反映,他们的交付被推迟了。有8位等待交付的Cybertruck买家在Cybertruck车主俱乐部论坛上称,交付延期。还有更多人在X和脸书上披露了这一问题。  Cybertruck顶部装饰件出现脱落问题 大多数Cybertruck买家被特斯拉交付专员告知,所有Cybertruck的交付都处于“质量控制性暂停”(containment hold)状态。质量控制性暂停交付通常发生在汽车制造商发现新生产的车辆存在问题时,他们希望暂停交付以解决问题,从而避免在客户手中召回车辆。  问题出在这里 在Cybertruck暂停交付事件中,大多数买家并不知道汽车存在质量问题。然而,一位买家分享了一张来自特斯拉服务应用的截图。一位特斯拉工作人员表示,问题是源自Cybertruck的“车顶装饰件”。车顶装饰件是指覆盖车辆车顶边缘的装饰条。 尽管特斯拉声称Cybertruck是“防弹”的,并且采用了“外骨骼结构”,但这款电动汽车的构造实际上更接近传统的承载式车身(Unibody)。大多数可见的车身部件实际上是附加在车身上的装饰件。  前面板据称用胶水固定 在某些情况下,这些装饰件非常脆弱。Electrek此前就曾报道过,特斯拉因一些装饰件在行驶过程中脱落,召回了1.1万辆Cybertruck。那次召回发生在去年6月,但看起来这个问题可能再次出现。 最近,关于Cybertruck前部面板仅通过胶水固定的图片在社交媒体上流传。 [查看评论](https://m.cnbeta.com.tw/comment/1485340.htm)

华尔街兴奋了!新CEO即将上任、晶圆厂有望被接手,英特尔股价隔夜大涨。周四,英特尔股价逆市大涨近15%,收于23.7美元,在标普500指数成分股中领涨;台积电则下跌逾3%。 [](https://static.cnbetacdn.com/article/2025/0313/135741753a187ef.webp) 英特尔股价反弹主要受两大利好消息驱动:一是新CEO即将上任,二是台积电计划牵头成立合资企业接手运营英特尔的代工业务。据分析,台积电股价下跌可能是因为市场担忧合资企业成立后、英特尔不完全退出代工业务,进而给台积电的利益带来损害。  据媒体报道,英特尔股价的强劲反弹主要受两大利好消息驱动:一是英特尔任命半导体软件公司Cadence前CEO陈立武为新任CEO,二是台积电可能与多家芯片巨头组建合资企业,运营英特尔晶圆厂。 台积电股价下跌,据分析,则可能是因为市场担忧合资企业成立后、英特尔不完全退出代工业务,进而给台积电的利益带来损害。 **新CEO带来转机?华尔街普遍看好** 据报道,半导体软件公司Cadence Design Systems的前CEO陈立武(Lip-Bu Tan)将加盟英特尔担任CEO,该消息引发市场普遍乐观情绪。 美银表示,陈立武拥有“成功的坚实业绩记录”,且Cadence曾与英特尔有过合作,“我们相信在他的领导下,英特尔有更大机会重组并扭转局面”。 德银分析师也持类似观点,称对陈立武的任命是英特尔的“理想结果”,并强调了他在“半导体生态系统中的丰富专业知识”。 公开信息显示,陈立武在28岁时创立了Walden International投资公司,50岁转型成为Cadence Design System的CEO。不过,他的主要经验集中在投资领域和EDA软件行业,而非半导体制造。 有消息称,陈立武此前在担任英特尔董事期间就曾支持将制造业务分拆。还有内部人士向媒体透露,陈立武对英特尔的冗员问题极为不满。 有传闻称,在一次与三位英特尔副总裁的闲聊中,当被问及如果担任CEO会如何管理时,他直言:“我会解雇你们三个中的两位。” 尽管股价录得大幅反弹,英特尔的市值在过去12个月中仍蒸发了近一半,显示公司面临的挑战依然严峻。 **台积电组团救英特尔:关键转折还是理想主义?** 据路透社援引知情人士消息,台积电正接触包括英伟达、AMD、博通和高通等在内的芯片企业,计划组建合资企业运营英特尔的晶圆厂,台积电将持有合资企业50%的股份。 值得注意的是,该计划得到了特朗普政府的支持,因为美国政府寻求让台积电参与拯救英特尔的活动,这意味着任何最终安排都需要获得美国监管部门的批准。 美银分析师认为,这样的安排“可能有助于英特尔在新任CEO领导下的潜在转型努力”。 信息平权分析指出,若此消息属实,将有两种可能的合作形式: 一是英特尔完全退出制造业务。这将对英特尔极为有利(预计2026-2027年可实现60-80亿美元盈利),长期来说对台积电也有利,但对半导体设备厂商可能是利空,因为台积电的设备采购量可能会大幅减少。 二是英特尔与台积电及其他公司成立合资代工厂。这一模式面临严重的利益冲突,如果台积电倾尽全力帮助合资公司成功,最终可能创造出自己的强大竞争对手;如果台积电消极运营合资公司,又难以满足美国政府的期望。 **晶圆代工业务:英特尔的痛点** 英特尔的晶圆代工业务一直难以与台积电和三星匹敌。 过去,英特尔采用成本加成定价模式,在PC市场近乎垄断的地位让这种策略行之有效。然而,随着AMD与台积电的合作日益紧密,从7nm时代开始性能逐渐超越英特尔,后者的优势开始逐渐瓦解。 信息平权认为,英特尔在14纳米工艺上“挤牙膏”式的停滞不前,导致其在技术竞争中逐渐落后——如果英特尔坚持“设计+自有制造”的模式与“AMD设计+台积电制造”竞争,凭借品牌溢价可能不会完全失败,但要在代工领域与台积电竞争则几乎不可能成功。 英特尔的晶圆厂资产估值约为1080亿美元,但在2024年录得188亿美元的财务亏损,成为1986年以来的首次亏损。尽管收到多次收购请求,英特尔一直抵制将设计部门与晶圆厂业务分离的提议。 目前,英特尔的财务状况十分令人担忧。公司每年经营现金流约100亿美元,而近年资本支出高达240-250亿美元。到2024年底,账面现金预计仅剩8亿美元。即使将资本支出降至200亿美元,每年仍有约100亿美元的资金缺口。 分析指出,根据18A工艺的进度和良率预期,英特尔的盈利状况可能要到2026年后才能显著改善。这意味着公司今年可能需要筹集150-200亿美元资金才能维持到2027年,而目前其市值仅为890亿美元。 据报道,部分英特尔董事会成员已对合资企业表示支持,但仍有一些高管持反对意见。考虑到英特尔与台积电使用不同的生产工艺、化学品和工具配置,技术整合也将成为一大重大挑战,可能给双方的合作带来阻碍。 [查看评论](https://m.cnbeta.com.tw/comment/1485338.htm)

据彭博社报道,美国社会保障局(SSA)近日迎来了一支由10名成员组成的特别调查团队,他们由埃隆·马斯克领导的政府效率部(DOGE)派遣,旨在调查社会保障体系中可能存在的“亡者领社保”现象。马斯克此前声称,美国社保体系可能存在高达数千万已故之人仍在领取公共福利的情况,并称其为“史上最大庞氏骗局”。  根据最新提交给联邦法院的声明,DOGE团队已在社保局内部展开工作。这支团队包括四名政府特别雇员和六名从其他部门借调的DOGE工作人员。他们的主要任务是调查社保局内部可能存在的浪费、欺诈和滥用行为。 进驻工作人员的主要职责是检查社保福利支付的合规性。特别是,七名DOGE团队成员被授权访问美国社会保障号持有者以及名为Numident的数据库,以便查找潜在的欺诈行为。这个数据库记录了数百万人的社会保障号,但有时也缺失死亡日期。马斯克曾引用这一点,指出仍有超过2000万100岁以上的“高龄”人士正在领取社保。 但批评人士表示,马斯克此举可能会加剧对社保计划的削减压力,并担心他团队的调查可能会导致敏感个人数据的滥用。反对者也指出,尽管社保局的数据显示,2015至2022年间的不当支付金额接近720亿美元,但这些资金并非完全因欺诈导致,绝大部分金额已经追回。 马斯克的言论和措施引发了社保局内部的一些紧张反应。社保局的反欺诈专家Leland Dudek对此表示,Numident数据库中缺失死亡日期并不意味着社保支付依然持续,这些支付数据是由另一个数据库“主受益人记录”管理的。社保局表示,正在积极纠正与死亡日期缺失相关的不一致问题。 此外,社保局内的“死亡数据”也得到了特别关注。除了Numident,社保局还保存着一份包含9400多万份死亡报告的主死亡档案。杜德克指出,死亡数据的补充和修正是社保局的优先工作之一,确保合规支付是其核心任务。 DOGE团队的调查范围不仅限于社保局。两名团队成员已被授权访问国家新雇员名录,该数据库由卫生与公众服务部管理,用于执行儿童抚养命令。此外,一名DOGE成员即将被派往小企业管理局,进一步扩大调查范围。 [查看评论](https://m.cnbeta.com.tw/comment/1485336.htm)

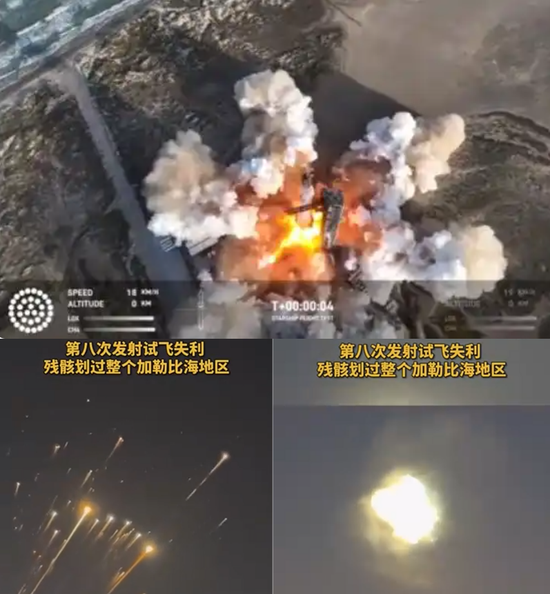

很显然,不是电车出了问题,不是卫星出了问题,而是它们的老板马斯克,出了问题;不是火星移民出了问题,不是脑机接口出了问题,而是人性的灵魂深处,出了问题。“确实非常困难……唉……”这个面对电视镜头欲言又止难掩沮丧的人,是一位当下全球瞩目的传奇人物。你一定会想到正在美俄夹击中苦苦支撑的泽连斯基,对吗?可惜不对。这个人是近年春风得意的“世界首富”:埃隆·马斯克。 **急转直下!** 是的,这位“科技狂人”、当代创新企业家中的首席“钢铁侠”,摊上大事了。 截止到3月13日,特斯拉的股价为235美元(摩根大通预期股价甚至下调为120美元!)。2月10日,更只有220美元。而才3个月前,特斯拉的股价却高达479美元。一个季度,横遭腰斩,堪称雪崩。而期间其市值蒸发竟高达8000亿美元=波兰一年的GDP=整个欧盟的防务重建军费!  是有人在资本市场恶意做空特斯拉吗?我们熟悉的阴谋论剧本总是这样的。然而,并非如此——除非,是全世界联手做空。因为雪崩的,远不止资本市场。 特斯拉近期在欧洲的销量下跌了60%,其中在德国的销量更暴跌了70%。在澳大利亚甚至下跌了85%。在美国本土也下跌了50%。而且很多马斯克的同胞,聚集在特斯拉门店前大肆涂抹抗议,很多特斯拉车主也开始紧急抛售。 如果你以为是全球用户和投资人,在对特斯拉的FSD自动驾驶系统表示不满,就不会有如下信息了: 意大利政府正在计划取消高达15亿欧元的星链服务订单,而意大利是公认对马斯克的“东家”特朗普很友好的少数欧洲国家。其他欧洲国家自然纷纷跟进。波兰外长甚至围绕每年5000万美元的星链服务公开怒怼马斯克,不惜声言另寻它家。不排除如下场景在未来几年出现:三四万颗星链卫星,在天上像无业游民一样四处闲逛,因为无事可做。  3月6日,马斯克的Space X星舰第八次发射,彻底失败。而刚刚,马斯克的X社交平台也遭遇大规模攻击,一度瘫痪。  “钢铁侠”开始颤抖。 而当年慧眼投资特斯拉的中国投资人段永平,在清仓赚了一大笔钱后反而说:在接触过马斯克本尊后,意识到这次投资是一次“很帅的错误”。 很显然,不是电车出了问题,不是卫星出了问题,而是它们的老板马斯克,出了问题;不是火星移民出了问题,不是脑机接口出了问题,而是人性的灵魂深处,出了问题。 我的判断是:我们已经永远地失去了那个“马斯克”。他还活着,但他已完了!——哪怕特斯拉股价再反弹。  **不可理喻!** 我凭什么这么说?因为马斯克的“死”,并不只是,甚至并不是在资本市场或产品市场的一时坠落,而是其心智世界的就此堕落。 从全球对马斯克的态度有多急转直下,就可以想象马斯克最近的言行有多不可理喻。 当年,他反对特朗普,他支持乌克兰,他曾留下对普京掷地有声的那句硬刚:“你把你的核弹发出来试试?我的星链可以让你发出的礼物返回到莫斯科。”那时的马斯克,作为一位钢铁侠,是何等荡气回肠。随后,他的火箭能像根香肠一样稳稳地回到地面上的一双“筷子”里。那时的马斯克,作为一个创新家,又何等不可思议。 然而,以“筷子”为转折点,在全球掌声、尖叫声中被认为“无所不能”的马斯克,却“全面”转向了完全相反的“不可思议”……且大概率就此万劫不复。 因为他,一个高科技企业家,扭头冲进了政治。 他转而肉麻谄媚特朗普,他公然撒钱为其贿选,他突然厌恶泽连斯基,他悍然中断星链“捅刀”,他居然干预德国大选,他竟然怂恿解散北约,他公开羞辱欧洲官员,他在线大骂本国议员,他亲自担纲政府裁员“刀斧手”,他在白宫当面讥讽国务卿……直到股价腰斩,销量暴跌,订单湮灭,人设崩塌,火箭解体……然后,才一声叹息。  正摇头叹息的,远不只是马斯克自己。更有我和我们所有人。为他,亦为企业家。 **都梦“大总统”?** 马斯克的迅速“黑化”,未必一定是他在中年时的“是非标准”忽然出现了“颠覆”,而是他的“人生目标”忽然发生了“异化”。他的智商始终在线,但他的灵魂已然出窍。 这让我的脑海里迅速明晰了一个冒冷汗的推论——企业家,和科学家,都不必然,甚至都很不适合去担纲政治家。 因为伟大的企业家多关心至高的“效率”(利),伟大的科学家更关心至高的“自己”(名)。而伟大的政治家需要关心的,却是整体的“平衡”(安),与社会的“成本”(福)。其底层逻辑是大不一样的。倘若简单跨界而直接套用,难免刻舟求剑,水土不服,甚至适得其反。因此,能成为伟大的企业家和伟大的科学家的人,却未必甚至几乎很难成为一位伟大的政治家。抑或者向深层次解析:一位本分的伟大企业家和伟大科学家,其难免“不伟大”的地方,对社会危害不大。而其一旦还要染指政治,其“不伟大”之处,就很可能会酿成很多人的灾难。 比如当下。  据我观察,如果说“老板”特朗普一直很“狂妄”,如果说“副手”万斯素来都“浅薄”,那么如今的“部长”马斯克,则可以说已近乎“阴险”。 如果我没有猜错,不管马斯克是不是像他最近委屈透露的眼前“刀斧手”这脏活儿“只干一年”,他都一定会用科技力量,在两年后的美国中期选举中“成全”共和党依旧掌控国会;进而他一定会用科技力量,在四年后通过民主程序“成全”特朗普能“有机会”连任;进而再四年,依然年富力强的他一定会用科技力量,通过民主程序“成全”自己“有资格”成为椭圆形办公室的新主人。正所谓十年磨一剑。 一言蔽之,马斯克现在的疯狂和谄媚,都是为了未来的野心和征服。 再一言蔽之,马斯克在介入政治后,一定忽然发现了一个远比“闯荡”火星更让他心神抓狂的目标:留在地球,掌握至高无上的“权力”。 俗透了! **都是“大俗人”!** 是啊,“牛人”、“狂人”、“超人”,也仍然难逃是个“大俗人”。 可如果我们了解“牛人”如牛顿,如爱迪生,这些天花板极的天才,也在前半生为人类文明进步屡创辉煌巅峰之后,在暮年调头陨落成为“大俗人”而晚节不保后——再预判马斯克的坠落尘埃,也就不足为奇了。  牛顿牛吧?人类第一科学家,无出其右。但发现了三大力学定律,一举奠定了近代数学、物理学和天文学的这位大神,晚年也居然会和马斯克一样热衷介入政治,并陷入疯癫。“科学家”牛顿,到死担任了31年掌控国家金融命脉的英国皇家铸币厂厂长,还随后到死担任了24年掌控国家科学殿堂的英国皇家学会会长。是的,到死他都不肯卸任——即便是他晚年已经鬼迷心窍于神学研究时。 而更重要的,是牛顿厂/会长的从政风格及业绩如何?这样说吧,他执掌皇家铸币厂,认定市面上有20%的假币在流通,和马斯克“部长”如今认定纳税人的钱被政府大肆浪费一模一样;他执掌皇家学会,为历任第二长,但这24年也恰是该学会历史上最黯淡无光的时段,没有任何创新,没有任何人才。他唯一让人记住的重要工作,是销毁了前任胡克的所有成就痕迹,甚至包括不让后人知道胡克到底长什么样!——这会不会也是马斯克“部长”的未来? 那么人类科技另一“牛人”、第一发明家爱迪生,晚年又如何呢?因为发明了白炽灯,爱迪生在照亮了全世界的同时,也一并照亮了他自己的商业帝国:从卖灯泡,到架电网。于是,他在64岁时创办了自己的爱迪生电气公司,从一位60年的“发明家”,摇身变成了一位20年的“企业家”。  而更重要的,是这一转型的成果如何?这样说吧,这位伟大的发明家在成为电力公司老板后,就再没有在发明创新上有过任何重大建树——马斯克“部长”会不会再将自己的灵魂放回到“特斯拉”,让“筷子”成为其创新的休止符,也很存疑。还不仅于此,因为爱迪生的电力公司依靠直流电技术,所以当后来居上的交流电技术开始出现时,“企业家”爱迪生便开始疯狂地加以反对。他借用自己的威望四处演讲游说,坚称交流电什么用都没有,只能用来做电刑杀人!事实上,他和他的助手确实亲手公开电死了很多小动物。但最终,事实胜于雄辩,交流电的高效不是爱迪生的电椅可以抹杀的。大结局是,“爱迪生电气公司”被自己的董事会引以为耻地更名为后来更著名的“通用电气公司”——这会不会也是马斯克“部长”的未来? 为什么?为什么也?为什么都? 因为狭隘,因为嫉妒,因为唯我独尊,因为一山不容二虎,因为大树之下寸草不生。本质上,都是因为人性的贪欲,人性的虚荣,人性恶的膨胀。 牛顿如此,爱迪生亦如此。马斯克正如此。  **都是“小人物”** 越是成功人士,甚至越是伟大人物,越应该时刻警惕自己的人生,会不会在巅峰忘乎所以时,不经意间走向自己前半生“人生价值”的反面,且浑然不知,而回头已晚。 规避这一人生扶摇直上又掉头向下的宿命悲剧曲线之法,也许就是在不断挑战和冲破事业边界的同时,要时刻思考和警惕自己人生的边界。前者要创新,要向前;后者要自控,要知止。企业家和企业家精神,在纵向一往无前时,横向也是有边界的。敬畏心,永远不可失。 因为,“到最后,都是小人物”——这是5年前马云上演沉浮曲线时,瞬间留给我的启发。如今,该轮到他当时的台上邻座了。是的,看似撼天动地、气吞山河的自以为是,只是因为——还没到“最后”。 可惜了,又一个天才,唉…… 文:中外管理传媒社长、总编 杨光 [查看评论](https://m.cnbeta.com.tw/comment/1485334.htm)

<blockquote><p>随着京东七鲜宣布将在天津新增20家仓店,这个曾经“佛系”发展的生鲜平台突然转向激进。本文将深入探讨京东七鲜为何选择此时发力即时零售,天津成为战役焦点的背后原因,以及这场零售战役对未来的深远影响。</p> </blockquote>  凌晨一点,天津河西区某小区,张女士在京东七鲜App下单了一盒精品佳沃花香蓝莓和京东京造西冷整切调理 牛排。28分钟后,配送员按响门铃——这不是一次普通的购物,而是京东在即时零售战场投下的一枚“深水炸弹”。 日前,《北京商报》等媒体曝出消息:京东七鲜计划在6月底前,于天津新增20家仓店,覆盖全市9个核心区。 自去年11月起,这家此前“佛系”发展的生鲜平台突然转向激进:价格战、配送提速、运费下调、布局前置仓,甚至喊出“击穿价”口号,部分商品比其他平台便宜10%。 一个问题浮出水面:在盒马、叮咚买菜、朴朴超市、小象超市、山姆云仓、永辉等都在发力即时零售的当下,姗姗来迟的京东七鲜,为何选择此时加速?天津,又为何成为这场战役的“诺曼底”? ## 一、京东七鲜的“慢”与“快” 时间倒回 2018 年,京东亦庄大族广场首店开业,直接对标盒马。那时的七鲜野心勃勃:5 年 1000 家店,用 “超市 + 餐饮 + 黑科技” 定义未来零售。而彼时,盒马正以“30分钟达”横扫一线城市,叮咚买菜在华东疯狂扩张,朴朴超市在福建闷声发财。而京东七鲜却显得格外“克制”——截至2025年3月,全国门店不足70家,主要集中在北京、天津、上海、广州、深圳、廊坊、佛山7个城市。 京东七鲜的慢,源于三个致命矛盾: 一是高端定位与即时零售的错位。早期七鲜模仿 Ole’精品超市,4000 平米大店主打 “魔镜溯源”“悬挂链物流”,甚至在超市里开酒吧(七范儿)。但即时零售的核心是 “家门口的便宜菜”,消费者不会为 “看糖度的镜面” 多掏 20%。一位前员工透露:“2019 年天津鲁能城店,进口水果占比超 40%,周边社区大爷大妈只逛不买。” 二是供应链的 “虚胖” 与 “贫血”。生鲜零售的命门是供应链。七鲜早期依赖京东大仓调拨,本地直采占比不足 30%。2020 年疫情期间,北京某门店因无法及时补货,眼睁睁看着美团小象抢走 80% 订单。直到 2021 年京心助农项目打通 200 + 产地,七鲜才真正摸到 “源头直采” 的门道 —— 云南的罗马生菜、福建的琯溪蜜柚,去掉 3 层中间商,成本直降 15%。 三是组织的摇摆与试错。七年四任负责人,战略反复横跳:从大店扩张到 OFC 加盟,从社区店到写字楼 “七范儿”,甚至尝试 “超市 + 家政”。2021 年七范儿首店因疫情关闭,内部复盘时承认:“我们总想做‘不一样的零售’,却忘了消费者要的只是‘更快更便宜的菜’。” 同时七鲜的慢也藏在京东的基因里。京东长于标品和3C,生鲜品类需要的前置仓、冷链、损耗控制,恰是其短板。更关键的是,即时零售要求“区域密度”,而京东七鲜的分散布局难以摊薄成本。 截至 2024 年底,盒马在北京的门店数量已接近 60 家,而叮咚买菜和小象超市在北京则均有100左右个前置仓,而北京作为京东七鲜店最多的城市,目前也不过有36家门店,其覆盖范围上与盒马、叮咚买菜与小象超市还有差距。 一位京东内部人士告诉刘老实:“慢是因为没想清楚模式,快是因为不能再等。”即时零售市场规模将在2025年突破1万亿,虽然未来十年仍然会保持双位数增长,但破局的窗口期一所剩无几。若此时不卡位,未来连入场券都拿不到。 ## 二、京东的王牌:藏在“供应链”里的杀招 与盒马、叮咚买菜等相比,京东七鲜看似劣势明显:门店少、用户习惯未养成、区域渗透率低。但若细看其底牌,会发现4大隐藏优势: 首先源头直采 + 全链路控本,用“鲜度”和“低价”撕开市场。七鲜的供应链从田间到货架,快得近乎暴力:云南高原的生菜凌晨 4 点采摘,下午 2 点已摆上北京亦庄门店的货架;大连黄海的生蚝捕捞后,通过京东冷链船 + 陆运,18 小时直达天津河西仓。 这 种“产地直连门店”模式 ,砍掉 3 层中间商,让鲜活基围虾(500g)卖 19.9 元(盒马 25.8 元),智利 J 级车厘子便宜 20%—— 低价的底气,来自京东 1500 个仓库的“共享底盘”:将 3C 退货仓改造为生鲜前置仓,单仓成本降 40%,连冰袋都是手机包装盒的边角料。 其次,京东生态协同:物流 + 会员 + 3C 的“三角杀器”。七鲜的 30 分钟达,藏着京东物流的“黑科技”。在天津,生鲜订单与 3C 退货单“动态拼车”,利用返程空驶率(日均 18%),单均配送成本压到 3.2 元(朴朴 8.1 元)。 更绝的是 “PLUS 会员特权”。免运费门槛从 59 元降至 29 元(仅限七鲜),叠加“坏果秒赔”,让低频用户(月购<2 次)转化率提升 37%。2024 年试点的”海鲜 + 料理锅”套餐(买三文鱼送电煮锅),用 3C 的流量反哺生鲜,这是盒马、朴朴学不来的“生态杠杆”。 第三,线下场景革命:从“买菜场”到“生活中心”。七鲜的门店是“科技感 + 烟火气”的混搭。北京十里堡店的“千里眼”,扫码能看云南菜农的采摘视频;天津梅江店的餐饮区,现场煎制挪威三文鱼,吸引 38% 的用户逛着买。 更聪明的是全品类覆盖。除了生鲜,还卖茅台(直供价)、戴森吸尘器(小时达),北京某门店 SKU 超 3500 个,其中 20% 是 3C 家电 —— 这种生鲜 + 万物的组合,让家庭用户一次买齐,客单价(112 元)比纯生鲜平台(叮咚 89 元)高 26%。 为什么是天津? 天津并非即时零售一线战场。截止目前,京东七鲜在天津仅有10家门店,盒马天津首店正在装修,朴朴超市也尚未进入,叮咚买菜覆盖率不足50%。但京东选择用三个月在这里新开现有2倍数量的门店,隐藏着三重算计: 一是市场空白期的“闪电突袭”。天津常住人口超1300万,人均可支配收入全国第7,但即时零售渗透率仅为一线的60%。对手尚未形成垄断,用户习惯正处培育期——这是最佳切入时机。 二是华北供应链的“枢纽价值”。天津港是中国北方最大生鲜进口口岸,京东在此建有3个保税冷链仓。智利车厘子、挪威三文鱼、澳洲牛肉可直通七鲜货架,物流成本比从上海转运低15%。地理优势让“击穿价”成为可能。 三是政策红利的“试验田”。2023年,天津推出“一刻钟便民生活圈”政策,对社区生鲜店给予租金补贴。如果京东七鲜将20家新店全数申报为“民生保障项目”,单店年省租金超50万。用政策杠杆撬动成本,这是朴朴、叮咚不具备的优势。 ## 三、即时零售的终局:没有奇迹,只有效率 京东七鲜的天津战役,本质是一场“成本革命”。 盒马的杀手锏是“日日鲜”供应链,叮咚买菜靠“产地直采”控价,朴朴超市凭“福州模式”滚雪球。而京东七鲜的底牌,是将集团原有的仓储、物流、数据能力“平移”到生鲜赛道。通过分析3C产品的历史数据,反向优化生鲜订货模型。用标品思维做非标品,这是跨界者的独特红利。 但挑战依然存在,即时零售是“区域密度游戏”,七鲜在天津的20家新店需形成网格化覆盖。若某个片区订单密度不足,前置仓可能陷入“越亏越补”的泥潭。 风口的本质,是效率的战争。2024年,即时零售进入“深水区”。 盒马在优化盈利模型,叮咚买菜收缩战线,朴朴超市谨慎北上。而京东七鲜选择此时冲锋,看似激进,实则暗合商业规律——在行业集体降速时,用集团资源打一场“不对称战争”。 天津战役的胜负,不取决于门店数量或补贴力度,而在于能否验证一个假设:京东的供应链基因,能否在生鲜赛道上跑通“成本领先+体验升级”的双重模型。 如果成功,七鲜将成为京东继物流后的第二张王牌;如果失败,至少能换来一条教训:零售的本质从未改变——要么足够便宜,要么足够快,要么足够好。而京东,这次想全都要。 此刻,天津的20家仓店正在紧锣密鼓地施工。它们承载的或许不只是生鲜货架,更是一家巨头对零售终局的终极押注。 撰文:刘老实 排版:柯不楠 校对:十 三 公众号:即时刘说 本文由 @即时刘说 原创发布于人人都是产品经理。未经作者许可,禁止转载 题图来自Pixabay,基于CC0协议 该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务

由《星际火狐》创作者深度参与的轨道射击游戏《Wild Blue》正式公开。在保留刺激又充满怀旧风情的基础上,开发团队带来了更流畅的操作和更震撼的视觉体验。游戏中,你将驾驶战机穿越广阔的海洋、陡峭的沙漠山脊和险峻的洞穴,与敌军正面对抗,阻止男爵的邪恶势力扩张。  游戏采用简洁直观的操作方式,让新手和射击游戏老玩家都能快速上手。而细腻的手绘动漫风画面则将你带入一个充满细节的奇幻世界。多样的玩法、隐藏的分支路线以及紧张刺激的任务,让每一场战斗都充满惊喜与挑战。游戏特色包括:  - 经典“轨道射击”玩法升级,带来更顺畅、更现代的操作体验 - 沉浸在生动绚丽的世界中,每一次飞行都能欣赏壮美风景 - 与可靠的战友并肩作战,完成一场场热血沸腾的战役 - 挑战劲敌,与神秘的对手小队展开激烈空战 - 探索隐藏路线和秘密任务,最终直面邪恶男爵的阴谋 - 通过简单易懂但极具挑战性的评分系统,成为王牌飞行员,精通每一场战斗 <内嵌内容,请前往机核查看>

人人都是产品经理 · 福田贝叶斯

人人都是产品经理 · 福田贝叶斯 钛媒体 · 雷达财经

钛媒体 · 雷达财经 cnBeta全文版

cnBeta全文版 36氪

36氪 机核 · YT17

机核 · YT17 嘶吼 · 山卡拉

嘶吼 · 山卡拉