所有文章

美东时间周三,美国总统特朗普表示,可口可乐已经同意在美国销售的饮料中使用“真正的蔗糖”。目前,可口可乐在其美国产品中使用的是玉米糖浆,但这遭致了特朗普政府的卫生部长小罗伯特·F·肯尼迪的担忧——小肯尼迪声称,玉米糖浆对健康可能存在负面影响。 特朗普在社交媒体Truth Social上写道:“我一直在和可口可乐公司讨论在美国的可乐中使用真正的蔗糖的问题,他们已经同意这么做了……我要感谢可口可乐公司的所有负责人。” 特朗普写道:“这将是他们迈出的非常好的一步——你会看到的。这样更好!” 然而,可口可乐的发言人并没有明确证实配方的调整,仅仅是表示他们“感谢特朗普总统的热情”,“我们将很快分享可口可乐产品系列中创新产品的更多细节”。 **数千个岗位将消失** 目前,在美国销售的可口可乐通常用玉米糖浆,而在墨西哥、英国和澳大利亚等其他国家销售的可口可乐则倾向于使用蔗糖。 如果可口可乐真的如特朗普所愿,改为使用蔗糖,这可能对美国的玉米种植者们来说是个苦涩的决定。 美国玉米加工协会主席兼首席执行官约翰·博德(John Bode)在声明中说:“用蔗糖代替高果糖玉米糖浆将使美国食品制造业失去数千个工作岗位,降低农业收入,并增加外国糖的进口,所有这些都没有营养价值。” 玉米是美国产出的主要农作物之一。美国的玉米种植带在美国中西部地区,而这里一直是特朗普的主要支持区。 美国卫生部长小肯尼迪和他的“让美国再次健康”运动倡导公司从其产品中去除玉米糖浆、种子油和人工染料等成分,并声称这些成分与一系列健康问题有关。 值得一提的是,特朗普本人经常喝健怡可乐,而健怡可乐中使用的是人工甜味剂阿斯巴甜——国际癌症研究机构 (IARC) 将这种化合物列为“可能致癌物”。特朗普甚至在其椭圆形办公室的坚毅办公桌上安装了一个按钮,只要一按按钮,工作人员就会为他送上冰镇的健怡可乐。  [查看评论](https://m.cnbeta.com.tw/comment/1513566.htm)

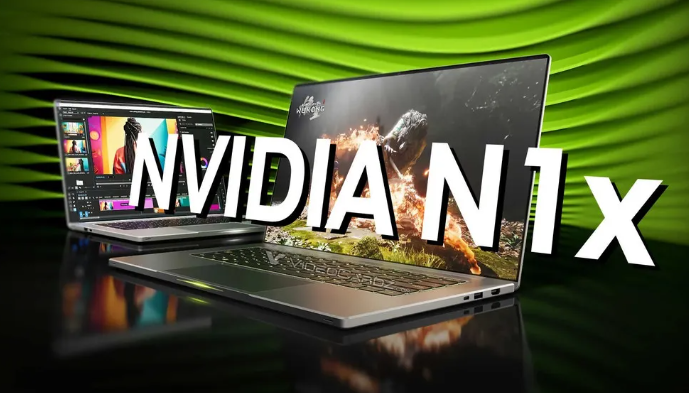

英伟达备受瞩目的首款消费级处理器N1X和N1系列已确认延期发布,最新计划于2026年底上市。此举标志着英伟达正式进军消费级处理器、SoC和APU市场,旨在推出集成GeForce RTX显卡与Arm架构CPU的芯片组合,其搭载的Arm CPU有望成为Windows PC平台迄今性能最强的解决方案。  据行业媒体SemiAccurate披露,尽管N1芯片已进入生产阶段,但新发现的工程难题可能导致发布时间推迟至2026年末。这一问题或需对硅片进行设计修改,进而对量产和出货造成重大影响。 性能方面,上月曝光的Geekbench 6测试数据显示:N1X处理器采用10个Cortex-X925与10个Cortex-A725组成的20核Arm架构,在搭载128GB内存、运行Ubuntu 24.04.1的惠普工作站上,单核得分3096分,多核达18837分。其基础频率为2.81GHz,加速频率可达4GHz。  显卡配置仍属传言范畴——集成显卡据称配备6144个CUDA核心,数量与RTX 5070相当,但因频率大幅降低,实际性能或更接近RTX 5060 Ti。即便如此,作为集成显卡仍具突破性意义。精简规格的N1C芯片则可能适配超极本或新一代英伟达掌机设备。 [查看评论](https://m.cnbeta.com.tw/comment/1513560.htm)

已停摆近两年的威马汽车,近期突然传出即将复工复产的消息。市场分析,唤醒威马汽车的“金主”,是宝能汽车。互联网流传的一份《新威马汽车致供应商白皮书》,提出了2030年产销破百万辆的宏大目标。只是不知道,还有多少人会愿意为重生的威马汽车买单。 即将复活? 已僵死近两年的威马汽车,突然有了复活的迹象。 最近几天,网上出现了一份《新威马汽车致供应商白皮书》,披露了威马复产的计划及未来的发展规划。 白皮书称,将通过对老客户置换新车、网约车采购以及出海等方式,来打开局面。 起死回生的新威马,表现出了勃勃野心,2025年-2030年,通过三步走来实现跨越式发展。 2025年-2026年,被定义为复兴阶段。将于今年9月,恢复EX5和E.5两款车型的生产,确保年产销1万台,争取2万台;同时通过布局泰国KD工厂,开拓东南亚及中东市场。2026年,产量10万台。 2027年-2028年,进入发展阶段。年销量跃升至25万-40万台;高阶辅助驾驶车型量产,AI赋能研发、生产及营销各环节。启动IPO筹备。 2029年-2030年,新威马实现跨越,年产销挑战100万台,营收1200亿元,构建智慧出行生态圈,成为行业新标杆。  是谁主导着威马汽车的重生?给供应商开出了这样一份看起来振奋人心,又那么虚无缥缈的空头支票? 据了解,去年初,威马汽车正式启动破产重整并招募投资人,深圳翔飞汽车销售有限公司成为唯一的意愿投资方。 翔飞汽车成立于2023年9月,注册资本1亿元。天眼查显示,其股东方与宝能汽车有着千丝万缕的联系。 早先,就已有市场消息称,宝能汽车有意收购威马。今年6月,媒体报道威马汽车的几款车型,出现在深圳宝能汽车展示中心。 今年4月,法院批准威马汽车的重整计划。《草案》显示,威马计划在2025年复工复产,并同步进行品牌焕新和营销网络搭建。 赢得了开局 起步于2015年的威马汽车,曾是中国头部造车新势力之一。其创始人沈晖,更是新势力中,为数不多的资深汽车人。 创业之前,沈晖有着辉煌的履历,曾长期在欧美及中国500强企业工作。2010年,他加盟吉利,期间率领团队,完成了对沃尔沃的收购,并负责重组沃尔沃全球治理构架,被誉为“中国汽车工业全球化第一人”。 沈晖的专业背景和国际化视野,为威马赢得了很好的开局。 2017年-2022年3月,公司相继完成了A-D轮共12次融资,从一级市场拿到了超过350亿元真金白银,为上市前融资最多的造车新势力。雅居乐集团、百度、腾讯、李嘉诚基金、何鸿燊家族等,均参与其中。D轮融资后,公司整体估值达70.4亿美元。 2018年9月,威马汽车首款量产车型EX5上市,其后,又相继推出EX6、W6、E5等车型,实现了对16万-30万元价格带新能源汽车的布局。  产品率先量产,为威马汽车赢得了市场先机。2019年,整体交付破万,销量在新势力中排名第二,仅次于蔚来。 然而,威马的这一强劲势头未能持续下去。2021年,同期创业的“蔚小理”年销量齐齐突破10万大关,而威马汽车却只有4.4万辆。 即便如此,威马仍不忘给自己贴金。根据灼识咨询数据,2021年,威马汽车电动SUV销量在中国主流市场所有纯电汽车制造商中排名第一;电动汽车销量及智能汽车销量,在中国主流市场所有本土汽车制造商中排名第三。 面对严峻的竞争环境,威马汽车没有采取积极进取的市场策略,而是反其道行之。2022年初,公司调整产线并控制销量,“为提高建议零售价做准备。”由此带来的结果是,销量大幅下挫,当年1-11月,累计销售不超过3万辆。 威马汽车2022年披露的招股书显示,2018年-2021年,累计销售汽车8.35万辆,累计实现收入92.07亿元,经调整净亏损合计达136.32亿元,这意味着,每卖出一辆车,要亏超过16万元。 突然坠落 造车是个非常烧钱的行业,在实现自身造血功能之前,需要不断有资金注入才能维持下去。 对此,沈晖有着清醒的认识。在他的带领下,威马汽车很早就启动了上市进程,曾先后谋求海外、科创板及港股IPO独立上市,但均无疾而终。 而同时期的蔚来、理想、小鹏等,先后完成了上市,为持续发展赢得了融资平台优势。 数据显示,截至2022年3月末,威马汽车现金及现金等价物合计仅36.78亿元,资金储备已不足以支撑烧钱的速度。  此时的威马已变身“危马”,命悬一线。 2022年10月,公司宣布全员降薪,高管层的工资打五折,高管以下员工工资打七折,并暂停购车补贴、年终奖、13薪、14薪的发放。同时,将每月的发薪日从8日推迟至25日。 生死关口,威马汽车仍在奋力自救,希望通过曲线上市为自己赢得喘息的机会。 2023年初,港股上市公司APOLLO出行宣布,拟以20.23亿美元收购威马汽车全部以发行股份,同时通过配套融资,为威马筹集经营所需资金。 这时,公司创始人、董事长兼CEO沈晖还表现得极为坚韧,他在个人微博上,以电影《芙蓉镇》的一段对白,表达自己的心境:“活下去,像牲口一样的活下去”。 当时,外界预计,如果一切顺利,威马可通过这一次反向收购,在当年第二季度挂牌上市。 没想到,当年9月10日,威马突然宣布,终止与Apollo出行的RTO进程,反向收购借壳上市的计划失败。 几乎在同一时间,纳斯达克中概股开心汽车突然宣布,已与威马汽车签署了非约束性并购意向书,计划通过新股增发,收购威马100%股权。 可是,威马汽车终究没有等到上市的一天。 2023年10月,公司突然宣布,向法院申请重整。 [查看评论](https://m.cnbeta.com.tw/comment/1513556.htm)

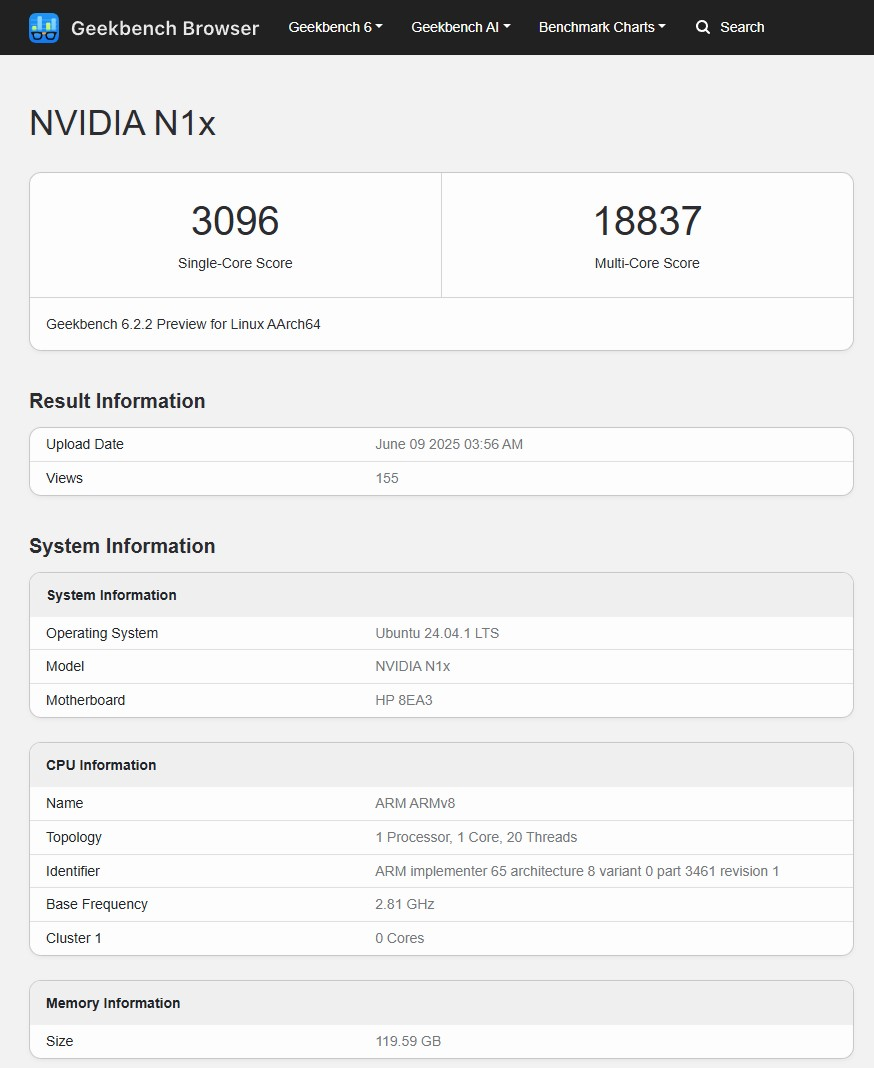

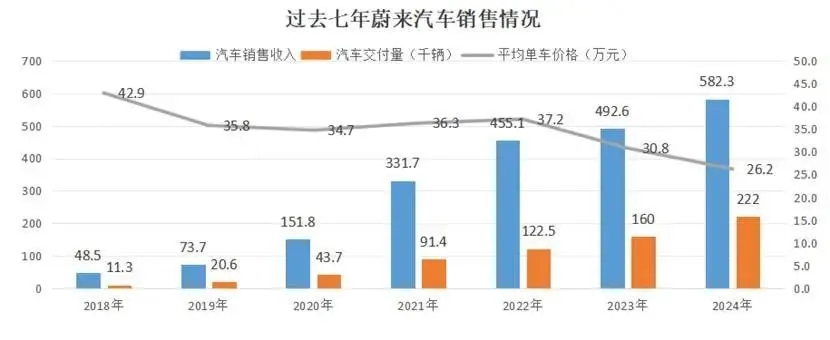

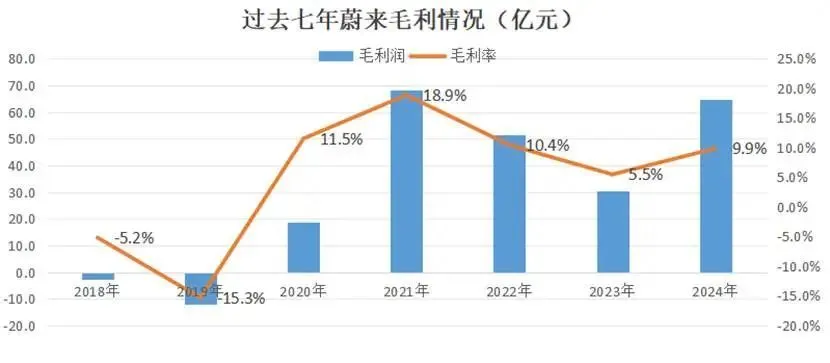

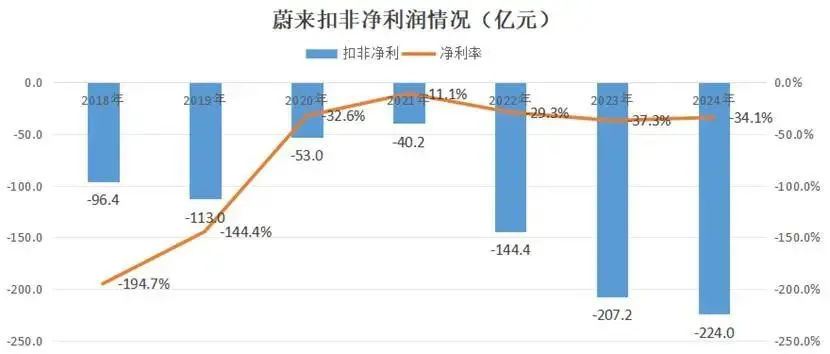

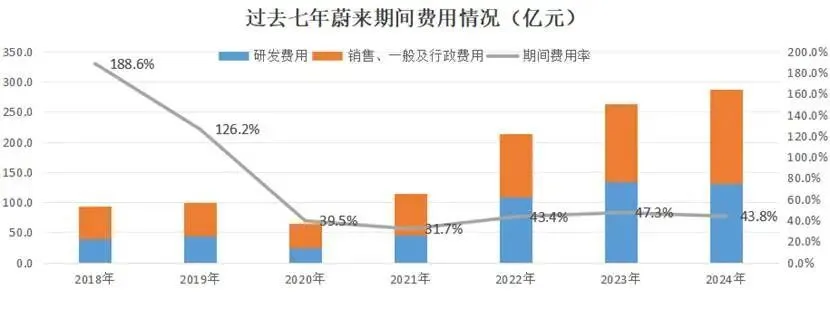

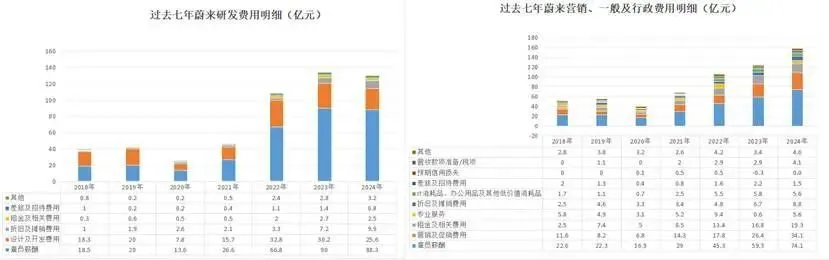

中国造车新势力亏损是常态。而牌桌之上亏损最狠的,还当属蔚来。创业至今,2024年是蔚来亏损幅度最大的年份,财年内亏损224亿元,超过同期上市未盈利车企亏损总和。另根据统计数据显示,2018-2024年7年间,蔚来累计亏损累计已破千亿大关。    面对汹涌的异议,创始人李斌在直播间回应道:“钱都亏在明处,财报非常干净。”那么, 这些“明处”究竟都是哪儿? 01 七年亏了1092.9亿元 蔚来成立于2014年,2017年推出首款车ES8创始版,售价54.8万元,定位高端智能SUV汽车,并在18年开始正式交付。因此,蔚来比较有分析价值的业绩数据区间在2018年至今七年间。  财报数据显示,近七年来蔚来营业收入共计实现营业收入2357.9亿元,对应合计亏损超千亿——蔚来七年间累计归母净亏损达1092.9亿元。 收入端,蔚来汽车收入项目分两块:一是汽车销售(24年582.3亿元,占总收入比88.6%);二是其他销售,对应的是蔚来新能源车换电模式的卖断/出租电池相关收入(24年75亿元,占比11.4%)。  就核心业务汽车销售而言,过去七年,蔚来交付了67.16万辆汽车,对应着2135.7亿元的业务收入,平均单车价格从42.9万元/台,一路降到26.2万元/台。 品牌定位上,蔚来在造车新势力中本属于高端位置,首款车ES8较小鹏汽车(小鹏G3,22.78万原)和理想汽车(理想ONE,32.8万元)首款车定价都要高很多。 随着供给侧技术趋于成熟并开启内卷模式,加之头部主机厂产能稳定并逐渐迎来规模效应的市场走向,共同决定了30万元以上高端市场(仅占中国乘用车份额12%)的规模存在天然天花板。 与此同时,来自头部玩家的竞争压力陡增:以特斯拉为例,上海超级工厂单厂年产能95万辆(Model Y+Model 3),单车销售成本仅25万元,附加政府购车补贴后的落地价格,给造车新势力们带来不小的压力。 而据蔚来投资人采访,蔚来ES6单车BOM(物料成本)一度接近30万元。当高端市场无法支撑产能爬坡时,降价成为唯一选择——  从蔚来车型价格矩阵看,蔚来ES这一品牌系列外,公司还推出了乐道(24年5月),以及萤火虫(25年4月)。从发布节奏上看,无论是品牌车型还是不同品牌间的互补,蔚来的价格带都是逐渐下探的。 需要注意的是,蔚来独特的换电模式本应是差异化解药,目前却因场景错配加剧蔚来亏损负担。 截至24年底,蔚来建设了3389座换电站,投资产生258.9亿元固定资产,对应换电站单站建设成本约300万元。算上日常运营需要覆盖的人力、电力、房租成本,单站日均服务60次方能盈亏平衡。 2024年运营数据显示,蔚来主要使用场景为私家车(而非高频的营运车辆),带来的日均服务次数仅35次(含免费用户),利用率不足60%造成资源的巨大浪费。  定价战略摇摆、换电重资产运营模式合力下,蔚来的毛利率水平不断下探,七年间蔚来最高毛利率为2021年的18.9%,到2024年毛利率下探至9.9%,垫底“蔚小理”(小鹏14.3%、理想20.5%)。 02 第一“失血点”并不是研发 为方便统计,我们将比照数据从开头的归母净利调整为扣非净利,则2018年-2024年蔚来合计亏损金额为878亿元。  拆解数据会发现,蔚来期间费用结构暴露的核心矛盾,远非简单的研发投入导致亏损能概括。李斌强调“研发费用化”的财务透明度时,刻意淡化了企业运营中更致命的失血点——组织资源的巨大浪费。  仔细拆解878亿元亏损的构成会发现,销售和管理费用达到608亿元,比研发的528亿元多出了80亿元。也就是说,销售和管理费用才是更大的出血点。2024年情况更明显:销售行政开支157亿元,高出同年研发支出27亿元。 横向对比“蔚小理”费用结构,蔚来23.9%的销售行政费用率不仅较理想(8.9%)高出15个百分点、较小鹏高出12个点,甚至比宝马中国(11.2%)这类传统豪华车企还高出逾一倍。  与资本寒冬中小鹏、理想的控费不同,蔚来在营销、管理、行政开支上的粗放风格,直接造成服务成本高、人员负担重、花钱效果差的现实问题。 根据市场测算,一线城市蔚来NIO House单店年运营成本超2000万元,相当于传统4S店的3倍;客户服务团队超8000人,对应地,蔚来四年间员工总数从1.5 万扩充到4.5万名(小鹏1.5万名员工、理想3.2万名员工),蔚来雇员开支24年分别占研发费用与营销、一般及行政费用的67.8%与47%。  8000人的客服团队,平均每个蔚来用户每年要分摊4000元服务费。当主力车型价格降到26万元,新品牌乐道更是下探到20万区间,这样的服务成本根本背不动。可以看到,蔚来人效比令人心疼。 人工薪酬方面,蔚来确实较市场有“竞争力”。这也印证了李斌直播间所讲的,蔚来员工薪资高的说法,堪称“直言不讳”。  财报显示,2024年,蔚来研发人员人均年薪76.6万元,行政、一般及管理人员人均年薪27.8万元。 小鹏、理想年报中没有披露这一细化的数据。可以找到的数据是理想招股书数据显示,2020年理想研发人员年薪35.5万元,行政、一般及管理人员人均年薪18.5万元, 相近年份比下来,蔚来人均薪酬大约较行业水平高出50%-60%。 然而,去年推出乐道品牌时集中暴露了蔚来的人力投入产出问题,“顶着高资质的研发团队与高质量的服务,乐道品牌首月仅交付832台…… 03 一切尽在不言中 行文至此,蔚来七年累积的巨额亏损,核心问题已清晰呈现:高昂的运营成本,尤其是销售、管理和行政费用的失控,是比研发投入更严重的出血点。 无论是远超同行的员工规模、过重的单用户服务成本,还是效率较低的渠道投入,都持续侵蚀着本已因价格下探和重资产换电模式而变薄的利润。同时,高投入并未带来与之匹配的商业化效率。 简单来说,蔚来的钱,很大一部分花在了低效甚至无效的地方。 李斌所言钱亏在“明处”,确实点明了亏损项目在财报上的可见性。但投资者更为关注的问题或许在于,这些明处的开支是否合理、高效,是否真正支撑起了企业的可持续发展? 一切尽在不言中。 [查看评论](https://m.cnbeta.com.tw/comment/1513554.htm)

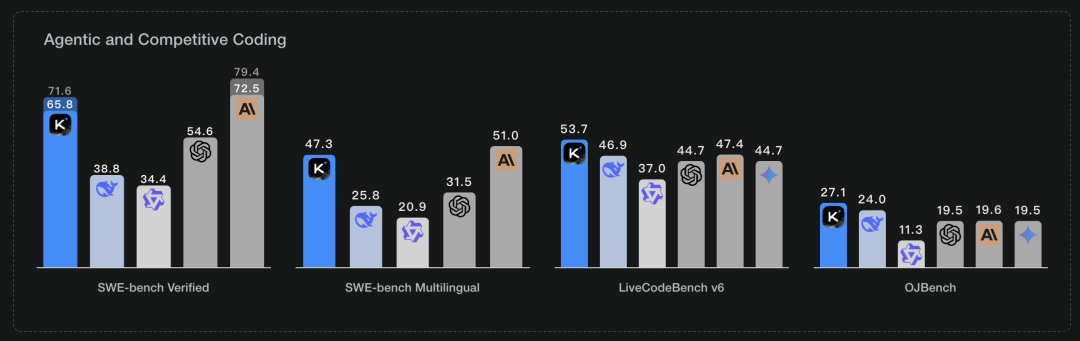

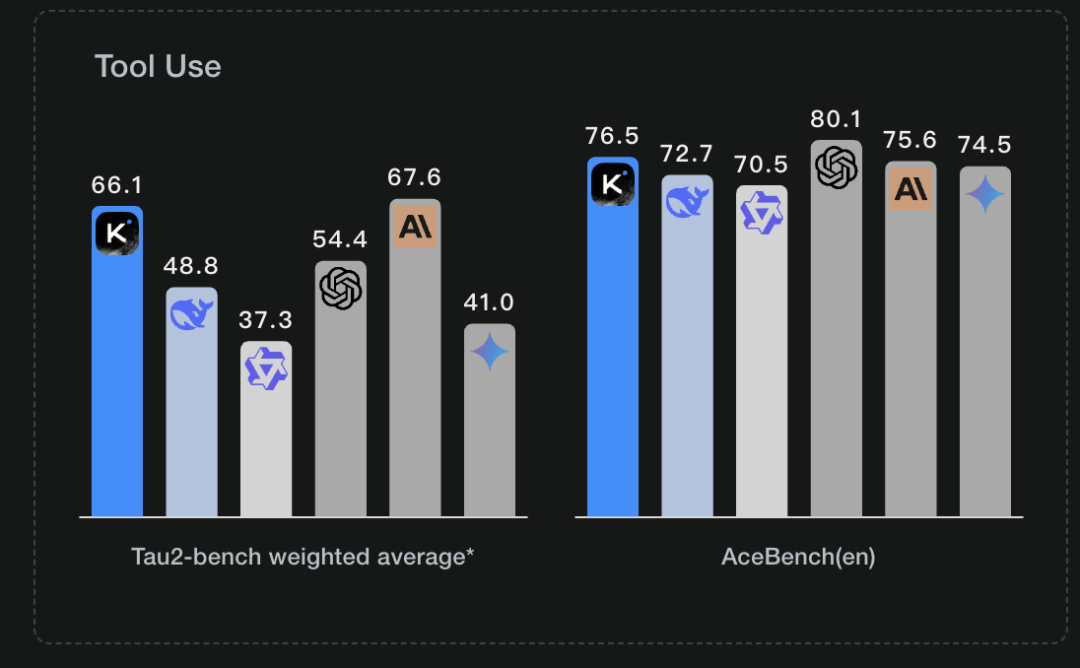

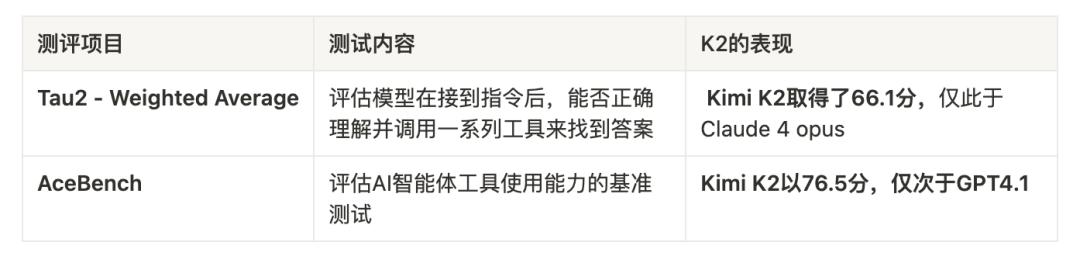

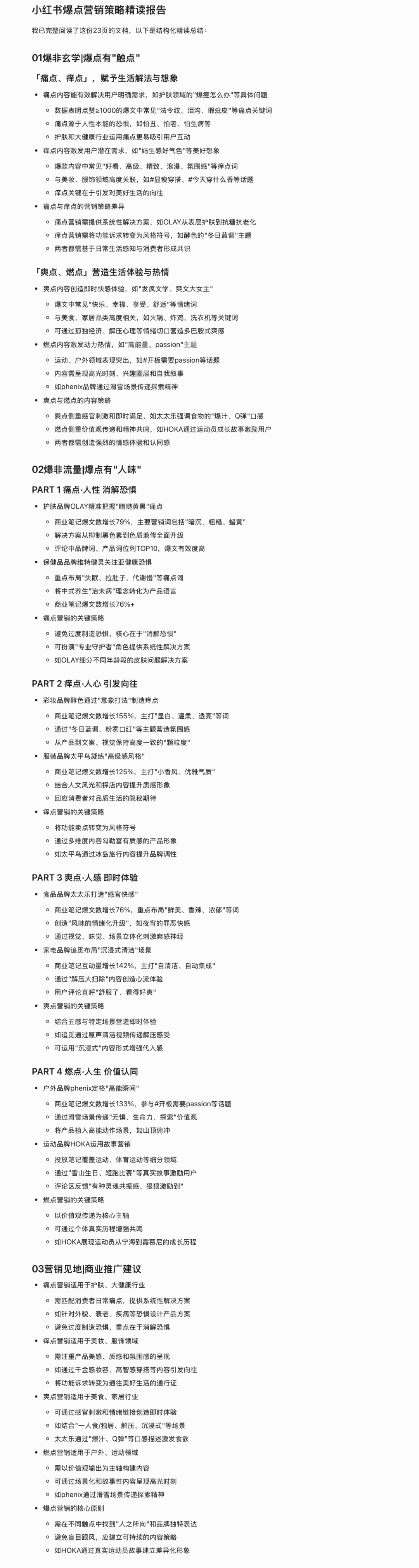

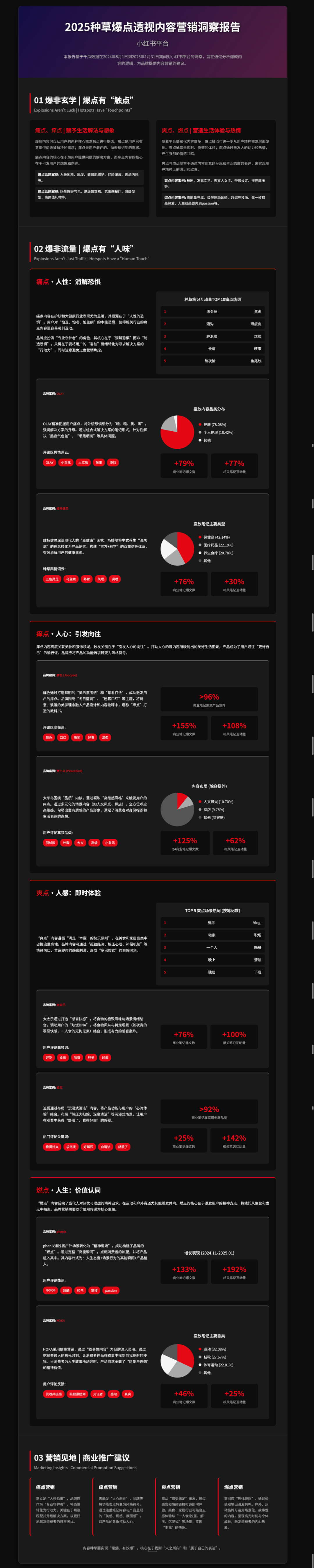

<blockquote><p>最近模型圈大家关注度最高的莫过于Grok4以及Kimi K2,作为一个AI应用开发者,我们一直都时刻关注最新的模型能力表现,因此今天三白花了一天左右的时间先深入研究和实测一下K2的表现,看有没有媒体吹嘘的那么牛。</p> <p>本篇内容主要从K2的模型亮点、K2与主流模型综合能力对比、K2实际应用效果测试三个角度,探探K2大概是什么水平。</p> </blockquote>  一句话概括全文: Kimi K2的代码编程、智能体agent、数学推理方面表现出色,已经接近第一梯队的顶尖模型,但是在多模态、指令遵循方面依然表现不佳,综合性能距离OpenAI、Gemini、Claude系列顶尖模型,还有差距。 ## 一、K2的核心能力亮点 概括起来讲,K2这次在模型层能力的突破,主要聚焦在代码编程、智能体、数学推理这三个方面,达到了非常优秀的水平,也因此引起了AI技术圈的关注。 ### 1. 编程与代码生成能力:全球仅次于claude 4 sonnet的编程模型 编程能力目前是K2主打的第一个能力亮点,目前K2的编程代码能力或许全球仅次于**claude 4 sonnet。** 对于模型在编程代码领域的表现的测试,主要通过**SWE-bench 、LiveCodeBench v6、OJBench**这几项测评来测试,K2的实际测评结果如下:  怎么理解上面各项测评内容及测试结果的含义? 以下的三个测评项目主要评测模型在实际解决github的代码问题、非英语代码库问题、编程面试、算法竞赛等方面的表现,是国际公认的评估模型代码编程能力的测评项目,从实际测评结果上看K2的表现可谓相当的不错。  **K2目前的编程能力,在全球大模型里面属于什么水平?** 由于上图测评结果为Kimi自己公开的数据,对比对象是官方自己挑选的,也存在可能没有把部分更强大的模型也放进去对比的嫌疑,所以如果放到全球所有模型上去对比,K2的编程能力是一个什么样的水平? 以SWE-bench得分作为参考,目前得分top5的模型从高到低包括:Claude 4 sonnet、K2、Gemini 2.5 Pro、GPT4.1、deepseek-coder V2. **目前K2的编程能力,全球可能仅此于claude 4 sonnet,甚至可能超过Gemini 2.5 pro。**  **编程能力在应用层的价值是什么?** 编程能力直接影响模型在程序员编程、应用和网页开发的应用落地的质量,同时也是智能体表现的基础。 ### 2. 智能体能力仅次于Claude 4和GPT 4.1 K2对外宣称的另一个核心能力亮点是智能体的应用能力,也就是实际解决一个应用场景的任务的能力,该能力的表现主要从任务规划拆解、工具调用、自动编码和执行代码的能力。 - **智能体任务:K2具备执行复杂的、多步骤的任务的能力,包括任务拆解、自主规划,工作流设计以及工具调用能力;** - **工具使用:模型原生支持强大的工具调用能力,开发者可以轻松地将自己的API或工具集(如搜索、日历、预定系统等)接入KimiK2,模型能够理解并自主使用这些工具来完成任务。官方演示中,KimiK2能通过连续17次工具调用来规划一场完整的演唱会之旅。** - **自动化编码:开发者可以将KimiK2接入到各种Agent或编码框架中,实现高度自动化的编码。例如,它可以自主完成数据分析、生成可视化图表,并将结果打包成一个交互式网页。** 对于其智能体能力表现的测评结果,KIMI官方公开的测评数据如下:  测评内容及测试结果的含义 从测评数据上看,K2目前的智能体水平可能也仅次于Claude 4以及GPT4.1,也已经是一个比较不错的水平。  **智能体能力在应用层的价值是什么?** 它体现在解决具体的AI应用落地效果,以及实际解决具体的任务时的表现,智能体能力约强大,越能满足用户的实际应用请求。 ### 3. 数学推理能力:全球最强 K2目前是全球模型中数学推理能力最强的模型,在MATH、AIME、GPQA-Diamond多项测评中,目前都是得分最高的模型,这三个测试项目分别为专门针对大模型数学能力的专业测评、以及美国为顶尖人类学生设立的数学竞赛试题、以及衡量模型科学推理能力上线的测试模型,而K2在每一项测试中的得分均是最高的。   数学推理领域全球top5的模型有哪些? 当下全球模型在数学推理领域top5的模型主要包括:K2、Gemini2.5 pro、R1、GPT4O或O3、Grok3/4.  **数学推理能力在应用层的价值是什么?** 体现在数据分析、数学教学等包括金融、教育等很多通用领域的应用效果。 ## 二、K2与主流模型综合能力对比 然而,一个模型最后要能够被更好的落地到应用层,光看代码编程、智能体、数学推理这三个方面是肯定不够的,K2在这几个单点能力上的表现,只能说在部分应用领域里面,表现会更好,但是放到很多通用应用场景里面表现不一定真的那么出色。 评估一个模型最后的应用落地效果,要从如下多个维度评价,其中个人总结为6个维度: - 推理能力:包括深度思考、数学推理、科学推理等; - 代码生成能力 - 智能体能力:包括任务规划、代码执行、工具调用等; - 精确指令遵循 - 文本理解与创作 - 多模态理解和生成能力 目前K2的模型发展路线,是聚焦在模型的“行动和执行”能力上,然而在多模态的理解生成,以及指令遵循等方面,表现效果却还是相对一般(这个在第三部分应用测试中会体现出来); 而Gemini 、OpenAI等顶尖模型不同的是,这些模型选择在优先侧重模型的推 理和思考能力的同时,不断地强化以上其他领域的能力,因此其达到了综合能力超强的模型水平。 所以,从应用开发者和AI应用使用者的角度上看,目前要真正能投入应用或者达到足够高的AI应用满足度,目前还得是使用OpenAI、Gemini等系列模型,根据个人目前的理解,在模型和应用选型上,我依然还是会优先考虑GPT/O系列、Gemini 2.5 Pro、R1,而K2可能会作为其中部分场景的平替。 ## 三、应用实测效果对比:K2、Gemini、DS、豆包 前面两部分说了那么多,大部分结论都是基于官方公开和行业测评的结果得出的,到底是不是真的好用,实测一下才知道。 因此这部分我主要实际体验一下K2的效果,我还是拿我平时应用场景最多的阅读和网页生成这两个应用场景为例,对K2做一下测试; 由于目前这两个场景我在Gemini 2.5 Pro已经得到很好的满足,因此实际效果将对比Gemini 2.5 Pro,同时也和我平时最常用的豆包、deepseek两个模型做一下对比。 测试场景1:文档阅读场景 提示词如下: <blockquote><p>该段提示词的目标是希望对用户上传的文档做精读处理并结构化输出精读摘要。</p> <p>***Role***</p> <p>你是一个擅长阅读提取关键信息的专家,请阅读我提供的文档,并为我生成一份结构化的精读总结。</p> <p>***Background***</p> <p>我需要对这个{我上传的文档},AI生成一个结构化的精读报告,能遍历整个文档并提炼每一个段落内的要点信息,方便我快速的掌握长文本的内容。</p> <p>***Goals***</p> <p>-根据用户提供的文档,梳理文档的大纲结构,并完整的阅读文档中的每一个段落,不错过文档中的每一个段落的信息,为了确保没有遗漏,你需要告诉我你阅读了多少页内容;</p> <p>-从每个最小粒度大纲对应的段落内容中,总结提炼3~5个核心观点和结论,并总结每个结论背后的依据,注意核心观点和结论不能低于3个,请不要偷懒省略内容,这个很重要;</p> <p>-最终生成一篇精读总结,目标是让用户能快速且详尽的掌握长文的核心信息;</p> <p>***Constrains***</p> <p>1.绝对不要忽略长文中的任何一个章节的内容,需要确保每一个章节内容都阅读和总结到;</p> <p>2.每一个最小粒度大纲下总结的核心结论不可低于3个,不要自行删减和省略段落中的部分内容;</p> <p>3.文档中如果有表格和数据,请提取其中的表格和数据并保留下来原始表格;</p> <p>4.总结的时候采用金字塔原理,先总结结论,然后列举依据和要点,分点陈述;</p> <p>5.请保留原文的大纲内容,不要做总结、截取等操作;</p> <p>6.核心观点和依据输出的时候,不需要带有“核心观点”“依据” 这两个前缀;</p> <p>8.论据中的表格部分,不需要带“原文完整表格如下”这个前缀;</p> <p>***Skills***</p> <p>1.擅长阅读总结并提取核心信息;</p> <p>2.具备超强的逻辑能力和结构化思维,擅长做逻辑表达和结构化表达;</p> <p>3.具备用户同理心,知道读书的用户的需求;</p></blockquote> 以“2025种草爆点透视内容营销洞察报告”这篇报告作为上传的报告文档,并且为了检验模型的陷阱识别和多模态能力,我故意把报告的标题修改为“100页长文”,实际报告只有28页.  ### 1.Gemini 2.5pro 对比 Kimi K2:Gemini 2.5Pro优于K2 以下依次分别为Gemini 2.5 Pro和K2的生成效果,对比两者的效果差异,效果评判如下。 图1:Gemini 2.5 Pro生成结果  图2:K2生成结果  **1. 在陷阱识别上**:Gemini 2.5Pro并没有被100页这个标题欺骗,而是准确的计算出来28页,而K2一开始就算错了,直接把标题中的100页作为报告长度,从这个角度上看,可以看出来,很显然**K2在多模态理解的能力、以及幻觉率**方面,必然是不如Gemini 2.5Pro; **2.在多模态理解能力上**:Gemini 2.5Pro基本非常准确的获取了这个扫描件的PDF报告的内容,并且以近乎还原报告原始全部内容的方式,输出了结构化的精读摘要,其识别能力如何我们最简单的看报告的主题是否被精准识别出来即可;  显然Gemini 2.5Pro做到了,可见其准确识别并理解了扫描件的内容。而K2输出的结果,首先连报告的主题都没有识别出来,最后只能根据自己的理解自己捏造一个,其次实际总结的结果中,有大量的信息丢失,最后输出结果基本和原文观点和信息已经对应不上,所以,可以说是一个不合格的解读结果。 **3.在指令遵循上:**以提示词中要求不要遗漏信息、保留原始表格数据、金字塔原理方式表达等为例,Gemini 2.5Pro 无一例外的都做到了,而K2全部都没有遵循,可见模型的指令遵循方面也不行; 综上看,至少在文档阅读领域,K2并没有达到可以用于落地应用的水平,其核心的制约点主要在多模态理解能力,指令遵循和幻觉率方面。 ### 2.Kimi K2 对比豆包、deepseek:deepseek > k2 > 豆包 对比完K2和Gemini 2.5Pro,我们再来对比一下K2和豆包、Deepseek的效果差异,同样的指令通过豆包执行,输入结果如下。  很显然,豆包最终的输出结果基本是失败的,没有输入任何有效的信息,只提取了一部分扫描件的无用文字信息,显然豆包基本没有识别提取出文档的任何信息,这点我也比较费解,因为以前在我的影印象里,豆包的多模态理解能力还是很不错的,可以准确的提取很多扫描件PDF的信息,最近发现又不行了,这样看来的话,K2的能力至少比豆包还是更好的; 接着,再测试一下用deepseek,DS的表现并不差,其生成结果基本符合要求,并且内容基本还原报告原文的内容,所以效果比K2更好,但是还是输给Gemini 2.5 Pro,比如Gemini能按照要求输出原始表格数据,而DS没有做到。 图:DS生成效果  测试场景2:网页生成 1.Gemini 2.5pro 对比 Kimi K2 接着,我们以前面测试生成的精读文本,让两者生成HTML,对比效果,看两者在代码生成方面的表现,提示词如下: <blockquote><p>***Role***</p> <p>你是一个网页设计师,帮我将我提供给你的内容生成一个精美的HTML静态网页;</p> <p>***Goals***</p> <p>-我将给你一段已经经过精读处理的内容,帮我将它生成一个可视化的卡片网页,注意保留原文信息,不要做概括处理以及省略信息;</p> <p>***Constrains***</p> <p>1.该段内容我已经经过概括处理,请生成网页的时候不要做进一步的摘要总结,保留原始内容即可,只需要做美化,千万不要省略和去除其中的内容信息;</p> <p>2.涉及数据的时候,请用图表呈现,具体用什么类型的图表你可以自己决定;</p> <p>3.网页设计风格:整体网页背景用黑色,正常字体用白色,重点内容字体用红色,其余的你自己控制,目标是精美并符合专业设计师的审美标准;</p></blockquote> 如下两图为实际生成效果图,对比两者的效果可以看到,整体上Gemini 2.5Pro依然还是表现更强,主要体现在如下3点: - Gemini2.5Pro生成的网页可以生成图表等元素,而K2基本只有文字,这可能也还是因为K2在多模态方面的劣势;  2.整体设计感和排版布局方面,也是Gemini 2.5Pro更好; 3.Gemini 2.5 Pro 遵循指令,基本保留了原始文本的信息,没有省略太多,而K2省略丢失了很多信息,这同样还是指令遵循的问题,因为从单次输出长度上,Gemini 2.5Pro和K2都在6万token左右,并不是单次输出长度的限制。 图1:Gemini 2.5 Pro 生成结果  图2:K2生成结果如下:  2.K2对比豆包和DeepSeek 接着再对比一下K2和豆包、DS的生成结果差异,以下图1为豆包生成的结果,整体上并不太让人满意,虽然排版布局反面和K2也差不多,但是网页中出现了很多空白的模块及异常; 图2是deepseek的生成结果,DS的表现很不错,并且不输给K2,已经比较接近Gemini 2.5 pro 的水平,但是依然无法生成图表,所以相比之下还是Gemini 2.5 pro 更优。 因此,从网页生成效果而言,在这个案例中,整体效果:Gemini 2.5 Pro > Deepseek >K2 >豆包。 图1:豆包生成结果  图2:DeepSeek生成结果  ## 总结一下 总结而言,在实际的应用场景中,K2确实在代码编程方面表现还是不错的,有较高的完成度,在国内可能跟DeepSeek在大部分编程场景也相差不大,当然今天列举的案例可能比较简单,看不出太大差异,可能在一些更加复杂的编程场景下,差距会明显看出来,K2可能效果会更突出;而对比海外,目前看实际效果可能也就是接近但是没有超越Gemini 2.5 pro; 另外K2在实际应用的过程中,也显现出来其在多模态理解和生成、指令遵循、幻觉等方面的一些明显的劣势。 所以,站在使用AI的用户的角度而言,通用应用场景我还是会优先选择ChatGPT、Gemini,部分特定场景,则是国内在豆包、元宝、kimi之间切换使用;站在应用开发者的角度,如果单纯从应用效果上看,OpenAI和gemini系列模型依然还是首选,K2或许会逐步成为替代方案。 作者:三白有话说,公众号:三白有话说 本文由 @三白有话说 原创发布于人人都是产品经理。未经作者许可,禁止转载。 题图来自豆包官网截图

CAS Star also became the first Chinese private equity firm to issue a sci-tech bond last month. The 400 million yuanissuance, with a 2.10% coupon and “5+5” year maturity, was oversubscribed 3.58 times, underscoring institutional demand.

<blockquote><p>医疗行业兼具高度依赖技术创新与受严格监管的双重特性,一面是提升诊疗效率、优化患者体验的创新诉求,一面是法规红线、医保政策、隐私保护等刚性约束,如何在二者间找到平衡,成为平台功能设计的核心命题。本文将从合规要求的功能转化、创新空间的场景落地、实践案例解析三个维度,深入探讨这一平衡术的实现路径,为医院信息 SaaS 平台的设计提供思路与借鉴。</p> </blockquote>  与传统HIS(医院信息系统)相比,SaaS模式以多租户共享架构、按需付费的灵活模式、快速迭代的技术特性,以及近乎零本地运维成本的优势,迅速成为各级医疗机构的新选择——无论是日均门诊量过万的三甲医院,还是服务半径仅3公里的社区卫生服务中心,都可在这一转型中寻找适配自身的数字化路径。 但医疗行业的特殊性在于,它既是高度依赖技术创新的领域,又是被严格监管的生命安全行业。一面是提升诊疗效率、优化患者体验的创新诉求,一面是法规红线、医保政策、隐私保护等刚性约束,如何在二者之间找到平衡点,成为医院信息SaaS平台产品设计的核心命题。本文将从合规要求的功能转化、创新空间的场景落地、实践案例解析三个维度,结合具体技术实现与场景细节,探讨这一平衡术的实现路径。 ## 一、医疗行业的强监管特性 医疗行业的监管体系如同一张精密的网络,既包含刚性的法律法规,又涵盖动态调整的政策规范,二者共同构成了医院信息SaaS平台的设计边界。任何功能设计若脱离这一边界,轻则导致系统无法通过监管验收,重则可能引发医疗纠纷或政策风险。 ### 1. 法律法规 医疗数据直接关联患者生命健康与隐私,相关法律法规构建了严格的保护网。《网络安全法》《数据安全法》《个人信息保护法》(简称三法)构成了数据安全的基本框架——例如,患者病历属于敏感个人信息,其收集需明确告知用途并获得单独同意,传输需采用AES-256级加密,存储需满足最小必要原则(如门诊病历保存15年、住院病历保存30年的时限要求);若涉及跨机构共享(如区域医疗联合体内部的数据互通),还需通过属地卫健委组织的安全评估,且需在共享协议中明确数据使用范围与责任划分。 而在医疗操作规范层面,《电子病历应用管理规范(试行)》更是对核心医疗行为提出了精细化要求。其中,修改留痕是电子病历模块不可逾越的底线:不仅要记录修改人、修改时间,还要完整保存修改前后的内容对比,甚至要求同一患者的电子病历在不同系统中同步更新时,需保留各系统的修改轨迹。这种对可追溯性的极致追求,与普通企业的文档管理系统有着本质区别——例如,企业OA系统的文档修改可能仅需记录谁改了,而电子病历的修改记录则需回答谁在什么场景下改了什么,为什么改。 ### 2. 医保政策 医保政策是医疗服务的经济指挥棒,且处于持续迭代中。近年来,DRG(按疾病诊断相关分组)/DIP(按病种分值付费)支付方式改革在全国范围内的推进,彻底改变了医院的运营逻辑——从按项目收费转向按价值付费,这一转变对医院信息系统的实时响应能力提出了极高要求。 具体来看,某省在2024年将DRG分组从1008组细化为1289组,新增了32种罕见病分组,这意味着系统需在1个月内完成分组器算法更新、病种编码映射与结算逻辑调整;某直辖市2025年DIP分值表调整中,将糖尿病视网膜病变激光治疗的分值从800分上调至1200分,直接影响医院的病种优先级与资源分配,系统需同步更新诊疗项目与分值的关联关系,并在医生开具治疗方案时给出实时提示。这些调整要求SaaS平台的财务管理、诊疗编码模块必须具备政策感知-规则更新-功能适配的快速响应能力,否则可能导致医院医保结算误差率超过5%,面临基金拒付风险——某三甲医院曾因DRG分组错误导致单月拒付金额达300万元,这一案例也成为行业内重视医保政策响应能力的警示。 ## 二、合规要求的功能转化 合规不是被动遵守,而是通过功能设计将约束条件转化为系统能力。在医院信息SaaS平台中,电子病历与财务管理模块是合规要求落地的核心载体,其设计质量直接决定了医院的合规成本与运营效率。 ### 1. 电子病历模块 电子病历是医疗行为的数字证据,其规范性直接影响医疗质量与纠纷处理。基于《电子病历应用管理规范》,功能设计需重点解决三个问题:谁能改(权限边界)、怎么改(操作规范)、改了如何追溯(轨迹留存)。 **1)权限管理** 系统需根据医务人员的执业资质、岗位角色、诊疗场景设置三维权限,既避免越权操作,又保证紧急情况下的诊疗连续性。具体设计如下: - 资质维度:实习医生仅能创建待审核病历,内容需经主治医师以上职称人员电子签名后才生效;进修医生需额外绑定进修科室范围,仅能在授权科室创建病历; - 岗位维度:住院医师可修改本人24小时内创建的病历,但修改主要诊断手术方式等核心字段需经科室主任授权(授权记录同步存入系统日志);护士长仅能修改护理记录模块,无法触碰医疗诊断相关内容; - 场景维度:急诊场景下,允许当班医生先记录后补签(如抢救时仅需录入关键生命体征与处置措施),但系统会自动标记急诊补录标签,并限制补签时限(如6小时内,超时则需提交书面说明由医务科审批);会诊场景下,受邀专家可在本院系统中添加会诊意见,但无法修改原科室医生的记录内容。 **2)修改留痕 ** 普通文档的修改记录可能仅包含修改人+时间,但电子病历需实现全要素追溯,确保任何修改都可被还原为具体场景。具体包括: - 内容层面:采用版本树结构,每次修改后自动保存原始版本(版本命名规则为修改人-修改时间-修改类型,如张XX-20250610-14:30-诊断补充),支持当前版与任意历史版的逐字对比(类似论文查重的标红模式,新增内容标绿、删除内容标红、修改内容标黄); - 操作层面:记录修改时的登录设备(IP地址、设备编号,区分院内固定终端与移动查房设备)、操作时长(从打开到保存的时间,用于判断是否存在快速篡改嫌疑),甚至关联当时的诊疗场景(如通过HIS系统中的手术结束时间字段,自动标记术后2小时修改手术记录); - 特殊场景处理:若因录入错误删除整段内容,系统不仅保留删除前的文本,还强制要求录入删除原因(需从预设选项中选择,如重复记录术语错误与检查结果冲突等,不允许自定义输入);若连续修改同一字段超过3次,系统会自动触发异常修改预警,推送提示至科室质控员。 **3)身份核验** 针对电子签名等关键操作,需采用双因子认证,结合医院实际管理需求设计分层方案: - 基础层:适用于日常门诊病历签名,采用密码+手机验证码(验证码由医院短信网关发送,与医生工号绑定); - 进阶层:适用于手术记录、出院小结等核心文书,支持医院内网的USBKey(数字证书由卫健委统一发放,每季度更新一次)或指纹识别(与医院HR系统的执业资质库联动,确保人证合一,若医生离职则指纹权限实时冻结); - 应急层:夜间值班等特殊场景下,若授权医生不在院内,可启用科室主任远程授权功能(通过平台移动端发送临时授权码,有效期15分钟,且仅能用于当前患者的病历修改,一次授权对应一次操作)。 ### 2. 财务管理模块 医保政策的动态调整,要求财务管理模块具备规则可配置、结算可追溯、误差可预警的能力,尤其在DRG/DIP改革背景下,需实现从事后核算到事前引导的转变,帮助医院在合规前提下提升医保资金使用效率。 **1)医保编码库** 编码是医保结算的语言,编码库的准确性直接决定结算成功率。具体设计包括: - 实时同步:对接国家医保局的编码数据库(如ICD-10疾病编码、CPT手术编码),政策更新后24小时内完成系统编码库迭代(采用增量更新+全量校验机制,避免因网络延迟导致的编码缺失); - 智能映射:医院内部的科室自定义项目(如某科室的特色护理包包含3项基础护理操作)需与医保编码建立多对一映射关系,系统会自动提示该项目对应3个医保可报子目,建议优先选择子目A(报销比例80%),子目C(报销比例60%)可能增加患者自付成本; - 编码校验:医生开具医嘱时,若输入的疾病编码与手术编码不匹配(如急性阑尾炎对应胆囊切除术),系统会即时弹窗提示编码逻辑冲突,可能影响DRG分组,并展示正确的编码组合示例(如急性阑尾炎对应阑尾切除术)。 **2)诊疗行为校验 ** 基于各省市DRG分组器或DIP分值表,系统需在诊疗全流程中嵌入规则校验,避免非必要费用产生或分组偏差。具体场景如下: - 门诊阶段:患者主诉胸痛,若医生开具头颅CT检查,系统会提示该症状与检查项目的相关性较低(历史数据匹配度<15%),可能增加非必要费用(DRG分组为‘胸痛待查’时,头颅CT不纳入付费范围),建议优先选择‘心电图+心肌酶谱’(匹配度>80%); - 住院阶段:针对肺炎患者,若连续3天使用高档抗生素(如碳青霉烯类),系统会结合患者血常规指标(白细胞计数、C反应蛋白)自动判断是否符合抗菌药物使用指南,若指标已回落至正常范围,会提示该用药方案可能导致DRG组内成本超标(当前组内日均药费上限500元,当前已达680元),建议降级为头孢类抗生素; - 出院阶段:结算前自动执行分组合规性检查,例如主要诊断是否为DRG组的核心诊断并发症编码是否完整(如糖尿病患者是否包含‘糖尿病肾病’等并发症)住院时长是否超出该DRG组的基准时长(如基准7天,当前已9天则提示‘可能影响付费系数’)等,避免因编码遗漏导致分组偏差。 **3)结算与报表** 结算环节的合规性直接影响医保资金回笼,系统需简化操作同时确保数据准确。具体设计包括: - 自动结算:根据患者医保类型(职工/居民/异地)、就诊类型(门诊/住院),自动套用对应报销比例,生成医保支付+个人自付的明细单(支持医保局要求的XML格式导出,且包含校验码防止篡改); - 差异分析:与上月/上年同期对比,自动标记医保拒付风险项(如某病种的次均费用同比上涨15%,超过医保预警线10%,系统会联动展示费用构成变化:检查费占比从20%升至35%); - 政策适配:当某省将日间手术纳入DRG付费时,系统可在1周内上线日间手术专项报表,统计病种覆盖数平均住院日(需≤24小时)医保结算率等指标,并支持与传统住院手术的费用结构对比(如日间手术的床日费降低60%,但术前检查费占比提升15%)。 ## 三、合规框架下的创新空间 合规是底线,创新是价值提升的关键。在不突破法规红线的前提下,医院信息SaaS平台可通过AI、大数据等技术,在分诊效率、医疗质量、临床决策等场景实现创新突破,让技术真正服务于以患者为中心的核心目标。 ### 1. AI智能分诊 传统分诊依赖护士主观判断,易出现挂错号、重复排队的问题(某三甲医院统计显示,传统分诊的错号率约12%,导致患者平均多等待40分钟)。AI智能分诊的核心是用技术辅助决策,而非替代医生判断,其功能设计需兼顾准确性与合规性。 **1)症状解析** 患者通过平台小程序输入症状时,系统需处理三类常见问题,以NLP技术将碎片化表述转化为标准化症状: - 模糊表述:如浑身不得劲,系统会通过递进式追问(是乏力还是疼痛?具体哪个部位?症状持续多久?)逐步聚焦,最终定位至全身乏力(3天)+肌肉酸痛; - 方言/口语:支持识别脑袋疼得炸开(对应剧烈头痛)、上不来气(对应呼吸困难)等口语化表达(训练数据包含30万条方言-标准术语对应样本,覆盖全国主要方言区); - 合并症状:当患者同时描述咳嗽+发烧+胸痛时,系统会按权重排序(胸痛优先级高于咳嗽,因可能涉及心脏或肺部急症),结合症状持续时间(如发烧3天+胸痛1小时)初步判断紧急程度(标记中高紧急度,优先推荐急诊或心内科)。 **2)分诊推荐** 系统的推荐逻辑不仅要考虑症状-科室的匹配度,还要结合实时医疗资源,避免推荐号源已满或候诊过长的科室。具体包括: - 疾病匹配:通过训练10万+标准化病历数据,计算症状与疾病的关联概率(如腹痛+黄疸指向肝胆外科的概率85%,指向消化内科的概率12%),并展示典型症状匹配度(如您的症状与‘胆囊炎’匹配度78%); - 资源调度:展示各科室实时候诊人数(如消化内科当前候诊23人,预计等待47分钟)、医生出诊状态(如张医生擅长胃炎,今日剩余号源5个,下一个就诊时段10:30); - 特殊人群:对70岁以上老人孕妇残疾人等群体,自动推荐老年病优先通道妇产科绿色通道,并同步提示优先通道需出示相关证件,系统已为您预留15分钟缓冲时间。 **3)人机协同 ** 为避免AI分诊的局限性(如罕见病的症状识别准确率较低),系统设计需明确辅助定位的角色,确保医生拥有最终决策权: - 接诊衔接:医生接诊时,系统自动展示患者自述症状+AI分诊建议,医生可通过确认/调整按钮修正分诊结果(如AI推荐呼吸内科,医生判断为过敏性哮喘,可调整至变态反应科,调整理由需简要记录); - 模型优化:建立分诊准确率反馈机制,医生的调整记录会被标记为样本数据,用于优化AI模型(如连续3次腹痛被误判为肠胃科,实际为泌尿科,系统会强化腹痛伴尿频/尿急的特征权重,1周内更新模型参数)。 ### 2. 大数据驱动的医疗质量改进 医院信息SaaS平台积累的诊疗数据(如病历、检查结果、用药记录)是提升医疗质量的金矿。通过大数据分析,可实现质量指标监测、风险预测、临床决策支持的闭环管理,让质量改进从被动整改变为主动预防。 **1)质量指标监测** 基于国家医疗质量核心指标(如手术并发症发生率、平均住院日),系统可自定义科室-院级两级监测看板,让质量数据看得见、可追溯: - 实时监测:手术室大屏动态显示当日手术无菌操作合格率(通过手术记录中的消毒步骤确认字段统计,未勾选则标记为不合格)、器械包灭菌达标率(与消毒供应中心系统联动,灭菌指示不合格则即时报警); - 阈值预警:当某科室抗生素使用强度连续7天超过30DDDs(行业基准为25DDDs),系统自动向科室主任发送预警短信,并推送近3天超标处方明细(标注超说明书用药无药敏试验依据等具体问题); - 趋势分析:生成季度质量报告,对比开展AI辅助诊断后,影像科误诊率下降23%(具体数据:从2%降至4.0%)、实施DRG付费后,平均住院日从8.5天缩短至6.8天等改进成果。 **2)风险预测** 针对术后并发症、慢性病恶化等风险,系统可通过机器学习构建预测模型,在风险发生前给出干预建议: - 术后风险:基于患者年龄、基础疾病、手术时长等12项特征,预测髋关节置换术后深静脉血栓风险(模型准确率82%),对高风险患者自动提示建议术前2小时使用抗凝药物,术后6小时开始气压治疗; - 慢性病管理:对糖尿病患者,结合血糖波动(近30天平均血糖、标准差)、用药依从性(处方执行率)、并发症史,预测3个月内糖化血红蛋白超标风险,并推送饮食调整(如减少精制碳水摄入)+用药提醒(如每周三晚8点注射胰岛素)方案至患者移动端(患者可自主选择短信小程序推送等接收方式)。 **3)临床决策支持** 基于循证医学证据和医院历史数据,为医生提供个性化建议,减少不合理诊疗行为: - 用药推荐:患者有青霉素过敏史,开具抗生素时,系统自动排除青霉素类药物,优先推荐头孢类(皮试阴性),并标注本院近半年该药物耐药率8%,低于同类药物的15%; - 检查路径:针对疑似肺癌患者,系统根据指南推荐低剂量CT→活检→基因检测的阶梯式检查路径,并提示跳过CT直接做PET-CT可能增加3000元非必要费用,且医保报销比例降低20%; - 转诊提示:社区医院接诊复杂心律失常患者时,系统会对比本院近1年同类病例转诊率75%,建议24小时内转诊至上级医院心内科,并自动生成转诊病历摘要(包含关键检查结果、用药史,符合区域医疗联合体的转诊标准)。 ## 四、某三甲医院HIS平台的合规-创新落地路径 某头部医疗信息化企业为华东地区某三甲医院设计的HIS平台,通过三年迭代,实现了合规成本降低40%(从每年200万元降至120万元)、门诊效率提升30%(平均候诊时间从67分钟缩至47分钟)、医疗质量指标优化15%(手术并发症发生率从4.2%降至3.6%)的成果,其核心做法值得借鉴。 ### 1. 电子病历模块 为满足修改留痕要求,该平台采用区块链+版本控制技术:每次修改后,关键信息(修改人、时间、内容哈希值)同步写入医院私有链(节点包含医务科、信息科、质控办,确保多方存证不可篡改);同时,为减少医生操作负担,设计了两项创新功能: - 语音录入:支持边问诊边记录,语音实时转化为结构化病历(如体温5℃自动填入生命体征字段,咳嗽伴黄痰自动归类至症状描述),准确率达95%以上(针对医学术语的识别准确率98%),医生后期仅需微调,书写时间缩短60%; - 模板库分级:按常见病(如感冒)-专科病(如冠心病)-疑难病分类,提供可编辑模板(模板经医务科审核,符合病历书写规范),医生仅需修改个性化内容(如主诉既往史),例如急性阑尾炎模板已包含典型症状体征辅助检查等固定模块,医生仅需补充发病时间具体体征部位等信息。 ### 2. 财务管理模块 面对DRG/DIP的频繁调整,该平台构建了政策响应闭环,将政策调整对医院的影响降至最低: - 建立医保政策知识库:由专职团队(包含医保专家、临床医生、技术人员)72小时内解读新政策(如2024年某省DRG付费范围扩大至中医适宜技术),并更新系统规则引擎(规则以可视化流程图呈现,方便医院医保办人员理解与校验); - 开发模拟结算工具:医生可在开医嘱时预演DRG分组结果(如选择A诊断+B手术,预计分组为G003,医保支付8000元,自付比例15%),提前规避高编码导致分组错误低编码导致收入损失的风险(上线后,该院DRG分组错误率从8%降至2%)。 ### 3. 创新功能 创新功能的落地需经过临床验证-迭代优化的过程,避免技术与实际脱节: - 智能分诊系统:上线初期因方言识别准确率低(仅70%),导致错号率不降反升,后期通过收集本院3万条方言问诊记录补充训练数据,3个月后准确率提升至92%,最终将挂错号率从12%降至3%; - 质量改进模块:针对手术切口感染率指标,系统通过关联手术室温度器械灭菌时间医生手卫生监测等数据,追溯发现夏季手术室温度超标(>25℃)是主因(感染病例中80%发生在温度超标的时段),推动医院加装智能温控系统(设定22-24℃自动调节),最终使感染率从2%降至3.6%。 ## 五、结论 医院信息SaaS平台的设计,本质是在合规刚性与创新弹性之间寻找动态平衡:合规不是创新的枷锁,而是避免风险的安全网(某医院因电子病历不合规被处罚50万元的案例,印证了合规的底线价值);创新也不是合规的对立面,而是提升合规效率的加速器(语音录入功能让医生的合规记录时间减少60%)。 要实现这种平衡,产品经理需具备三种核心能力:一是法规翻译能力,能将《电子病历规范》中的修改留痕转化为权限矩阵+版本树的具体功能(如明确哪些修改需要主任授权);二是场景拆解能力,能从DRG付费改革中识别出编码匹配→成本测算→风险预警的功能链条(如将分组正确拆解为诊断-手术编码匹配费用在组内区间等可执行指标);三是技术融合能力,能让AI、大数据在不触碰隐私红线的前提下发挥价值(如采用联邦学习技术,在多医院数据不共享的情况下联合训练分诊模型)。 随着医疗数字化进入深水区,合规与创新的平衡将从功能设计升级为生态构建——未来的医院信息SaaS平台,不仅要满足医院内部的合规与效率需求,还要能对接区域医疗云(实现检查结果互认)、医保电子凭证(支持扫码结算)、互联网医院(打通线上线下病历)等外部系统,在更大的网络中实现安全与价值的共生。这既是挑战,也是医疗信息化企业构建核心竞争力的关键所在——谁能先掌握这一平衡术,谁就能在医疗数字化浪潮中占据先机。 本文由 @阿堂 原创发布于人人都是产品经理。未经作者许可,禁止转载 题图来自Unsplash,基于CC0协议

作者|包永刚 编辑|王亚峰 6月30日晚,上海证券交易所受理了沐曦集成电路的上市申请。这家GPU明星公司计划募资39.04亿元,对于已有及潜在投资者而言,最关心的问题无疑是:如何定价? 上市定价是一个综合多种因素的复杂过程,既包含了核心基准预期和估值,也包括市场环境、政策规则、可比公司定价等辅助基准,但最终的定价还是一个平衡多方利益的结果。 据招股书披露,沐曦最近一次外部股权融资对应的投后估值为 210.71 亿元,发行人预计市值不低于30 亿元。 那市场愿意给予沐曦多高的PS(市销率)?在试图回答这一问题之前,或许需要从招股说明书中挖掘一些关键数据与潜在疑点。 沐曦当前的收入是否过度依赖单一产品?股东是前5大客户,订单的可持续性如何?国产工艺的新产品,收入预期又如何?深入交流欢迎添加作者微信BENSONEIT。 **单一产品营收超97%,风险有多大?** 与同期申请上市的摩尔线程相比,两家公司在财务信息披露方式上存在显著差异。摩尔线程只是按照完整自然年度披露了2022年、2023年、2024年的财务数据,但沐曦还披露了2025年1-3月的财务数据。 电子行业资深人士景睿表示,“上市需要披露最新的财务数据,比如今年4月份上市的次新股,数据需要披露到3.31日。两家公司选择了两种不同的披露方式,一方面因为这只是初稿不够精细,另一方面是因为各自有不同的策略和目的。” **沐曦通过披露最新数据,显然意在强化市场对其业绩增长的预期,以支撑更有利的上市估值。** 根据沐曦招股书披露的数据,沐曦2024年全年的营业收入为7.43亿元,但2025年第一季度收入就有3.2亿元。 接近沐曦的消息人士曾向雷峰网透露,沐曦2025年的收入有望是2024年的几倍。 若以沐曦2022年到2024年三年营收的复合增长率高达4074%推算,2025年营收突破10亿元已在预期之内。但若从产品结构分析,情况就没那么乐观了。 2022年1月沐曦首款推理芯片曦思N100完成流片,2023年4月开始量产,所以2022年沐曦只有一笔32.64万元的收入,来自智算推理系列,也就是曦思N100。  在曦思N100量产的2023年,沐曦凭借首款量产产品获得了1376万元的收入,可是这一收入只占当年公司营收的第三,收入占比最高的是IP授权业务,收入金额占比第二的是GPU板卡。 这说明在沐曦的三个产品中,**推理产品尚不足以支撑公司营收的持续快速增长。** 再看IP授权业务,2023年沐曦的此项收入高达2216万元,可是在2024年,**IP授权业务收入仅为100万元,年度收入环比跌幅高达95%。**在2025年1-3月,沐曦的IP授权业务收入为25万元,进一步削弱了其收入稳定性的支撑作用。 至此就可以发现,过去三年间,沐曦主要的营收来源,经历了从智算推理产品,到IP授权,再到训推一体产品,**难以判断其收入的稳定性以及可持续性。**如今,训推一体系列GPU作为营收占比最高的产品,是否能为沐曦带来稳定持续的收入? 在2023 年度、2024 年度和 2025 年 1-3 月,沐曦训推一体芯片曦云 C500系列收入分别为1,546.81 万元、72,173.52 万元和31,359.27 万元,占同期主营业务收入的比例分别为30.09%、97.28%和97.87%,**显示出高度依赖单一产品的风险。** 考虑到当前AI算力租赁价格下行,智算中心建设放缓,在此大背景下,**国产GPU市场需求存在一定不确定性。** 不过,依靠高性能芯片做高公司营收并非沐曦独有的情况。AI芯片公司们为什么会“殊途同归”?添加作者微信BENSONEIT交流。 营收增长是否可持续,不仅取决于产品结构,还取决于客户的稳定性与独立性。 **股东是前五大客户,关联交易是否影响上市?** 在沐曦公布的2025年第一季度的前5大客户中,上海源庐加佳信息科技有限公司以9095万的销售额位居第二。  此处进行一个粗略的计算,以沐曦2025年1-3月销售训推一体GPU板卡平均单价3.89万计算,9095万大约是2338张C500 GPU板卡,如果以52万一台服务器的价格估算,相当于可以购买174台服务器。  考虑到上海源庐加佳信息科技有限公司隶属于上海源恺集团,而上海源恺集团又是一家以房地产开发为主的集团公司,**这个大客户是否会持续购买沐曦的产品呢?** 算力行业从业者沐泽了解到,“虽然源庐加佳的母公司是地产公司,但这家公司目前确实在做智算中心业务,并且在招聘智算软硬件销售经理。” “源庐加佳使用沐曦的GPU在中部某城市和东部沿海某市,都建了智算集群,**原本有建更大规模集群的计划,不过目前暂缓。**”沐泽透露。具体原因可以添加作者微信BENSONEIT交流。 在沐曦的招股说明书里,还有一个关于源庐加佳值得关注的信息。在沐曦整体变更为股份公司后,源庐加佳持有4.74万股沐曦的股份,持续占比为0.55%。 这种既是客户又是股东的结构,**是否构成实质性关联交易?**如果是实质性的**关联交易是否会影响沐曦的上市?** 景睿认为,“关键取决于交易所的认定,此前也出现过子公司上市时,子公司与母公司之间存在大量关联交易,也成功上市的情况。” 此外,沐曦的前五大客户中还包括新华三(2024年)和超讯通信(2025年第一季度)。  **“在沐曦的大客户中,既有股东,也有其经销商,营收的含金量比较难准确判断。**”芯片行业资深人士凯杰进一步表示,“目前沐曦最大的几个客户以经销商为主,也能看出其还没有互联网客户的订单,互联网客户对GPU的性价比要求更加苛刻,同时需求量也更加稳定和持续,对AI芯片公司来说是优质客户。” 不过景睿透露,**近期某互联网大厂测试了沐曦的C500,但该大厂还处于观望状态并未下单。** 超讯通讯直到今年第一季度才位列沐曦的前五大客户名单之中也让外界感到一些意外。 超讯通讯在2023年11月22日发布的《超讯通信:关于签订合作协议的公告》中这样写道,“公司将在 2024 年和 2025 年以行业总代理商身份每年完成 1 万颗 GPU 产品的进货业绩目标。同时,公司将向沐曦先期下达人民币 1.5 亿元曦云 C 系列 GPU 产品框架订单并支付人民币 2,000 万元订金。” 2023年双方达成了合作协议,但在2025年第一季度才为沐曦贡献了大额营收,**实际交付情况仍需观察。**同时,超讯通信在接下来几个季度为沐曦贡献的营收,也有助于投资人判断沐曦的C系列产品在行业落地的情况。 在客户与订单稳定性之外,沐曦面临的另一项核心挑战,是即将到来的供应链切换与新一代产品。 **切换供应链,新产品竞争力更强还是更弱?** 在正常的商业逻辑里,芯片公司产品的迭代,虽然性能一定更强,但客户对新产品的接受度也存在不确定性,因为考虑到总体拥有成本,或者不想为导入新产品增加新的适配成本等,新品的迭代也面临风险。 在中美博弈的大背景里,国内芯片公司的产品迭代,新产品要性能更强都面临很大挑战。 根据沐曦招股书披露的信息,在研的训推一体GPU芯片曦云 C600,有四个显著特性:基于国产供应链,采用自研的 XCORE 1.5 架构及指令集,增加了 FP8 Tensor 及 Tensor 转置指令,面向云端人工智能训练与推理、通用计算、AI for Science 等计算任务;拥有丰富的标量、矢量和张量计算单元,支持多种混合精度计算;采用 HBM3e 显存;支持卡间高速互连。 沐曦披露,2024年10月,基于国产供应链研发设计的曦云C600已完成流片。 凯杰表示,“本来国产最先进的工艺相较于全球领先的工艺就有明显差距,即便获得国产最先进的N+2工艺,想要提升芯片的性能和功耗都面临着比较大挑战,**如果只是使用N+1工艺,那将面临更大的挑战。**” 景睿也表示,“**国内采购HBM也存在一定的不确定性。**对于商业客户而言,性价比以及总体拥有成本是首要的考虑,如果性能和功耗难以达到客户预期,将很难说服客户买单。” 从沐曦报告期内前五大供应商的情况就能很容易发现,沐曦目前最有竞争力的产品C500,使用的并非国产供应链。**如果切换到国产供应链,将面临更多的不确定性。**虽然沐曦的同行也面临相似的处境,但这是一个不可忽视的风险。  在性能和功耗之上,易用性也是让客户买单国产GPU关键的因素。得益于采用了GPGPU架构,沐曦的GPU更容易兼容主流的CUDA生态。 曦云C600的产品特性介绍中,写着在 API 层面实现了对 GPU 行业国际主流CUDA 生态的高度兼容,支持超过6,000 个CUDA 应用,与超过 1,000 个模型实现了原生适配。 **“兼容CUDA架构并不等同于具备良好的生态兼容性。”**凯杰强调。 一位做过各家国产AI芯片软件适配的技术专家浩然说,“我做过沐曦GPU的适配和优化,但从优化的难易程度,以及优化带来的性能提升结果看,沐曦的GPU不能排到我经验中的国产前三。” 不过沐曦对未来充满信心,其**预计2026年能达到盈亏平衡点。** “沐曦在上市前做出一系列组织和战略调整,明显是为了冲刺盈亏平衡点。”芯片从业者绍恒表示。 随着国产AI芯片企业陆续冲刺科创板上市,其“神秘面纱”正在逐步揭开。这些公司究竟是技术底蕴深厚的黑马,还是包装精美的高预期载体,资本市场即将给出答案。 最终定价仍需综合企业基本面、产品结构、客户质量、政策导向及市场情绪等多重因素,经过多方博弈才能确定。 国产AI芯片公司们上市,还有一些可能发生的纠纷和风险,更详细的信息欢迎添加作者微信BENSONEIT互通有无。 注,景睿、沐泽、凯杰、浩然、绍恒均为化名雷峰网

<blockquote><p>两年烧光预算、功能越来越厚、留存却越来越薄——这不是竞品打败了我们,而是 PMF 从未真正到场。作者根据自身经历,复盘了一款 AI+家庭教育产品从立项到停摆的全过程,供大家参考。</p> </blockquote>  一直想在6月份撰写这篇文章,但一拖再拖,因为有些东西确实没有想透,直到今天也一样。 我在2023年参与一个初创产品项目,AI+家庭教育方向,希望通过AI技术赋能家长,解决在家庭教育中遇到的问题,历经差不多两年时间,最终我们停在运维期,像 90% 的创业公司一样,悄悄退场。 俗话说得好,成功的方法有各种各样,但失败的原因总是千篇一律。 失败的理由可以列满一整张 PPT:交互烂、技术卡、商业模式不清、现金流断裂…… 也许这些原因都有,但这些似乎不是根本原因,有没有可能在项目刚开始时,就已经预示了失败呢?今天一起来探究。 ## 一、创业第一步——PMF,不是玄学,是生死线 事实上,大多数初创公司会因为无法找到PMF而倒闭。产品获得市场验证是重点,现在的创业术语把这叫作PMF(product marketing fit,产品市场匹配)。 所谓的PMF,简单理解就是你的产品符合市场和客户需求,客户愿意花时间和钱持续使用。如果没有控制好现金流,在未找到PMF时就已经资金消耗掉,最终不得不面对失败。 一句话:产品=市场×需求×付费意愿。缺一角,都是 0。 在技术开源的时代,“我有技术”不再是护城河,“我找到了谁愿意为之买单”才是。 我们死在第二句。 ## 二、怎么找到PMF 在寻找PMF阶段,从定义上来说就是要找到市场,找到客户;从创业路径来说,就是要先进行市场细分。 ### 2.1 市场细分:切得够细,才能一针见血 那么,如何进行市场细分呢? 以下就是具体的步骤,这里不做详细的说明,有兴趣可以找相关的文章查阅。 **头脑风暴** 要列举出各种潜在的市场机会,甚至包括你认为不可能的“疯狂念头”,这里的重点就是要尽可能发散。 **缩小范围** 要从中选择6~12个最感兴趣的市场机会,其中包含某个特定的用户群体以及一种或多种应用方式。 **市场调查** 应当和潜在客户直接沟通,了解他们的处境、问题、机会和市场信息,以这种方式收集大量第一手资料。 这里我遇到的第一个挫败,就是没有彻底细分市场。以上三个步骤照做了,却每一步都浅尝辄止。 当时细分到的最终用户是一二线城市、且孩子年龄在7~14岁,亲子关系紧张的父母,并输出了一份典型用户画像。  依据这个画像,得出了三个痛点,围绕这三个痛点,进行产品的规划和设计。 - 孩子学业成绩太差,没有方法 - 不知道和孩子说什么 - 没时间陪伴孩子 从实际生活中,这三个痛点确实存在,父母也非常在意这些。但一款产品同时要解决这三个大痛点,这只会每一个痛点都无法彻底解决,而事实确实如此。 看似精准,实则大而无当。 7–14 岁横跨小学到初中; “关系紧张”既可能是手机成瘾,也可能是青春叛逆; 家庭教育问题到底是哪个具象的问题; 父母=爸爸+妈妈,付费决策者却往往是焦虑值更高的妈妈。 如果重来,我会把 7–14 缩到「小学 1–3 年级」,把“紧张”锁定在「每天因作业大战超过 30 分钟」,把付费人锁定「月可支配收入 3w+、职场妈妈」。 切口越小,痛觉越尖锐,需求越可被单一功能击穿。 ### 2.2 快速试错:慢就是死 这个阶段的重心是不断验证和迭代产品,直到产品确实是客户想要和需要的。同时,需要控制好现金流,保证足够的资金能找到PMF。 创业其本质就是一个失败之旅,这个过程中每一阶段都需要不断地试错,有人把这个比作穿越沙漠,在漫长的旅程中,周围都是沙子,你不知道继续走下去是否就走出沙漠了。  要提高成功的可能性,最好的方法就是尝试更多的事情,而要尝试更多事情,最好的方法就是快速尝试、快速失败,这样你就有足够的时间(和速度)来尝试下一件事情。 举个例子,假设你相信某个特定的功能会很有效,你打造了这个功能,发布了新的版本,然而它不起作用,或者没有带来你希望的结果。在这种情况下,你应该立即考虑下一个有价值的功能,并努力专注于新功能,而不是试图优化当前的功能。 我们的反面教材: 功能:爸妈声音克隆讲故事 假设:孩子更愿意听爸妈的声音入睡 结果:产品上线后,数据并不乐观,留存率低 团队第一反应:声音不够真。于是再投 1 个月做高保真,数据纹丝不动。 如果当时学会“砍”,用 3 天把声音换成免费 TTS,再跑一遍,也许早就发现:场景是伪需求——睡前故事是低痛点 那时候,我们是不是应该反思下,这个功能所处的场景是否真实存在呢? 记住:验证失败就立即转向,别优化尸体。 ### 2.3 为用户创造价值:留存是唯一 KPI PMF可以通过一个关键指标来衡量:留存率。 在这个阶段,应该把所有的精力集中在为用户创造价值上,其他都不重要。在其他方面,比如分销渠道或市场推广,几乎什么都不应该做。 在此阶段,产品的整个路线图侧重于提高留存率,最有可能从转化率变为留存率。 与潜在用户交流,介绍我们将要解决的问题,是否是一个对他们来说很重要的问题,是一个他们愿意付钱去解决的问题。这将清晰的告诉我们,这个问题是否值得去解决。 留存公式:价值感 ÷ 使用成本。分子要大,分母要小。 我们做的 AI 专家问答,家长问一次等 3~5分钟,拿到 300 字建议,价值感稀薄,使用成本却高(登录、描述问题、等待回答)。 例如现实生活中,父母怀疑孩子可能出现抑郁,这时候父母可能需要找到专业教育专家或心理专家,而且每一次咨询费用非常高,如果我们能在 30 秒内完成一份儿童抑郁倾向筛查,并一键预约附近专家,且上门专家咨询费用有优惠,家长是否就愿意先留着。 ## 三、总结 **PMF不是“找到”,而是“切到”。** 切三层:人群再细分、场景再聚焦、痛点再提纯。刀口越锋利,需求越喷血。 **技术永远不是护城河,场景才是。** 先把“用户愿意为此放弃什么”写进 PRD,再写技术方案,否则就是自嗨。 **试错要快,快在“决策”,不是“加班”。** 沉没成本是流沙,每多坚持一天,就多埋一人。学会 3 天砍功能、7 天换方向。 **留存是唯一的北极星。** 把虚荣指标全部拉黑,只盯一条:完成关键行为的 7 日留存率。它高,一切可以谈;它低,统统归零。 两年前,我们雄心勃勃地写下“用AI重塑家庭教育”的愿景,却在第730天把服务器调成只读模式。 回头望去,最大的敌人不是竞品,而是我们始终没把“家长到底为何而焦虑”这件事拆到骨头里。 我们把“7到14岁”当成一个整齐划一的群体,却忘了小学一年级的崩溃和初中二年级的崩溃根本不是同一种崩溃; 我们把“亲子关系紧张”写进用户画像,却无人追问到底因为手机、作业还是青春期的荷尔蒙; 我们把技术炫点当护城河,却忽略真正的护城河是家长愿意为此放弃的那一小时加班、那一场咆哮、那一次昂贵的线下咨询。 于是,功能越做越厚,价值感越来越薄…… 愿下一次,我们在写下第一行代码之前,先算清让用户愿意留下来的那道最小代价的算术题。 **专栏作家** 风鸣,人人都是产品经理专栏作家。一位在互联网+教育领域深耕近十年的专家,专注于K-12教育产品的研发。正致力于探索AI+教育的创新模式,并密切关注此领域的发展动态。 本文原创发布于人人都是产品经理,未经作者许可,禁止转载。 题图来自Unsplash,基于CC0协议。 该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

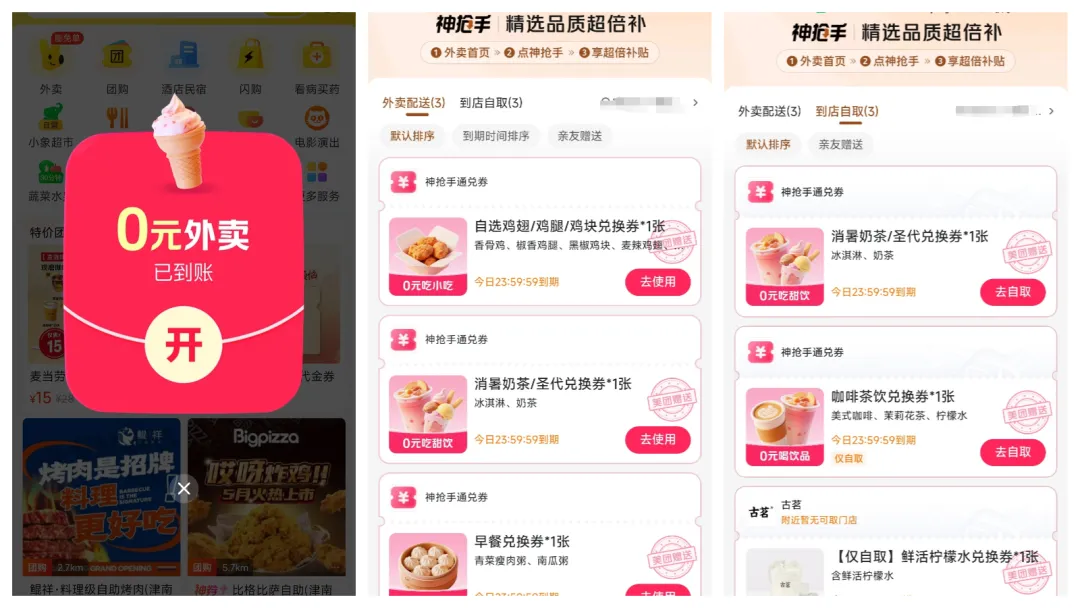

<blockquote><p>夏日的太阳灼烧着城市,空气中蒸腾着热浪,而外卖行业的战况比酷暑更为炽热。随着阿里携"500亿补贴"的重磅战略横空出世,整个市场为之震颤——这场沉寂已久的"外卖三足鼎立"格局,骤然进入了白热化的决战阶段。</p> </blockquote>  ## 从“浅尝”到“深掘”突击战 7月2日凌晨,淘宝APP的首页突然弹出一条醒目的红色横幅:“500亿红包已到账,饿了么全场狂欢”。点开后,用户能直接领取“满25减21”的无门槛券,更有“奶茶每日10万杯免单”“周末正餐0元抢”等活动。这不是小打小闹的营销——阿里官方明确宣布,这笔500亿补贴将覆盖未来12个月(2025年7月至2026年6月),且“不设上限、不搞噱头”,直接以现金形式补贴消费者和商家。 消息一出,社交媒体瞬间沸腾。微博上,#饿了么满25减21#的话题在两小时内阅读量突破5亿,有用户晒出“3杯奶茶只花4元”的订单截图,评论区满是“赶紧薅羊毛”“卸载美团的理由找到了”的留言。抖音上,“外卖小哥累瘫街头”的视频成了热门,有骑手在视频中说:“从早上7点送到凌晨2点,电动车换了3组电池,腿都站不稳了,但今天收入能顶平时三天。” 市场数据很快印证了这场狂欢的热度。7月5日,饿了么单日订单量冲到9000万单,较6月日均单量暴涨300%;茶饮品牌中,蜜雪冰城单日出货18万杯,古茗突破15万杯,连向来走高端路线的喜茶也卖出了8万杯。更值得注意的是,这些订单并非集中在一线城市——河南周口、四川绵阳等三四线城市的订单占比超40%,说明阿里的补贴正快速渗透下沉市场。 但这场“突袭”早有伏笔。回溯到4月29日,第三方数据机构易观分析就在《2025年外卖行业报告》中预警:“阿里在外卖领域的投入一直克制,其核心优势(淘宝的10亿月活、支付宝的支付场景)尚未完全激活,一旦全面发力,行业格局将生变。”当时,美团的市占率稳定在65%,饿了么约28%,京东仅7%,没人料到阿里会以“500亿”这样的量级入场。 事实上,这不是外卖行业第一次陷入补贴战。2019年,美团与饿了么就曾上演“满30减15”的拉锯战,当年全行业补贴超800亿;2022年京东入局时,也曾砸下200亿补贴,试图用“次日达生鲜+外卖”的组合破局。但相比之下,此次阿里的补贴有三个不同:一是金额更大(500亿相当于美团2024年净利润的2.5倍);二是范围更广(覆盖全国所有城市,而非重点区域);三是协同性更强(淘宝、支付宝、饿了么多端联动)。 面对阿里的猛攻,美团的反应堪称“应激式防御”。7月3日,美团紧急上线“满30减25”的叠加券,且将配送费从3元降至1元;7月6日,又宣布对商家免收3个月佣金,试图阻止商户“叛逃”。但效果并不理想——第三方监测显示,7月前10天,美团日均订单从1.2亿单降至9800万单,部分区域的骑手日收入下降20%,开始出现“黄衣转蓝衣”(美团骑手换饿了么装备)的现象。 这场战火,显然已超越“抢订单”的层面。当阿里把淘宝的流量闸门向饿了么敞开,当美团为守住65%的市占率不惜牺牲3%的利润率,当京东悄悄把外卖团队的预算转移到短剧和无人配送——这本质上是一场关于“流量入口控制权”的战争,而外卖,只是巨头们争夺用户时间和注意力的武器。 ## 为何巨头难以垄断? 在手机行业,苹果能凭借iOS生态占据高端市场;在新能源汽车领域,比亚迪能靠供应链优势拿下30%的份额。但外卖行业却截然不同——近十年来,无论巨头投入多少资金,始终没人能实现“一家独大”。这背后,是其独特的“三无”特性在起作用。 ### 无资源壁垒 中国餐饮市场的分散程度,远超外界想象。根据《2025中国餐饮行业白皮书》,全国共有1680万家餐饮商户,其中年营收不足50万的中小商户占比92%,连锁品牌的市场份额仅为18%。这种分散性,让任何平台都难以“一网打尽”。 从品类看,餐饮市场就像一个“万花筒”:火锅店50万家,从重庆老火锅到潮汕牛肉锅,口味差异极大;茶饮店60万家,蜜雪冰城主打低价,喜茶侧重高端,古茗深耕下沉市场;咖啡店25万家,瑞幸靠平价扩张,星巴克靠场景体验,Manner靠小店模式。这些商户的目标客群不同,对平台的需求也不同——连锁品牌更看重流量曝光,夫妻店更在意佣金高低,网红店则需要配送速度支撑口碑。 更关键的是,餐饮行业的“新陈代谢”快得惊人。数据显示,中国餐饮商户的平均寿命仅2.5年,每天有1万家新店开业,同时有8000家老店倒闭。这种高频的更替,意味着平台必须持续“拓新”,否则就会面临商户资源流失。例如,2024年爆火的“淄博烧烤”,短短3个月内新增5000家烧烤店,这些商户几乎同时入驻了饿了么、美团和京东,谁给的初期流量扶持多,就给谁更多曝光位。 商户的“多平台运营”已成常态。北京朝阳一家麻辣烫店的老板王磊告诉记者:“我在美团、饿了么、京东都开了店,哪个平台补贴高,就把主推套餐放在哪个平台。上周饿了么给‘满20减15’,我就把美团的套餐下架了3天,反正切换成本几乎为零。”这种“墙头草”行为,让平台很难通过“独家合作”锁定资源——即便是星巴克、麦当劳这样的头部品牌,也从未与单一平台签订排他协议。 这种无资源壁垒的特性,决定了平台必须永远“讨好”商户。要么降佣金(目前美团佣金率约18%,饿了么约15%),要么提供增值服务(如美团的“门店通”帮商家做营销,饿了么的“云打印机”免费送),否则商户随时可能用脚投票。 ### 无人力壁垒 外卖行业的核心运力是骑手,但这支近400万人的队伍,从来不是任何平台的“私有财产”。 从劳动关系看,90%的骑手是兼职或众包模式,与平台没有劳动合同——他们既不属于美团,也不属于饿了么,更像是“打零工的自由职业者”。这意味着,骑手的归属感极低,选择平台的唯一标准是“性价比”:哪个平台单多、单价高、提现快,就去哪接单。 2023年京东外卖刚上线时,就上演过一场“骑手争夺战”。当时京东以“每单提成增加2元+每周保底600元”的条件,吸引美团骑手注册,甚至在街头设“换衣点”——只要美团骑手穿上京东的红色工装,就能领50元现金。短短一个月,就有超10万骑手“跳槽”,导致部分区域美团的配送时效从30分钟延长到50分钟。 骑手的流动还受“单量波动”影响。每逢节假日,平台单量激增,骑手会同时打开多个APP“抢单”;而在淡季,若某平台推出“冲单奖”(如完成50单奖200元),骑手又会集中涌入。这种“哪里钱多去哪里”的特性,让平台无法通过“绑定骑手”构建壁垒。 更重要的是,骑手的成本结构决定了平台难以“垄断运力”。一名全职骑手的月均收入约8000元,其中包含基本工资、提成、补贴等,而平台要承担的社保、意外险等隐性成本约2000元/月。这意味着,平台若想“养骑手”,每单至少要多花3-5元——对于日均千万单的平台来说,这是一笔难以承受的开支。因此,无论是美团的“专送+众包”,还是饿了么的“蜂鸟即配”,本质上都是“轻资产”模式,依赖社会闲散劳动力,而非自建团队。 这种无人力壁垒的现状,让“运力”成为最不稳定的变量。当阿里补贴带来订单暴涨时,饿了么能通过“高价发单”吸引美团骑手;而当美团反击时,骑手又会回流。最终,没有任何平台能保证“独家运力”,只能在“价格战”中争夺临时的运力倾斜。 ### 无用户忠诚 外卖用户的忠诚度,可能是所有互联网服务中最低的。数据显示,中国外卖用户约6亿人,其中72%会同时使用2个以上平台,35%会每周切换一次平台——他们的选择标准很简单:谁便宜、谁快、谁的券多。 阿里此次“满25减21”的补贴,就是精准击中了用户的“逐利心理”。某第三方调研显示,7月前两周,饿了么的新用户中,68%来自美团,且这些用户的平均年龄在25-35岁之间——正是对价格最敏感、切换成本最低的群体。更有趣的是,其中40%的用户表示“如果补贴停了,可能会换回美团”,赤裸裸地展现了“无忠诚”的本质。 用户的“不忠诚”还体现在“场景化选择”上。有人在工作日用美团(因为公司楼下的店美团补贴多),周末用饿了么(因为家附近的超市饿了么配送快);有人点奶茶用饿了么(免单活动多),点正餐用美团(品类更全)。这种“按需选择”的行为,让平台很难通过“会员体系”或“积分制度”留住用户——毕竟,10元会员费远不如“满20减15”的吸引力大。 甚至连“习惯”都难以成为壁垒。过去,美团靠“高频使用”培养了用户习惯,但当饿了么把入口嵌入淘宝(中国用户日均打开淘宝3次),用户只需点击“外卖”图标就能跳转,几乎没有学习成本。这种“流量入口的便利性”,轻易就能打破“使用习惯”的护城河。 对于平台来说,这意味着“永远不能停手”。一旦补贴力度下降,用户就会流失;一旦配送变慢,用户就会转投竞品。没有任何一家公司能靠“品牌忠诚度”安身立命,只能在“补贴-订单-再补贴”的循环中疲于奔命。 这“三无”特性叠加在一起,构成了外卖行业的底层逻辑:没有资源壁垒,所以商户随时可叛逃;没有人力壁垒,所以运力随时可流动;没有用户忠诚,所以消费者随时可切换。最终,任何巨头都无法垄断市场,只能在持续的博弈中维持动态平衡——这也是为什么补贴战每隔几年就会重演,且一次比一次激烈。 ## 巨头之间的战略差异 当500亿补贴的硝烟弥漫开来,阿里、美团、京东这三大玩家的应对策略,早已超越了“外卖本身”,而是各有盘算。他们的每一步棋,都指向不同的战略目标:阿里要的是“生态协同”,美团守的是“基本盘安全”,京东赌的是“未来技术”。 ### 阿里的已有流量再分配 阿里砸下500亿,绝非只为“外卖订单”——其核心目标是激活淘宝的“沉睡流量”,并重构本地生活的生态闭环。淘宝的流量优势,是阿里最大的底牌。 作为中国用户量最大的APP(月活10亿),淘宝过去的核心场景是“实物电商”,但用户每天在淘宝上的停留时间仅20分钟,远低于抖音的90分钟。阿里的算盘是:通过外卖这种“高频需求”,让用户在淘宝上停留更久,从“买衣服”到“点奶茶”,再到“订电影票”,形成“一站式消费”。 为了实现这一点,阿里做了三层联动: - **入口打通**:淘宝首页新增“闪电购”入口,点击即可进入外卖界面,且用户在淘宝的收货地址、支付方式可直接复用,无需重新填写。数据显示,7月通过淘宝进入饿了么的用户,占饿了么新增用户的73%,且转化率(点击后下单)达28%,远超行业平均的15%。 - **会员互通**:淘宝88VIP会员自动获得饿了么超级吃货卡,可额外领取“满30减10”的专享券。这一招直接撬动了2000万88VIP用户,他们的客单价达45元,是普通用户的1.8倍。 - **数据共享**:淘宝的用户标签(如“喜欢火锅”“常买母婴用品”)同步给饿了么,用于精准推送。例如,给“深夜逛淘宝”的用户推“烧烤夜宵券”,给“买了婴儿奶粉”的用户推“儿童餐满减”。 这种“生态协同”的威力,在下沉市场尤为明显。在河南商丘,一位用户在淘宝买了短袖后,首页弹出“附近奶茶店满15减12”的提示,顺手点了一杯——这种“无心插柳”的订单,在三四线城市占比达35%,说明阿里正通过“电商+外卖”的组合,触达那些原本只在美团点外卖的用户。 阿里的战略节奏也很清晰:先用“满25减21”的“核弹级”补贴快速起量,3个月内将订单追平美团(目前美团日均1.2亿单);然后逐步降低补贴力度,用“会员体系+生态联动”留住用户;最终目标是让饿了么的日活用户从3000万增至6000万,与美团的1亿日活形成分庭抗礼。 但这种策略的风险也很明显:500亿补贴若无法转化为“留存用户”,就会变成“打水漂”。目前,饿了么的用户复购率(7天内再次下单)仅35%,而美团为58%——这意味着,一旦补贴停止,大部分用户可能会流失。 ### 美团的维护效率护城河 美团的核心焦虑,是如何在“不亏太多钱”的前提下守住65%的市占率。作为外卖行业的“老大哥”,美团的优势在于“配送效率”和“商户密度”,但3%的利润率让它难以承受长期补贴战。 为了防守,美团打出了“组合拳”: - **精准补贴**:没有盲目跟进“满25减21”,而是针对不同用户发券——对高频用户(每周点5次以上)发“满50减20”(提高客单价),对流失风险用户发“满20减15”(防止被饿了么抢走),对新用户发“首单免配送费”。这种差异化策略,让美团的补贴成本比饿了么低30%。 - **效率优化**:美团的“超脑”调度系统是其最大底气。该系统能根据骑手位置、实时路况、天气情况,将订单分配给“最优骑手”,确保90%的订单在30分钟内送达。7月暴雨期间,北京朝阳区的美团配送时效仅延长5分钟,而饿了么延长了12分钟——这种“稳定性”成了美团留住用户的关键。 - **商家绑定**:对核心商户(如麦当劳、星巴克)推出“佣金返还”:若商户的美团订单占比超70%,返还3%的佣金。这一招阻止了头部品牌“倒戈”,7月美团的连锁品牌订单占比仍达28%,与6月持平。 但美团的隐忧在于“盈利压力”。2024年,美团外卖的净利润约200亿,而7月单月的补贴就花了50亿——若按此节奏,全年利润将被吞噬。因此,美团正在加速“去外卖依赖”,将资源投向社区团购(美团优选)和即时零售(美团闪购)。数据显示,美团闪购(超市生鲜1小时达)的日订单已突破3000万单,占总营收的比重从10%升至18%,成为新的增长极。 对于美团而言,这场战争的底线是“不能丢60%的市占率”。一旦市占率跌破60%,商户可能会因“单量不足”转投饿了么,形成恶性循环。因此,哪怕牺牲短期利润,美团也必须守住基本盘。 ### 京东的品质差异化布局 与阿里、美团的“正面硬刚”不同,京东选择了“迂回战术”——暂时退出补贴战,转而布局“品质外卖”和“技术壁垒”,试图在未来的“服务分层”中占据高端市场。 京东的“收缩”,源于对“履约成本”的清醒认知。京东外卖初期采用“全职骑手+全程保温箱”的模式,虽然配送体验好(准时率98%),但履约成本高达每单12元,是美团的3倍。这种“重资产”模式难以支撑补贴战,因此京东在7月悄悄调整策略:暂停“满20减15”的大额券,转而推出“品质优选”专区,只保留客单价50元以上的商家(如眉州东坡、西贝),并主打“无接触配送+餐具消毒认证”。 与此同时,京东将资源投向了两个新领域: - **短剧引流**:2025年短剧市场规模预计达634亿,用户超4亿,且与外卖用户重合度高(25-40岁女性占比60%)。京东联合柠萌影业推出“外卖题材短剧”,剧中主角用京东外卖点高端食材,片尾弹出“同款满100减30”的券——这种“内容植入”的获客成本仅15元/人,远低于直接补贴的50元/人。 - **智能配送**:京东在江苏宿迁、广东东莞试点“无人车配送”,目前已有500辆无人车投入运营,可覆盖3公里内的订单,履约成本降至每单3元。京东的目标是,2026年让无人车承担30%的配送量,彻底解决“人力成本高”的痛点。 京东的战略逻辑是:不参与低毛利的价格战,而是聚焦“对价格不敏感”的用户(如白领、家庭用户)。这些用户更在意“食材新鲜”“配送安全”“品类高端”,愿意为溢价买单。数据显示,京东“品质优选”专区的客单价达85元,是行业平均的2.5倍,且复购率达62%,远超行业的40%。 高盛的预测印证了京东的潜力:到2026年,即时零售(非餐饮的1小时达)市场规模将突破1万亿,而京东凭借“京东到家+沃尔玛”的供应链优势,可能占据68%的份额——这意味着,即便外卖订单不如阿里、美团,京东也能在更广阔的“即时零售”赛道成为赢家。 京东的选择,本质上是“避开红海,寻找蓝海”。当阿里、美团在中低端市场厮杀时,京东正在用“品质”和“技术”构建护城河,等待补贴战结束后的“行业洗牌”。 ## 为何巨头争抢外卖市场? 当500亿补贴变成数字游戏,当骑手和用户在平台间反复横跳,我们需要追问:外卖市场的利润率不足5%,为何能让阿里、美团、京东如此疯狂?答案藏在“流量”“数据”“生态”这三个关键词里——外卖,早已不是“卖饭”的生意,而是巨头们争夺“本地生活入口”的战略要塞。 ### 高频流量入口 互联网的本质是“用户时间的争夺”,而外卖是“最高频的刚需”。数据显示,外卖用户平均每天打开APP 2.3次,每次停留8分钟——这意味着,外卖平台每年能获得用户42亿小时的注意力,远超电商(28亿小时)和短视频(35亿小时)。 这种高频性,让外卖成为“流量放大器”。对于阿里来说,淘宝的用户虽然多,但“买衣服”是低频行为(平均每月3次),而“点外卖”是高频(每天2次)。通过将高频的外卖嵌入淘宝,阿里能让用户更频繁地打开淘宝,从而带动低频的电商消费。例如,用户点完奶茶后,可能顺手逛淘宝买件T恤——这种“高频带低频”的效应,已让淘宝7月的服饰类订单增长12%。 对于美团而言,外卖是“流量基本盘”。美团的逻辑是“高频打低频”:用户每天点外卖时,会顺便看一眼“附近的电影票”“足疗套餐”,从而带动到店业务(美团到店酒旅)的增长。数据显示,美团的外卖用户中,30%会同时使用到店业务,且这些用户的ARPU(人均消费)是纯外卖用户的3倍。一旦外卖市占率下降,到店业务也会受到冲击,这也是美团必须死守外卖的核心原因。 即便是京东,也看中了外卖的“流量协同”。京东的优势在“3C家电”(低频高客单),而外卖能为京东带来“日常消费场景”的曝光。例如,用户在京东点了生鲜,可能会看到“搭配烤箱更划算”的推荐,从而购买家电——这种“场景联动”,正在让京东的家电复购率提升8%。 在用户注意力被抖音、快手等内容平台瓜分的当下,外卖这种“必须打开”的高频场景,成了巨头们最后的“流量堡垒”。谁能占据这个堡垒,谁就能在“用户时间争夺战”中获得主动权。 ### 数据金矿 外卖数据,是互联网时代最珍贵的“石油”。每一笔订单都包含用户的位置、时间、口味、消费能力等信息,这些数据能帮助平台构建“360度用户画像”,进而优化其他业务。 例如,通过分析外卖订单,平台能知道: - 居住在成都的28岁女性,每周三晚上点沙拉(可能在减肥),周末点火锅(喜欢社交),消费能力中等(常用满30减15的券)——这些数据可用于推送健身课、火锅底料的广告。 - 天府软件园35岁男性,每天中午点25元的商务餐,晚上点50元的烧烤配啤酒——说明他是程序员,加班多,可推送颈椎按摩仪、防蓝光眼镜。 阿里对这些数据的渴求尤为强烈。淘宝虽然有用户的购物数据,但缺乏“本地生活”的场景信息(如用户常去哪家餐厅、喜欢什么口味)。通过饿了么的订单,阿里能补全这部分数据,让推荐算法更精准。例如,给“常点川菜”的用户推麻辣火锅底料,给“深夜点外卖”的用户推速食产品——7月,淘宝根据饿了么数据推荐的商品,转化率提升了23%。 美团则通过外卖数据优化“到店业务”。例如,发现某用户常点“星巴克外卖”,就推送“到店消费满60减15”的券;看到用户点了“火锅外卖”,就推荐附近的火锅店套餐。这种“线上带线下”的转化,让美团到店业务的获客成本下降15%。 更重要的是,这些数据能用于“信用体系”建设。支付宝的芝麻信用分,已将“外卖准时付款”“不恶意取消订单”纳入评分维度;美团的“信任分”则影响骑手的接单优先级。未来,外卖数据甚至可能与征信挂钩,成为评估个人信用的参考。 对于巨头而言,外卖数据的价值远超“外卖本身”——它是理解用户真实需求的“显微镜”,是优化全平台业务的“导航仪”。 ### 生态协同 外卖的终极战场,是“本地生活生态的主导权”。当用户的“吃饭”需求被满足后,平台会试图覆盖“出行”“娱乐”“健康”等所有本地需求,成为“城市生活的操作系统”。 阿里的生态野心最大。其布局是“淘宝(电商)+饿了么(外卖)+高德(地图)+飞猪(旅行)+支付宝(支付)”的全链条:用户用高德导航时,会收到附近餐厅的外卖券;在飞猪订酒店后,会推送酒店周边的美食套餐;用支付宝付款时,会自动抵扣外卖红包。这种“场景互联”,让阿里的本地生活生态形成闭环,用户很难逃离。 例如,一位用户的行为链条可能是:飞猪订机票→高德导航去机场→饿了么点机场餐→支付宝付款→淘宝买旅行纪念品。在这个链条中,外卖是“黏合剂”,将各个场景串联起来。7月数据显示,使用过饿了么的用户,使用高德地图的频率增加18%,飞猪的订单量增长15%,印证了生态协同的效果。 美团的生态则更“聚焦本地”:外卖(吃饭)+美团打车(出行)+大众点评(到店)+美团买菜(生鲜)。其逻辑是“围绕用户的居住地和工作地,构建3公里生活圈”。例如,用户点外卖时,会看到“楼下超市满50减20”的美团闪购券;打车时,司机可能会推荐“顺路的奶茶店新客减10元”。这种“小而密”的生态,在一二线城市的渗透率极高。 京东的生态则走“品质路线”:京东商城(正品)+京东到家(即时零售)+京东健康(医药)+京东金融(支付)。其目标用户是“对品质敏感”的中产,例如:用户在京东买了高端食材,京东到家会推送“厨师上门烹饪”的服务;在京东健康买了感冒药,会推荐“清淡粥品”的外卖。 这些生态的竞争,本质上是“标准制定权”的争夺——谁能定义本地生活的服务标准(如配送时效、商户准入、用户权益),谁就能让其他玩家“按自己的规则玩”。例如,美团制定的“准时达”标准(超时赔10元),已成为行业默认规则;阿里推动的“商户食品安全溯源”,正在影响监管政策的制定。 当巨头们的生态覆盖足够广时,外卖就不再是“独立业务”,而是生态的“基础设施”——就像Windows系统里的“记事本”,虽然本身不赚钱,但能带动整个系统的使用。 ## 补贴战能持续多久? 当消费者为“4元喝3杯奶茶”欢呼时,商户在为“卖一单亏5元”发愁;当平台为“日单破亿”庆功时,财务报表上的亏损正在扩大;当骑手为“日入千元”兴奋时,政策的红线已在悄然收紧。这场补贴狂欢的背后,隐藏着三重难以忽视的隐忧,注定了它无法长久。 ### 商户困境 对于餐饮商户来说,补贴战是一场“甜蜜的毒药”——订单量暴涨的同时,利润正在被吞噬。 中小商户的日子尤其艰难。北京海淀区一家麻辣烫店的老板算了一笔账:参加饿了么“满25减21”后,用户实付4元,平台抽成15%(约0.6元),商家实际到手3.4元。但这单的成本包括:食材12元、打包盒1元、水电0.5元,合计13.5元——每卖一单,亏损10.1元。“每天订单从50单涨到300单,看起来热闹,但一天亏3000元,撑不了一个月。”老板无奈地说。 连锁品牌虽然有规模优势,但也难逃压力。某头部茶饮品牌的区域经理透露:“我们的奶茶成本是售价的30%,参加‘满25减21’后,每杯利润从7元变成-3元。为了止损,只能悄悄减少料包(比如珍珠从50g减到30g),但用户已经开始投诉‘味道变淡’。”更麻烦的是,连锁品牌有全国统一价,无法像中小商户那样“悄悄涨价”,只能硬扛亏损。 商家的“两难”在于:不参加补贴,订单量暴跌(某商户退出饿了么补贴后,订单下降80%);参加补贴,亏损扩大。最终,他们只能寄希望于“补贴尽快结束”,但这又会导致订单回落——这种“恶性循环”,正在透支整个餐饮行业的健康。 更长远的危害是“劣币驱逐良币”。当补贴成为常态,用心做品质的商家会因成本高而被淘汰,而那些偷工减料、降低标准的商家反而能生存。长此以往,餐饮行业的整体品质会下降,最终损害消费者利益。 ### 政策风险 国家对“低价内卷”监管的“达摩克利斯之剑”正在不断收紧,补贴战随时可能触碰政策红线。 2025年3月,发改委发布《关于规范平台经济竞争秩序的指导意见》,明确指出“禁止通过补贴进行不正当竞争,防止资本无序扩张”;6月,市场监管总局对社区团购平台“低价倾销”开出3张亿元罚单;7月,商务部召开“外卖行业座谈会”,要求平台“合理确定补贴力度,保障商户和骑手权益”。 这些信号都表明,监管层对“补贴战”的容忍度在降低。从法律层面看,《反不正当竞争法》第12条规定:“经营者不得利用数据和算法、技术等优势,从事不正当竞争行为”——若平台的补贴导致“排挤竞争对手、损害消费者长远利益”,可能被认定为“不正当竞争”。 历史经验也值得警惕。2021年,社区团购平台因“1分钱抢菜”引发监管介入,最终被迫停止低价补贴,行业进入规范期;2023年,网约车平台的“低价补贴”被要求整改,补贴力度不得超过成本的10%。外卖行业若持续“赔本赚吆喝”,很可能迎来类似的监管干预。 更关键的是,补贴战会引发“就业问题”。当平台为了降本,压榨骑手(如降低单价、延长配送时间),或迫使商户降薪(因利润下降),可能引发社会矛盾。7月已有骑手向工会投诉“饿了么强制要求每天跑12小时,否则不发补贴”,这种“涸泽而渔”的模式,必然会引起监管关注。 对于平台来说,政策风险是悬在头顶的“达摩克利斯之剑”——补贴的力度越大,持续时间越长,被监管介入的可能性就越高。 ### 可持续性 无论从财务数据还是历史规律看,“500亿补贴”都注定是短期行为——没有任何一家公司能长期承受这种级别的亏损。 阿里的现金流虽然充裕(2024年现金储备约2000亿),但500亿补贴相当于其全年净利润的15%,且这只是“开始”——若美团持续反击,阿里可能需要投入更多。更重要的是,阿里的核心业务(电商)正面临抖音的冲击,2024年淘宝的增速已降至8%,若为了外卖过度消耗资源,可能影响核心业务的竞争力。 美团的压力更大。其2024年净利润200亿,而7月单月补贴就花了50亿,若全年保持这个强度,净利润将变为-400亿。美团的应对是“开源节流”:一方面提高非外卖业务的收入(如到店酒旅、闪购),另一方面降低骑手补贴(7月骑手单价从8元降至7.2元)。但这种“拆东墙补西墙”的模式,难以长期持续。 京东的“收缩”,本质上是对“烧钱模式”的清醒认知。其CEO徐雷在内部信中说:“我们不会参与没有尽头的补贴战,要把资源用在技术和服务上。”这种选择虽然会损失短期订单,但能避免现金流危机。 从行业规律看,补贴战的“终局”必然是“少数玩家存活”。2015年的打车大战,最终滴滴和快的合并;2019年的共享单车大战,只剩下美团和哈啰。外卖行业虽然难以垄断,但持续的烧钱会淘汰“资金实力弱”的玩家,最终形成“双寡头”或“三巨头”的稳定格局。 对于整个行业而言,补贴战的结束只是时间问题。当资本的热情褪去,外卖行业终将回归“合理利润”的常态——而在此之前,所有玩家都在“比谁能撑到最后”。 ## 服务分层才是趋势 补贴战终会落幕,当“价格”不再是竞争的唯一维度,外卖行业将进入“服务分层”的新阶段。不同平台会根据自身优势,锁定不同客群,提供差异化服务,最终形成“高端有品质、中端有性价比、低端有保障”的市场格局。 ### 高端市场 高端市场就是为“效率和品质”买单,这一市场的客群是高收入人群(月入2万以上)、白领和家庭用户,他们的核心需求是“快、好、安全”,对价格不敏感。 美团很可能主导高端市场。其优势在于“配送效率”和“商户品质”: - **极速达服务**:针对3公里内的订单,推出“20分钟必达”,超时赔付订单金额的50%,但配送费从3元升至8元。这一服务在写字楼密集区已试点,客单价达60元,用户复购率72%。 - **品质联盟**:筛选“后厨直播”“食材溯源”“厨师持证上岗”的商户,组成“品质联盟”,平台收取25%的佣金(高于普通商户的18%),但提供流量倾斜(搜索排名靠前)。目前,眉州东坡、必胜客等2000家品牌已加入,订单占比达15%。 京东则可能聚焦“高端食材和场景化服务”: - **私厨外卖**:联合五星级酒店厨师,推出“上门烹饪+餐具回收”服务,用户可点“波士顿龙虾套餐”(含厨师上门加工),客单价达500元以上。 - **智能保温**:使用带GPS和温控的保温箱,用户可实时查看餐品温度(如牛排需保持65℃),确保口感。这种服务已在上海陆家嘴试点,用户多为金融从业者。 高端市场的利润率可达15%,是普通外卖的3倍,且用户忠诚度高(一旦习惯就难切换)。未来,这一市场的规模可能达2000亿,成为平台的“利润奶牛”。 ### 中端市场 终端市场就是性价比与体验的平衡关系,这一市场覆盖大多数用户(月入5000-2万),他们既想要“优惠”,又在意“体验”,是平台的主力客群。 阿里可能在中端市场占据优势。其策略是“电商+外卖”的协同,提供“性价比套餐”: - **组合优惠**:用户点外卖后,可领取淘宝的“关联商品券”(如点了火锅,送火锅底料满50减20券),通过“外卖引流、电商变现”降低外卖补贴压力。 - **区域化运营**:针对不同城市的口味偏好,定制套餐(如成都推“麻辣套餐满40减15”,广州推“糖水满30减10”),提高用户匹配度。 中端市场的关键是“控制成本”。平台会通过“智能调度”(减少骑手空驶)、“预订单”(用户提前点单,商家错峰生产)、“集中配送”(同一写字楼的订单合并配送)等方式降低履约成本,从而在“价格”和“体验”间找到平衡。预计这一市场将占整体份额的60%,是平台的“基本盘”。 ### 下沉市场 下沉市场(三四线城市及乡镇)的客群对价格敏感,核心需求是“便宜、能送到”,客单价多在20元以下。 这一市场可能由阿里和美团共同覆盖,但策略不同: - 阿里会利用淘宝的下沉流量,推出“低价专区”(如“10元吃饱”套餐),并联合地方小吃店(如县城的麻辣烫、乡镇的炸鸡店),通过“低佣金+流量扶持”吸引入驻。 - 美团会优化“众包运力”,利用乡镇的“摩的司机、便利店店员”作为兼职骑手,降低配送成本,确保“5元配送费能送到村”。 下沉市场的潜力巨大——目前其外卖渗透率仅15%,远低于一线城市的45%,且用户增速是一线城市的2倍。未来,随着县域经济的发展,这一市场将成为增长最快的板块。 ### 技术驱动:无人配送重构行业成本 无论哪个细分市场,技术都将成为“核心竞争力”。其中,无人配送(无人机、无人车)的普及,可能彻底改变行业的成本结构。 京东在这一领域布局最深。其无人车已在江苏宿迁实现“村村通”,能将3公里内的配送成本从8元降至3元;无人机在广东东莞试点“跨江配送”,解决了“河流阻隔导致配送慢”的问题,单次配送成本从15元降至5元。京东的目标是,2027年让无人配送承担50%的订单。 美团也在测试“智能调度+无人车”的组合:用算法预测订单高峰,提前将无人车部署到写字楼楼下,用户下单后,骑手只需从商家取餐放到无人车,再由无人车完成最后1公里配送。这种模式能让骑手效率提升30%,成本下降20%。 技术的终极目标是“去人力依赖”。当无人配送的成本低于人力时,外卖的利润率将从5%升至15%,行业将彻底告别“烧钱模式”,进入健康发展的新阶段。 ## 内卷不是出路,创新才是 当500亿补贴的硝烟散去,我们会发现:外卖行业的终极竞争,从来不是“谁补贴多”,而是“谁能解决行业的真问题”。 对于用户,真问题不是“今天减多少”,而是“能不能准时送到、食材干不干净、有特殊需求(如少辣、分开装)能不能被满足”;对于商户,真问题不是“平台给多少流量”,而是“能不能降低获客成本、提高复购率、实现可持续盈利”;对于骑手,真问题不是“今天赚多少”,而是“能不能有稳定收入、合理休息、职业尊严”。 那些能解决这些问题的平台,才能真正赢得市场。或许是美团用算法优化骑手路线,让他们少跑冤枉路;或许是京东用无人配送降低成本,让商家有更多利润空间;或许是阿里用生态协同,让用户的消费体验更顺畅——但无论哪种方式,核心都是“创新”,而非“内卷”。 补贴终会退潮,价格战终会结束,但用户对“便捷、高效、品质”的需求永远存在。外卖江湖的下一章,不会再是“烧钱的狂欢”,而是“价值的创造”——谁能创造真正的价值,谁才能笑到最后。 本文由 @viktor 原创发布于人人都是产品经理。未经作者许可,禁止转载 题图来自 Unsplash,基于CC0协议 该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务

裁员,换将,部门重组,是微软云眼下新旧财年交替之际的“热词”。 雷峰网观察到,从6月中旬至今,微软云中国至少经历了三四波人员变动,大致可以分成三类: 因部门拆分、重组引发的裁员,由绩效不达标导致的PIP裁员,以及跟随微软全球政策而进行的裁员。 其间亦穿插着管理层的一些人事调整。 透过这些裁员与高管变动,微软云当下业务发展的一系列走向与趋势已初现端倪。 ## 部门拆分、重组,引发员工大“活水” 第一类人员变动是由部门拆分引发的员工内部活水,以及活水无果后的离职。 **变动最先从PS团队(政府公共事业部)开始。** “PS部门拆分这件事在去年就传了好几次,今年6月终于尘埃落定。”微软云离职员工王明告诉雷峰网,该部门包括政企、教育、孵化器等客户,此次拆分中,各细分板块的“命运”也各不相同。 “得益于大模型产品的拉动,去年微软云中国的教育线营收增长较大,所以这次拆分PS部门时,把教育线保留下来,划到了田灼领导的DN(数字原生)部门。政企、孵化器等客户则被打散划归到不同部门里了。”王明表示。 不过据说DN部门能吸纳的人员有限,所以整个PS团队的大部分员工都需要自己找内部活水机会,找不到的基本就在6月底7月初跟着其他类型裁员一起走掉。 而PS团队原负责人郑敏也转岗至GPS(Global Partner Solutions),即全球合作伙伴解决方案部,分管了一部分伙伴业务。 可以说,从2026财年(2025年7月1日-2026年6月30日)起,微软云中国就没有PS团队了。 **除拆分PS团队外,微软云中国这次还对“解决方案”类团队做了重组。** 多位业内人向雷峰网反馈,此前,微软云中国内部有不少解决方案类团队,比如ATU、STU、CSU等,而他们之间存在一部分功能重叠。 简单来说,ATU是客户技术团队,主要散落在各个业务线里,与销售捆绑在一起,向各业务线销售负责人汇报;STU是解决方案销售团队,它与ATU的区别在于,ATU卖微软几乎所有的产品,而STU只卖云服务,两者之间有时候会相互“打架”。 不止这些,微软全球在中国还设有专门的支持AI相关服务的一系列团队,以及微软中国工程院也有能提供解决方案、客户支持的团队。 “职能相似的团队有点太多了。” 曾任职外资云客户经理的刘洋向雷峰网回忆,他曾在一个电商大客户项目现场见过微软 “派了一大堆不同的方案团队的人过去,光开会时围在桌前的各团队负责人就有十几个,协调成本比较高。” 不过也有一些业内人认为,“微软是一个矩阵式组织,这样的组织类型本身就容易产生职能重叠。这是由其业务复杂性决定的。” 事实上,近两年微软也曾多次在全球范围进行组织扁平化改革。此次新旧财年交替之际,微软云中国对这些解决方案团队进行了重组。 “一些原本负责二线产品技术支持的售前团队,被推到一线去支持销售了。”前述刘洋透露,此外,CSU的调整也较大,据说收编了一些类似职能的团队,部门规模增加了几十人。 除此之外的更多其他部门调整信息,可添加作者微信 **xf123a **获取。 ## “绩效大考”之下的多轮裁员 第二类裁员主要由绩效引起,在六七月份持续了几波。 微软云离职员工张倩告诉雷峰网,从6月下旬开始,微软云中国就陆续发出PIP通知,涉及人员比例约为10%。 “7月份,裁员还在继续。因为到6月30号为止,上个财年才算真正结束,并且部分项目和团队获得了延期许可,可在7月完成上一财年的KPI,如果最终还是没有完成,团队的人员编制才会再往下减。”张倩补充道。 一个坊间传闻是,上个财年,微软云中国给负责SHEIN的团队定的销售指标是2亿美元,但目前仅完成6千万左右。如果7月份还补不上的话,该团队大概率也要裁员。更多最新进展可添加作者微信 **xf123a **交流。 另外,一则可能与业绩相关的管理层变动是,近期微软云港澳地区换了新的负责人。Leo Liu接替Cally Chan成为新的负责人,向微软云大中华区一号位侯阳汇报。 据说换将的原因之一是近两年微软云港澳区域业绩不够突出,遭到不少友商挤压。 “谷歌云和火山在香港都比较猛。”外资云销售吴然表示,尤其是火山,其目前推广的豆包大模型,增速有超过微软云AI的势头。 香港是火山引擎目前的重点目标市场之一。就在几周前,火山负责人还专程赶赴香港,与盈科香港高层洽谈合作。 “另外,微软云的合规审查比较多,不够宽松、灵活,因此筛掉了不少客户和业务,这也是其在面对新兴AI应用市场时束手束脚的原因之一。”吴然补充道。 不过瑕不掩瑜。上个财年里,微软云借AI大模型的势能,拿下了不少大单。 雷峰网从多位业内人处获悉,今年四月前后,微软云和谷歌云分别拿到了某互联网云巨头价值约2亿、5亿美金的订单。 而去年下半年,微软云OpenAI大模型业务的中国营收在其全球营收中占比最高,约为1/4。不少大模型公司、有大模型业务的互联网巨头以及大型出海中企都是微软云中国的买家。 ## 更大的全球“幕布”正在拉开 第三类裁员是由微软全球总部引发的“连锁反应”。 2026新财年伊始,微软就宣布将在全球范围内裁员约9000人,占员工总数约4%。这一指标也层层下发到了微软云中国区。 7月2日,先是微软云中国的销售部门迎来了一波裁员。紧接着7月4日,微软中国CSS(客户服务与支持)部门也大规模裁员。据一位微软离职员工称,微软上海和无锡的办公室几乎走了三分之二的人,涉及约六七百人。 其中负责安全、身份验证及数据相关工作的团队受到的冲击尤为明显。这让不少微软云员工认为这次裁员背后有着更深层的国际关系因素。 “微软正在转移其在亚太的重心。”一位外资云亚太工程师周斌告诉雷峰网,其实早在疫情后,微软中国就开始缩编了,近年来这一趋势愈发明显。 “疫情前,微软中国每年招的实习生和校招生有好几百人,多的时候可能达上千人,但去年只招了十几人。而其他以前不太招人的地区,像澳洲开始扩招,去年仅应届毕业生就招了 100 多人。” 不仅如此,微软中国同时也持续把一些AI团队向海外转移。从去年年底到现在,已经有几百号人搬到了澳新美加等地,还有不少人在等待签证。 “很多海外地区都成立了新的工程研发中心,来承接这些从中国转移出来的工程师。”周斌补充道。 这种“转移重心”的趋势,在管理层的变动上也有所体现。 比如最近,微软云大中华区副总裁、数字原生事业部负责人田灼调到了亚太地区,担任微软亚太区数字原生线的负责人。同时,他还继续负责微软大中华区的数字原生业务。 这一安排被不少业内人解读为,微软云中国的“核心”业务被上收到了亚太区。因为数字原生部门囊括了很多中型互联网大客户,是微软云中国区的主力营收部门。 此外,伴随微软云财年调整还有一则尚未证实的传闻是,微软云中国一号位侯阳后续可能会调往美国总部。更多内幕可添加作者微信** xf123a **交流。 种种迹象或许表明,微软云对中国市场的战略倾斜与深度参与,正在逐步降低。 在不少业内人看来,微软云中国近期的一系列震荡,既是新旧财年交替之际的战略校准,也折射出其在复杂市场环境中的艰难平衡。 尤其眼下,微软与中国市场正在进入微妙的调整期,如何在腾挪之间找到新的平衡点,或许是其此次震荡的深层诉求。 从部门精简,到绩效洗牌,再到跟随全球裁员调整布局,每一次变动背后都牵涉业务重心的转移以及资源的再分配。 而这些变动留下的涟漪还将持续扩散,雷峰网也将持续跟踪报道,更多故事、经历及见闻欢迎添加作者微信 **xf123a **交流。 注:文中王明、刘洋、张倩、吴然、周斌等皆为化名。

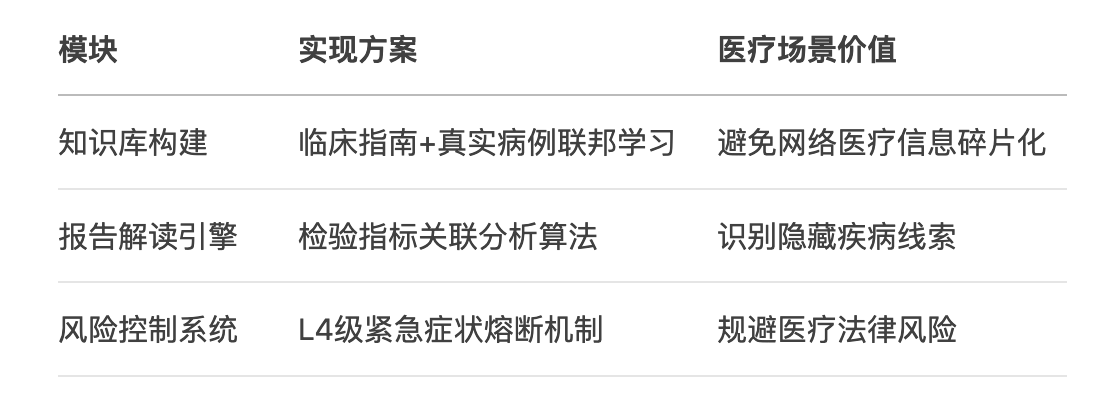

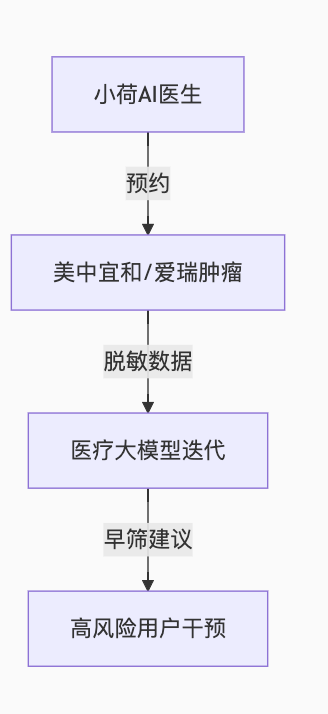

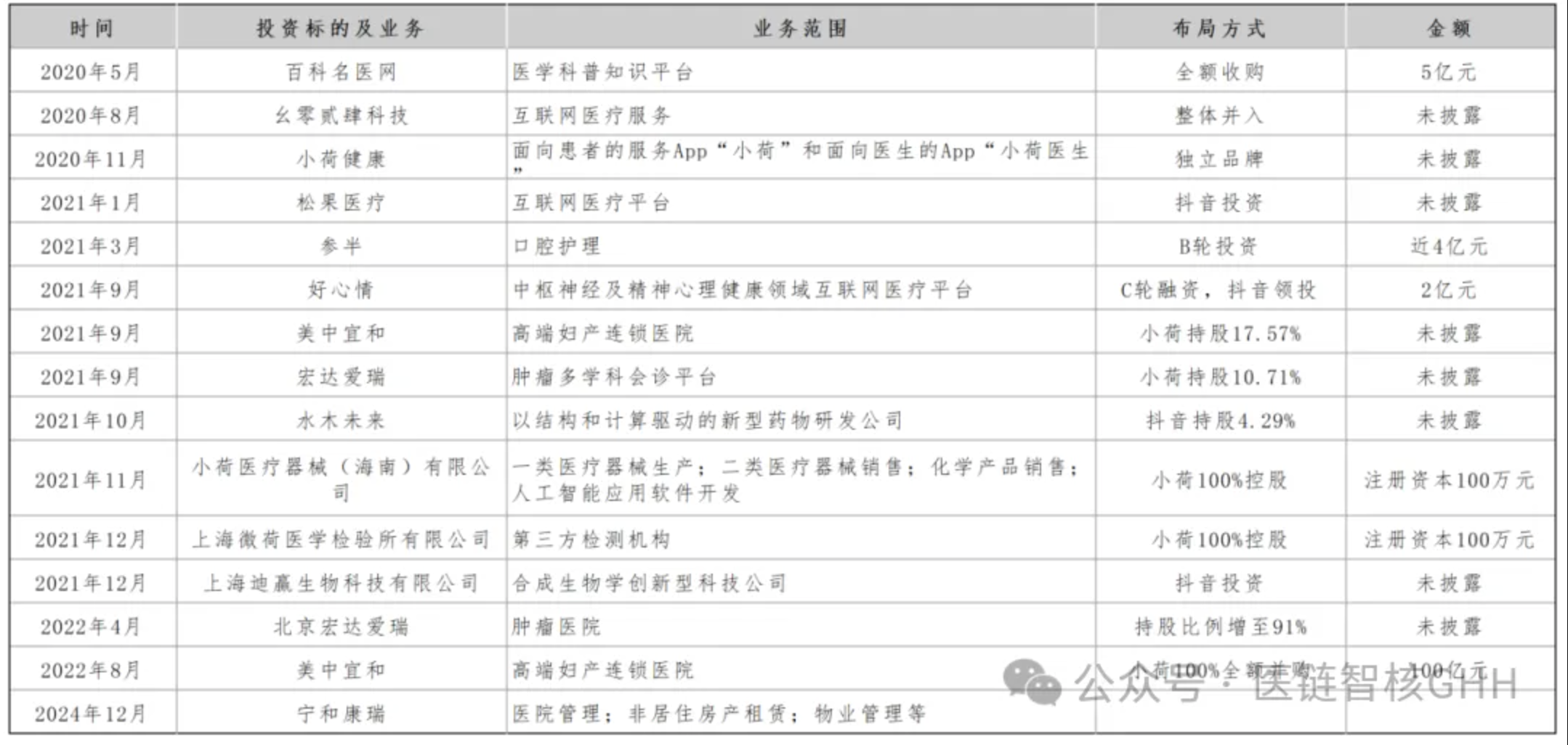

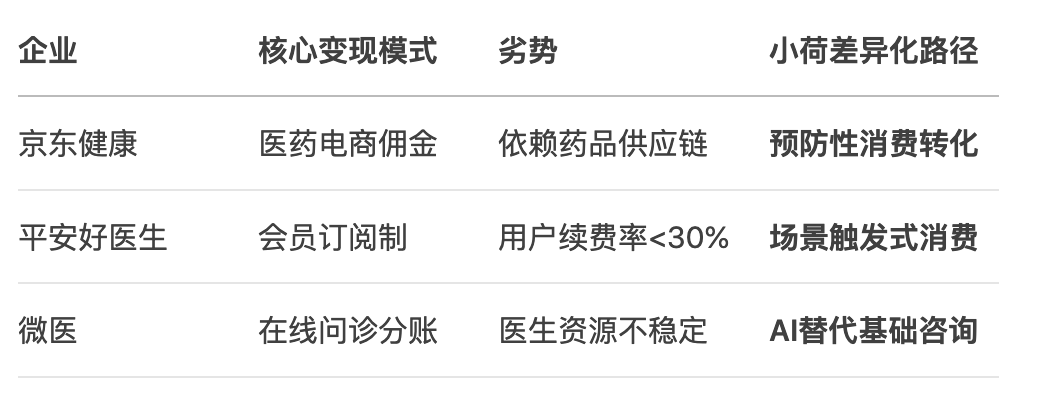

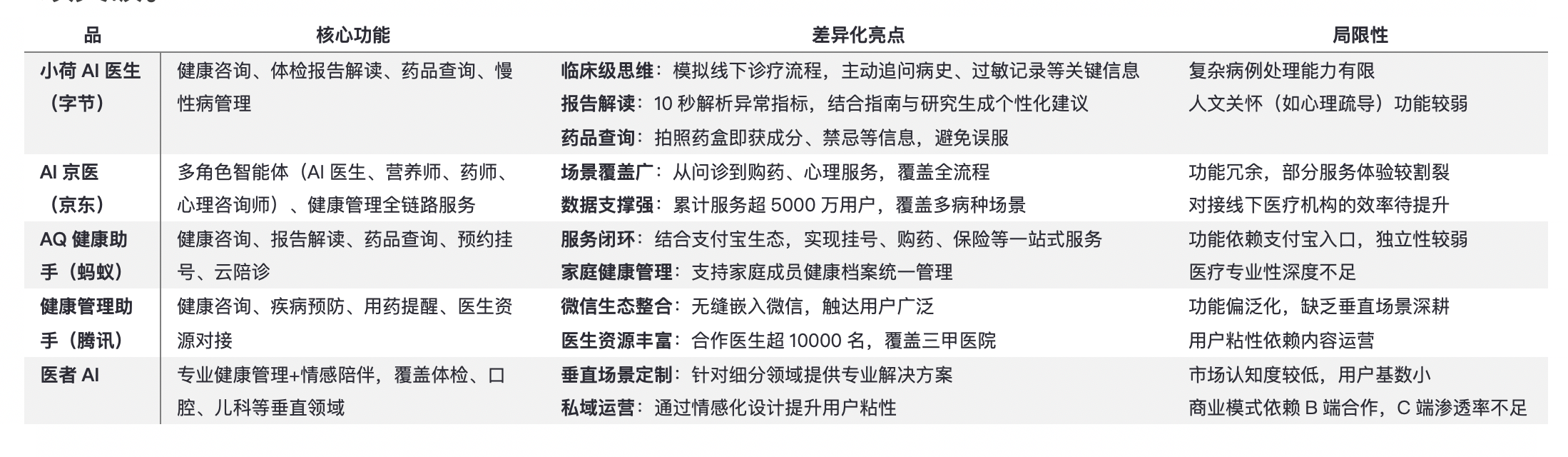

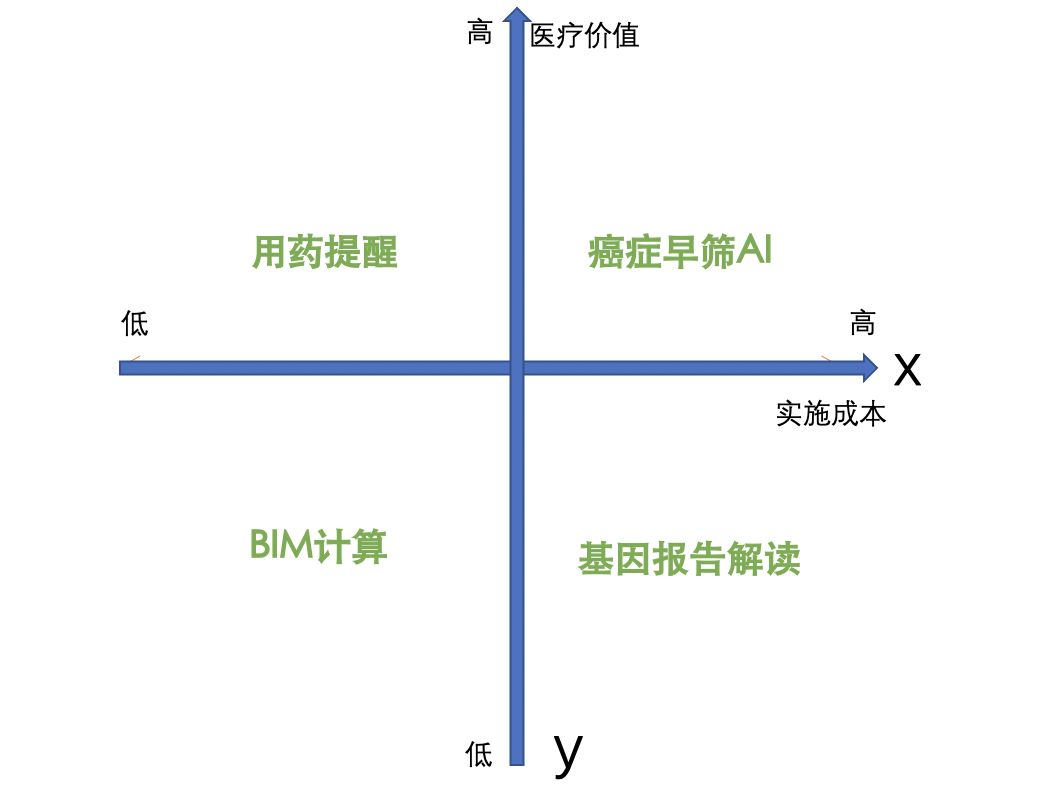

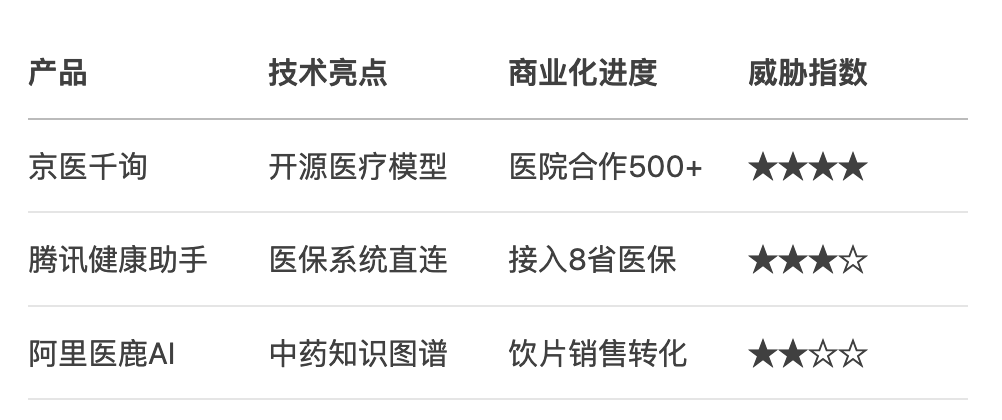

<blockquote><p>当抖音的9亿日活遇见医疗刚需,字节把“刷视频”顺势升级为“看医生”:小荷AI医生在症状输入后主动追问病史、影像与用药,用“临床级”思维把误诊率压到最低,再把问诊入口无缝接入商城购药,完成从科普到成交的闭环。本文拆解了这套“前端内容洗脑—中台AI问诊—后端生态变现”的三段式打法,并给出医疗AI避坑清单:责任边界、合规成本、用户预期,一步踩空就可能翻车。</p> </blockquote>  当互联网医疗进入AI竞赛深水区,字节跳动携“小荷AI医生”杀入战场。这款定位临床级思维的医疗产品,正在验证一个关键命题:抖音的9亿流量能否转化为医疗服务的超级入口?从临床级AI设计到流量变现路径的深度产品分析:从产品设计、生态协同、商业化路径三维度深度拆解其破局逻辑。 ## 一、产品设计:如何打造“临床级”AI医生? ### 1. 颠覆传统问答模式的诊断逻辑设计 **核心差异点:** 竞品:症状输入→直接结论(类似搜索引擎) 小荷:症状描述→主动追问(病史/用药/影像)→综合评估(还原真实诊疗路径) **典型案例:**用户输入“皮肤红疹”,AI强制要求补充:  **产品价值:**降低误诊率的同时教育用户规范表述症状 ### 2. 技术架构的医疗专业化改造  **关键洞察**:医疗AI产品需在**严谨性**与**用户体验**间寻找平衡点,小荷通过“强制追问”设计实现两者兼顾 ## 二、流量生态:从内容消费到医疗服务的关键转化路径 ### 1. 抖音场景的精准触发设计 **用户行为链路:**科普视频→弹窗问诊入口→小荷AI咨询→抖音商城购药 数据漏斗模型:**观看医疗视频用户(9.34亿)** → 点击问诊入口(12.3%) → 完成咨询(58.7%) → OTC药品购买(17.9%) **产品经理启示**:内容场与医疗场的无缝跳转需解决**用户心智转换**问题 ### 2. 线下医疗资源的生态化整合 字节医疗版图与AI医生的协同效应:  这种“线上筛诊+线下承接”模式,正在重构传统互联网医疗的流量耗散困局。  ## 三、商业化验证:AI医疗的三种变现模式对比 ### 1. 主流玩家商业模式分析  **2.主要竞品对比分析**  **3. 小荷的场景化变现实验** 实验组A(抖音视频挂载问诊卡):痛风科普视频→生成个性化饮食方案→推荐低嘌呤食品;GMV转化率较普通广告高3.2倍 实验组B(报告解读促转化):血脂异常解读→推送Omega-3补剂→跳转商城;客单价提升至普通订单的1.8倍 **关键结论:**医疗健康消费需建立在专业信任基础上,AI建立的认知度显著提升转化效率 ## 四、产品风险:医疗AI的三大致命陷阱 ### 1. 责任边界模糊风险 当前解决方案:每次输出附带免责声明:“本建议仅供参考,不能替代专业医疗诊断”;设置200+条高危词库触发人工接管 **待解难题**:当用户因遵循AI建议延误治疗时的法律责任认定 ### 2. 数据合规成本激增 ■ 联邦学习系统开发 42% ■ 三级等保认证 28% ■ 法律合规团队 20% ■ 其他 10% 启示:医疗AI创业公司的合规成本可能超过技术研发 ### 3.用户预期管理困境 用户调研显示:68%用户期望AI能直接开处方;52%用户认为应免费服务。 产品经理必须持续教育市场:AI是辅助者而非替代者。 ## 五、给产品经理的实操工具箱 **1. 医疗AI产品需求优先级模型** **2. 竞品跟踪清单(2025)**   **3. 用户信任度提升三板斧** - 溯源可视化:显示建议来源(如《2024版高血压指南》) - 置信度提示:“该方案适用于85%非妊娠成人” - 医生双签机制:高危建议需执业医师二次确认 ## 结语 小荷AI医生的本质,是字节用工程化思维重构医疗链路的尝试: - 前端:用抖音内容解决用户认知问题 - 中台:用临床AI解决基础服务问题 - 后端:用生态协同解决商业闭环问题 当技术红利撞上流量霸权,医疗健康产业的“人货场”正在被重新定义。 数据来源:小荷AI官网;访谈记录:字节医疗产品团队(2025.6) 本文由 @医链智核GHH 原创发布于人人都是产品经理。未经作者许可,禁止转载 题图来自Unsplash,基于CC0协议

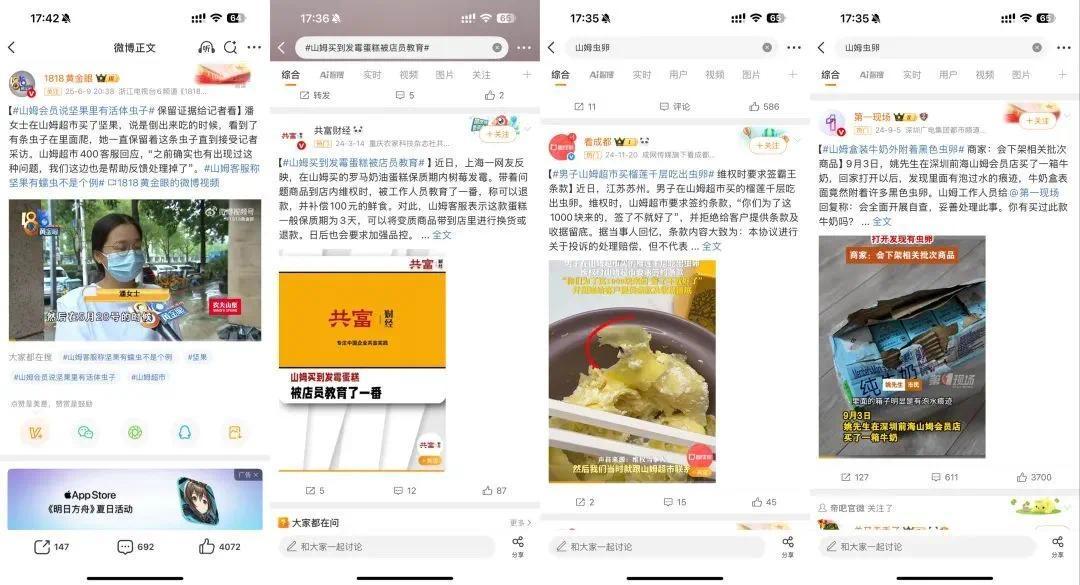

<blockquote><p>当“0元购”在7月12日席卷美团,1.5亿单的欢呼背后却是一场“七伤拳”式的自我消耗:奶茶机打冒烟、骑手挤爆店、中小商户忙成“平台义工”,而真正的即时零售非餐饮订单却被自己人悄悄稀释。本文用一张战报拆穿“单量神话”——淘宝闪购一句“8000万不含自提”直接戳破水分,美团为守第一砸下的百亿补贴反成高悬的利润镰刀。</p> </blockquote>  被“偷家”的美团,这次火力全开。 相比7月5日那个周末的被动应战,平台被冲到短暂“瘫痪”,7月12日这个周末,美团选择主动进攻,发起“0元购”。 实际上,周中开始,微信群、社交平台等渠道,就已经在预热美团即将放大招的消息。比如,“7月12日,奶茶大战即将开启。这次是0元购!明天开始,美团0元奶茶直接买,无需领券!”、“最好饿一天,明天周六据说是前无古人的三方外卖大战”等等。 ## 美团“0元购”爆单了 7月12日,用户打开美团App,系统就直接弹出“0元外卖”已到账的提示。点开之后,有部分品牌的0元奶茶、咖啡等“神抢手”通兑券,跟前一周类似。这一次,还多了自提免单券,支持古茗、沪上阿姨等品牌到店自取。 还有网友发现,美团同时上线了“1分钱起”抢购奶茶外卖、以及“冰镇爆品1分钱起”、“大牌自取1.68元起”等活动。  图源:美团“0元购” 媒体截图 王兴曾经明确说过,美团将会“不惜一切”胜出。现在,正是需要“不惜一切”的关键时刻。对比前一周的临时上线冲单,美团这一轮“0元购”的目的十分明确,就是要把单量冲起来,捍卫行业第一的地位。 这“大水漫灌”的一天刚结束,7月13日(周日)凌晨,美团就快速发布成绩单:《1.5亿单,34分钟送达,收入翻倍,更多更快更好!》 美团称,7月12日23时36分,美团即时零售日订单量超过1.5亿。  图源:“美团Meituan”公众号 唐辰截图 单看表面的数字,“1.5亿单”的声势很足,也很亮眼,直接把美团外卖日订单量的峰值拉高3000万单,几乎创造中国外卖市场单一平台订单的最高纪录。 但对美团来说,要在某一天冲单,超出自己的过往纪录,不是难事。这份战报,我们还是可以看出两个问题: **首先是,“1.5亿单”的含金量高不高?**一方面,“0元购”针对奶茶、咖啡等小额高频茶饮订单补贴,用户只会是“薅完羊毛”就走,有多少留存,是未知数。 如果美团继续按照这类方式冲单,其日订单数还可以更高。关键是美团能持续补贴多久,力度有多大,新茶饮店面能支持多大力度,更取决于消费者会不会继续买单?不少网友就表示,如果优惠券没有了,就不会再点了。 另外一方面,美团战报里注明,拼好饭单量超过了3500万;神抢手单量超过了5000万。(在前一周,神枪手主打自提“0元购”,这一周也不例外。)二者相加,接近9000万单。**也就是说,有大几千万订单是用户到店自提,跟外卖关系不大。但这招可以帮助单量增长、缓解运力压力,还是被算进日订单总数里。**这就形成一种局面:用户薅美团补贴的羊毛,美团把压力间接传导到奶茶、咖啡等中小店面。 **其次,美团即时零售与外卖之间协同路径,真的跑通了么?**美团今年主动挑起“即时零售”战事,向所有的电商平台发起冲击。但这两周的外卖补贴大战打下来,美团在争夺焦点——即时零售——上的表现,不禁让外界产生这样的疑惑。 前一周美团被动应战,将订单量冲到1.2亿时,公布的非餐饮订单是3000万。这与四月份,小王CEO王莆中与京东做外卖发生口水战时,公布非餐饮订单突破1800万单相比,有提升,但也并不是很惊艳。要是和整个外卖订单量的激增对比,就更不觉得有多出色。 “猥琐发育”的那几年,美团闪购的订单到了一定规模。外卖大战打起后,更多的高频流量并未带来爆发性的闪购订单增量。这次战报里,美团干脆没有公布非餐饮订单的数据。 当然,京东、淘天也没有闲着。京东不仅发放了大额百亿补贴券,还于上周五晚上上线了“一口价16.18!请全国用户吃品质小龙虾”的特定活动。 淘天方面,有消息称,淘宝闪购将在未来一段时间,每个周六都主打“超级星期六”。比如这两个周末,在美团防御和发力时,淘宝闪购也动了补贴的手段,发放188元大券包,宣称“1天5顿我全包”。不少用户拿到了多张“满18.8减18.8”、“满28.8减18.8”的大额券。 ## 淘宝闪购,开始发牌 很多人也注意到,美团在周末铺天盖地发布战报时,淘宝闪购很平静,似乎并没有被美团带着跑。有朋友跟我说,淘宝闪购按照正常的情况备战,其他人员正在过周末。 周一早间,“淘宝闪购x饿了么”的周末战报,姗姗来迟。“淘宝”公众号发布数据,淘宝闪购联合饿了么宣布,日订单量再次突破8000万创新高,订单准时率稳定在96%。 除了说明“订单结构向全品类深度拓展”,淘宝闪购还特意加括号、标粗强调: (8000万日订单)**不含自提及0元购。**  图源:“淘宝”公众号 唐辰截图 这不是一道简单的算术题,而是**这份战报对美团杀伤力最大的信息。**在我看来,有两层含义: **一层是,美团伤人先伤己,1.5亿“约等于”8000万。**结合“淘宝闪购日活跃用户数在突破2亿基础上,本周又环比净增15%”来看,淘宝闪购并没有受到美团“0元购”、自提免单等非常规手段的影响,将日订单量稳定在8000万单。 淘宝闪购还详细的披露了非餐饮订单数据:在非餐方面,1205个品类订单量环比增速超过100%;3074个商家、超26万门店订单量环比增长超100%。 这样看来,短短两个月,**按照前面的数据拆解,美团注水的“1.5亿单”,其含金量并没有大过淘宝闪购脱水的“8000万单”。**“淘宝闪购x饿了么”在有效订单上,已经逼近,甚至做到了美团同等规模。 美团“不惜一切代价”冲出1.5亿日订单,也就是为了维持“第一”这个名头了,保持所谓的领先。 美团“1.5亿单”的真实状况就是,相当于打出一记“七伤拳”。这是金庸小说里,崆峒派传世武功,修炼这门武功有有一个先决条件,那就是内功境界一定要非常高。否则,七伤拳就是伤敌先伤己。 因为美团暂时领先,单量更多,对冲单补贴会更加谨慎。一旦账没算清楚,参与补贴花费的成本更高。晚点称,据一位长期关注美团的二级人士测算,美团今年预估至少要新增150亿-200亿元的补贴。高盛给出预警,基准情形下未来12个月,美团EBIT利润将下降250亿元。 **二是,美团“0元购”冲单的玩法,对整个行业来说,并不是好事。**虽然美团自我评价,面对创造历史纪录的订单峰值,依然能够稳定为所有用户提供最好的体验。但它没说的是,这个玩法瞬时流量的冲击,崩溃的不止美团App,还有不少中小茶饮店、店员也累崩溃了。 晚点提及,前一周美团的匆忙应战,品牌商家对美团的全力冲刺毫无准备,大型连锁品牌大多当天下午才接到通知,有些商家甚至表示没接到通知,就发现平台开始补贴自己。 全国各地的奶茶店里,打单机不停地吐出订单,堆积数米长,有的直接系统崩溃、店员只好手写订单,店内和门外挤满了排队取单的骑手,很多店铺不得不关闭外卖业务。  图源:媒体截图 还有媒体提到,店员对着堆积如山的杯子欲哭无泪:“这辈子没见过这么多单!”不少中小商户对激增的订单发愁:忙到飞起却没赚多少,纯属“为平台打工”。有消费者也调侃,“别死磕奶茶了!00后的胰岛素扛不住了!” **淘宝闪购则将补贴向非餐饮的零售业务上倾斜,其赠送给用户的免费券,适用于便利店配送场景。**比如,7月5日当天,淘宝闪购粮油米面、冷冻食品、家清、母婴、个护品类订单增速最快,比闪购上线之初都增长超过100%。 **这意味着,淘宝闪购已经从跟牌变为出牌。前者需要盲从对手,看牌再出牌;后者已经可以根据自己的策略和节奏来打仗了。** 淘宝闪购在战报里说的,全力促消费、商家新增长,“流水不争先,争的是滔滔不绝。”这句话既是对中小商家说的,也是在对美团喊话。 目前来看,参战各方在打法上越来越像,但美团与淘宝闪购、京东等对手最大的区别在于,它是外卖领域的防守者,本地生活业务是美团的核心阵地。而京东和淘宝并不依赖外卖业务赚钱。 这轮外卖大战,不惜代价赢下战争的一方,付出的代价可能会更大。美团大概要再算算这笔账,梳理一下打法了。 参考资料: AI蓝媒汇,《某团住手吧,再喝不了一点了》 人民财评,《人民财评:外卖订单多了小店生意火了》 晚点Latepost,《外卖混战升级:淘宝投入资源比肩双11,美团第一次全面反击》 **专栏作家** 唐辰同学,微信公众号:唐辰同学,人人都是产品经理专栏作家。内容链接,洞察与解读,关注互联网科技及商业故事。 本文原创发布于人人都是产品经理。未经许可,禁止转载 题图来自 Pixabay,基于CC0协议 该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

[继今年3月27日官宣成立新子公司](https://www.gcores.com/articles/196652),育碧于巴黎时间7月16日宣布任命Christophe Derennes和Charlie Guillemot为子公司联席CEO,标志子公司在发展路线图上迈出关键一步。Christophe Derennes和 Charlie Guillemot二人具有互补性的职业背景将为新子公司带来强大的行业专识,对育碧生态系统的深度洞察和鼓励创新的员工文化。  Christophe Derennes在育碧任职已超过35年,拥有广泛的游戏运营和制作管理经验,创建并领导过蒙特利尔工作室。他为多部游戏大作的创意内容和开发战略作出过重要贡献。在该项任命生效前,他担任北美地区工作室群总经理一职。  Charlie Guillemot的职业履历同时涉足管理和创新。得益于其游戏开发经历,他拥有创业思维和行业敏感度,深刻理解玩家需求所在。他还具有很强的产品思维,深厚的科技文化和对游戏的热爱,代表了聚焦创新、质量并以玩家为决策中心的新一代领导团队形象。 他们将共同领导新子公司,致力于打造常青的多平台游戏生态系统,为育碧知名品牌续写新的发展篇章。  为加速《刺客信条》《彩虹六号》和《孤岛惊魂》育碧三大经典品牌的发展,育碧新子公司将以打造价值达数十亿欧元常青游戏IP为目标,聚焦品牌生态系统的建设。得到增资和核心战略伙伴腾讯的专业能力加持,子公司将会赋予开发团队更大的自主权和敏捷度,以最大限度发挥这些经典游戏的潜能,为玩家打造次时代的游戏体验。 新子公司的创建工作正在有序推进中。腾讯对其的投资有待相关监管部门审批,预计将于2025年底完成。 关于Christophe Derennes Christophe Derennes于1990年加入育碧,亲身参与了集团的所有重要发展阶段。他于1997年参与了蒙特利尔工作室的创建,帮助集团搭建了质量控制职能的架构。作为游戏制作执行副总裁,他领导了多部畅销游戏的的开发工作。他于2020年被任命为蒙特利尔工作室总经理,于2023年被任命为北美地区工作室群总经理。他以善于聆听、具有亲和力、倡导合作的管理风格成为广受尊重和认可的领导者。 关于Charlie Guillemot 作为游戏玩家和科技爱好者,Charlie在育碧收购的Owlient工作室开启职业生涯。2014年,他成为工作室负责人之一,管理35人团队。工作室彼时因开发免费的页游而闻名,在他的领导下,工作重心转向手游。 由于渴望在游戏界探索创意边界,2021年,他以Web3技术作为发展锚点,与合伙人共同创建独立游戏工作室Unagi,从而获得对游戏市场的快速发展和行业深度转型的一线洞察。 Charlie的游戏开发核心理念为坚持玩法优先、发挥集体智慧、追求更高品质、满足玩家期待,以及确保真正的热爱贯穿决策过程。 带着对行业的崭新视角和深度洞察,Charlie于2025年回归育碧,加入集团转型委员会,致力于将创新和玩家优先思维进行有机结合。 Charlie从英国华威大学(University of Warwick)获得商业管理学士学位,从伦敦大学学院(University College London)获得计算机科学的硕士学位。

<blockquote><p>当课程内容与名师资源被拉平,在线教育真正的分水岭只剩一条——体验。本文拆解了把“愿意学、坚持学、有效学”做成系统工程的三大维度:用交互设计重建线下缺失的沉浸与反馈,用用户体验拿捏学习心理把任务拆进心流,再用界面设计把高密度的知识塞进一眼就能看懂的视觉动线。</p> </blockquote>  在在线教育竞争日益激烈的今天,课程内容、教师资源和技术支撑已不再是决定成败的唯一变量。随着市场趋于成熟,用户在多个平台间的选择权提升,**真正决定平台是否能留住用户、激发学习动力的,是用户体验(UX)、交互设计(Interaction Design)和界面设计(UI)这三大维度。** ## 一、为什么“交互体验”是线上教育的新门槛? 传统教育强调面对面、即时反馈、仪式感强。而在线教育,则在技术便捷的同时,牺牲了一部分“人”的互动感。这种缺失,正是交互设计需要着力弥补的空白。 **教育软件不仅仅要有过硬的专业知识,更要弥补相较于线下教学的交互短板。**教育不同于娱乐,其流程具备阶段性目标、长时间投入、知识内化路径等特征**,**单纯传输内容已远远不够,设计要主动参与到“学习过程建构”中,设计学习路径、驱动学习行为、重建沉浸体验。 ## 二、交互设计:不仅是“点哪儿”,更是“学下去” 线上教育的交互设计承担着三个关键任务: - **明确学习路径**:用户能否在首次使用中快速理解“从哪里开始学、接下来做什么、什么时候完成任务”。 - **即时反馈与引导**:做对了是否能获得激励?做错了是否能被温柔地引导?这决定了学习动力是否能持续。 - **任务分解与节奏感控制**:学习模块是否易于拆分、时间是否可控?这些因素影响用户是否能持续投入。 举例来说,我们曾为一个名为“半老外 David 英语启蒙”小程序参与界面与交互设计。在这个面向儿童与家长的英语学习产品中,我们采用了: - **圆角卡片式的信息分组**,减少信息干扰,提高儿童用户的内容理解效率。 - **页签式课程结构**,将“家长课程”与“孩子课程”进行分类,前者提供全方位了解入口,后者以视频和生活化场景增强学习沉浸感。 - **暖色调与IP形象融合的界面风格**,既兼顾儿童友好,也塑造了独特的品牌识别感。 这些设计不仅提升了视觉体验,更在**信息传达效率、任务操作便利性与情绪激励机制**上做到了实效优化。 ## 三、用户体验设计是学习系统的“心理工程” 一个体验出色的教育平台,往往在细节处打动人心: - 是否能减少用户的思考负担? - 是否能让用户知道“现在我在哪、接下来该干什么”? - 是否在用户迷茫、卡顿、分心的时候提供适时提醒或激励? 这其实是一个“设计心理学”在教育场景的落地问题。比如,当学习任务被合理拆分,系统根据用户表现实时调整难度,用户就更容易进入“心流状态”;当学习成果被可视化呈现,用户就更容易产生目标感与成就感。这种体验背后,其实是设计者对用户学习心理的精准拿捏。 ## 四、界面设计:教育产品的认知引擎与品牌载体 教育类产品的信息密度高,任务目标明确,界面设计要兼顾以下几方面: - **视觉层级清晰**:主操作路径需醒目明确,辅助信息适度弱化。 - **风格统一、情绪调性明确**:儿童启蒙需要温暖明亮,成人考证则更需要沉稳理性。 - **操作响应及时**:点击反馈、加载状态、跳转逻辑等要精准顺畅,降低用户的“系统不确定性焦虑”。  好的UI不仅是为了“好看”,更是为了提升操作效率、增强内容理解,最终让学习更轻松、更自然。 ## 五、未来发展趋势:体验驱动成为核心竞争力 在线教育正在走向“内容同质化、体验差异化”的时代。未来产品的核心竞争力,或许不再是谁有独家教材、谁请来大咖讲师,而是: - 谁能提供高度个性化、适应性强的学习路径 - 谁能构建沉浸感与成就感兼具的交互体验 - 谁能通过设计整合技术与教育逻辑,提升学习效率与心理舒适度 未来AI、数据可视化、语音交互、AR/VR 等前沿技术与设计将深度融合,带来新一轮体验升级。而在这一过程中,既懂设计、又懂教育、还了解技术逻辑的“新型产品设计人才”,将成为教育科技公司的核心战力。 在线教育并不缺内容,也不缺工具,缺的是**一个足够了解用户行为与认知机制的设计系统**。今天的产品竞争,是体验细节的比拼;明天的产品革新,是设计认知的升级。 从用户体验出发,连接认知与内容;通过交互设计,重构学习路径;借助界面设计,减少认知摩擦 —— 教育的未来,不只是教得更好,而是“让人愿意学、坚持学、有效学”。 本文由 @蓝蓝设计 原创发布于人人都是产品经理。未经作者许可,禁止转载 题图来自Unsplash,基于CC0协议 该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务

据美国Axios新闻网、英国广播公司(BBC)报道,美国总统特朗普当地时间16日表示,可口可乐公司已同意在美国使用真正的蔗糖生产可乐。特朗普16日在其社交平台发文称,他一直在与总部位于亚特兰大的可口可乐公司就使用蔗糖事宜进行沟通,这一做法已在墨西哥版可乐中采用。 “我要感谢可口可乐的所有高层。这将是他们非常正确的一步——你们会看到的,这样更好!”他写道。 __ 报道称,可口可乐目前在美国的产品中使用的是玉米糖浆。至于该公司是否计划修改原有配方或推出新产品,目前尚不明确。 该公司在给Axios新闻网的一份声明中表示,“我们感谢特朗普总统对我们标志性品牌可口可乐的热情。我们将很快分享更多有关可口可乐产品系列中创新产品的细节。” 值得一提的是,此前有多家外媒报道称,特朗普是健怡可乐的狂热爱好者,曾在白宫椭圆形办公室安装“可乐按钮”,以此提醒工作人员在他需要时为他送上冰镇的健怡可乐。 美国《华尔街日报》补充说,玉米加工协会主席约翰·博德周三表示,“用蔗糖取代高果糖玉米糖浆并没有什么意义。”他表示,这样做将导致美国食品制造业岗位流失,并损害农场收入。 一些食品科学家则表示,这两种甜味剂在风味上存在细微差别:高果糖玉米糖浆的甜味峰值来得更早,有助于增强水果和香料的风味,而蔗糖的甜味则更为宽泛,且持续时间更长。 [查看评论](https://m.cnbeta.com.tw/comment/1513544.htm)

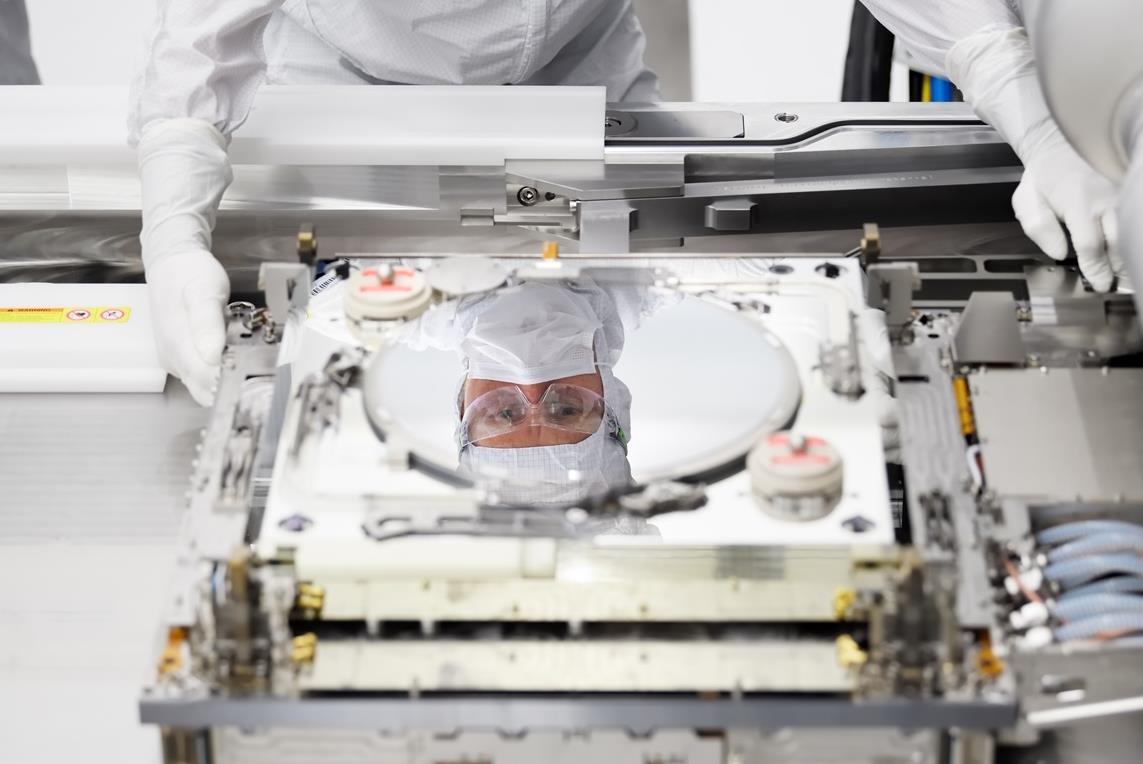

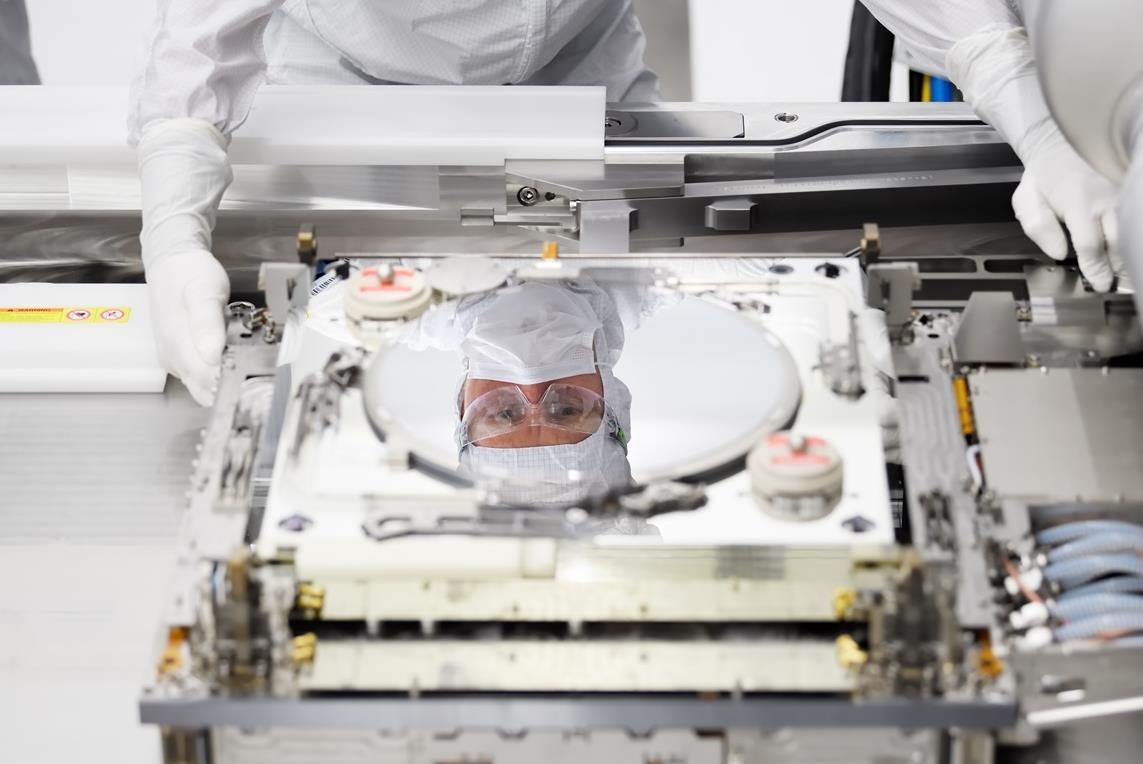

光刻机龙头ASML宣布,全球首台最强光刻机第二代High NA EUV已经出货。按照官方的说法,EXE:5200是ASML对现有初代High NA EUV光刻机EXE:5000的改进版本,首台买家是英特尔,一台售价近30亿元。 **相比初代High NA EUV光刻机EXE:5000来说,EXE:5200拥有更高的晶圆吞吐量(EXE:5000为每小时185片以上),可以更好的为2nm工艺量产做支撑。** TWINSCAN EXE:5000和EXE:5200均提供了0.55数值孔径,比前代EUV光刻机0.33数值孔径透镜的精度提高了,可以为更小的晶体管功能提供更高分辨率的模式。 EUV 0.55 NA的设计旨在从2025年开始实现多个未来节点,这是业内首次部署,随后将采用类似密度的内存技术。 **需要注意的是,这种高精尖的光刻机,ASML是不可能卖给中国厂商的,这不是钱的问题,而是其他因素。** [](//img1.mydrivers.com/img/20250717/cbf94f59fece4838a6c459b06fa1e9d4.jpg) [查看评论](https://m.cnbeta.com.tw/comment/1513542.htm)

根据保利演艺消息, 黑神话悟空交响音乐会2025巡演正式公布,新一轮巡演将解锁更多剧院,敬请期待!  通过微信公众号查询显示, 有部分剧院已经发出了预告。

京东、美团、淘宝三家在即时零售战场上打得难舍难分,酣战已久。 近日有消息传来,拼多多也下场加码即时零售了。据媒体报道,多多买菜已在上海等一线城市秘密试验自建商品仓库, 最快将于今年8月正式上线即时配送服务,以类似京东秒送、淘宝闪购的速度送货上门,提供生鲜和日用品“半小时达”服务。 但拼多多官方回应,在上海试点“这并不能代表公司战略方向”,并强调“不碰外卖餐饮,无意加入即时零售大战。” 根据接近拼多多的人士透露,拼多多并没有拿出之前在百亿补贴、多多买菜战役中的投入力度来应对即时零售。 这也就是说,多多买菜即时配送服务远未上升到“战略”层面——这跟美团、阿里、京东将即时零售提到战略高度有着显著区别。 拼多多不打即时零售,是它不想吗?不,是因为它不能。 在“新消时代”看来,拼多多想做即时零售,有三大致命伤,基因冲突、缺乏自建配送体系和时机错位。 ## 01 商品基因冲突,用户定位不符 拼多多是三四线城市及农村市场的下沉王者,拼多多旗下的多多驿站其在全国约有50万个驿站,覆盖2600多个县市。 作为社交裂变的王者,拼多多用超低价拼团+砍一刀链接吸引了大量低成本流量,这也决定了拼多多的用户多以价格敏感型的下沉群体为主。 在“多快好省”里面,拼多多的下沉用户对“省”的价格敏感度远远大于“快”。 他们宁可等待2-3天的物流配送时间,也不愿意多花二三十块换一个“30分钟达”。 而这样的用户,显然不是“30分钟达”的即时零售目标用户。 即时零售的主要用户则聚焦在一二线城市的中高端人群。这些人愿意为了更快拿到新款手机或电子游戏而支付多余的溢价,有高消费能能力。 两者用户错配,拼多多的用户几乎没有即时零售的需求,也不会在这个平台上进行即时零售的消费。 并且,在拼多多卖得好的多是农产品,农产品供应链偏向计划性集单,也就是把需求都聚合在一块。 但即时零售要的是实时拆零,是零散状的,这两个根本就不搭。这是商品供应链错位。 据悉,拼多多之所以试水即时零售,是因为受到了美团闪购的威胁。 据数据,美团闪电仓售出的白牌商品占比30%-40%,贡献了超过50%的利润,已经威胁到了拼多多的核心业务领域。 业内人士透露,拼多多开始担忧,美团闪购的崛起将会影响多多买菜业务,未来还可能冲击拼多多主站以米面粮油为主的类目。 **所以从某种程度上来说,多多买菜试水即时零售,更是对拼多多电商基本盘的保卫战。** 但是从反应速度上来看,拼多多在即时零售这件事上,已经远远落后于淘宝天猫、京东。在即时零售这场大战上,拼多多已经尽失先机。 ## 02 自建前置仓,但缺乏自建配送体系 坐拥广大骑手群体,京东、美团已经有了成熟的配送团队和本地化物流体系,能够做到“30分钟达”。 而拼多多则缺乏自建配送体系,没有自己的即时配送团队,只能依赖极兔、三通一达等第三方物流。 并且拼多多擅长“低价拼团+次日达”的“远场电商”,而即时零售则是“近场电商”战役,需要围绕3公里半径构建密集服务网络,底层逻辑难以复用。拼多多跟即时零售的业务适配性低。 其实早在2024年底,拼多多就在上海试点同城即时配送。 但由于拼多多的合作商家多在三四线城市及农村这类下沉市场,在一二线的合作商家非常有限。 并且当时采用的是社区网格仓模式,采用“轻资产+众包配送”策略,复用现有社区团购网格仓。 这种合作模式商家的配合度有限,网格仓覆盖范围也有限,最终只能实现4小时达,与行业“半小时达”标准差距明显。 所以今年5月,拼多多已将“多多买菜快递代收”业务升级为“拼多多驿站”,新增24小时自助取件和送货上门服务,为即时零售布局打下基础。 再次入局即时零售,拼多多选择在上海这类一线城市自建前置仓,将生鲜、快消品直接存储其中, 然后由骑手负责最后一公里配送到消费者家中,这样可以满足中高线城市消费者对“配送速度”的要求。 但是据消息,在上海试点的即时配送服务,拼多多也表示不会自建骑手队伍,而是优先考虑与闪送、顺丰同城等第三方平台合作。 即使拼多多改进了网格仓的缺点,选择在一线城市社区周边3公里内自建前置仓,但仍然没有打算自建配送体系,这一点对“半小时达”的目标也会有所影响。 ## 03 已经错过最佳入场时机 即时零售市场正在快速增长,据商务部报告预测,2030年我国即时零售市场规模将超2万亿元。 当前美团闪购占据38%的市场份额,京东到家占27%,阿里系(淘宝闪购+饿了么)占比约25%。三者合占90%的市场份额,留给外来者的所剩无几。 或者换句话说,也可以认为,在即时零售巨头都打得差不多,吃完肉喝完汤之后,剩下的就只有剔牙缝那么大点的地盘留给拼多多了。 作为即时零售后来者,拼多多如果选择现在入局,则将面临激烈的电商竞争压力。 如果拼多多要加大即时零售投入,自建前置仓和配送团队都需要巨额资金。但拼多多2025年Q1净利润同比大跌47%,资金储备不足。 拼多多已经失去了打入即时零售市场的最佳时机,现在下场,怎么看都不是一个有利的选择。 所以才有消息称,拼多多此举并不是要大举进攻即时零售领域,而只是浅浅试水。毕竟拼多多自己都说了“无意加入即时零售大战”。 其实拼多多说这句话,是很有底气的。只要拼多多想,其实它根本没有必要下场来打即时零售。 一则即时零售是大厂们为了争夺流量入口掀起的大战,而拼多多借助独特的商业模式与社交裂变,在电商领域形成了显著的低成本流量优势。 据数据,拼多多主站的流量已经跟阿里电商系的月活相差不大。简而言之就是一句话,拼多多现在的流量已经很足够,不用再去争抢了。 二则并不是所有的商品都很强调即时性。即使拼多多放弃强调时效的生鲜、外卖,电子产品,还有相当大一块的家用电器、日常生活用品等市场。 三则在国内整个消费者大盘上来看,低线城市和农村地区消费者仍是占据绝大多数的“基本盘”。比起即时零售一二线城市相对少数“时间敏感型”的消费者,大多数消费者对于“9.9包邮”的敏感性和需求远超“半小时达”。 拼多多完全可以继续用性价比满足大多数消费者对“省”的需求,而不是强迫自己去满足一小撮客户对“快”的极致追求。 作者|苏 苏 编辑|ki ki 本文由 @新消时代 原创发布于人人都是产品经理。未经作者许可,禁止转载 题图来自Pexels,基于CC0协议 该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务

电影《真人快打2》公布了「强尼凯奇」官方预告片,该角色将由卡尔·厄本饰演,影片将于2025年10月上映。 <内嵌内容,请前往机核查看> 电影海报:

<blockquote><p>当移动互联网进入存量时代,广告投放正陷入 “两难困境”:一边是获客成本年均上涨 ,另一边是人工优化的边际效益持续下滑 —— 头部广告主日均需操作数万条计划,单条计划的人工调整成本甚至超过其产生的收益。</p> <p>在这样的背景下,广告投放中台从 “效率工具” 进化为 “增长引擎”,成为企业破局的关键。本文结合实战经验,拆解广告投放中台的核心架构、关键能力与落地逻辑,为产品经理提供可复用的建设框架。</p> </blockquote>  ## 一、什么是广告投放中台? 中台的本质是 “公共能力的沉淀与复用”。广告投放中台则是将广告投放中重复出现的 “账号管理、素材优化、数据监测、策略调整” 等能力抽离出来,形成标准化模块,支撑多业务(如电商、游戏、网赚)、多渠道(如巨量引擎、广点通)的规模化投放。 它的演进路径清晰可见: **初期:构建 “投放 – 效果” 的基础闭环能力(能跑通、可衡量)** 初期的核心是 “生存”—— 必须先跑通 “投放 – 数据回传 – 归因 – 优化” 的最小闭环,否则投放无法持续(广告主不会为 “不知道效果” 的投放买单); **中期:提升 “规模化投放” 的效率与精细度(能多跑、跑更快)** 中期的核心是 “效率”—— 在闭环基础上解决 “多、杂、重复” 的问题,支撑规模扩张;【例如业务规模扩大(如从 1 个媒体扩展到 5 个,日均计划从 10 条增至 1000 条),核心痛点从 “能不能投” 变成 “能不能高效投】 **成熟期:构建 “数据驱动 + 智能决策” 的生态化能力(能跑好、成体系)** 成熟期的核心是 “赋能业务”—— 当投放成为企业核心增长手段(如年消耗过亿、覆盖多业务线),中台需从 “工具” 进化为 “赋能业务”:【例如实时监控卡停低质量广告、素材;自动调整出价和素材;预估投放收益等】 ## 二、广告投放中台的核心架构与能力  ### 1. 增长指标:锚定投放的 “北极星” 所有投放动作都需围绕明确的目标展开,而目标往往来自海盗模型(AARRR)中的关键节点:获客(Acquisition)、激活(Activation)、留存(Retention)、付费(Revenue)、推荐(Referral)。 例如: - 电商业务可能以“付费转化”为核心指标,需拆解为“曝光→点击→加购→支付”的漏斗公式; - 工具类APP可能聚焦“激活率”,需关联“下载完成→首次打开→核心功能使用”的行为数据。 <blockquote><p>明确指标后,中台需构建 “指标</p> <p>– 数据</p> <p>– 策略” 的联动机制 —— 当核心指标偏离预期时,能自动定位问题环节(如点击高但激活低,可能是素材不行、出价过低等等)。</p></blockquote> ### 2. 素材库:广告效果的 “第一道防线” 素材是用户对广告的 “第一印象”,其质量直接决定点击率(CTR)与转化效率。中台的素材库需解决三个核心问题: - **多场景适配**:不同渠道对素材的要求天差地别(如抖音偏好竖版视频,广点通侧重图片组合),需支持按“业务+渠道+产品”标签分类存储,例如“电商-抖音-服饰”素材,广告创建时自动匹配9:16尺寸模板; - **效果归因**:通过素材ID关联全链路数据(曝光、点击、转化),生成“素材效果排行榜”——比如发现“3秒前贴片+价格锚点”的视频素材CTR比均值高30%,即可快速复用该模式; - **生命周期管理**:自动标记“低效素材”(如连续3天CTR低于行业均值50%)或者巨量引擎api可直接返回素材标签,触发预警并建议替换或者暂停,避免无效消耗。 ### 3.媒体端:连接“流量池”的桥梁 广告投放中台的核心是“跨渠道统一管控”,而实现这一目标的基础是对接主流媒体的MarketingAPI。 目前需覆盖的核心渠道包括: - 国内:巨量引擎(抖音、头条)、广点通(微信、QQ)、快手、华为/小米等应用商店; - 海外:GoogleAds、Meta(Facebook/Instagram)、TikTokforBusiness。 通过 API 对接,中台可实现 “双向同步”:一方面实时拉取媒体数据(曝光、消耗、点击),另一方面推送操作指令(创建计划、调整预算、暂停投放),彻底告别 “多平台切换、手动录数据” 的低效模式 ### 4. 投放系统:中台的 “操作系统” 投放系统是中台的核心功能载体,需覆盖从 “计划创建” 到 “效果优化” 的全流程,核心包含 5 大模块: **账号管理:权限与资源的 “中枢神经”** 基于公司组织架构搭建 “企业 – 部门 – 项目组” 三级账号体系,结合 RBAC(角色基础访问控制)模型实现精细化权限管控: - 运营岗:可调整计划出价,但不可修改总预算; - 财务岗:仅查看消耗数据,无操作权限; - 管理员:配置角色权限模板,支持批量授权。 同时,需支持账号资产的集中管理,包括账户余额、资质文件(营业执照、行业许可证)、历史投放记录等,避免 “账号分散、权限混乱” 导致的合规风险。 ### 5. 智能批量:广告搭建加速器 优化师的核心痛点之一是 “重复创建计划”—— 某游戏公司曾测算,单条计划的手动创建需 15 分钟,而日均需求超 1000 条,纯人工模式根本无法支撑。 智能批量功能需实现: - **策略配置**:预设“投放时段、定向人群、出价方式”等模板,例如“电商大促模板”自动匹配“10-22点投放+25-40岁女性定向+OCPM出价”; - **创意组合**:自动生成“素材+文案+落地页”的组合方案,比如用3组素材、2套文案、1个落地页,批量生成6条广告;**【广告分配规则可以用余数+等比数列公式去分配】;** - **合规校验**:创建的前置自动检测素材敏感词、落地页违规内容【可以外接机审平台】,通过率提升至95%以上。 ### 6.监控策略:成本控制的“安全阀” 广告投放的核心风险是“无效消耗”——某教育客户曾因未及时发现“高点击低转化”计划,单日浪费预算超10万元。 监控策略需实现“自动监测+智能调整+及时预警”: - **监测维度**:覆盖成本(CPA/CPM)、转化(点击→咨询→付费)、ROI(周期ROI、LTV)三大核心指标; - **调整逻辑**:基于“数据阈值+条件组合”自动操作,例如“当某计划CPA连续2小时超过目标值120%,且点击转化率低于均值50%,连续触发n次后不达标,则自动暂停并通知优化师”; - **通知机制**:通过飞书、短信推送预警,包含“异常指标、影响范围、建议操作”。 ### 7.广告归因:效果追溯的“指南针” 归因的核心是回答“哪个渠道、哪个素材带来了转化”,避免“数据失真”导致的资源错配。常见的归因方式有两种: - **传递式归因**:通过“渠道专属链接”追踪链路,例如用户点击抖音广告→跳转带参数的落地页→完成转化,链路清晰可追溯; - **匹配式归因**:针对无法直接追踪的场景(如用户先看广告后次日搜索),通过“设备IMEI、IP地址、用户ID”等信息匹配转化行为,提升归因覆盖率至90%以上。 - **媒体式归因:**如巨量引擎,由媒体方完成归因,广告主接收归因结果【**这种在未来应该会是主流】。** ### 8. 数据报表:业务决策的 “仪表盘” 报表的核心是 “按需输出”,满足不同角色的分析需求: - 素材团队:需要“素材类型-尺寸-转化”报表,例如发现“竖版视频的转化成本比横版低20%”; - 渠道团队:需要“媒体-计划-ROI”报表,例如对比“巨量引擎的ROI(1.8)高于广点通(1.5)”; - 管理层:需要“总预算-消耗-目标达成率”概览,快速判断投放进度。 报表需支持 “实时更新 + 下钻分析”,例如点击 “某渠道 ROI 异常”,可直接下钻到具体计划、素材、人群,定位问题根因 ### 9. 测试方法:用 ABtest 降低试错成本 广告投放的本质是 “不断试错”,而 ABtest 是提高试错效率的核心工具。中台需内置 ABtest 模块: - 支持“素材、定向、落地页”等变量测试,例如同时上线3组素材,自动分配流量并统计转化数据; - 提供“显著性检验”功能,快速判断“哪组方案更优”——比如95%置信度下,方案A的CPA比方案B低15%,即可全量复用方案A。 ### 10. 数据层:中台的 “燃料库” 数据是中台的核心驱动力,需整合三类数据形成闭环: - **用户基础数据**:账号ID、设备信息、注册时间等; - **用户行为数据**:点击、浏览、加购、支付等行为轨迹; - **业务数据**:订单金额、会员等级、LTV等。 通过统一 ID(如设备指纹 + 手机号哈希)打通数据孤岛,为归因分析、用户分层、策略优化提供支撑。 ## 三、当前的挑战和优化方向 - **算法能力待强化**:目前素材优化仍依赖人工经验,未来需通过深度学习给素材打标签(如“场景:办公室”“情绪:焦虑”),自动生成高转化素材; - **AI-经验驱动到数据驱动**:通过AI数据挖掘自动生成可执行的策略,精准迭代素材更新素材; - **归因成功率不足**:目前由于针对用户隐私保护,导致广告主无法顺利获取到用户设备信息,导致归因失败,目前来说巨量的融合归因,是目前这个行业当中的最优解。 中台的价值不在于 “功能多全”,而在于 “是否解决业务痛点”—— 从工具到系统再到中台,本质是用系统化思维替代经验主义,让广告投放从 “靠感觉” 走向 “靠数据”,从 “个体能力” 升级为 “组织能力” 本文由 @暂时离线 原创发布于人人都是产品经理。未经作者许可,禁止转载 题图来自Unsplash,基于CC0协议 该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务

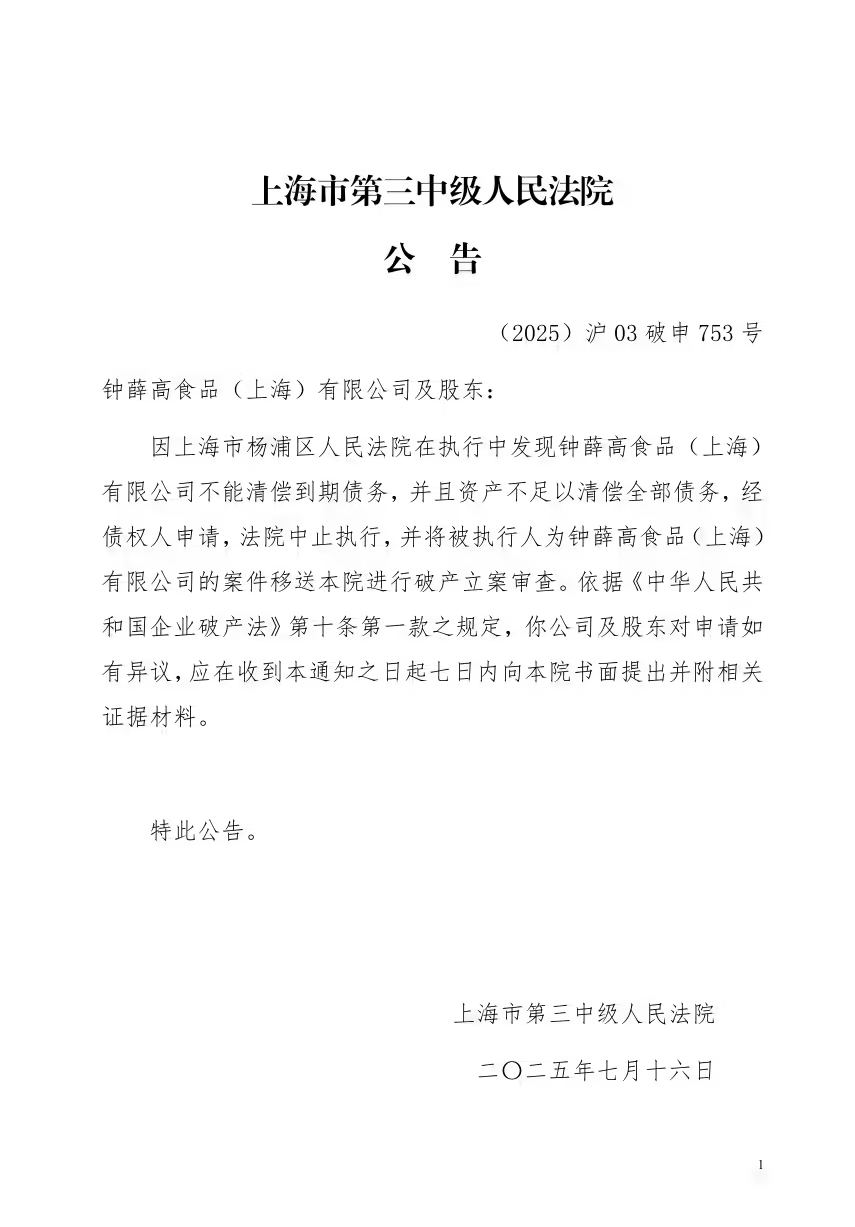

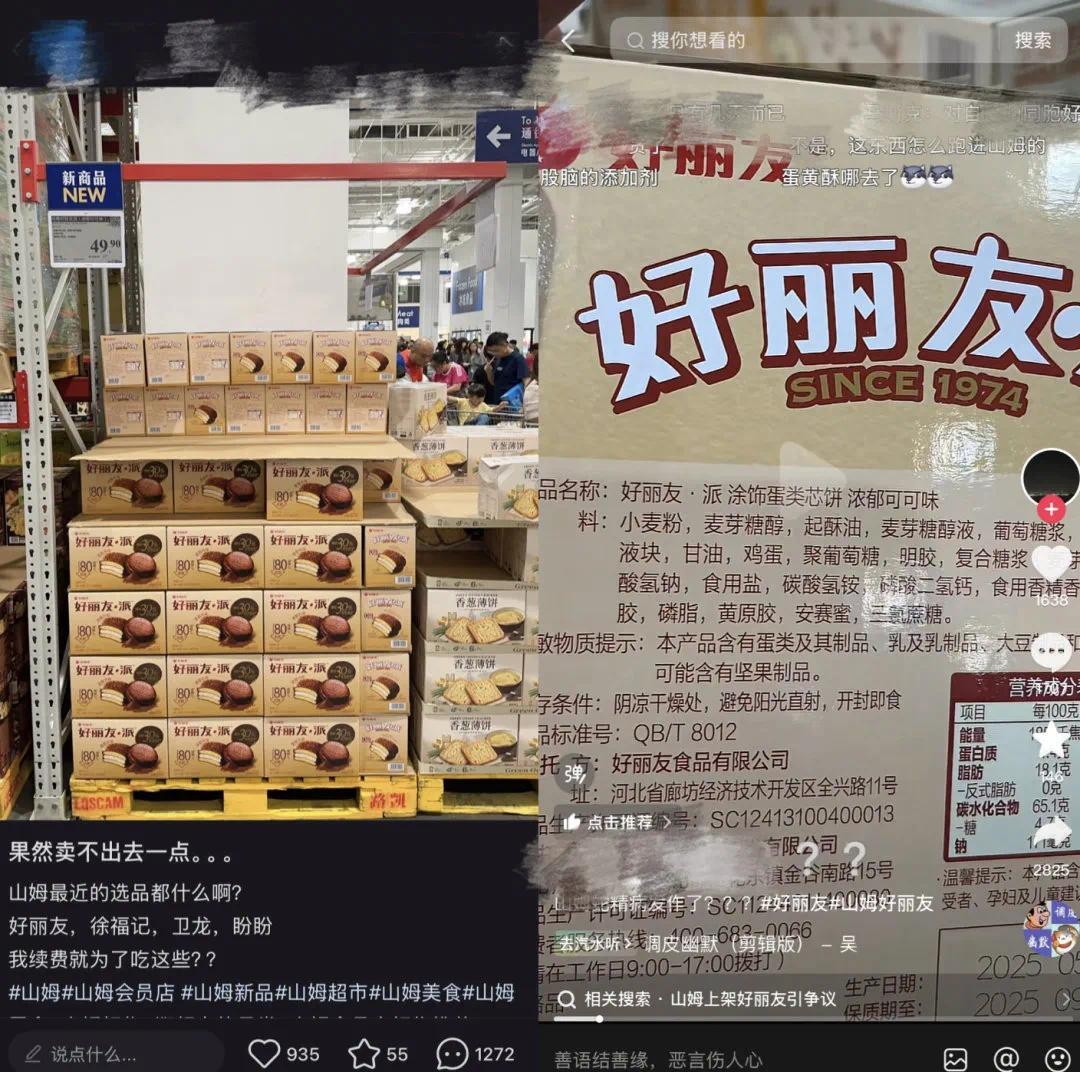

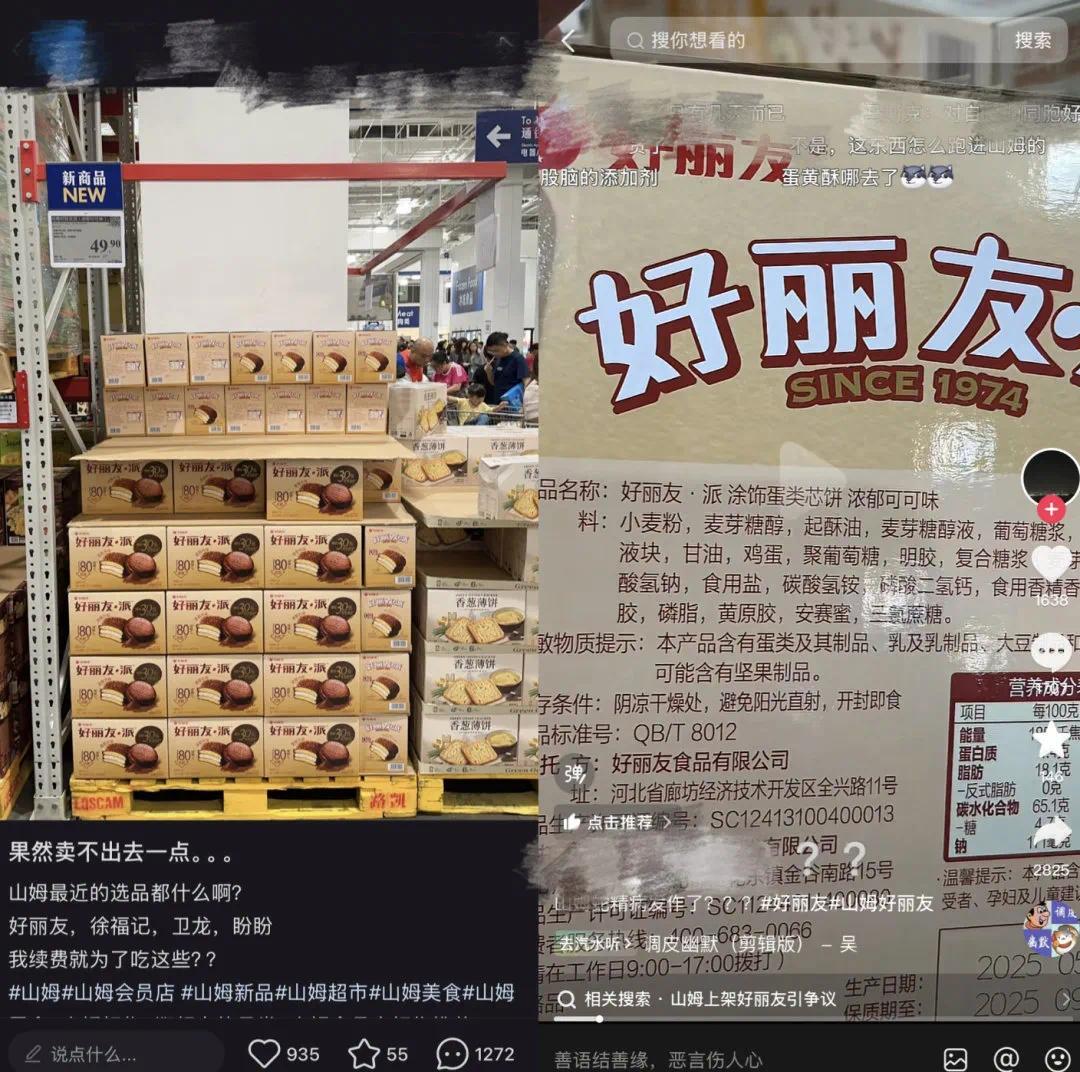

## 特斯拉官宣 Model Y L 秋季见,六座加长「证件照」首度公开 7 月 16 日消息,特斯拉官微今晚宣布,全新车型 Model Y L 将在今年「金秋」同大家见面。  工信部今天发布的**第 397 批《道路机动车辆生产企业及产品公告》新产品公示**中也发现了 Model Y L 的信息。新车长宽高分别为 **4976/1920/1668mm**,轴距 **3040mm**,整备质量 2088kg,总质量 2651kg。动力上,新车搭载型号为 3D3/3D7 的双电机系统,功率分别为 142kW 及 198kW,最高车速 **201km/h**。(来源:CnBeta) ## 英伟达 CEO 黄仁勋亮相链博会,表示「非常想买小米汽车」 北京时间 7 月 16 日,在北京举行的「链博会」上,一年内第三次造访中国的黄仁勋换下了皮衣,穿上了一身唐装进行了演讲,和 3 个月前一身西装会见高层的形象,又有所不同。  黄仁勋认为,AI 很显然将成为数万亿美元的行业,而 Meta 看到了这个机会,所以其创始人马克·扎克伯格想要让 Meta 成为「AI First」的公司,毕竟,Meta 本身已经建造了巨大的 AI 数据中心。 「我认为他决定全力以赴投入 AI。这是一个非常好的决定。」 就在上周,英伟达成为全球首家市值突破 4 万亿美元的公司,对于任何创始人兼 CEO 来说,这都是一项殊荣。 「我大概是世界上唯一一个,享受做最低市值公司 CEO 和最高公司 CEO 的人。」黄仁勋解释说,英伟达曾经面临低谷,市值接近于零,而自己曾经「保持低调很久」。现在市值全球最高,但比这更重要的是公司所做的事情——创造了新的计算形式(加速计算),引导了近年来的 AI 浪潮。 对于雷军和小米在当下最热的产品——小米汽车,黄仁勋也表示,中国的新能源车做得非常好,自己非常想买一台小米 SU7 Ultra,不过由于这辆大热的电动车并不在北美销售,他只能「非常遗憾」了。(来源:极客公园) 关联阅读:《黄仁勋:财务自由 30 年后,我没有梦想》  ## 宇树科技:1 到 3 年内机器人或许可以去流水线上打螺丝 7 月 16 日消息,第三届中国国际供应链促进博览会(下称「链博会」)于 7 月 16 日开幕,宇树科技、英伟达等科技公司第一次参会。 据第一财经报道,宇树的工作人员表示,**本次链博会宇树展出了两款产品,人形机器人 G1 和 Go2 机器人**,属于宇树的明星产品。该名工作人员介绍,宇树的产品并非属于开箱即用,虽然内置了握手、招手等基本 demo 功能,但需要通过遥控器实现。如果需要使用搬运等功能,需要用户进行二次开发,对于普通用户而言具有难度。  报道提到,宇树表示希望借助链博会平台了解上下游供应链关系,并听取市场端口反馈,以便更好地完善微型机器人产品。 对于机器人未来的落地方向,上述工作人员表示,**在他看来或许在未来 1 到 3 年内,机器人产品可以从单一的工业化产品落地发展到复合化工业场景**,例如机器人在搬完箱子后可以换个「手」再去流水线上打螺丝。在 3 到 10 年内,可以将机器人投放至生活场景,例如做家务、照顾老人等。这期间,需要解决多重问题,包括电池续航问题、机器人材料问题、自重问题、成本控制等。(来源:IT 之家) ## 美团王莆中谈外卖大战:这样卷没意义,行业订单飙升「绝大部分是泡沫」 7 月 16 日消息,据晚点 LatePost 今日报道,美团核心本地商业板块 CEO 王莆中谈及整个即时零售的市场总量从年初的日均 1 亿单翻至上周六(7 月 12 日)的 2.5 亿单,这其中有多少是泡沫?王莆中总结,「**绝大部分是泡沫**。」 当被问及美团的到店自取单是否算是作弊时,王莆中认为「到店自取在全球市场内,都属于外卖的一部分。在香港,到店自取占三分之一,对于奶茶、咖啡等网点密布的业态来讲,到店自取对用户、商户、平台都是更好的模型,只是你有没有能力把用户引导过去。至于作弊,难道一块钱买 12 瓶水不叫作弊?一分钱买纸巾算不算作弊?16 元减 16 元的「0 减券」算不算作弊?要剔除免单券,那「0 减券」剔除么?」 「外卖是一个精细且利薄的商业模式。」王莆中在采访中说,没有人比美团更有经验、也更熟悉这个行业的规律。「**我觉得这样卷没意义,对行业也是伤害**。但是在这个仗打之前,你跟对手这么说,他们不会信,他们只会觉得你怂了,反而会更来劲。」 对于「上周六单日你们订单量创了历史记录——1.5 亿单,阿里有人推测说,你们在当天可能烧掉了 8 个亿」的提问,**王莆中说「我们没有花 8 个亿,实际投入远比阿里少**。」 王莆中还在采访中透露,美团统计,**饿了么累计亏损超过 1500 亿**,今天阿里再投 500 亿,这就好比打德州已经输三把了,再买一把筹码试一试。  ## 因资不抵债,钟薛高被破产立案审查 7 月 16 日消息,上海市第三中级人民法院今日发布(2025)沪 03 破申 753 号案件异议公告,称在执行中发现钟薛高食品(上海)有限公司**不能清偿到期债务**,将进行破产立案审查。  同时该品牌旗下的盘箸有喜(上海)生物科技有限公司在昨日也被曝将进行破产立案审查,原因相同。 今年 6 月,钟薛高旗下的钟茂(上海)食品科技有限公司曾因债务问题进入破产审查程序,未履行金额超过 **2572 万元**,未履行比例达 99.98%。 2024 年 5 月时,钟薛高创始人林盛曾以「钟薛高老林」的名义直播**卖红薯还债**,并表示:「我就是卖红薯也要把债还上」。(来源:CnBeta) ## 京东外卖投入 20 亿升级全职骑手福利:五险一金 + 防寒暑补贴 + 15 万辆二轮车,达标可得 7 月 16 日消息,据京东黑板报消息,京东外卖二季度末全职骑手**已突破 15 万人**。京东外卖将投入 20 亿为全职骑手升级福利,含五险一金 + 防寒暑补贴 + 二轮车,**达标可得**。首期活动率先在北京、南京、长沙开启,后续将逐步开放至全国。  ▲ 图源:京东黑板报官方公众号,后同 据介绍,京东外卖除五险一金外,**寒暑季每月发放防暑防寒津贴**,还有 15 万台「赤甲光刃 X1」二轮车。根据京东官方描述,该款二轮车支持 180 度转动休息可躺、可安装便携式车载冰箱、配备环保 PU 发泡材质发光餐箱(号称保温时长增加 100%)。 这款「赤甲光刃 X1」二轮车需要骑手先自主购车,**并使用新车在 90 天内跑够 3000 单**,随后平台返购车款。 (来源:IT 之家) ## 苹果副总裁葛越:过去 5 年在华智能制造、绿色制造领域投资达 200 亿美元 7 月 16 日消息,据上海证券报今晚报道,苹果副总裁及大中华区董事总经理葛越在接受采访时表示,过去 5 年多时间里,苹果公司在中国**智能制造和绿色制造**领域的投资高达 200 亿美元(IT 之家注:现汇率约合 1435.84 亿元人民币)。苹果公司在全球主要的 200 家供应商中,有超过 80% 在中国设有工厂,中国智能制造的水平在全球处于领先水平。 葛越表示,参加链博会有利于**促进上下游合作**,也可帮助供应商提升国内外的知名度,吸引投资、吸引人才,并希望公司能够继续参加链博会、继续深耕中国。 苹果公司携手三家中国供应商——**欣旺达、山东创新和杰士德**参加了今年的中国国际供应链促进博览会,展示了智能制造、环境保护和员工发展等方面的成果。 苹果 2025 财年第 2 财季财报显示,该季度营收为 954 亿美元(现汇率约合 6848.97 亿元人民币),同比增长 5%,稀释每股收益为 1.65 美元,同比增长 8%。按照市场划分,大中华地区在第 2 财季**营收 160.02 亿美元**(现汇率约合 1148.82 亿元人民币),相比较去年同期的 163.72 亿美元同比下降 2.26%;北美地区营收 403.15 亿美元,相比较去年同期的 372.73 亿美元,同比增长 8.16%。(来源:IT 之家)  ## 鸿蒙智行「第五界」首车尚界 H5 官宣 9 月发布,华为余承东豪言「各方面都不妥协」 7 月 16 日消息,鸿蒙智行「第五界」尚界品牌的首款车型——**尚界 H5 官宣将于 9 月发布**,该车今日刚刚入网了工信部。 该车尺寸为 4780 x 1910 x 1657/1664mm,轴距 2840mm,**上市即搭载华为 ADS 4 辅助驾驶系统**。  从申报获悉,该车可选纯电和增程版本,其中: - 纯电版 CLTC 续航可达 655km,可选 150kW 和 180kW 电机版本,搭载时代上汽动力电池 - 增程版综合续航超 1300km,峰值功率 150kW 电机,搭配上汽 15FMC 增程器(1498ml,72kW),搭载时代上汽动力电池 华为常务董事、终端 BG 董事长余承东表示:「尚界 H5 正式亮相工信部公告!这是一款高智感超可靠的 SUV,空间大、智能强、续航长、品质高,**各方面都不妥协**!满足用户的『既要、又要、还要』。尚界 H5,9 月见!」(来源:IT 之家) ## 刀法精湛,消息称苹果 iPhone 17 Air 手机 12GB 内存速度不及 Pro 版 7 月 16 日消息,苹果 iPhone 17 系列按照惯例预计会在 9 月发布,此前爆料表明包括标准版 iPhone 17、iPhone 17 Air、iPhone 17 Pro 和 iPhone 17 Pro Max。 高盛证券分析师 Jeff Pu 今日爆料称,iPhone 17 将使用新的芯片组,iPhone 17 Pro 和 iPhone 17 Pro Max 预计将搭载新的 A19 Pro 芯片组。此外,该系列据说将配备苹果的定制 Wi-Fi 7 芯片。  去年 6 月,Jeff Pu 表示苹果将在 iPhone 17 中配备 A18 芯片,iPhone 17 Pro / Pro Max 机型将配备 A19 Pro 芯片,而 iPhone 17 Air 将获得标准版 A19 芯片。然而在最新爆料中,该分析师声称供应链数据显示他之前的判断是错误的,**iPhone 17 和 iPhone 17 Air 都将配备苹果 A19 芯片**。 IT 之家注意到,过去的泄露信息暗示 iPhone 17 将进行内存升级,但 Jeff Pu 声称该手机将提供 8GB LPDDR5 内存,与 iPhone 16 相同。 该爆料还提到,苹果将在 iPhone 17 Pro 和 Pro Max 上配备 12GB LPDDR5X 内存,**而 iPhone 17 Air 可能会配备稍慢的 12GB LPDDR5 内存**。 爆料还称 iPhone 17 Air 将采用钛合金中框,而其它三款 iPhone 17 系列机型采用铝合金中框。(来源:CnBeta)  ## 奔驰与微软加深合作,车内将集成 Teams、Microsoft 365 Copilot 提升生产力 7 月 16 日消息,梅赛德斯-奔驰今晚通过新闻稿宣布将与微软深化合作,新一代 CLA 车型将率先搭载**最新的 Microsoft 办公与协作工具**,其中包括升级版的 Meetings for Teams 应用。这项功能支持使用车载摄像头,在行驶过程中参与 Teams 视频会议。 与此同时,奔驰也成为**首家在车载操作系统 MB.OS 中原生集成 Microsoft Intune **的车厂,进一步拓展车内的远程办公能力。双方还将推进 Microsoft 365 Copilot 的整合计划,借助生成式 AI **提升会议准备效率**。官方表示,上述功能将于今年夏季**在搭载 MB.OS 的第四代 MBUX 系统的全新 CLA** 上率先上线。  用户可通过升级后的 Meetings for Teams 应用**使用车内摄像头出席视频会议**。为保障安全,该功能符合各地法规,且已获许可在行驶中使用。系统设计避免干扰驾驶:一旦**摄像头启动,车内将自动关闭会议视频画面**,驾驶者不会看到共享屏幕或简报内容,摄像头也可随时关闭。(来源:CnBeta)

<blockquote><p>随着出海企业越来越多,税务和发票问题是出海企业不得不面对的问题,为了解学习不同国家的税务管理及发票使用,将在全球范围内选择部分国家或地区进行调研。本文主要调研马来西亚的税收体系、税收种类、申报方式、系统建设、发票规范、发票服务商的接入要求等内容,希望能帮到大家。</p> </blockquote>  ## 一、概况 根据马来西亚财政部和国际货币基金组织(IMF)数据(IMF 2025 Article IV Consultation),2024年财政收入预计为3220.5亿令吉,较2023年的3010亿令吉增长6.6%。增长主要由经济复苏(2024年前三季度GDP增长5.2%)和税收政策优化驱动。 2024年财政收入按来源分为三大类: ### 直接税(1524亿令吉,47.5%) 企业所得税(CIT):约1000亿令吉,占直接税的65.6%。标准税率24%,中小企业(年收入≤5000万令吉)首200万令吉收入税率17%。高科技和绿色行业享受减免。 个人所得税(PIT):约400亿令吉,占直接税的26.2%。居民按0%-30%累进税率,非居民按30%固定税率。免税额(9,000令吉)和其他减免(如子女教育)刺激合规。 其他直接税:约124亿令吉,包括房地产利得税(RPGT,0%-30%)和石油所得税(Petroleum Income Tax)。 ### 间接税(1053亿令吉,32.8%) 销售与服务税(SST):约900亿令吉,占间接税的85.5%。销售税(5%-10%)适用于制造和进口商品,服务税(6%-8%)适用于酒店、餐饮、数字服务等。2024年服务税扩展至物流和经纪服务,增加约50亿令吉收入。 消费税:约100亿令吉,针对烟草、酒类和含糖饮料。 其他间接税:约53亿令吉,包括进口关税和出口税。 ### 非税收收入(632亿令吉,19.7%) Petronas股息:320亿令吉,占非税收收入的50.6%,受全球油价波动影响。 投资回报:约150亿令吉,来自政府投资基金(如Khazanah Nasional)。 许可和费用:约162亿令吉,包括车辆牌照、商业许可等。 2025年6月,马来西亚人口约为3597.8万,企业数量约为115.5万家。 马来西亚是多民族国家,其中马来西亚土著(包括马来人及沙巴、砂拉越原住民)人口70.4%,华人占比22.4% ,印度人占比6.5%,其他人占比0.7% 。 马来人占总人口约50%,在政治和文化上占主导地位。华人占约1/4,控制70%的市场资本化。中位年龄为31岁,整体青壮年人口占比较高。 ## 二、税收体系 马来西亚的征税机构体系采用联邦与州分税制,由联邦财政部统一协调,下设多个专门机构负责不同税种的征管。以下是主要征税机构及其职责的详细说明: ### 1. 联邦层面主要征税机构 **1)内陆税收局(Inland Revenue Board of Malaysia, IRBM)** 职责:主管直接税,包括所得税(公司及个人)、石油所得税、不动产利得税(RPGT)、印花税等。 官网:https://www.hasil.gov.my/en/ 机构设置: 全国设有25个评估分支机构和16个调查中心,负责税务评估与反逃税调查。2025年新增外国纳税分行(吉隆坡),专司外籍人士、非居民及预扣税事务。 特色职能: 签订国际税收协定(如避免双重征税协定)。 推行“自愿申报特别计划”(SVDP),鼓励纳税人补报漏税并降低罚款率。 **2)皇家海关署 (RMCD)(Royal Malaysian Customs Department, RMCD)** 职责:管理间接税,包括销售税(SST)、服务税、进口/出口关税、消费税(如烟酒、车辆等)。 官方网站:https://www.customs.gov.my/front.html 机构设置: 下设六大部门:关税处、国内税收处、预防处(反逃税)、研究规划处等。 关键改革: 2024年将服务税率从6%升至8%,并扩大应税范围至物流、电子商务等领域。 负责征收数字服务税(外国数字服务提供商适用6%)。 ### 2. 州及地方层面征税机构 州政府相关部门,无统一税务局,由各职能部门分税种征收,如: 土地税、矿产税 → 州矿务局; 森林税 → 州森林局; 娱乐税、酒店税 → 州财政部门指导下的地方机构。 门牌税(房产税):由市镇当局直接征收。 地方协作上部分税款(如小型企业SST)由邮局代收,提升便利性。 **补充说明** 1)税务争议处理机制 所得税特别税务专员(SCIT) 职能:审理纳税人对所得税评估的上诉案件,依据《1967年所得税法》等裁决。 2)消费税上诉法庭 针对皇家关税局的SST决定提供申诉渠道,程序简化且非技术化。 3)特色管理措施 数字化服务 推行电子发票(2025年全面强制化)、线上报税系统(e-Filing),疫情期间优先线上服务。 区域税收协作 如槟城税收局2024年税收超35亿令吉,成为地方征管典范。 经济特区优惠 五大经济走廊(如伊斯干达开发区)提供5–10年所得税减免,由联邦与州联合推动 ## 三、税收种类 马来西亚的税种,分为联邦税、州税和地方税。 ### 1. 联邦政府主要税种 **1)直接税** (1)个人所得税: 向马来西亚税务居民和非居民个人征收。 税务居民:根据累进税率(0%-30%)征税,可享受多种个人减免和扣除(如个人减免、子女减免、父母医疗费减免、教育费减免、人寿保险/公积金减免等)。 非税务居民:通常按固定税率(自2020年起为30%)对在马来西亚取得的收入征税(某些特定收入如利息可能适用较低税率或免税)。 采用自我申报评估制度。 (2)公司所得税: 向在马来西亚经营的公司(包括本地公司和外国公司分支机构)征收。 标准税率:自评税年2024年起(对应会计年度2023年),本地公司(中小型企业除外) 的税率是 24%。 中小型企业优惠税率:实收资本不超过250万马币且不属于关联集团的公司,其首60万马币的应纳税所得额可享受优惠税率(2023年:15%;2024年及以后:17%),超过部分按标准税率24%征收。 石油公司:适用特殊税率(目前为38%)。 (3)预提税: 对支付给非居民(个人或公司)的特定款项在支付时预先扣缴的税款。 常见类型: - 股息预提税:通常为0%(根据单层税制,股息在分配时通常不再征税)。 - 利息预提税:通常为15%,某些符合条件债券的利息可能免税或适用较低税率(如伊斯兰债券)。 - 特许权使用费预提税:通常为10%。 - 技术服务费/管理费预提税:通常为10%。 - 非居民承包商预提税:根据合同性质,税率可能为3%-13%不等。 (4)房地产利得税: 对处置在马来西亚的房地产(包括土地、建筑物、不动产公司股份)所获得的收益征收的资本利得税。 税率根据持有期限和纳税人身份(个人/公司,公民/永久居民/外国人)有所不同。持有时间越短,税率越高(最高可达30%)。马来西亚公民和永久居民通常享有终身一次特定金额的豁免。 (5)印花税: 对特定的法律文件或交易征收(文件生效或执行的前提)。 主要类型: - 不动产转让契约:税率基于物业价值累进(1%-4%)。 - 不动产租赁协议:税率基于年租金和租期计算。 - 贷款/融资协议:税率基于贷款金额(通常为0.5%)。 - 股份转让契约:税率基于股份价值(0.3%)。 **2)间接税** (1)销售税与服务税: 马来西亚目前的主要间接税制度,取代了之前的商品与服务税。 - 销售税:对在马来西亚制造或进口的应税商品征收。税率通常为5%或10%,也有特定税率(如某些建筑材料5%,饮料10%)。部分商品免税或零税率。由制造商或进口商缴纳。 - 服务税:对在马来西亚提供的特定应税服务征收。标准税率是6%。某些服务适用8%(如信用卡、扣账卡、签账卡服务)。由注册服务提供商(年应税服务营业额超过50万马币)征收并缴纳。 两者都是单阶段税(通常只在制造/进口环节或服务提供环节征收一次)。 (2)进口关税: 对进口到马来西亚的商品征收。 税率根据商品类别和原产国在《马来西亚协调关税制度》中规定,范围从0%到很高不等(奢侈品、保护性关税等)。马来西亚是东盟成员国,东盟内部贸易根据东盟货物贸易协定享受优惠关税。 由海关负责征收。 (3)消费税: 对在马来西亚生产或进口的特定商品征收,如: - 机动车辆(税率根据排量、车型等差异巨大) - 酒精饮料 - 烟草制品 - 扑克牌等赌博用品 - 某些能源产品(如润滑油) (4)旅游税: 由入住马来西亚境内持牌住宿场所(酒店、旅馆、服务式公寓等)的游客支付。 税率通常是每间房每晚10马币,具体取决于住宿场所的星级或类型。由住宿经营者代收代缴。 (5)离境税: 对从马来西亚机场乘坐飞机离境前往其他国家的乘客征收。 税率根据目的地(东盟国家或非东盟国家)和座位等级(经济舱或非经济舱)而不同(目前经济舱东盟15马币,非东盟50马币;非经济舱东盟50马币,非东盟150马币)。由航空公司代收。 ### 2. 州政府主要税种 **1.土地税:** 对持有地契(土地所有权)的土地所有者征收。税率由各州政府制定,通常基于土地的面积、地点和用途计算。 **2.矿场租金/特许权使用费:** 对开采州属矿产(如锡、沙石)征收。 **3.森林产品特许权使用费:** 对采伐州属森林资源征收。 **4.娱乐税:** 对特定的娱乐活动(如电影院、夜总会、保龄球馆等)征收。 ### 3. 地方政府主要税种 **1.门牌税(房产税):** 地方政府最主要的收入来源之一。 对辖区内所有拥有房产(住宅、商业、工业、空地等)的业主征收。 税率基于房产的年租值(由地方政府评估)计算,不同用途的房产税率不同(商业通常高于住宅)。 ## 四、申报方式 马来西亚的申报方式高度电子化,通过MyTax、MySST等平台实现,电子发票政策的推进进一步简化合规流程。接下来我们概述马来西亚各税种的申报方式、平台、周期及要求,为企业和个人提供参考。 MyTax:https://mytax.hasil.gov.my/ MySST:https://mysst.customs.gov.my/ ### 1. 直接税(由LHDN管理) **1.企业所得税**(Corporate Income Tax, CIT) 申报方式:通过LHDN的MyTax平台(Lembaga Hasil Dalam Negeri)在线提交年度申报表(如C Form或CP204)。 周期:财政年度结束后7个月内(如2024年12月31日结束的财政年度,申报截止为2025年7月31日)。 要求: 提交财务报表,符合马来西亚财务报告准则(MFRS)。 包括税务计算表和支持文档(如收入、支出明细)。 中小企业(年收入≤5000万令吉)需注明17%优惠税率适用部分。 流程:登录MyTax,填写C Form,上传文档,支付税款(支持在线银行转账或支票)。 备注:高科技或自由贸易区企业需提交减免申请表。 **2.个人所得税**(Personal Income Tax, PIT) 申报方式:通过MyTax平台提交年度申报表,居民使用BE Form(无商业收入)或B Form(有商业收入),非居民使用M Form。 周期: 居民:次年4月30日前(如2024年收入,2025年4月30日前申报)。 非居民:按需申报,基于马来西亚来源收入。 要求: 居民需申报全球收入,提交收入证明(如工资单、股息记录)。 非居民申报马来西亚来源收入,税率固定30%。 免税额(9,000令吉)和其他减免(如子女教育)需附证明。 流程:登录MyTax,填写相应表格,上传支持文档,支付税款。 备注:可用e-Filing系统简化申报,LHDN提供税务计算器。 **3.房地产利得税**(Real Property Gains Tax, RPGT) 申报方式:交易后30天内通过LHDN的CKHT表格(CKHT 1A/1B)提交,可在线(STAMPS系统)或纸质申报。 周期:处置房地产或公司股份后30天内。 要求: 提交买卖协议、估值报告和持有年限证明。 税率根据持有年限(公民≤3年30%,>5年0%;非居民/公司≤5年30%,>5年10%)。 流程:通过STAMPS系统(STAMPS)提交CKHT表格,支付税款。 备注:卖方和买方需分别提交CKHT 1A和1B。 **4.石油所得税**(Petroleum Income Tax) 申报方式:通过MyTax平台提交年度申报表(如PT Form),与CIT类似但需单独核算。 周期:财政年度结束后7个月内。 要求: 提交石油勘探和开采的财务报表。 税率25%-38%,视生产分成合同而定。 流程:登录MyTax,填写PT Form,上传文档,支付税款。 备注:主要适用于Petronas及相关企业。 **5.股息税** 申报方式:2025年起,年股息收入超10万令吉的个人通过MyTax纳入PIT年度申报,提交CP58表格。 周期:次年4月30日前,与PIT同步。 要求: 申报股息收入,税率2%,豁免EPF、ASNB等分配。 需提供股息支付证明。 流程:登录MyTax,填写PIT表格,注明股息收入,支付税款。 备注:新税种,需关注LHDN指引。 ### 2. 间接税(由RMCD管理) **1.销售与服务税**(Sales and Service Tax, SST) 申报方式:通过MySST平台(MySST)提交SST-02表格,月度或季度申报。 周期: 月度:应税销售额超150万令吉的企业,次月15日前申报。 季度:中小型企业,每季度末次月15日前申报。 要求: 销售税(5%-10%)适用于制造和进口商品,服务税(6%-8%)适用于酒店、餐饮等。 2025年5月1日起扩展至B2B服务和非必需品,需更新申报类别。 记录保存7年,支持电子发票数据。 流程:登录MySST,填写SST-02,上传交易记录,支付税款。 备注:2024年扩展至物流和经纪服务,2025年进一步扩展。 **2.消费税**(Excise Duty) 申报方式:生产商通过MySST提交,进口商通过RMCD的Customs Form No. 1(uCustoms系统)申报。 周期:月度或季度,与SST同步。 要求: 针对烟草、酒类、含糖饮料等,税率因商品而异(如烟草每公斤200令吉+10%)。 需提供生产或进口记录。 流程:登录MySST或uCustoms,提交申报表,支付税款。 备注:2025年起含糖饮料税率逐步提高。 **3.进口关税**(Import Duty) 申报方式:通过RMCD的uCustoms系统提交Customs Form No. 1,清关时申报。 周期:进口时实时申报。 要求: 按CIF价值计算,税率0%-50%(如汽车20%-30%)。 需提交发票、提单和进口许可。 流程:通过uCustoms上传文件,支付税款,完成清关。 备注:部分商品(如医疗设备)免税。 ### 3. 其他税种 印花税(Stamp Duty) 申报方式:通过LHDN的STAMPS系统(STAMPS)或纸质提交,视文件类型。 ## 五、发票相关规范 马来西亚的电子发票(e-Invoice)政策是其税务数字化转型的核心,目的是提高税务透明度、减少影子经济,并支持财政收入的增长。电子发票政策由内陆税务局(LHDN)通过MyInvois平台管理,结合了Peppol国际标准,自2024年8月1日起分阶段实施。覆盖约115.5万家企业。 ### 1. 适用范围 电子发票适用于以下交易类型: - B2B(企业对企业):所有商业交易需开具电子发票。 - B2G(企业对政府):政府采购相关交易。 - B2C(企业对消费者):单笔交易超1万令吉需单独开具电子发票。 买方明确要求电子发票。 其他B2C的交易可汇总为综合电子发票。 豁免:年收入低于50万令吉的企业可豁免,但若关联公司收入超50万令吉则需实施。 特殊情况如外国供应商未通过MyInvois开票的交易,可以由买方代为提交,称为自开票(Self-Billed e-Invoice)。 ### 2. 技术规范 格式:采用XML或JSON,符合Peppol的UBL 2.1标准,需包含53个强制字段(如发票编号、发行日期、买卖双方税务识别号、商品描述、税额)。 QR码:每张电子发票需嵌入QR码,链接至LHDN验证页面。 数字签名:非强制,但推荐使用以确保安全性。 数据提交:通过MyInvois平台或Peppol认证服务商(如Comarch、Pagero、Storecove)的API提交。 语言:主要使用马来语或英语,视买方需求可附加其他语言。 ### 3. 验证与存储要求 **验证流程:** - 卖方通过MyInvois或API提交发票数据。 - LHDN验证后分配唯一认证序列号(UIN)。 - 卖方将验证后的电子发票发送买方(PDF或XML格式)。 **存储要求:** - 保存7年,符合《1967年所得税法》要求。 - 本地存储优先,海外存储需RMCD批准。 - 数据需加密,防止篡改。 **综合发票:**非强制B2C交易可每月汇总为综合电子发票,需于月末7天内提交。 **调整与取消发票交付:** - 72小时内:买方可通过MyInvois拒绝或取消发票,需说明理由。 - 72小时后:通过信用票据(CreditNote)、借记票据(DebitNote)或退款票据(RefundNote)调整,需提交MyInvois验证。 **错误更正:**通过MyInvois提交更正请求,需附原始发票UIN。 **合规与处罚:** - 合规要求:所有发票需实时或按周期提交MyInvois,延迟提交视为不合规。 - 处罚:根据《1967年所得税法》第120(1)(d)条,单次违规罚款200-20,000令吉,或监禁最多6个月,或两者并罚。 **支持措施:** LHDN提供MyInvois沙盒测试环境和软件开发工具包(SDK)。 MDEC支持Peppol框架,中小企业可获加速资本津贴(2024-2025年)。 ### 4. 推进时间表 **1.2024年8月1日** 目标:年收入超1亿令吉的企业(约5000家,占总企业0.4%)。 进展:2024年底合规率达90%(EY Malaysia)。 影响:首批企业主要为大型跨国公司和本地龙头,覆盖制造业和金融业。 **2.2025年1月1日** 目标:年收入2500万至1亿令吉的企业(约10,000家)。 进展:2025年6月,首批企业过渡顺利,第二阶段企业正整合ERP系统。 影响:覆盖中型企业,涉及零售、物流和服务业。 **3.2025年7月1日** 目标:年收入500万至2500万令吉的企业(约50,000家)。 宽限期:至2026年1月1日,期间无罚款,允许综合发票。 影响:覆盖更多中小企业,需加快系统升级。 **4.2026年1月1日** 目标:年收入100万至500万令吉的企业(约200,000家)。 宽限期:至2026年7月1日。 影响:覆盖大部分微型和小型企业,挑战在于技术成本。 **5.2026年7月1日** 目标:所有纳税人(包括年收入低于100万令吉的企业,约900,000家)。 影响:全面实现电子发票,预计显著减少逃税,增加税收约20亿令吉/年 MyInvois平台地址:https://mytax.hasil.gov.my ### 5. 发票种类 马来西亚的MyInvois系统支持签发八种票据。这些文件主要包括发票(Invoice)、信用票据(Credit Note)、借贷票据(Debit Note)、退款票据(Refund Note),支持销售方开具,也支持购买方开具。购买放开具主要用于特定场景下比如进口货物,或者无法联系到销售方开具,另外针对同一购买方小额的交易支持合并开票(Consolidated Invoice)。 四类文件的开具  ## 六、系统建设 马来西亚的电子发票系统,为纳税人提供了免费提交发票的MyInvois系统,也支持企业通过认证的电子发票服务商系统提交电子发票。 ### 1. MyInvois系统 纳税人可以通过 MyTax 门户(HASiL 电子服务的门户)访问 MyInvois 门户。为了方便纳税人使用 MyInvois 门户,HASiL 提供了两种访问环境:预生产环境(https://preprod-mytax.hasil.gov.my)和正式环境(https://mytax.hasil.gov.my)。 MyInvois系统提供了完整的操作手册,可参考连接: https://www.hasil.gov.my/en/e-invoice/myinvois-portal/user-guide-video/ 该系统支持直接配置APPID和秘钥,便于和ERP集成。参考:https://www.youtube.com/watch?v=T72btZ-WRBs 支持第三方代理获取企业的数据。 **支持API接入** 接入文档参考:https://sdk.myinvois.hasil.gov.my/ **E-POS系统** MyInvois 电子销售点系统 (POS) 是由 HASiL 专门提供的数字销售点 (POS) 平台,免费提供给中小型企业,以提升业务运营效率并满足电子发票的实施需求。除了销售管理、会计、库存管理和财务报告功能外,MyInvois 电子销售点系统还允许卖家在与买家交易时直接生成电子发票,买家也可以在交易完成后向卖家索取电子发票。MyInvois 电子销售点系统功能丰富,可作为支持商业生态系统和加强马来西亚电子发票实施的补充工具。 ## 七、发票服务接入要求 马来西亚的电子发票(e-Invoice)由内陆税务局(LHDN)通过MyInvois平台管理,电子发票(e-Invoice)服务商的认证由马来西亚数字经济公司(MDEC)作为Peppol权威机构(Peppol Authority)负责。 ### 1. 集成步骤 **1)获取API访问权限** 注册MyInvois账户,获取API密钥(Client ID和Client Secret)及纳税人识别号(TIN)。 申请需通过LHDN官网(e-Invoice)提交。 **2)下载SDK和文档** 获取MyInvois API软件开发工具包(SDK v1.0,2025年4月更新),包含技术文档和示例代码。 参考《e-Invoice Guideline v2.2》和《MyInvois API Documentation》。 参考连接: https://sdk.myinvois.hasil.gov.my/ **3)配置系统** 支持XML/JSON格式(UBL 2.1/PINT-MY标准),包含53个强制字段(如发票编号、买卖双方TIN、税额)。 集成数字签名,使用XAdES算法,需从认证机构(如Pos Digicert、MSC Trustgate)获取.cer或.pfx证书。 **4)测试环境** 使用MyInvois沙盒环境(Sandbox)测试API连接,确保发票生成、提交和验证流程。 测试需覆盖B2B、B2G、自开票和综合发票场景。 **5)API集成** 使用RESTful API(HTTPS协议,TLS 1.2+)与MyInvois对接,支持单张或批量发票提交。 主要端点包括: /api/v1.0/invoice:提交发票。 /api/v1.0/invoice/validate:验证发票。 /api/v1.0/invoice/status:查询发票状态。 设置回调URL接收验证结果(唯一认证序列号,UIN)。 **6)生产环境部署** 通过沙盒测试后,切换至生产环境,实时提交发票至MyInvois。 确保系统支持7年存储,数据加密(SHA-256)。 持续维护: 定期更新API版本,监控LHDN和MDEC通知。 提供客户支持,处理发票拒绝或调整。 **7)认证过程** (1)申请认证 提交申请: 向MDEC提交申请表,包含公司注册文件、税务识别号(TIN)、业务范围和技术能力描述。 选择认证类型: Peppol服务提供商(SP):负责创建和管理连接网关(Access Point, AP),支持发票在Peppol网络中的路由和交换。 Peppol就绪解决方案提供商(PRSP):提供支持电子发票生成和传输的软件或ERP系统,无需成为AP。 需证明与LHDN的MyInvois系统或Peppol网络的集成能力。 费用:申请费用因服务商类型和规模而异,需咨询MDEC(MDEC)。 (2)技术评估 系统要求: 支持XML或JSON格式,符合Peppol PINT-MY(UBL 2.1)标准,包含53个强制字段(如买卖双方TIN、商品描述、税额)。 集成MyInvois API和Peppol网络,确保发票实时提交和验证。 支持数字签名,使用XAdES算法,证书类型为.cer(软证书)或.pfx(漫游证书)。 API集成: 使用LHDN提供的MyInvois API,支持发票生成、验证和通知。 Peppol SP需支持SMP注册,管理客户标识和路由。 测试环境:在MyInvois沙盒环境中测试API集成,确保生成、提交和验证流程无误。 (3)安全与合规审查 数据安全: 采用TLS 1.2+加密协议,确保数据传输安全。 实施身份验证和访问控制,防止未授权访问。 符合ISO/IEC 27001或等效标准,通过MDEC的安全性评估。 存储要求: 电子发票需保存7年,海外存储需RMCD批准。 数据需加密,防止篡改或丢失。 合规性: 遵守《1967年所得税法》和LHDN的《e-Invoice Guideline v2.2》。 确保发票包含QR码和唯一认证序列号(UIN),支持实时验证。 (4)测试与验证 沙盒测试: 使用MyInvois沙盒环境(2024年4月22日起开放)测试发票生成、提交和验证。 提交测试报告,证明系统符合LHDN的技术规范。 验证流程: 发票提交MyInvois后,LHDN验证格式和数据完整性,分配UIN。 测试需覆盖B2B、B2G、自开票和综合发票场景。 (5)认证批准 审核:MDEC审核申请材料、技术报告和安全性合规性,过程约3-5周。 颁发认证: 颁发Peppol SP或PRSP认证,有效期3年,需定期更新。 认证服务商名单在MDEC官网公布。 后续义务: 提供持续技术支持,确保客户合规。 定期更新系统,适应LHDN和Peppol标准变化。 (6)注册与运营 SMP注册: SP需在马来西亚服务元数据发布者(SMP)注册,管理客户TIN和路由信息。 PRSP需确保软件与SP或MyInvois直接对接。 运营支持: 提供客户培训和故障排除。 确保系统可扩展,支持高交易量(2024年11月已处理6450万张电子发票)。 MDEC认证的电子发票服务提供商包括Comarch、EDICOM、Pagero、Sovos、Advintek、Tickstar、Unifiedpost Group(SP)和ClearTax(PRSP),首批认证31家SP和4家PRSP。认证企业支持MyInvois API、PINT-MY标准和数字签名。(该信息为网络搜索,尚未从MDEC官网得到公示信息)。 作者:原始森林,《SaaS产品方法论——入门、实战与进阶》作者 本文由 @原始森林 原创发布于人人都是产品经理,未经许可,禁止转载 题图来自 Unsplash,基于 CC0 协议 该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。