国内外AI监管政策:数据安全法、生成内容合规性——人工智能时代的法律边界与创新平衡

在人工智能飞速发展的当下,AI技术的广泛应用带来了前所未有的机遇,同时也引发了诸多伦理、法律和监管方面的挑战。

一、回顾

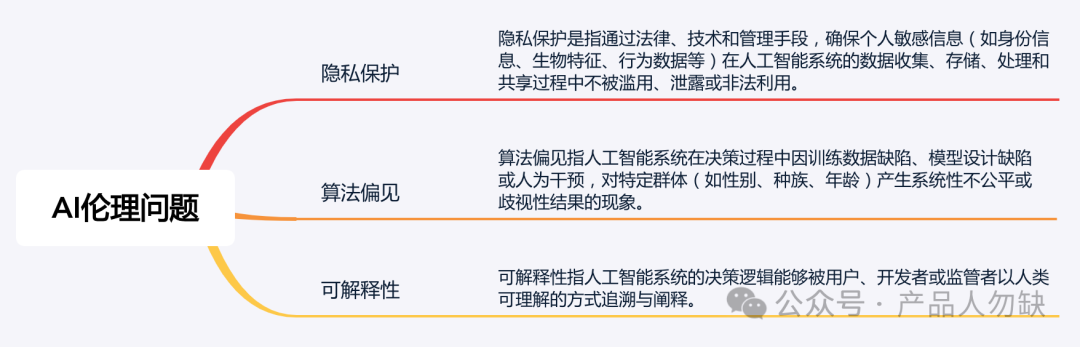

上一篇分享的AI产品经理核心技能-AI伦理问题:隐私保护、算法偏见、可解释性。有兴趣可阅读 这篇文章。

二、 纵观全球AI监管格局:从“野蛮生长”到“规则重塑”

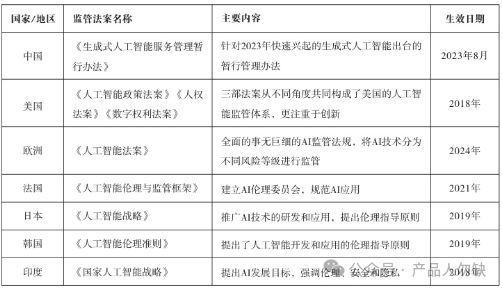

随着ChatGPT、Sora等生成式AI技术爆发式发展,全球监管机构正加速构建“安全围栏”。2023年至今,欧盟、美国、中国等主要经济体密集出台AI专项法规,核心聚焦两大领域:【数据安全风险防控】与【生成内容合规性治理】。

欧盟:2024年通过全球首部全面AI法案(AI Act),以风险分级制度为核心,要求生成式AI内容强制标注水印。

美国:通过《人工智能政策法案》《数字权利法案》等分散立法,强调“创新优先”与国家安全平衡。

中国:以《数据安全法》《生成式人工智能服务管理暂行办法》为框架,构建“数据分类分级+生成内容全流程审查”体系。

(图:全球主要国家AI监管法案对比表,来源:资料)

数据安全:AI发展的“生命线”

- 中国《数据安全法》的“紧箍咒”

数据本地化:特斯拉FSD在华训练数据需境内存储,核心算法不得跨境传输。

分类分级管理:AI企业需识别“核心数据”,建立全生命周期安全制度,违规最高罚款1000万元。

合规实践:头部企业如腾讯、阿里云通过“数据沙盒”“隐私计算”实现“可用不可见”。

- 欧盟的“超严标准”

高风险AI系统(如医疗诊断、信用评分)需满足数据治理、技术文档等23项强制性要求。

数据跨境限制:非欧盟企业需设立境内代表机构,否则面临年营业额7%的罚款。

生成内容合规

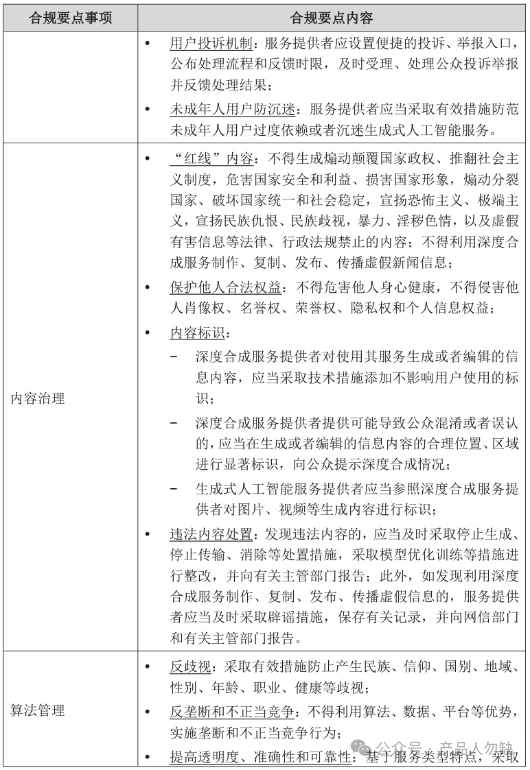

- 中国《生成式人工智能服务管理暂行办法》核心要求

内容安全底线:不得生成煽动分裂国家、宣扬恐怖主义、虚假信息等违法内容。

真实性保障:服务提供者需建立“输入指令过滤+生成内容审核”双机制,防范虚假信息。

未成年人保护:强制设置防沉迷措施,限制未成年人单日使用时长。

(案例:2024年某AI绘画平台因生成涉政敏感图片被网信办约谈,责令暂停服务整改)

- 欧盟的“透明化治理”

强制标注:所有AI生成内容需添加不可删除水印,披露训练数据版权来源。

深度伪造(Deepfake)限制:除艺术创作、犯罪侦查等豁免场景外,禁止未经授权的生物特征模拟。

三、企业合规指南:头部科技公司的“生存法则”

1. 技术层面

数据安全:采用联邦学习、同态加密技术,满足本地化存储要求。

内容过滤:部署多模态AI审查模型,实时拦截违规生成内容。

2. 管理层面

合规团队:设立AI伦理委员会,定期开展算法安全评估。

用户协议:明确告知数据使用范围,设置“一键投诉”通道。

(案例:IBM推出AI合规管理平台,整合欧盟、中国等50+法规要求)

四、结语

AI监管的本质,是在“释放技术红利”与“防范社会风险”间寻找最优解。无论是欧盟的“风险防控”、美国的“创新包容”,还是中国的“安全可控”,其终极目标都是构建可信赖的AI生态。对企业和开发者而言,唯有将合规内化为核心竞争力,才能在这场技术革命中行稳致远。

本文由人人都是产品经理作者【产品人勿缺】,微信公众号:【产品人勿缺】,原创/授权 发布于人人都是产品经理,未经许可,禁止转载。

题图来自Unsplash,基于 CC0 协议。